腾讯字节,做AI to C的两个“极端”在顶峰相遇

腾讯字节,做AI to C的两个“极端”在顶峰相遇投机是腾讯的惯性,投放是字节的基因

投机是腾讯的惯性,投放是字节的基因

大雄:(趴在书桌前抓头发)哆啦 A 梦!今天的作文题目是《未来的机器人》,可是我要写800字!写不完啦!哆啦 A 梦:(得意叉腰)别担心!我刚从22世纪带来了「超高效作业处理器」——FlashMLA 魔盒!它能让写作文像吃铜锣烧一样快哦!

就在刚刚,Anthropic祭出首个混合推理Claude 3.7 Sonnet,堪称扩展思考模式的最强模型。在最新编码测试中,新模型暴击o3-mini、DeepSeek R1,AI编码王者出世了。

我在想,Deepseek到底对游戏行业的影响有多大。一段时间内,Deepseek本身就成了流量密码、泼天富贵。大到概念股暴涨,各领域大厂下场接入Deepseek、小到零基础用Deepseek做游戏……沿着这个趋势,说不定蔡浩宇说的“99%的开发者”真的要被迫提前转行了。

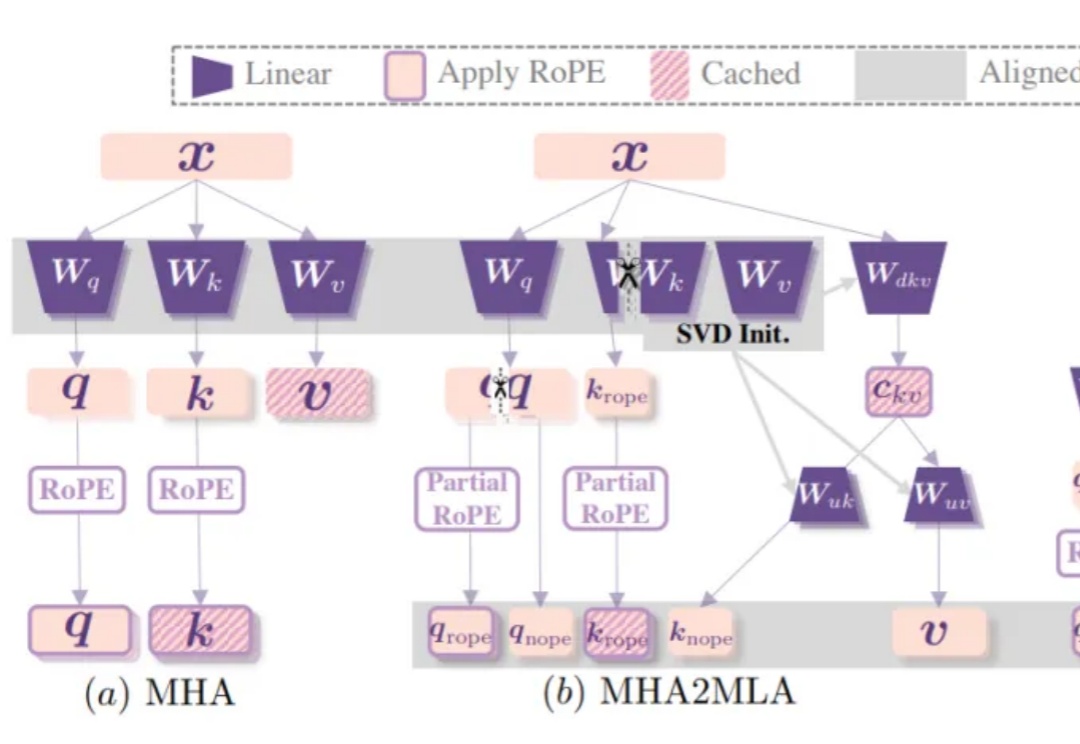

DeepSeek-R1背后关键——多头潜在注意力机制(MLA),现在也能轻松移植到其他模型了!

没完了,刚刚接入DeepSeek的百度,又双叒叕搞事情了。

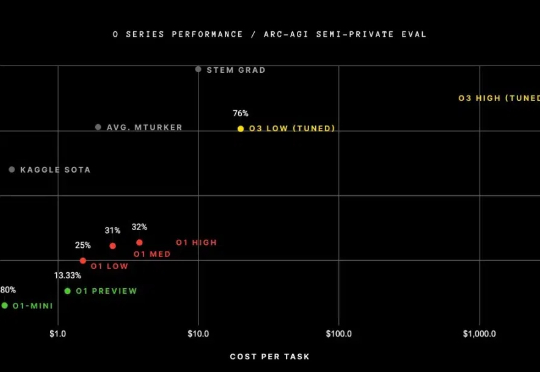

自 OpenAI 发布 o1-mini 模型以来,推理模型就一直是 AI 社区的热门话题,而春节前面世的开放式推理模型 DeepSeek-R1 更是让推理模型的热度达到了前所未有的高峰。

DeepSeek 懂的都懂,从爆火那天起,官方就常年“服务器繁忙“,想问个问题,比春运抢票还难。

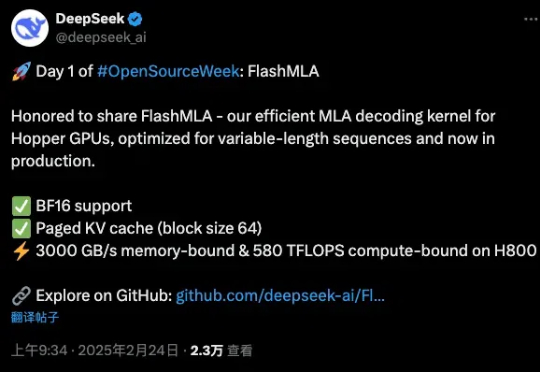

刚刚,万众瞩目的DeepSeek,开源了他们第一天的项目。FlashMLA是一款面向Hopper GPU的高效MLA解码内核,并针对可变长度序列的服务场景进行了优化。

DeepSeek开源周第一天就放大招!FlashMLA强势登场,这是专为英伟达Hopper GPU打造MLA解码内核。注意,DeepSeek训练成本极低的两大关键,一个是MoE,另一个就是MLA。