挖掘注意力中的运动线索:无需训练,解锁4D场景重建能力

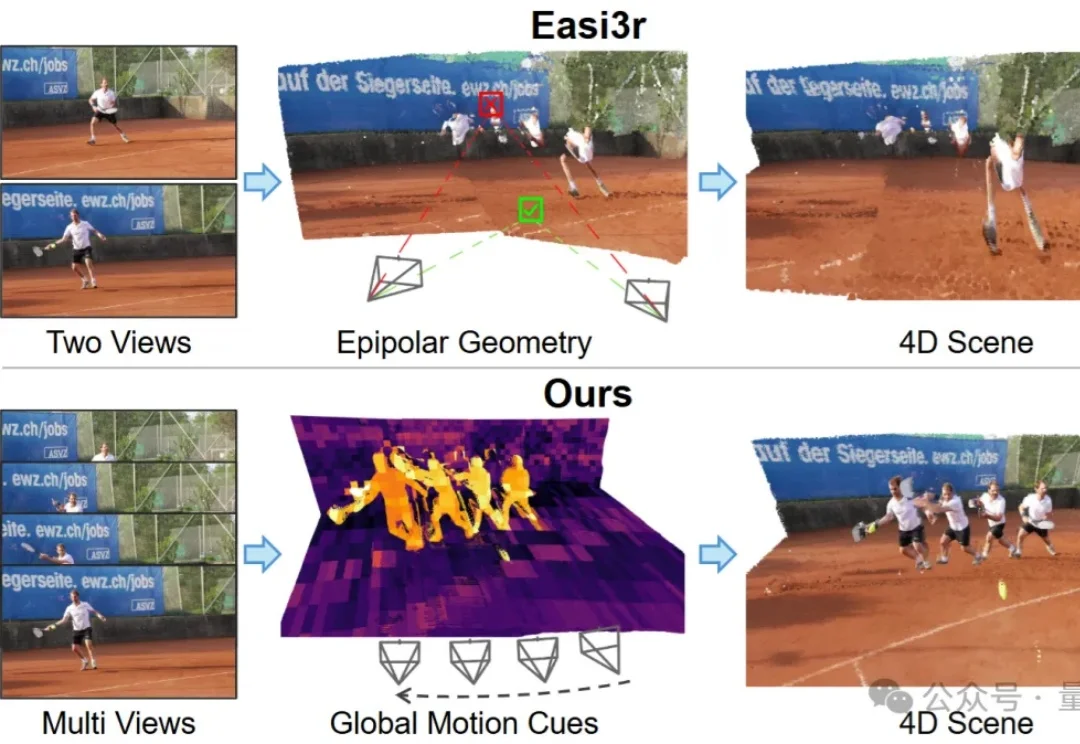

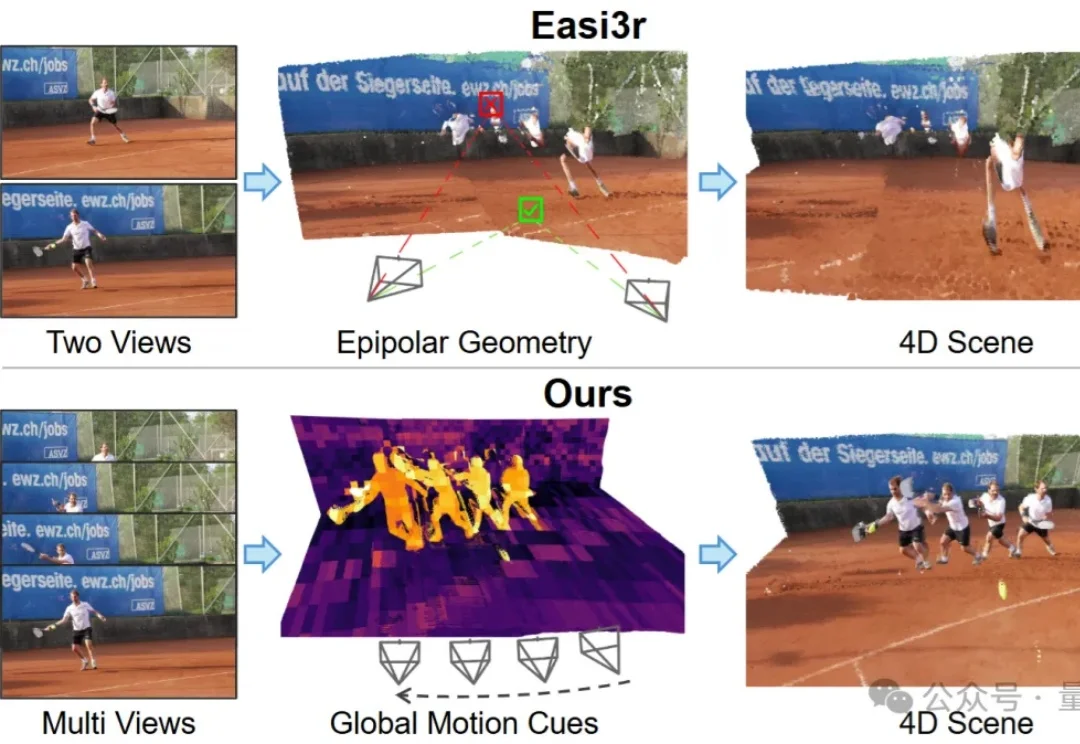

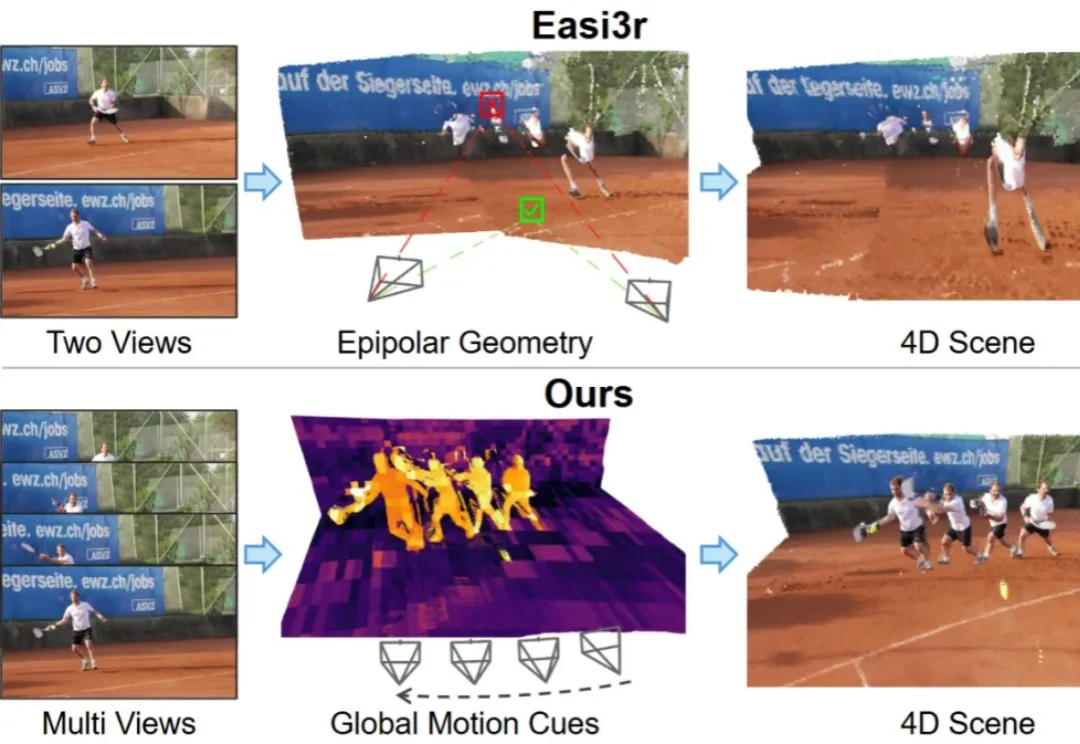

挖掘注意力中的运动线索:无需训练,解锁4D场景重建能力如何让针对静态场景训练的3D基础模型(3D Foundation Models),在不增加训练成本的前提下,具备处理动态4D场景的能力?

如何让针对静态场景训练的3D基础模型(3D Foundation Models),在不增加训练成本的前提下,具备处理动态4D场景的能力?

如何让针对静态场景训练的 3D 基础模型(3D Foundation Models)在不增加训练成本的前提下,具备处理动态 4D 场景的能力?

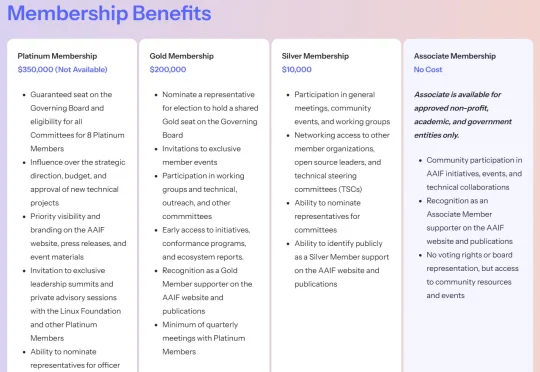

刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。

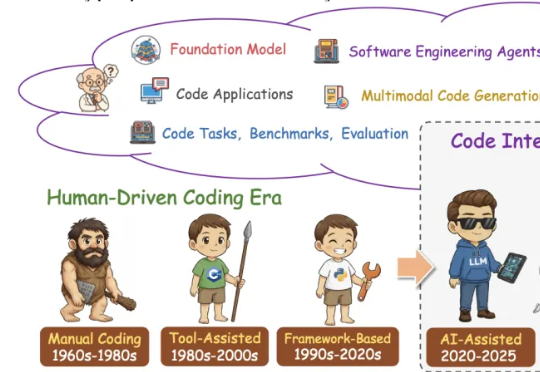

这篇学术论长文由北京航空航天大学复杂关键软件环境全国重点实验室领衔。《From Code Foundation Models to Agents and Applications》一文是对过去几年代码智能领域的一次系统梳理:模型、任务、训练、智能体、安全与应用都被串联成了一条完整、连贯的技术链路。

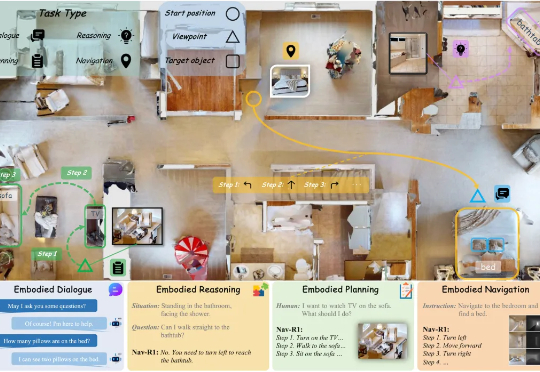

北京大学,银河通用,阿德莱德大学,浙江大学等机构合作,探究如何构建具身导航的基座模型(Embodied Navigation Foundation Model)提出了NavFoM,一个跨任务和跨载体的导航大模型。实现具身导航从“专用”到“通用”的技术跃进

刚刚,OpenAI宣布已完成资本结构重组。这就意味着,OpenAI上市的道路已经铺平,而软银前几天刚批准的225亿美元投资,也将顺利到账。具体来说,OpenAI重组后,非营利主体(即原本的OpenAI Nonprofit)改名为OpenAI Foundation,继续掌控营利实体——

这篇题为《Nav-R1: Reasoning and Navigation in Embodied Scenes》的新论文,提出了一个新的「身体体现式(embodied)基础模型」(foundation model),旨在让机器人或智能体在 3D 环境中能够更好地结合「感知 + 推理 + 行动」。简单说,它不仅「看到 + 听到+开动马达」,还加入清晰的中间「思考」环节。

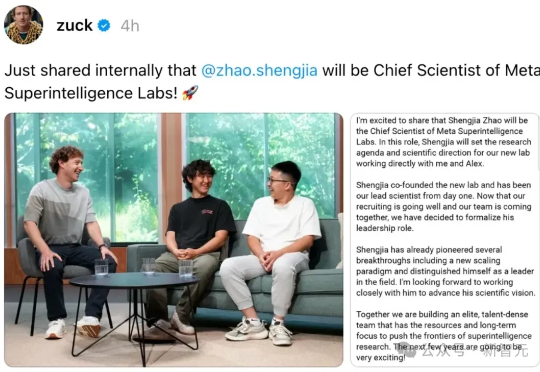

Meta超级智能实验室一拆四以后,首席AI官Alexandr Wang全员信曝光。这位28岁华人获扎克伯格力挺,出任超级智能实验室负责人。内部信强调「超级智能即将到来」,并宣布实验室拆分为四大部门。同时,AGI Foundations团队被解散,成员分流。Yann LeCun地位明显降级,权力重心全面向Wang集中。

在最近的技术报告中,苹果公司提供了更多关于 iOS 26 新的苹果人工智能基础模型(Apple Intelligence Foundation Models)的性能和特性的详细信息,该模型是在最近的 2025 年全球开发者大会(WWDC)上宣布的。

谷歌DeepMind开启「上帝视角」,全新力作AlphaEarth Foundations震撼上线,10米级分辨率,打造出前所未有的地球数字画像。网友直呼:这不就是「地球版ChatGPT」?