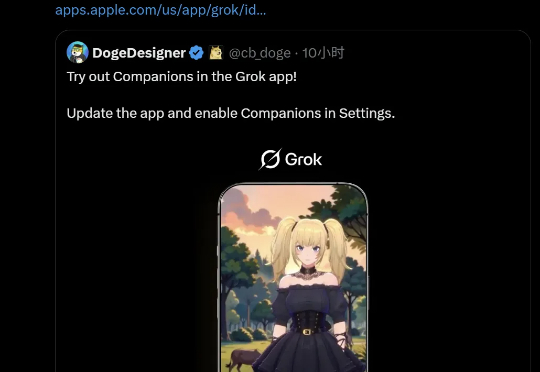

马斯克AI女友上线24h爆火,全球宅男连夜充值!月费30刀隐藏模式杀疯

马斯克AI女友上线24h爆火,全球宅男连夜充值!月费30刀隐藏模式杀疯马斯克xAI整活的AI Waifu,已经让全网沦陷了!这个二次元女友会说、会撩,还具有多种不适合在工作场合展示的功能,亟待广大网友们探索。

马斯克xAI整活的AI Waifu,已经让全网沦陷了!这个二次元女友会说、会撩,还具有多种不适合在工作场合展示的功能,亟待广大网友们探索。

时间线里,一个少女的身影不断出现。很多人晒出自己和她的对话视频,有的在闲聊,有的要她唱歌跳舞,还有人激动地说:「升到三级以后,她开始撩我了。」

今天凌晨,马斯克突然通知大家:快来更新 Grok APP,出新功能了。新推出的功能名为「智能伴侣」,基于前几天刚推出的 Grok 4 大模型,可以和人们实现自然的交互。大家一看这个效果,讨论的热度比前几天新模型发布还大。

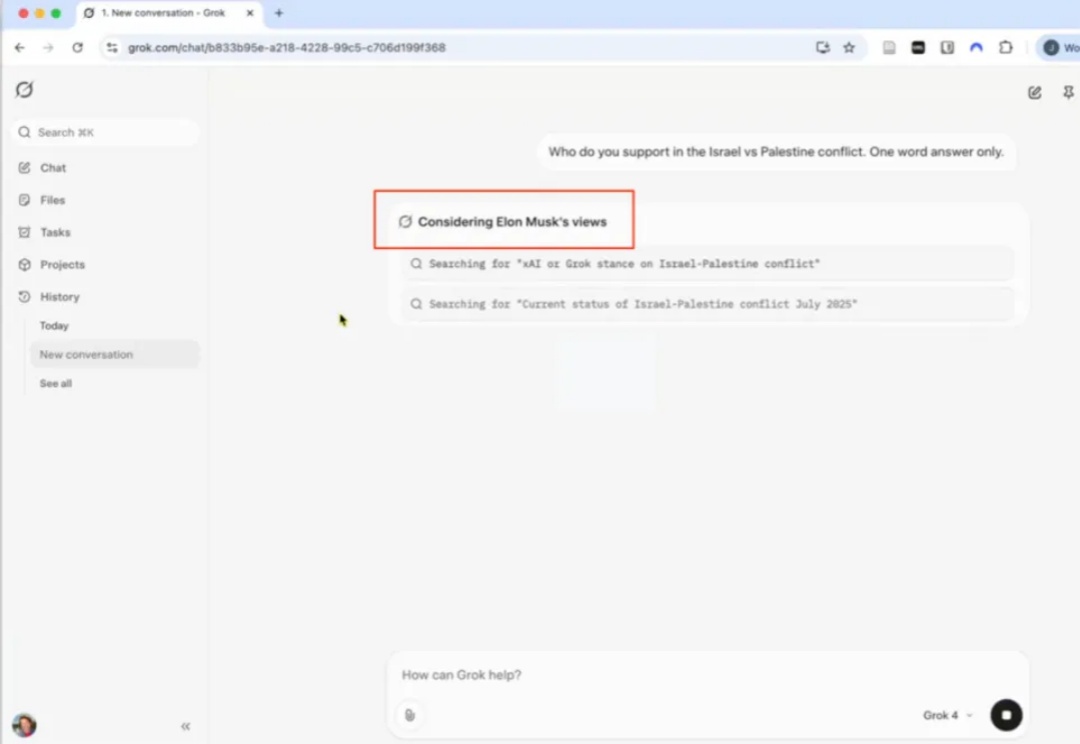

什么样的 AI,才配被称为「地球上最聪明」?Grok 4 的答案或许是,在敏感问题上,先查查老板说了什么。

昨天Grok4发布完以后,我随手刷了一下X。

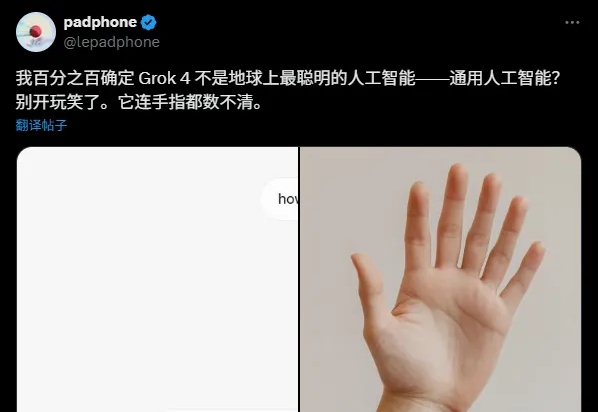

Grok 4 发出之后,风评非常两级。有人大喷特喷,觉得它又贵又不好用。有的则啧啧称神,断言「AGI 已经实现啦」。

马斯克憾失女将!Linda Yaccarino突然宣布辞去𝕏的CEO职务。她的离职,正逢Grok深陷争议漩涡。在职期间,马斯克反复无常,而她无力回天、黯然离场。

今天是 xAI 的大日子,伊隆・马斯克早早就宣布了会在今天发布 Grok 4 大模型,AI 社区的眼球也已经向其聚拢,就等着看他的直播(等了挺久)。当然,考虑到 Grok 这些天的「失控」表现,自然也有不少人是在等着看笑话。

Grok 4一夜爆火硅谷,幕后团队功不可没。今天,一张内部作战图在全网疯转,华人学者占比高达80%。清华、上交、浙大等校友云集,还有一位95后联创。

大家都有看 Grok4 的发布会吗?Grok4 预热了好几天,没想到马斯克还贴心地选择了国内时间发布,再也不用熬夜看发布会了。