Ilya、小扎之后,苏莱曼的「超级智能」进入7年倒计时!

Ilya、小扎之后,苏莱曼的「超级智能」进入7年倒计时!大家一直热衷谈论的AGI忽然不香了,主流的AI公司都开始改口谈「超级智能」,AGI已经沦落为研究员口中的「自动化软件开发工具」。苏莱曼领军的微软MAI团队,正成为超级智能赛道一位新的「超级玩家」。曾曝「欺凌员工」的他,如今要打造有「人味」的AI。

大家一直热衷谈论的AGI忽然不香了,主流的AI公司都开始改口谈「超级智能」,AGI已经沦落为研究员口中的「自动化软件开发工具」。苏莱曼领军的微软MAI团队,正成为超级智能赛道一位新的「超级玩家」。曾曝「欺凌员工」的他,如今要打造有「人味」的AI。

马斯克似乎并不想翻篇,转发了一位博主 po 出的 Ilya 最新证词的帖子,称这是「一个 52 页的故事」。在这份证词中,Ilya Sutskever 曝出了他围绕罢免 Sam Altman 所采取的关键行动。

还记得Ilya把奥特曼赶出OpenAI的那场宫斗大戏吗?时隔两年,又有新的猛料爆出来了。10月1日,在旧金山,马斯克和OpenAI的律师对Ilya Sutskever进行了长达近10个小时的质询。

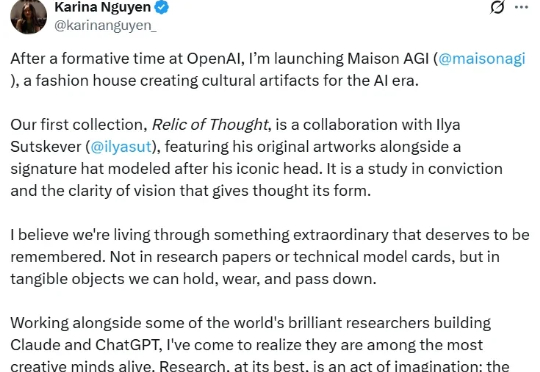

前OpenAI研究员Karina Nguyen宣布创立时尚品牌Maison AGI,首个系列就前OpenAI研究员Karina Nguyen宣布创立时尚品牌Maison AGI,首个系列就与Ilya Sutskever合作,甚至要推出一顶以他头型为原型的帽子。她称,这可能是人类在被AI超越前,最后一次「手作」。当科学家成了灵感缪斯,研究员开始做纪念品,AI的故事,正从技术革命变成人类的自我信仰。

Ilya最新发文引爆全网,AGI内部实现了吗?OpenAI前主管的一句话,瞬间点醒了许多人:AI其实早已觉醒,只是我们还在大梦中不醒。

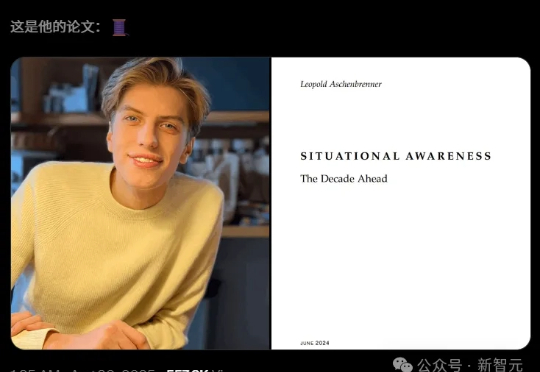

他曾是Ilya的亲信,因揭露OpenAI安全隐患被解雇,却在短短6个月内以47%回报打造出管理规模15亿美元的基金。作为AI安全激进派,他在165页论文《Situational Awareness》中预测2027年将迎来AGI,并呼吁建立「AI版曼哈顿计划」。

Ilya「换头」全网炸锅,难道内部已实现「超级智能」?另一边,OpenAI研究员集体高潮,惊呼感受AGI,究竟在憋着什么大招?

Ilya之后,谁是支撑起OpenAI研究的人? GPT-5发布前夕,奥特曼公开了他背后的两位90后得力干将。

Ilya登顶、Hinton家族双双入选、图灵「穿越上榜」,本科生的也能冲进前十!

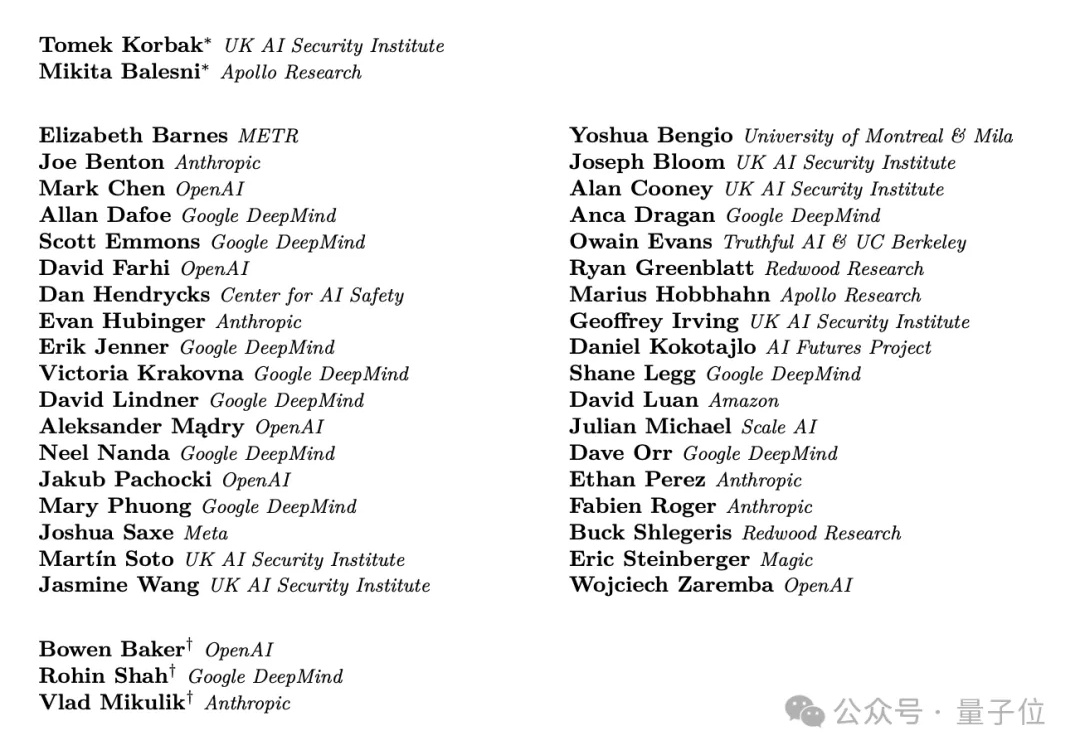

难得难得,几大AI巨头不竞争了不抢人了,改联合一起发研究了。