Llama架构比不上GPT2?神奇token提升10倍记忆?

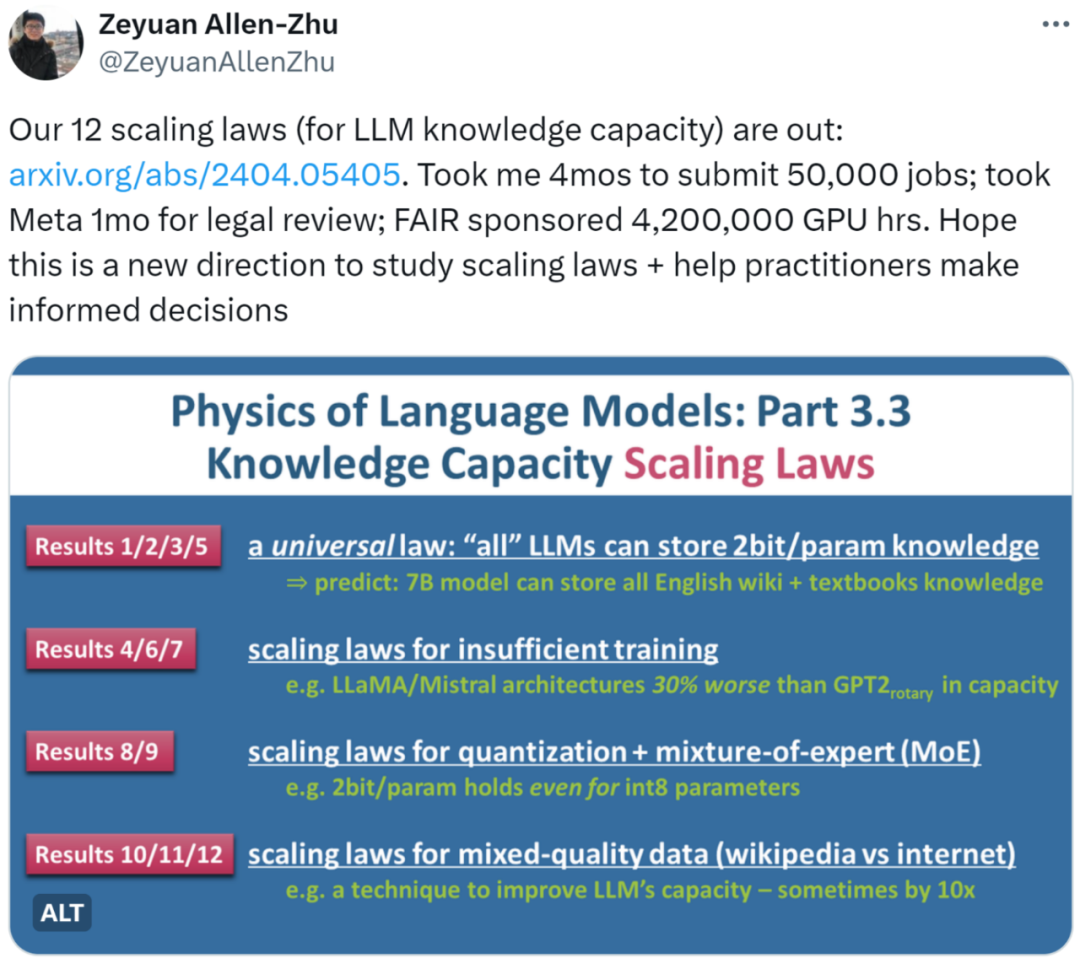

Llama架构比不上GPT2?神奇token提升10倍记忆?近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在不同条件下的知识容量提供了较为精确的计量方法。

近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在不同条件下的知识容量提供了较为精确的计量方法。

上个月,彭博社消息称苹果正在与 Google 进行谈判,希望将 Gemini 集成的 iPhone 当中,为 iPhone 的软件提供 AI 相关的新功能。把新系统的核心功能“外包”给第三方,这种做法非常不苹果。

大语言模型的「逆转诅咒」,被解开了。近日,来自Meta FAIR的研究人员推出了反向训练大法,让模型从反方向上学到了事实之间的逻辑,终于改进了这个困扰人们已久的问题。

距离AI「杀死」搜索引擎,到底还差几步?

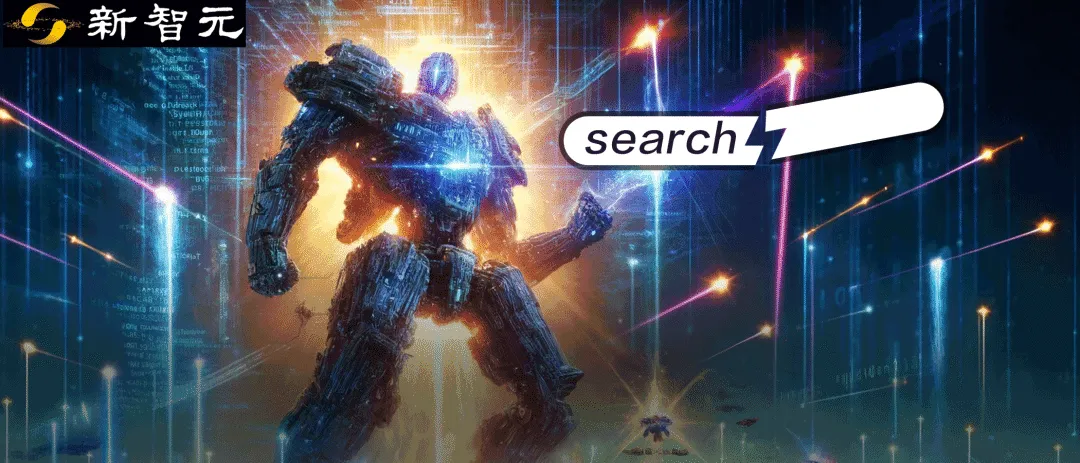

自动将不同开源模型进行组合,生成具有新能力的新模型,Sakana AI开发的新方法做到了!

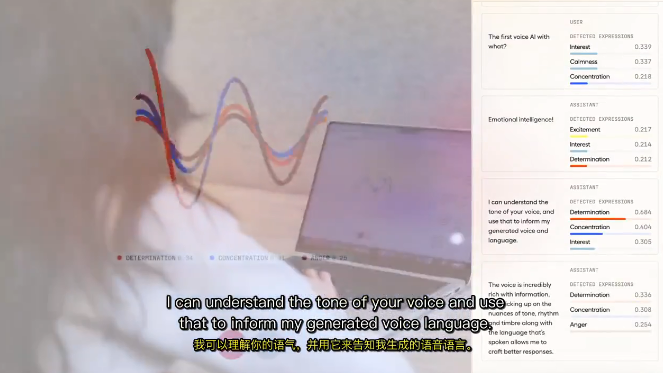

第一个能听懂你说话的语气、有“情商”的AI火了!

中国领先的 Data Centric AI 赋能平台及解决方案服务商

近日,天才程序员Justine Tunney发推表示自己更新了Llamafile的代码,通过手搓84个新的矩阵乘法内核,将Llama的推理速度提高了500%!

Gecko 是一种通用的文本嵌入模型,可用于训练包括文档检索、语义相似度和分类等各种任务。文本嵌入模型在自然语言处理中扮演着重要角色,为各种文本相关任务提供了强大的语义表示和计算能力。

「这是自 Karpathy 和我 2015 年启动这门课程以来的第 9 个年头,这是人工智能和计算机视觉令人难以置信的十年!」知名 AI 科学家李飞飞的计算机视觉「神课」CS231n,又一次开课了。