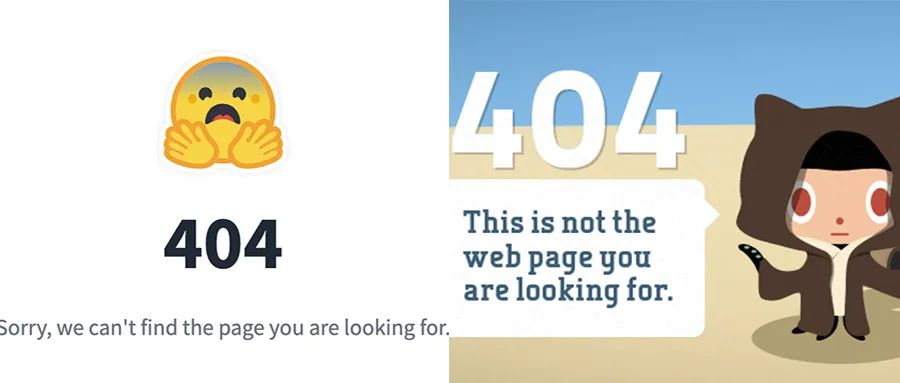

斯坦福AI团队抄袭国产大模型?连识别“清华简”都抄了,清华系团队发文回应

斯坦福AI团队抄袭国产大模型?连识别“清华简”都抄了,清华系团队发文回应面壁智能回应:“深表遗憾”,这也是一种“受到国际团队认可的方式”。

面壁智能回应:“深表遗憾”,这也是一种“受到国际团队认可的方式”。

大模型抄袭丑闻总是不断。

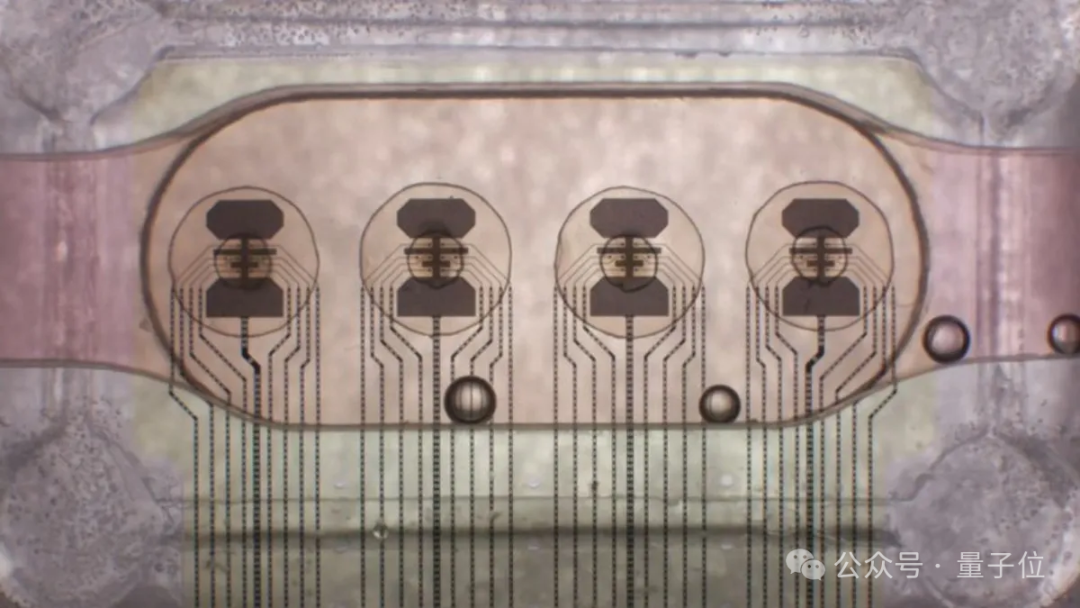

首个“脑PU”来了!由“16核”类人脑器官(human brain organoids)组成。

研究人员提出了一种新的大型语言模型训练方法,通过一次性预测多个未来tokens来提高样本效率和模型性能,在代码和自然语言生成任务上均表现出显著优势,且不会增加训练时间,推理速度还能提升至三倍。

在以英语为主的语料库上训练的多语言LLM,是否使用英语作为内部语言?对此,来自EPFL的研究人员针对Llama 2家族进行了一系列实验。

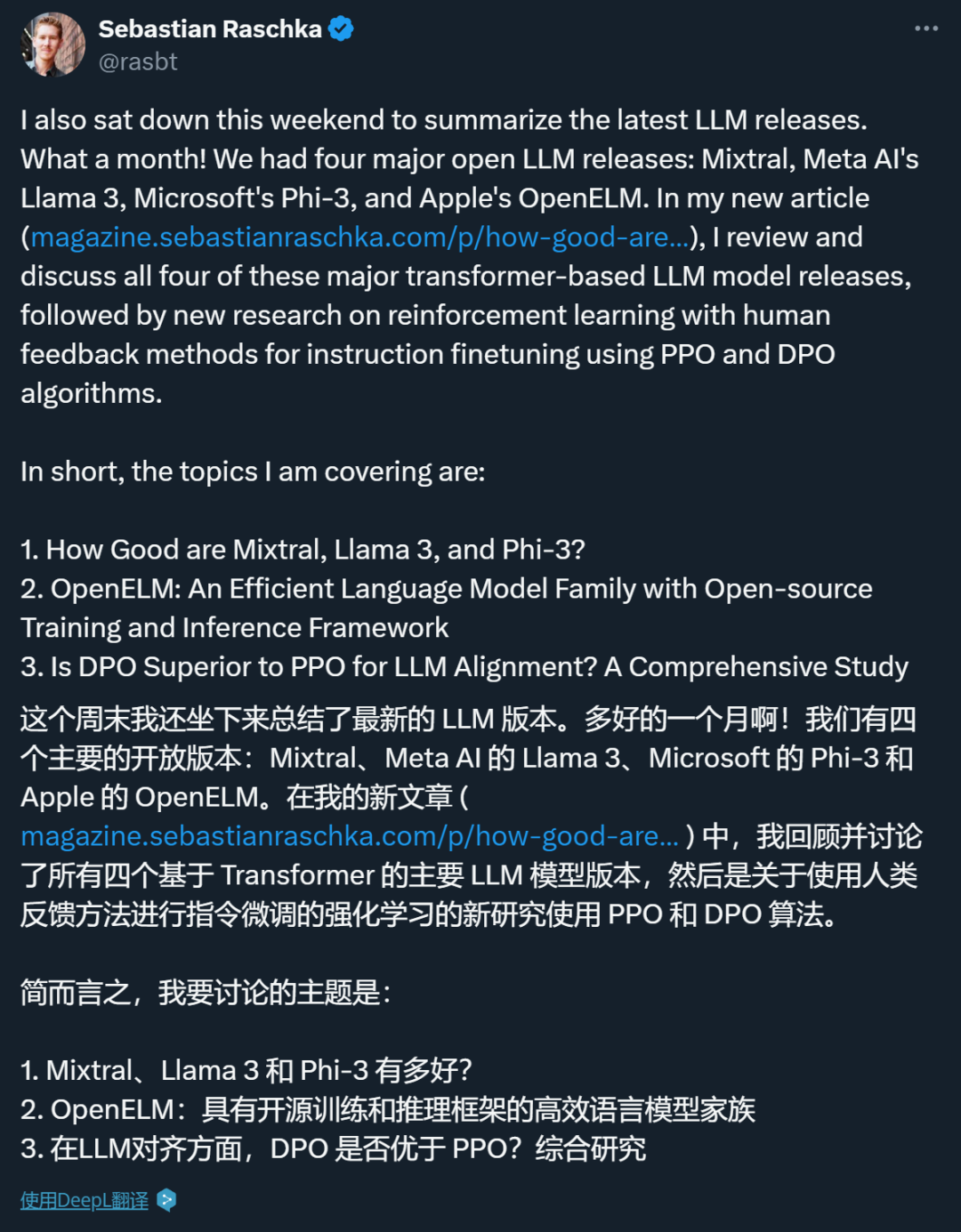

深度学习领域知名研究者、Lightning AI 的首席人工智能教育者 Sebastian Raschka 对 AI 大模型有着深刻的洞察,也会经常把一些观察的结果写成博客。在一篇 5 月中发布的博客中,他盘点分析了 4 月份发布的四个主要新模型:Mixtral、Meta AI 的 Llama 3、微软的 Phi-3 和苹果的 OpenELM。

开放但禁止商用用途。

开源代码大模型的王座,再次易主! 来自素有“欧洲OpenAI”之称的Mistral,用22B参数量表现超越了70B的Code Llama。

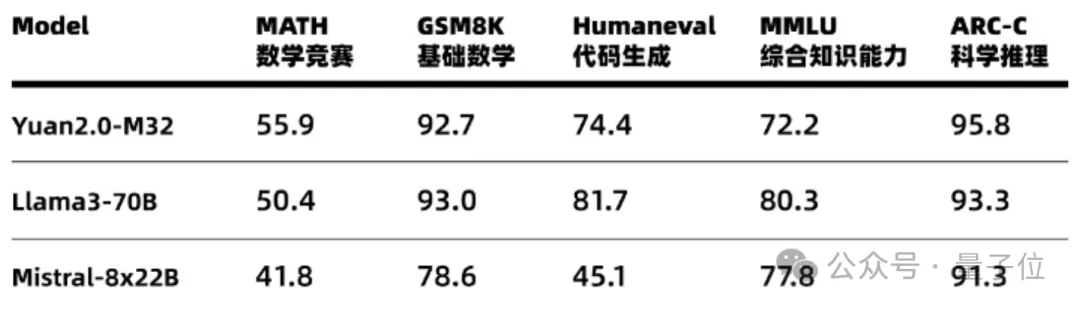

每个token只需要5.28%的算力,精度就能全面对标Llama 3。

就在刚刚,法国AI初创公司Mistral发布了自家首款代码生成模型Codestral。不仅支持32K长上下文窗口以及80多种编程语言,而且还用22B的参数量取得了与70B的Llama 3相近的性能。目前,已经开放API与IDE插件供用户使用。