2025,AI Agent赛道还有哪些机会?

2025,AI Agent赛道还有哪些机会?进入2025年以来, AI Agent的发展明显提速。5月6日,OpenAI宣布以30亿美元收购 Windsurf;编程工具Cursor的母公司Anysphere也获得了9亿美元的融资,估值高达90亿美元;号称中国第一个通用AI Agent的Manus在五月也获得了硅谷老牌风险投资公司Benchmark领投的7500万美元的融资;

进入2025年以来, AI Agent的发展明显提速。5月6日,OpenAI宣布以30亿美元收购 Windsurf;编程工具Cursor的母公司Anysphere也获得了9亿美元的融资,估值高达90亿美元;号称中国第一个通用AI Agent的Manus在五月也获得了硅谷老牌风险投资公司Benchmark领投的7500万美元的融资;

随着基础模型的快速发展和 AI Agent 进入规模化应用阶段,被广泛使用的基准测试(Benchmark)却面临一个日益尖锐的问题:想要真实地反映 AI 的客观能力正变得越来越困难。

知名科技记者马克·古尔曼(Mark Gurman)撰文表示,苹果公司正准备允许第三方开发者使用其人工智能模型编写软件,旨在推动新应用的开发,并提升其设备的吸引力。知情人士透露,苹果正在开发一套软件开发工具包(SDK)及相关框架,以便外部开发者能够基于苹果的大语言模型构建AI功能。这一计划预计将在6月9日的全球开发者大会(WWDC)上公布。

根据TechCrunch和Semafor等报道,美国财政部正在审查Benchmark Capital对中国初创公司Manus AI的7500万美元投资,据两位知情人士透露,这已经反映出中美之间的科技竞争已经升级到政治层面。

AI研究中,基准测试(benchmark)和排行榜在评估模型性能上扮演着关键角色。

外媒报道,Manus 最近完成了一轮由美国风险投资公司 Benchmark 领投的 7500 万美元的融资。蝴蝶效应计划利用这笔资金将其服务扩展到包括美国、日本和中东在内的其他市场。据 The Information 上周报道,Manus 使用 Anthropic 的 Claude AI 模型及其他工具,平均每个任务需向 Anthropic 支付 2 美元。

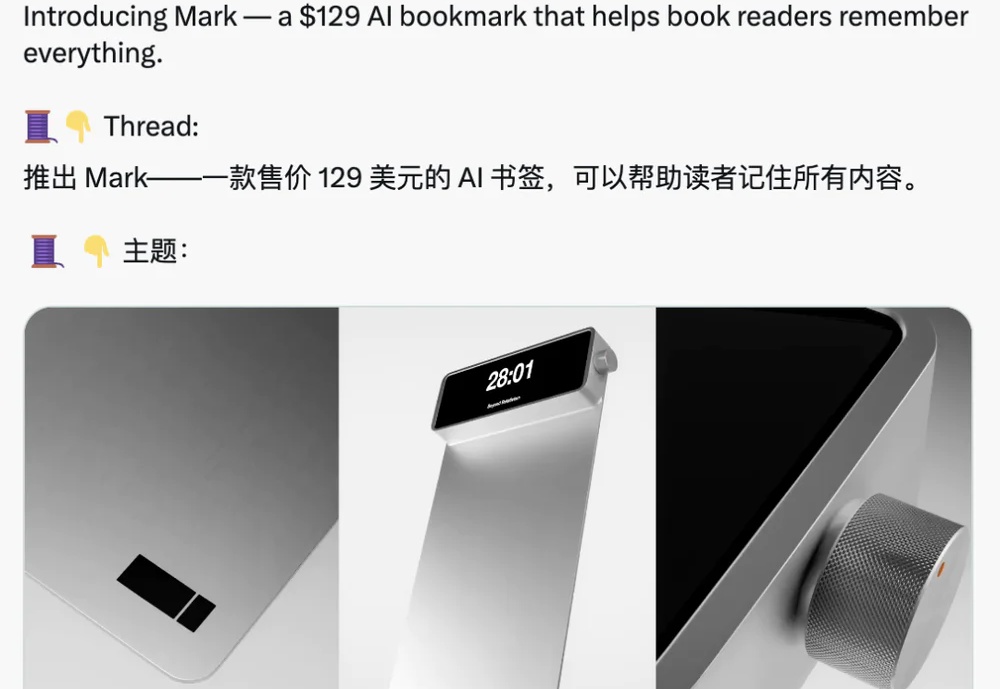

一叠便签纸、一个普通书签和一支笔,售价2美元(折合人民币14.7元)。一个能做类似事情的钛合金AI书签,售价129美元(折合人民币947元),你会心动吗?

MIT物理学大牛Max Tegmark团队,再出重磅力作。他们发现:AI能够在没有任何先验知识的情况下,完全独立地提出哈密顿物理量,或拉格朗日方程式。仅仅通过尝试解释数据,AI就自己收敛到了这些物理原则,发现了宇宙间的奥秘!

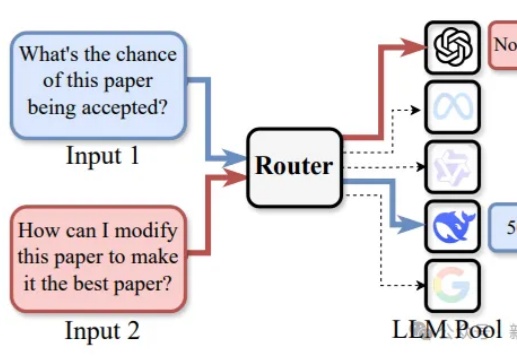

路由LLM是指一种通过router动态分配请求到若干候选LLM的机制。论文提出且开源了针对router设计的全面RouterEval基准,通过整合8500+个LLM在12个主流Benchmark上的2亿条性能记录。将大模型路由问题转化为标准的分类任务,使研究者可在单卡甚至笔记本电脑上开展前沿研究。

今年年初,OpenAI 上线 Deep Research,开启了智能体又一新阶段,其能根据用户需求自主进行网络信息检索、整合多源信息、深度分析数据,并最终为用户提供全面深入的解答。