Chain-of-Agents: OPPO推出通用智能体模型新范式,多榜单SOTA,模型代码数据全开源

Chain-of-Agents: OPPO推出通用智能体模型新范式,多榜单SOTA,模型代码数据全开源近年来,以多智能体系统(MAS)为代表的研究取得了显著进展,在深度研究、编程辅助等复杂问题求解任务中展现出强大的能力。现有的多智能体框架通过多个角色明确、工具多样的智能体协作完成复杂任务,展现出明显的优势。

近年来,以多智能体系统(MAS)为代表的研究取得了显著进展,在深度研究、编程辅助等复杂问题求解任务中展现出强大的能力。现有的多智能体框架通过多个角色明确、工具多样的智能体协作完成复杂任务,展现出明显的优势。

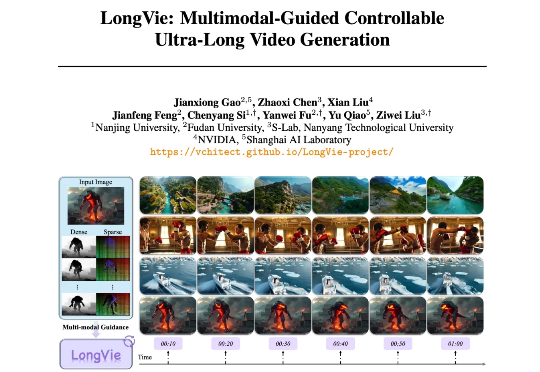

从 Sora 的惊艳亮相到多款高性能开源模型的诞生,视频生成在过去两年迎来爆发式进步,已能生成几十秒的高质量短片。然而,要想生成时长超过 1 分钟、内容与运动可控、风格统一的超长视频,仍面临巨大挑战。

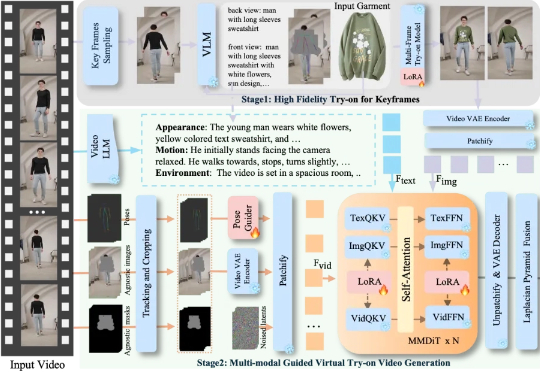

服装视频广告太烧钱?卡点变装太难拍? 字节跳动智能创作团队联合清华大学最新推出一款全能的视频换装模型 DreamVVT,为视频虚拟试穿领域带来了突破性进展。

“我真的厌倦了看到那些急于求成的科技初创公司,为了讨好风投而在数据上撒谎,还贴上‘SOTA’的标签。”有网友吐槽。 事情源于高人气开源智能体记忆项目 Mem0 在今年 4 月底发布的一篇论文。

刚刚,一篇来自香港大学 XLANG Lab 和月之暗面等多家机构的论文上线了 arXiv,其中提出了一个用于构建和扩展 CUA(使用计算机的智能体)的完全开源的框架。 使用该框架,他们还构建了一个旗舰模型 OpenCUA-32B,其在 OSWorld-Verified 上达到了 34.8% 的成功率,创下了新的开源 SOTA,甚至在这个基准测试中超越了 GPT-4o。

智谱基于GLM-4.5打造的开源多模态视觉推理模型GLM-4.5V,在42个公开榜单中41项夺得SOTA!其功能涵盖图像、视频、文档理解、Grounding、地图定位、空间关系推理、UI转Code等。

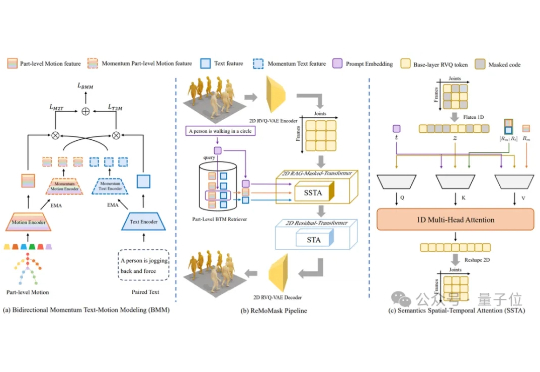

北京大学提出了ReMoMask:一种全新的基于检索增强生成的Text-to-Motion框架。它是一个集成三项关键创新的统一框架:(1)基于动量的双向文本-动作模型,通过动量队列将负样本的尺度与批次大小解耦,显著提高了跨模态检索精度;(2)语义时空注意力机制,在部件级融合过程中强制执行生物力学约束,消除异步伪影;(3)RAG-无分类器引导结合轻微的无条件生成以增强泛化能力。

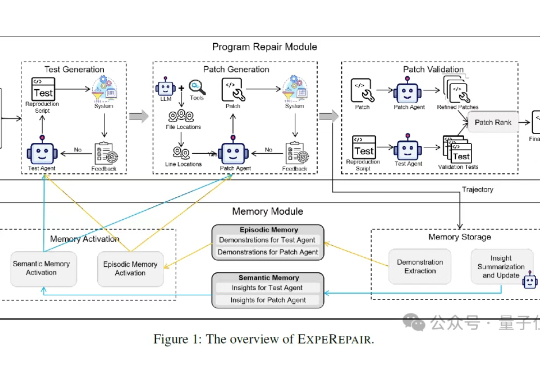

AI学会像人一样修Bug了!“这个Bug我上周刚修过”“这个报错怎么又来了”“新人怎么又在同一个地方踩坑”……

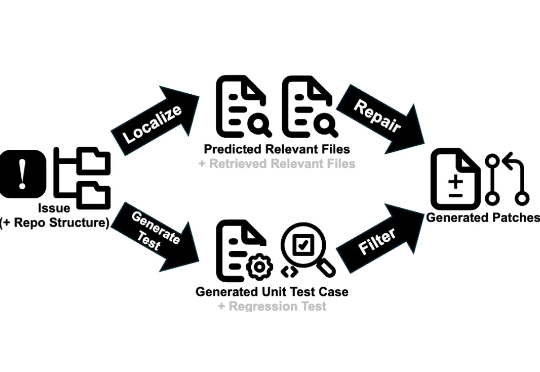

近日,一项由北京大学、字节跳动 Seed 团队及香港大学联合进行的研究,提出了一种名为「SWE-Swiss」的完整「配方」,旨在高效训练用于解决软件工程问题的 AI 模型。研究团队推出的 32B 参数模型 SWE-Swiss-32B,在权威基准 SWE-bench Verified 上取得了 60.2% 的准确率,在同尺寸级别中达到了新的 SOTA。

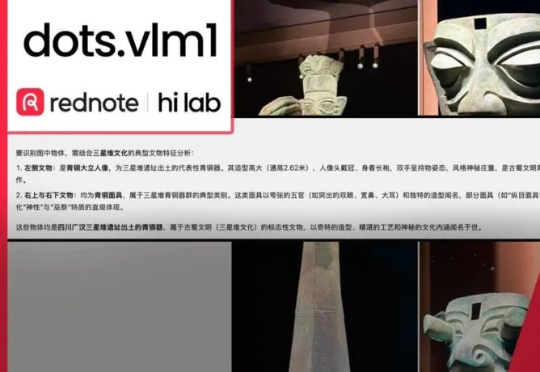

擅长「种草」的小红书正加大技术自研力度,两个月内接连开源三款模型!最新开源的首个多模态大模型dots.vlm1,基于自研视觉编码器构建,实测看穿色盲图,破解数独,解高考数学题,一句话写李白诗风,视觉理解和推理能力都逼近Gemini 2.5 Pro闭源模型。