硅谷全面“龙虾化”!Anthropic微软Meta和Notion等集体交卷自己的Claw

硅谷全面“龙虾化”!Anthropic微软Meta和Notion等集体交卷自己的Claw现在硅谷最火的词,绝对是Claw。就在过去的半个月里,全球AI巨头似乎集体接到了一份名为“做自己的OpenClaw”的剧本。Meta急了。

现在硅谷最火的词,绝对是Claw。就在过去的半个月里,全球AI巨头似乎集体接到了一份名为“做自己的OpenClaw”的剧本。Meta急了。

所有人都在等 DeepSeek,春节来,下周来,还是没来。 一场为了全面「狙击」 DeepSeek,抢夺流量,但是 DeepSeek 都没出现的春节大战,就在一轮又一轮的红包奶茶里轰轰烈烈地结束了。

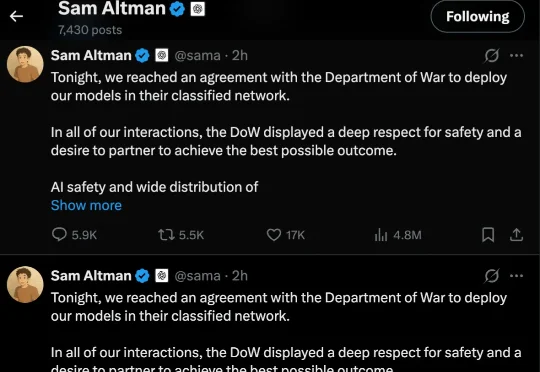

就在奥特曼公开支持 Anthropic、声称反对五角大楼施压后不到 12 小时,剧情发生了戏剧性逆转。刚刚,奥特曼在 X 上连发三条相同的帖子,宣布 OpenAI 已与美国五角大楼达成协议,将模型部署到他们的机密网络中。

全球最大游戏博主 PewDiePie,又整活了。他靠着「偷师」DeepSeek、清华大学发布的技术文档,用一堆魔改显卡成功微调出一个自己的 AI 模型,而这个模型在编程基准测试中的表现,竟然超越了 GPT-4 和 Gemini 2.5 Pro。

此事件震动了整个硅谷。虽然此前因为抨击其他 AI 公司「蒸馏」其模型,Anthropic 成为了众矢之的,但目前 Anthropic 在科技界获得了巨大的声援。包括竞争对手 OpenAI、谷歌都公开表态支持 Anthropic 坚守底线的决定。

北京时间 2 月 28 日上午 9:24,Anthropic 官方账号发布置顶声明,回应国防部长 Hegseth 的供应链风险标签宣告,这是 Anthropic 在事件公开后的首次正式表态,声明同步挂在 anthropic.com 官网

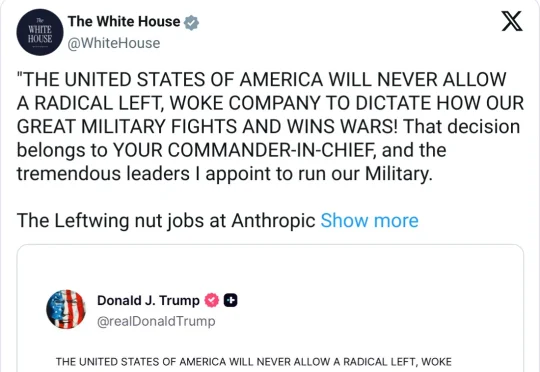

白宫官方账号于北京时间 2 月 28 日凌晨转发特朗普声明(发布于特朗普自己的媒体 Truth Social),宣布所有联邦机构立即停用 Anthropic 技术,给予六个月过渡期

VUI Labs(宇生月伴)宣布完成数千万元天使+轮融资。本轮投资由同创伟业领投、老股东靖亚资本、小苗朗程持续加注,心流资本FlowCapital担任长期财务顾问。公司半年累计获得近亿元投资,所募资金

Anterior,刚刚完成了 4000 万美元的融资,使其总融资额达到 6400 万美元。这轮融资由 NEA 和 Sequoia Capital 继续参与,新投资者包括 FPV 和 Kinnevik。但让我真正感兴趣的不是融资金额本身,而是他们正在解决的问题以及他们解决问题的方式。

独家获悉,月之暗面(以下简称“月暗”)已对内部组织架构进行调整。曾经以 C 端产品 Kimi 为主的团队中,负责 API 服务对接的员工一度只有个位数,而如今,随着调用需求激增,该 API 团队正在快速扩编,并以独立业务分支的形式存在,直接向总裁张予彤汇报。