Meta宣布全新训推一体加速器:完全集成PyTorch 2,性能3倍提升

Meta宣布全新训推一体加速器:完全集成PyTorch 2,性能3倍提升Meta 正在不遗余力地想要在生成式 AI 领域赶上竞争对手,目标是投入数十亿美元用于 AI 研究。这些巨资一部分用于招募 AI 研究员。但更大的一部分用于开发硬件,特别是用于运行和训练 Meta AI 模型的芯片

Meta 正在不遗余力地想要在生成式 AI 领域赶上竞争对手,目标是投入数十亿美元用于 AI 研究。这些巨资一部分用于招募 AI 研究员。但更大的一部分用于开发硬件,特别是用于运行和训练 Meta AI 模型的芯片

纯C语言训练GPT,1000行代码搞定!,不用现成的深度学习框架,纯手搓。 发布仅几个小时,已经揽星2.3k。

JAX在最近的基准测试中的性能已经不声不响地超过了Pytorch和TensorFlow,也许未来会有更多的大模型诞生在这个平台上。谷歌在背后的默默付出终于得到了回报。

马斯克说到做到开源Grok-1,开源社区一片狂喜。但基于Grok-1做改动or商用,都还有点难题: Grok-1使用Rust+JAX构建,对于习惯Python+PyTorch+HuggingFace等主流软件生态的用户上手门槛高。

这两天,有关开源的话题又火了起来。有人表示,「没有开源,AI 将一无所有,继续保持 AI 开放。」这个观点得到了很多人的赞同,其中包括图灵奖得主、Meta 首席科学家 Yann LeCun。

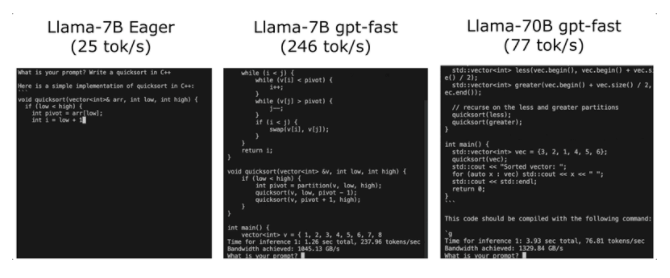

PyTorch团队让大模型推理速度加快了10倍。且只用了不到1000行的纯原生PyTorch代码!

今天,备受广大开发者欢迎的深度学习框架Keras,正式更新了3.0版本,实现了对PyTorch和JAX的支持,同时性能提升,还能轻松实现大规模分布式训练。

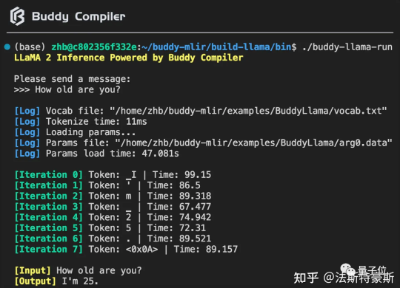

Buddy Compiler 端到端 LLaMA2-7B 推理示例已经合并到 buddy-mlir仓库[1]主线。我们在 Buddy Compiler 的前端部分实现了面向 TorchDynamo 的第三方编译器,从而结合了 MLIR 和 PyTorch 的编译生态。

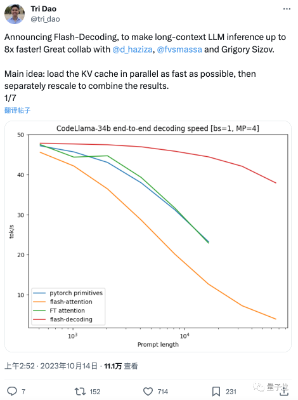

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证

AMD 的 Ryzen AI for Windows 是该公司基于 Zen 4 微架构的 Ryzen 7040 系列 APU 中内置的一个硬件单元。AMD 的 Vitis AI 为人工智能推理提供了强大的工具集,可与 TensorFlow、PyTorch 和 ONNX 等流行框架无缝集成。