Karpathy「疯狂之作」:100美元、4小时,就能训练你自己的「小型GPT」

Karpathy「疯狂之作」:100美元、4小时,就能训练你自己的「小型GPT」AI传奇人物、前特斯拉AI总监Karpathy重磅推出全新开源项目「nanochat」,以不到8000行代码复现ChatGPT全流程,只需一台GPU、约4小时、成本仅百美元。该项目在GitHub上线不到12小时即获4.2k星标!

AI传奇人物、前特斯拉AI总监Karpathy重磅推出全新开源项目「nanochat」,以不到8000行代码复现ChatGPT全流程,只需一台GPU、约4小时、成本仅百美元。该项目在GitHub上线不到12小时即获4.2k星标!

该公司周二宣布完成530 万美元种子轮融资,本轮由 Outlander VC 和 Field Ventures 共同领投。埃默里透露,部分投资人源自他上一个创业项目,这些早期投资者又为他引荐了本轮领投机构。其他参投方包括 Hootsuite 创始人联合创立的 LOI Venture、Zenda Capital、8-Bit Capital 以及 Behind Genius Ventures。

Computer use是真正Agents的关键驱动力。它们的有效性取决于两个因素:能够接入多少工具,以及能否在这些工具之间进行推理。Computer use显著拓展了这两方面的能力——既赋予Agents使用任意软件的广度,也提升了它们将一系列动作串联成完整工作流的智能。

GPT-5,一夜又成为了编码圈的顶流。AI大牛Karpathy发文狂赞,Claude Code折腾一小时没搞定的难题,GPT-5 Pro十分钟就完成了,奥特曼秒回感谢。

现在做 AI 课程的,不计其数,吴恩达、Andrej Karpathy,Greg Isenberg 等人更是大神下凡支教。高校如斯坦福、MIT、哈佛等也有公开课资源。

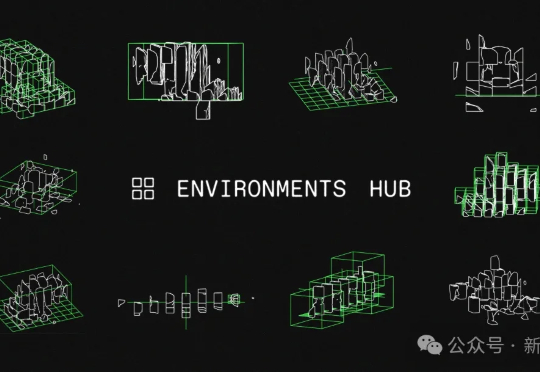

强化学习核心是什么?Karpathy一语道破——环境。全新开源Environments Hub横空出世,为强化学习训练带去革命性突破。

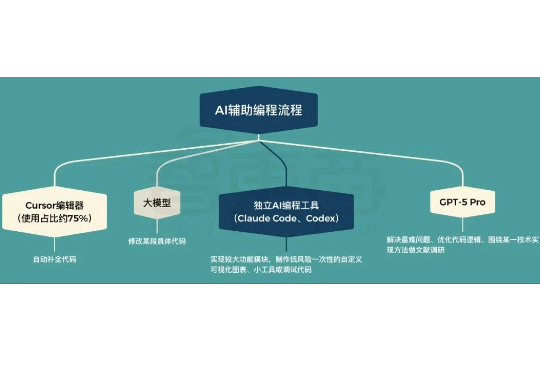

智东西8月25日消息,今日,前特斯拉AI总监、OpenAI联合创始人安德烈·卡帕西(Andrej Karpathy)放出了AI辅助编程的私藏独家秘籍。

刚刚,大神Karpathy发布全新Vibe Coding指南!

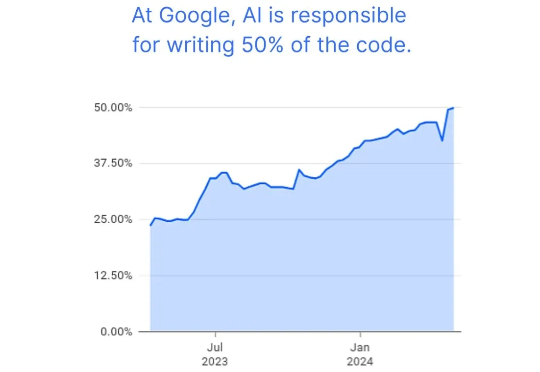

氛围编程(vibe coding),这个由 Andrej Karpathy 带火的热词,已经成为了一种相当流行的编程方式。但这种编程方式的流行程度究竟如何,目前还没有什么比较可靠的统计数据。

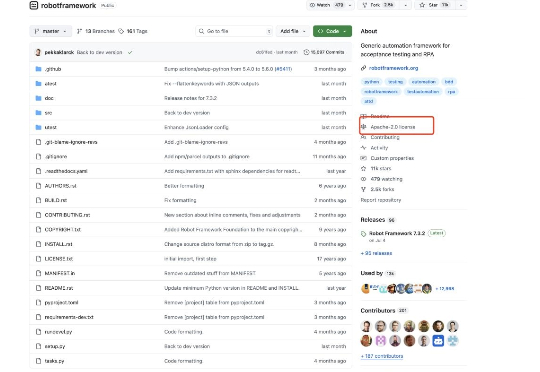

github排名第一,视觉模型与自动化 这两年,RPA+AI(智能自动化流程)经常被提及,在企业/机构数字化转型过程中,自动化和智能化是提升效能的重要方式,而迈向自动化和智能化的第一步则是机器人流程自动化(RPA)。