这一代孩子掉队的新陷阱:AI寒门

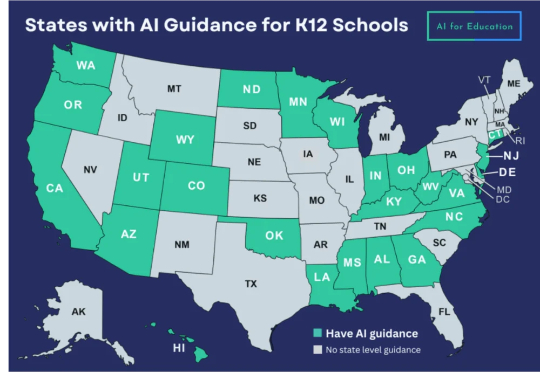

这一代孩子掉队的新陷阱:AI寒门最近一个很火的话题是“AI寒门”,最初由北京大学教育学院副教授林小英提出,指的是父母由于认知局限,不善用甚至排斥AI,导致孩子错失AI浪潮下优化教育资源的机会。

最近一个很火的话题是“AI寒门”,最初由北京大学教育学院副教授林小英提出,指的是父母由于认知局限,不善用甚至排斥AI,导致孩子错失AI浪潮下优化教育资源的机会。

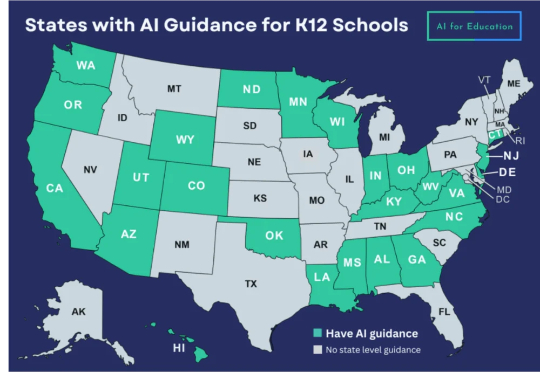

随着大语言模型(LLM)能力的快速迭代,传统评估方法已难以满足需求。如何科学评估 LLM 的「心智」特征,例如价值观、性格和社交智能?如何建立更全面、更可靠的 AI 评估体系?北京大学宋国杰教授团队最新综述论文(共 63 页,包含 500 篇引文),首次尝试系统性梳理答案。

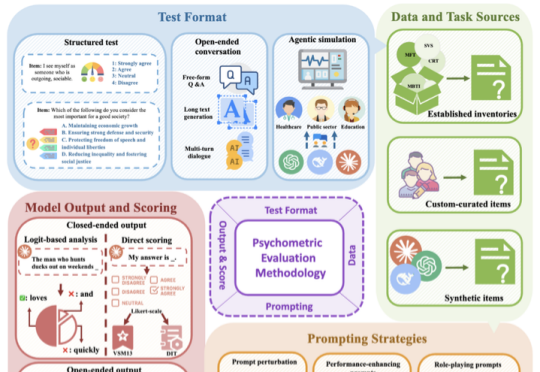

最近,北京大学陈宝权教授带领团队在三维形状生成和三维数据对齐方面取得新的突破。在三维数据生成方面,团队提出了3D自回归模型新范式,有望打破3D扩散模型在三维生成方面的垄断地位。

北京大学团队继VARGPT实现视觉理解与生成任务统一之后,再度推出了VARGPT-v1.1版本。该版本进一步提升了视觉自回归模型的能力,不仅在在视觉理解方面有所加强,还在图像生成和编辑任务中达到新的性能高度

中国科学院深圳先进技术研究院娄春波团队与北京大学定量生物学中心钱珑团队成功推出一款生物制造大语言模型SYMPLEX。SYMPLEX是全球首个面向合成生物学元件挖掘与生物制造应用的大语言模型。

北京大学陈宝权教授团队提出RainyGS技术,通过结合物理模拟和3D高斯泼溅渲染框架,实现了真实场景中动态雨效的高质量仿真与呈现,真正实现「从真实到真实」,或者「以仿真乱真」,即Real2Sim2Real !相比现有的视频编辑工具(如 Runway),其物理真实性获得保证。

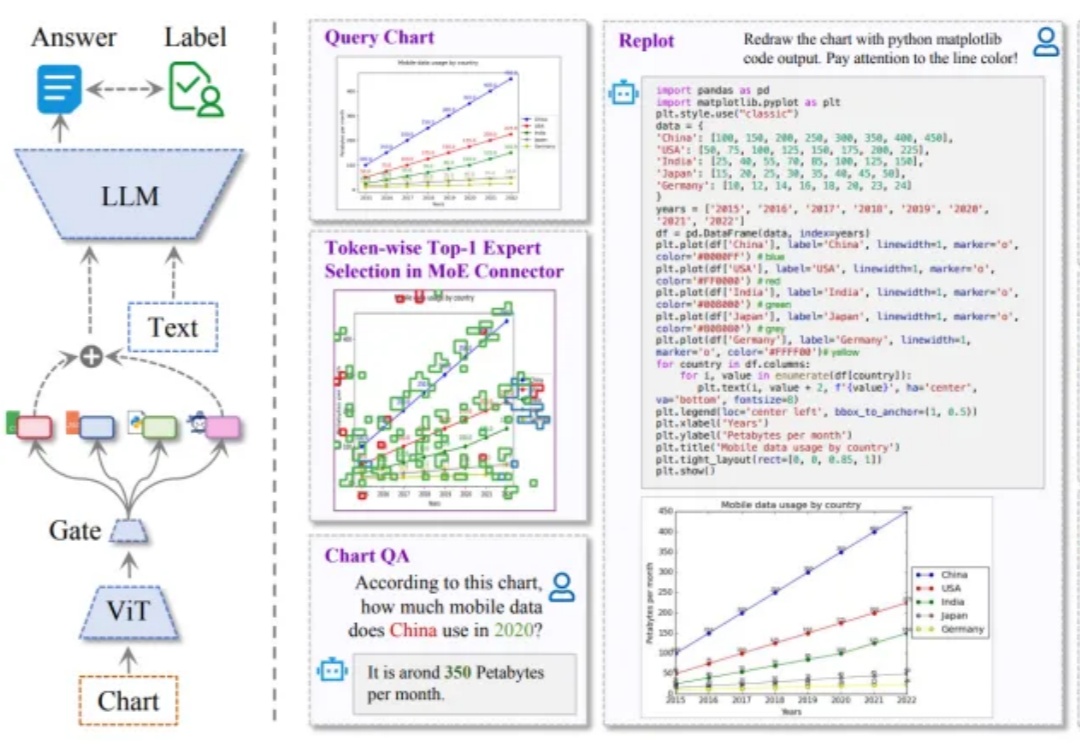

最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由 IDEA、清华大学、北京大学、香港科技大学(广州)联合团队提出的 ChartMoE 成功入选 Oral (口头报告) 论文。据了解,本届大会共收到 11672 篇论文,被选中做 Oral Presentation(口头报告)的比例约为 1.8%

它名为 Uni-3DAR,来自深势科技、北京科学智能研究院及北京大学,是一个通过自回归下一 token 预测任务将 3D 结构的生成与理解统一起来的框架。据了解,Uni-3DAR 是世界首个此类科学大模型。并且其作者阵容非常强大,包括了深势科技 AI 算法负责人柯国霖、中国科学院院士鄂维南、深势科技创始人兼首席科学家和北京科学智能研究院院长张林峰等。

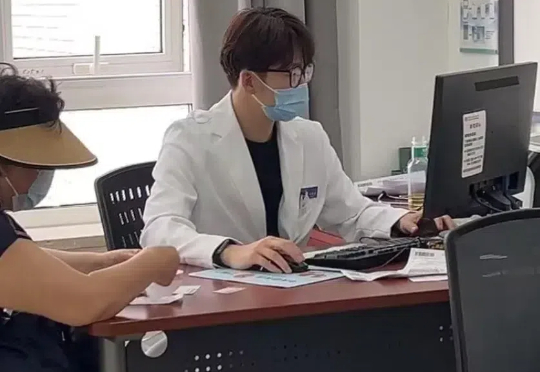

2月26日,北京大学第三医院的心内科诊室里,两种治疗方案在诊台上对峙:左侧是心内科大夫汪京嘉开出的一份用于治疗高血脂的医嘱,右侧是人工智能软件生成的处方。

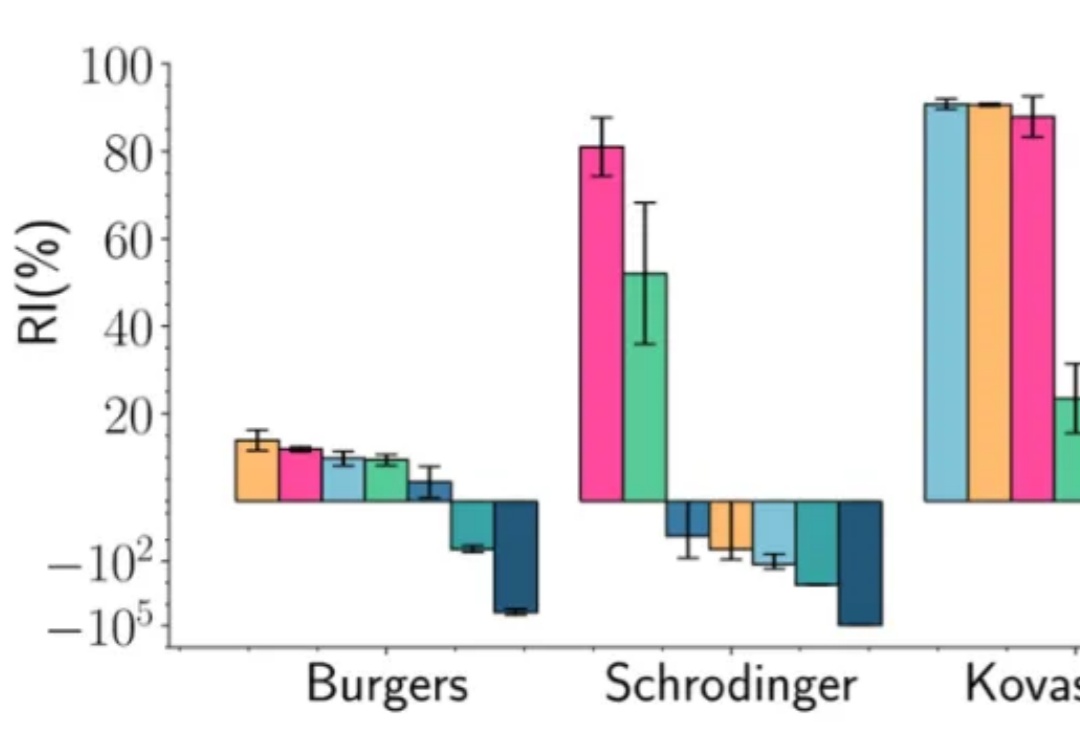

在深度学习的多个应用场景中,联合优化多个损失项是一个普遍的问题。典型的例子包括物理信息神经网络(Physics-Informed Neural Networks, PINNs)、多任务学习(Multi-Task Learning, MTL)和连续学习(Continual Learning, CL)。然而,不同损失项的梯度方向往往相互冲突,导致优化过程陷入局部最优甚至训练失败。