游戏AI来了!英伟达新模型看直播学会所有游戏,GPT-5.2秒杀塞尔达

游戏AI来了!英伟达新模型看直播学会所有游戏,GPT-5.2秒杀塞尔达英伟达让AI仅靠「看直播」就学会了通用游戏操作。虚拟世界已成为物理智能的黑客帝国,看4万小时直播学会几乎所有游戏!

英伟达让AI仅靠「看直播」就学会了通用游戏操作。虚拟世界已成为物理智能的黑客帝国,看4万小时直播学会几乎所有游戏!

真是越到年底,越是神仙打架。

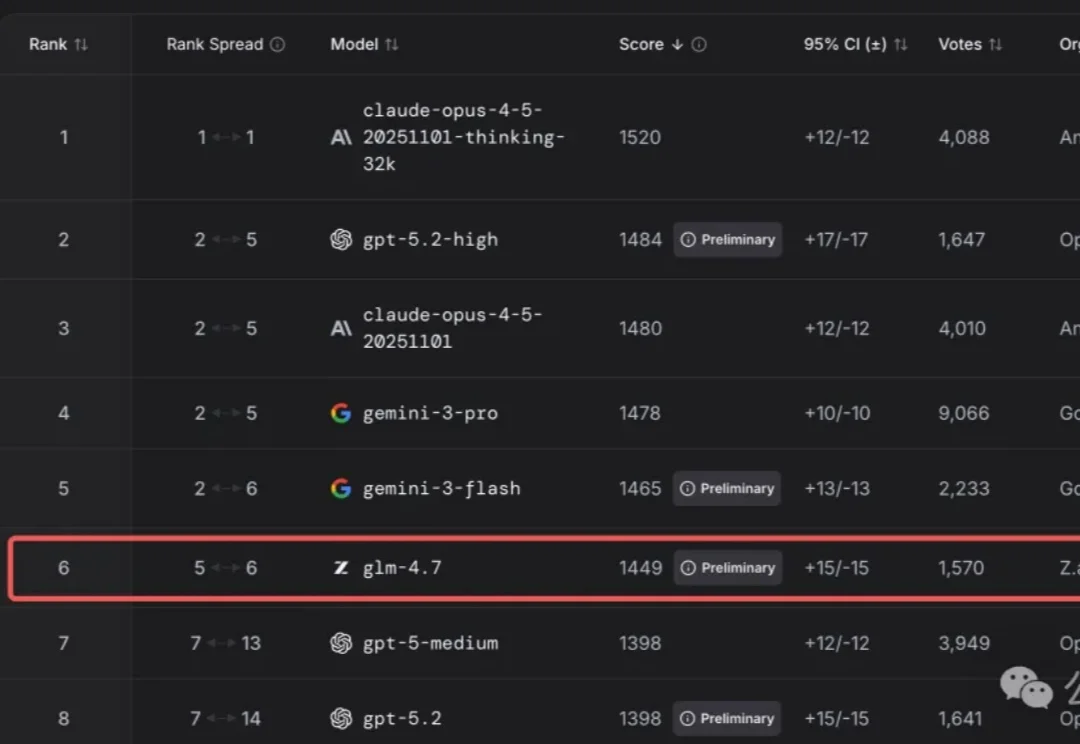

智谱作为「大模型第一股」赴港上市前夕,直接掏出了旗舰模型GLM-4.7并开源!

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

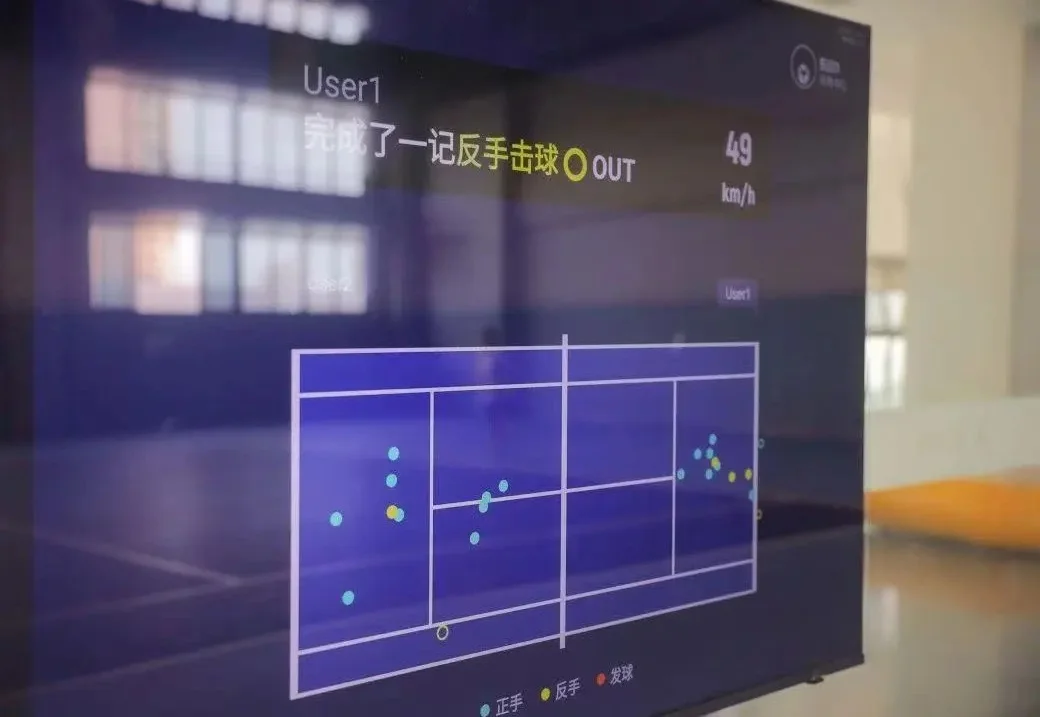

用 AI,把百万级的鹰眼系统打造「万元级」的平民运动生意。

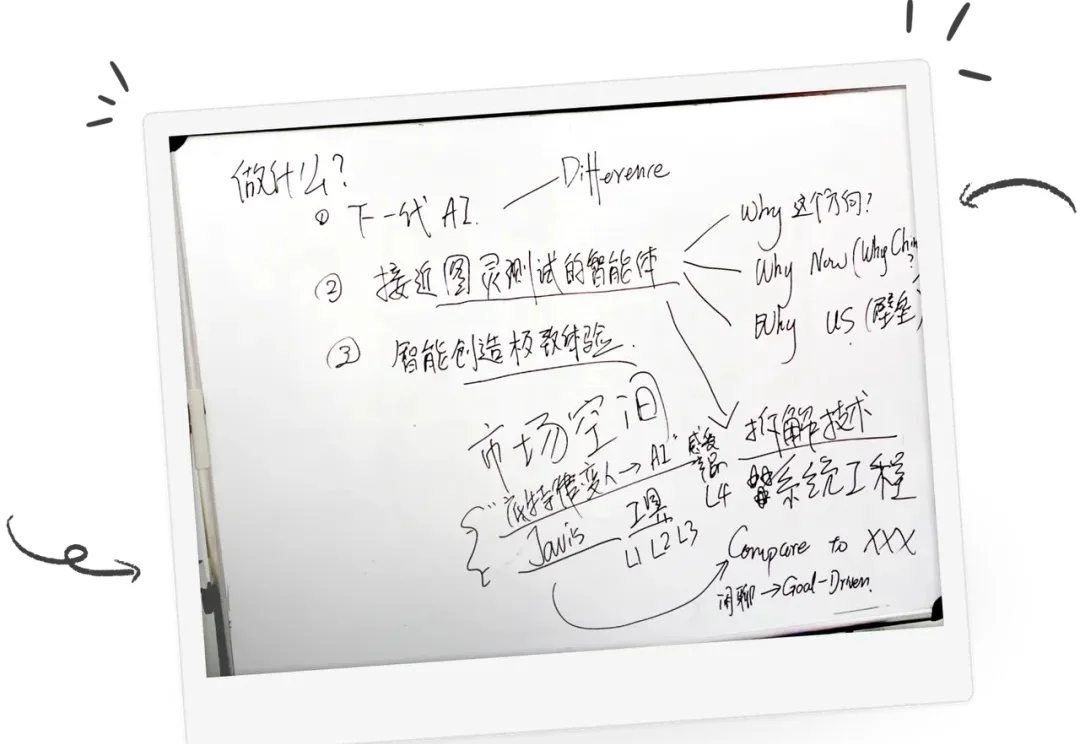

如果说,去年是国内大模型的应用元年,那么2025年无疑是行业的分化之年。此刻你选择的叙事,决定了你看到的世界。

回顾 2025 年,如果问普通人对 AI 行业最深刻的印象是什么?答案依然是激烈的“参数战争”:有 DeepSeek、Gemini 3 等大模型的集体爆发,也有文生图、文生视频能力的持续惊艳。

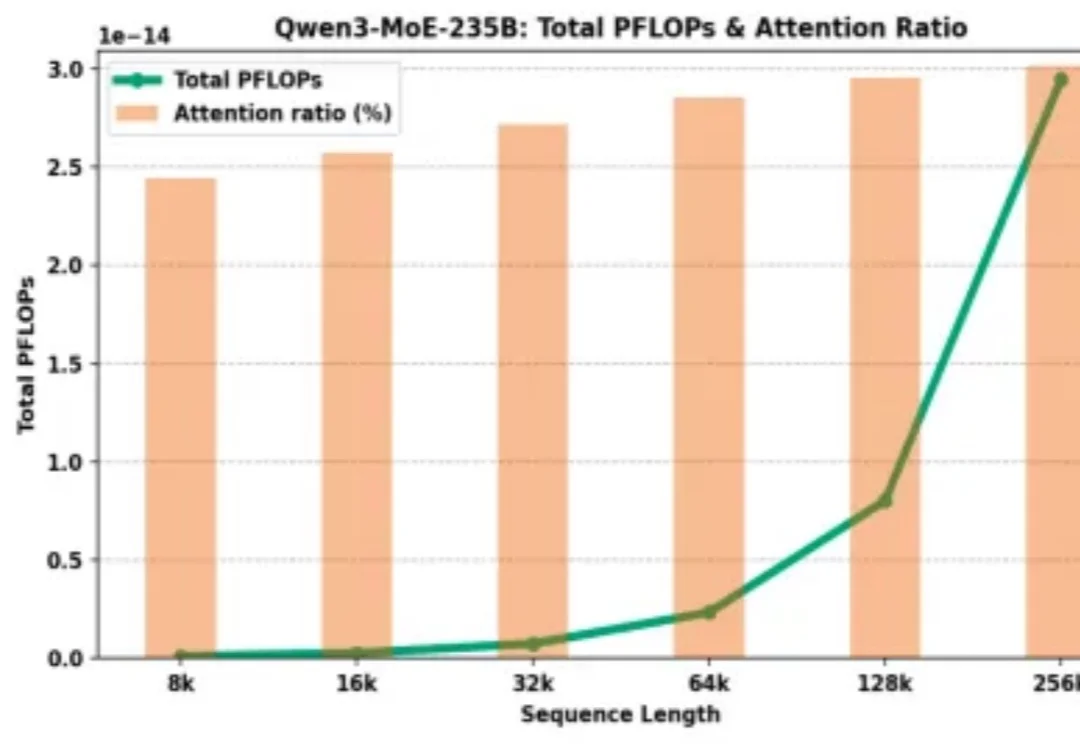

为什么大模型厂商给了 128K 的上下文窗口,却在计费上让长文本显著更贵?

参数越小,智商越高?Gemini 3 Flash用百万级长上下文、白菜价成本,把自家大哥Pro按在地上摩擦。谷歌到底掏出了什么黑魔法,让整个大模型圈开始怀疑人生?

来猜一下,AI时代,医生最哭笑不得的是什么?