苹果AI论文太坑了!用GPT写的GT,导致北京程序员通宵加班

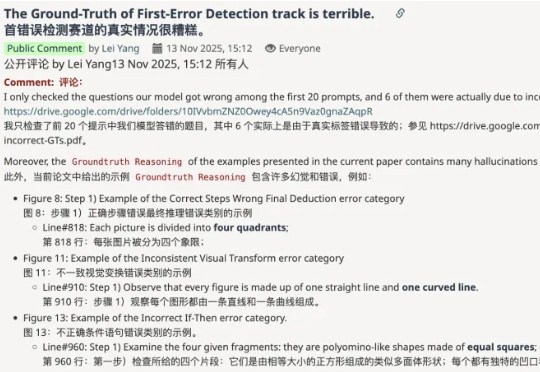

苹果AI论文太坑了!用GPT写的GT,导致北京程序员通宵加班大无语事件天天有,今天特别多——AI大模型公司阶跃星辰的研究员,自曝被苹果挂在arXiv上的论文,狠狠坑了一把。自己去反馈问题,对方简单回了两句就把issue关了;直到自己留下公开评论,对方才撤稿下架代码了。

大无语事件天天有,今天特别多——AI大模型公司阶跃星辰的研究员,自曝被苹果挂在arXiv上的论文,狠狠坑了一把。自己去反馈问题,对方简单回了两句就把issue关了;直到自己留下公开评论,对方才撤稿下架代码了。

正值AlphaFold问世五周年,其设计者、也是凭借AlphaFold获得诺贝尔化学奖的John Jumper公开表示:AlphaFold的下一步是与大模型融合。不过具体方法并没有透露,或许已有所思路,甚至已经在进程之中。

如果不是这波大模型的爆发,没人会想到「输入法」这个早已被视为「基础设施」的赛道,会在 2025 年下半年突然变得性感起来。

终于有人要给大模型安“脖子”了!

“后来,人工智能(AI)变得无处不在。如今我们‘勉强’接受NeuroAI这个称呼,只为大众能理解其含义。”

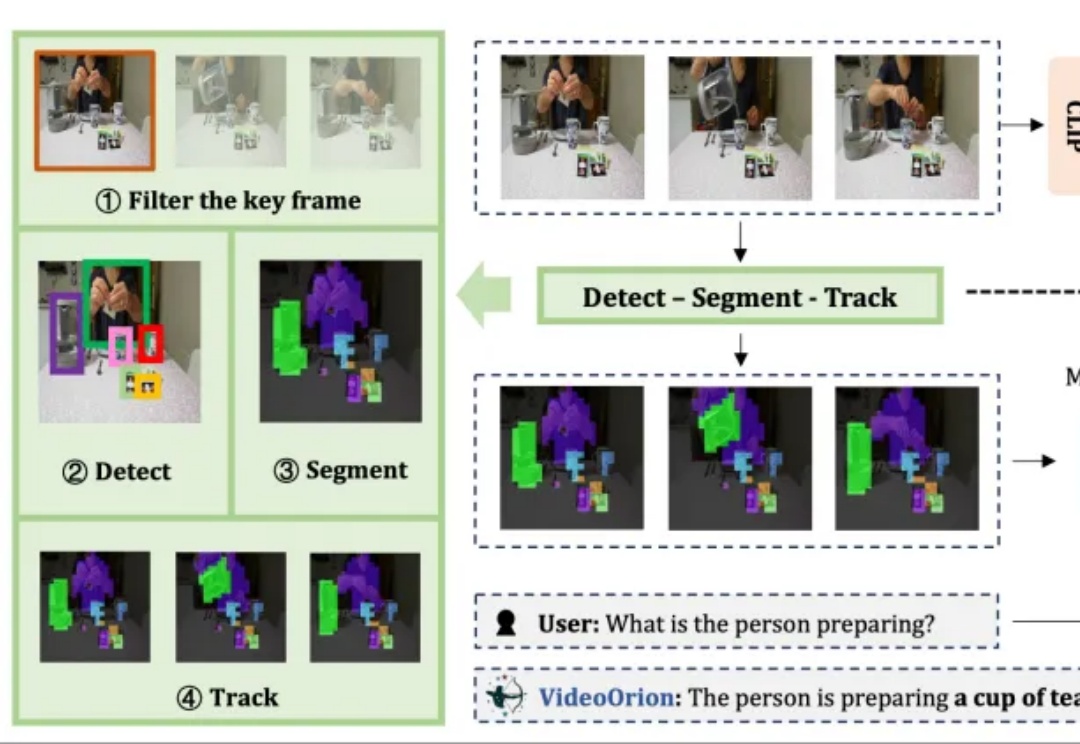

被顶会ICCV 2025以554高分接收的视频理解框架来了!

近期,一支来自美国哈佛大学和美国斯坦福大学等联合团队真的做到了——他们集成 40 余种衰老时钟模型开发了一个名为 ClockBase Agent 的平台,让 AI 在 200 万份人类和小鼠的分子组学数据里“挖宝”,并找出了超过 500 种可能让生物年龄倒退的干预措施。

在 LLM 优化领域,有两个响亮的名字:Adam(及其变体 AdamW)和 Muon。

腾讯混元大模型团队正式发布并开源HunyuanVideo 1.5。

AI正从「规模时代」,重新走向「科研时代」。这是Ilya大神在最新采访中发表的观点。这一次,Ilya一顿输出近2万字,信息量爆炸,几乎把当下最热门的AI话题都聊了个遍:Ilya认为,目前主流的「预训练 + Scaling」路线已经明显遇到瓶颈。与其盲目上大规模,不如把注意力放回到「研究范式本身」的重构上。