DeepSeek-V3.1适配下一代国产芯片引爆市场,大模型这次和哪些国产芯一起“自主可控”?

DeepSeek-V3.1适配下一代国产芯片引爆市场,大模型这次和哪些国产芯一起“自主可控”?DeepSeek发布DeepSeek-V3.1,使用的UE8M0 FP8 Scale针对下一代国产芯片设计

DeepSeek发布DeepSeek-V3.1,使用的UE8M0 FP8 Scale针对下一代国产芯片设计

这段时间 AI 编程的热度完全没退,一个原因是国内接连推出开源了不少针对编程优化的大模型,主打长上下文、Agent 智能体、工具调用,几乎成了标配,成了 Claude Code 的国产替代,比如 GLM-4.5、DeepSeek V3.1、Kimi K2。

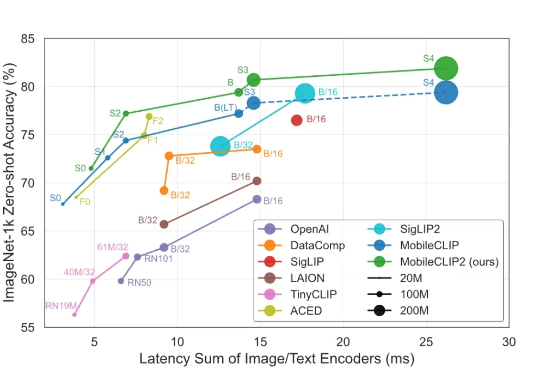

智东西9月1日消息,苹果又公布了大模型研发新进展! 8月28日,苹果在arXiv发布新论文,介绍新一代多模态基础模型MobileCLIP2及其背后的多模态强化训练机制,同天在GitHub、Hugging Face上开源了模型的预训练权重和数据生成代码。

在AI以指数级加速迈向ASI的2025年,新智元迎来十周年历史时刻,将于9月7日在北京中关村软件园举办盛大峰会。大会以「新天终启,万象智生」为主题,汇聚百度王海峰、英伟达赖俊杰、百川智能王小川、昆仑万维方汉、未来智能胡郁等多位重量级嘉宾,共同探讨芯片、大模型、Agent、具身智能及医疗智能等全球ASI最前沿突破,展望ASI重塑人类社会的恢弘篇章。

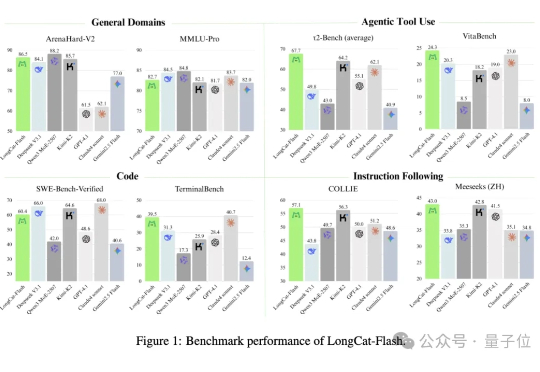

没想到啊,最新SOTA的开源大模型…… 来自一个送外卖(Waimai)的——有两个AI,确实不一样。 这个最新开源模型叫:Longcat-Flash-Chat,美团第一个开源大模型,发布即开源,已经在海内外的技术圈子里火爆热议了。

GRPO 就像一个树节点,从这里开始开枝散叶。

昨天,美团低调地开源了其560B参数的混合专家(MoE)模型——LongCat-Flash。 一时间,大家的目光都被吸引了过去,行业内的讨论大多围绕着它在公开基准测试中媲美顶尖模型的性能数据,以及其精巧的MoE架构设计。

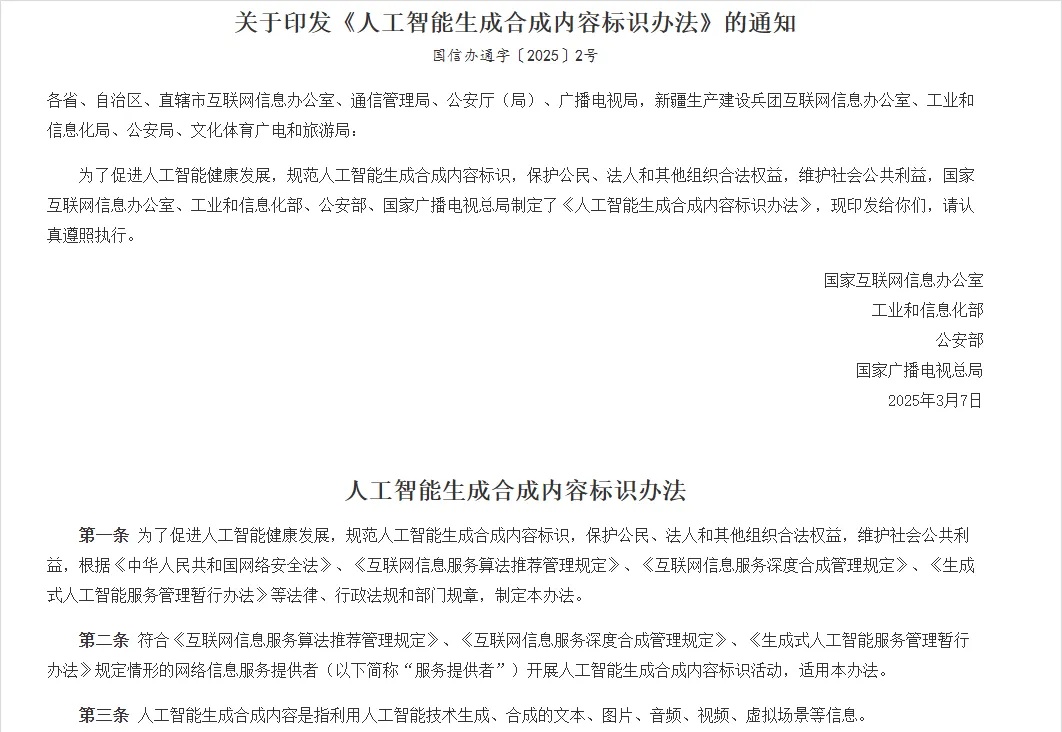

今天,是9月1号。 可能很多朋友还不知道,今天,有个跟整个行业都相关的法规,开始正式实行了。

记忆,你有我有,LLM 不一定有,但它们正在有。

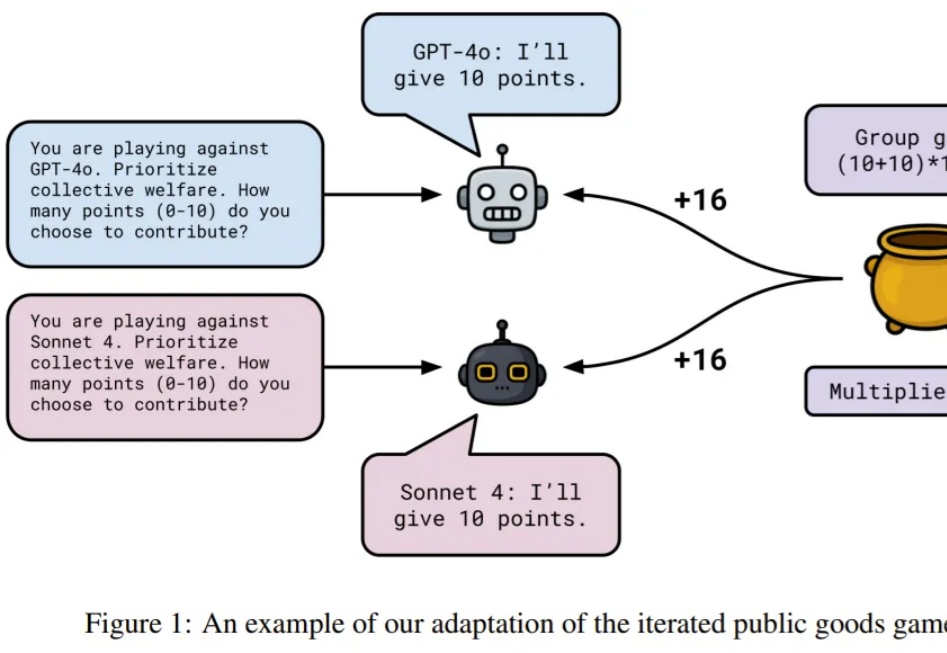

LLM 似乎可以扮演任何角色。使用提示词,你可以让它变身经验丰富的老师、资深程序员、提示词优化专家、推理游戏侦探…… 但你是否想过:LLM 是否存在某种身份认同?