谷歌版两门「小钢炮」开源!2.7亿参数干翻SOTA

谷歌版两门「小钢炮」开源!2.7亿参数干翻SOTA谷歌这波像开了「大小号双修」:前脚用Gemini把大模型战场搅翻,后脚甩出两位端侧「师兄弟」:一个走复古硬核架构回归,一个专职教AI「别光会聊,赶紧去干活」。手机里的智能体中枢,要开始卷起来了。

谷歌这波像开了「大小号双修」:前脚用Gemini把大模型战场搅翻,后脚甩出两位端侧「师兄弟」:一个走复古硬核架构回归,一个专职教AI「别光会聊,赶紧去干活」。手机里的智能体中枢,要开始卷起来了。

智东西12月19日报道,由三名00后武汉大学校友创办的大模型领域科技创企模态跃迁(MercAllure),已完成两轮累计数千万元融资,投资方包括深圳高新投、力合科创、楚天凤鸣天使基金、武汉基金、奇绩创坛等机构。

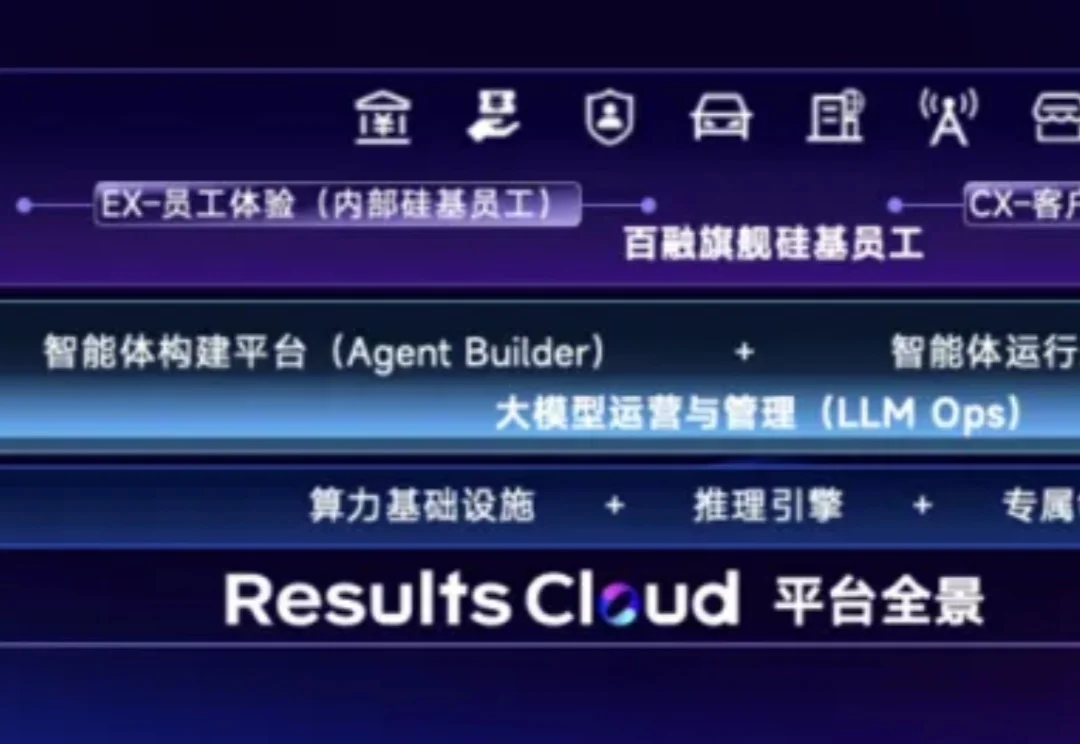

智能体元年已至,AI下半场的“生产力战争”已经打响。

年初,围绕着 2025 年将是「大模型落地应用元年」「AI Agent 元年」的共识,业界开始了大规模持续探索。

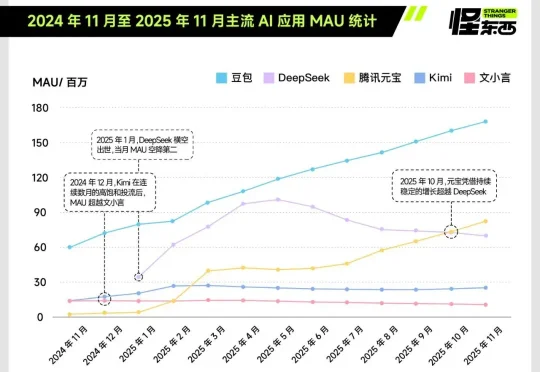

今天,在 FORCE 原动力大会上,火山引擎发布豆包大模型1.8、豆包视频生成模型 Seedance 1.5 pro。经过一年多的持续升级,豆包大模型家族在多模态理解和生成能力、Agent 能力上,已位于全球第一梯队。

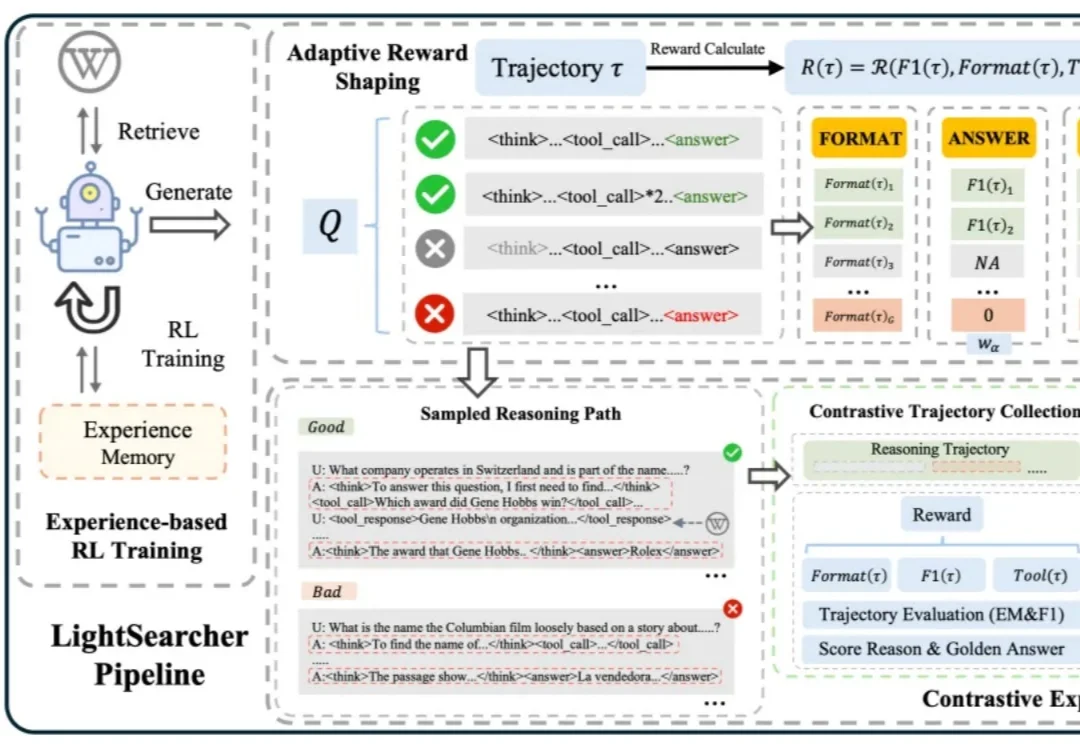

如今,以 DeepSeek-R1 为代表的深度思考大模型能够处理复杂的推理任务,而DeepSearch 作为深度思考大模型的核心搜索器,在推理过程中通过迭代调用外部搜索工具,访问参数边界之外的最新、领域特定知识,从而提升推理的深度和事实可靠性。

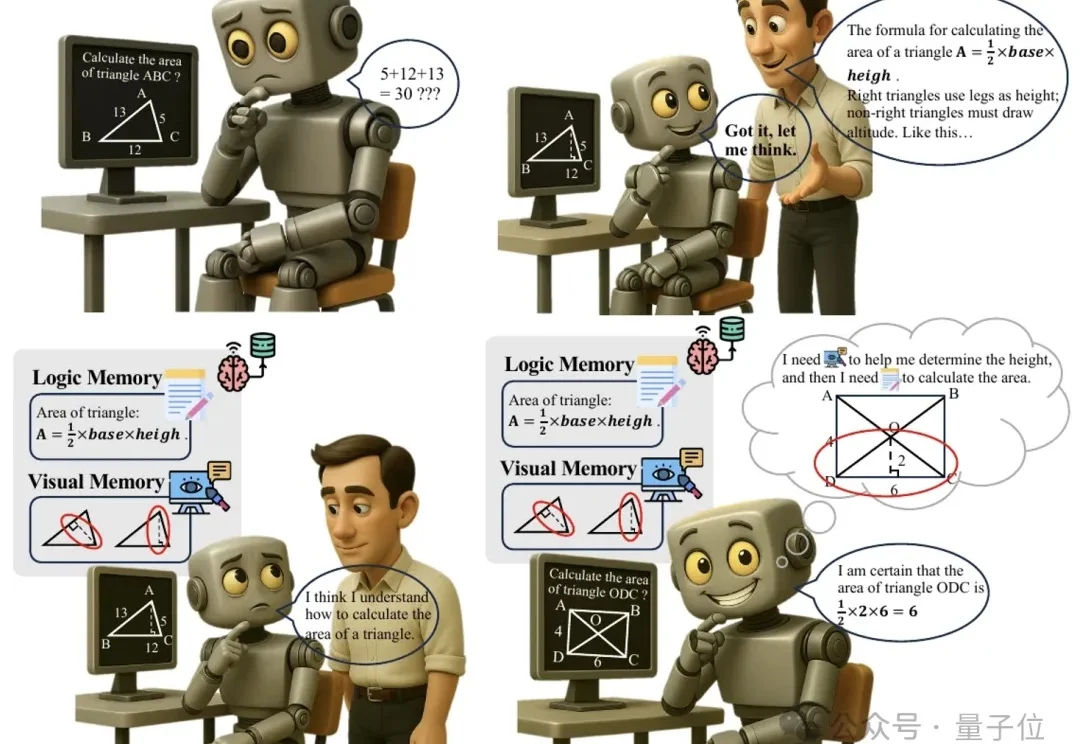

多模态推理又有新招,大模型“记不住教训”的毛病有治了。

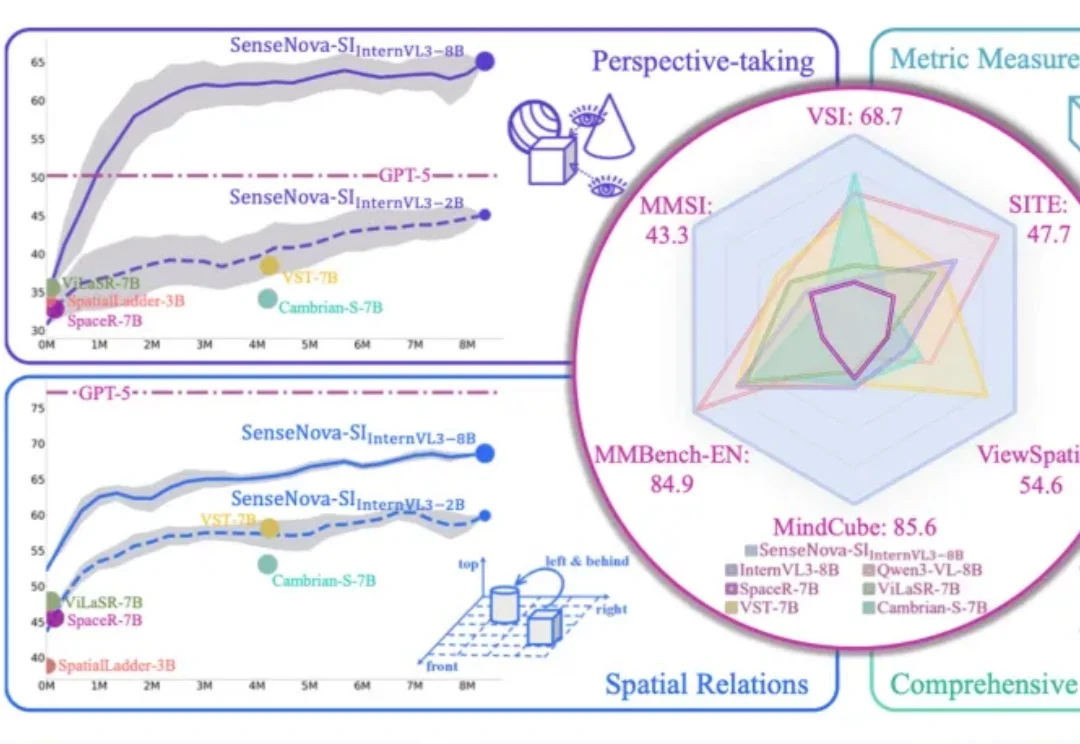

李飞飞团队最新的空间智能模型Cambrian-S,首次被一个国产开源AI超越了。

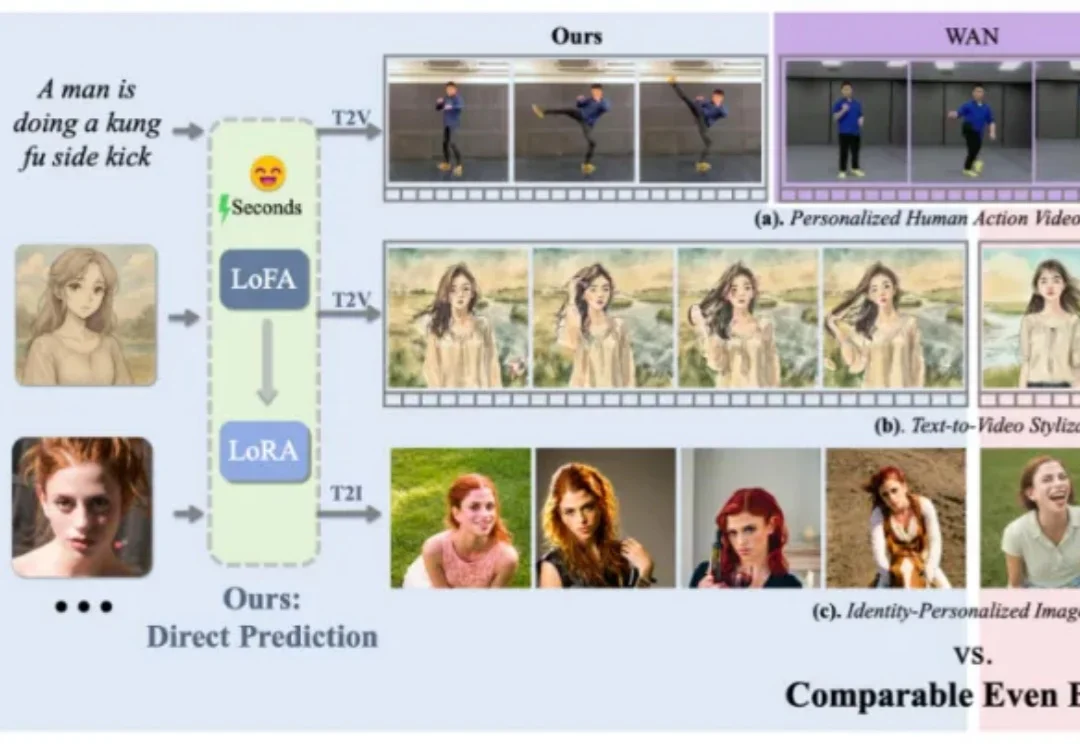

在个性化视觉生成的实际应用中,通用视觉基础模型的表现往往难以满足精准需求。为实现高度定制化的生成效果,通常需对大模型进行针对性的自适应微调,但当前以 LoRA 为代表的主流方法,仍受限于定制化数据收集与冗长的优化流程,耗时耗力,难以在真实场景中广泛应用。

独家获悉,腾讯近期完成了一次组织调整,正式新成立AI Infra部、AI Data部、数据计算平台部。 12月17日下午发布的内部公告中,腾讯表示,Vinces Yao将出任“CEO/总裁办公室”首席AI科学家,向腾讯总裁刘炽平汇报;他同时兼任AI Infra部、大语言模型部负责人,向技术工程事业群总裁卢山汇报。