字节Seed发布扩散语言模型,推理速度达2146 tokens/s,比同规模自回归快5.4倍

字节Seed发布扩散语言模型,推理速度达2146 tokens/s,比同规模自回归快5.4倍用扩散模型写代码,不仅像开了倍速,改起来还特别灵活! 字节Seed最新发布扩散语言模型Seed Diffusion Preview,这款模型主要聚焦于代码生成领域,它的特别之处在于采用了离散状态扩散技术,在推理速度上表现出色。

用扩散模型写代码,不仅像开了倍速,改起来还特别灵活! 字节Seed最新发布扩散语言模型Seed Diffusion Preview,这款模型主要聚焦于代码生成领域,它的特别之处在于采用了离散状态扩散技术,在推理速度上表现出色。

近日,一位开发者在 GitHub 上公开警告称,字节跳动旗下 AI 编程环境 Trae IDE 存在在用户未明确知情的情况下,将数据上传至字节服务器的行为,即便用户已在设置中手动关闭遥测(Telemetry)功能。

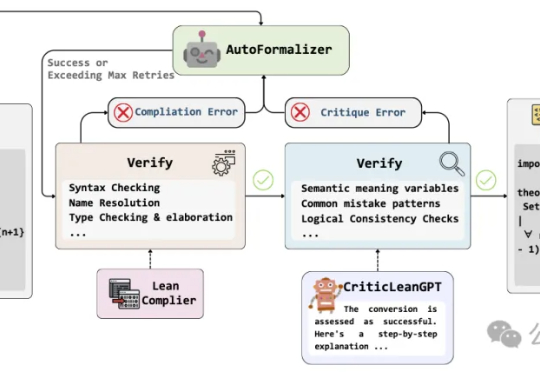

当人工智能已经能下围棋、写代码,如何让机器理解并证明数学定理,仍是横亘在科研界的重大难题。

字节跳动在 Trae IDE(Visual Studio Code 的分支)中发现的令人担忧的性能和隐私问题。主要发现包括:资源消耗过高(33 个进程 vs. VSCode 中为 9 个进程)、无论用户如何设置,遥测数据都会持续传输,以及令人担忧的社区管理实践。

7 月 26 日,字节将 AI Agent 平台「扣子(Coze)」旗下最核心的两个项目—— Coze Studio 与 Coze Loop 正式开源至 GitHub,并采用开放程度更高、可自由用于任何商业用途的 Apache 2.0 许可证,无任何附加条款。开源仅两天,项目已在 GitHub 上收获超过 6K star。

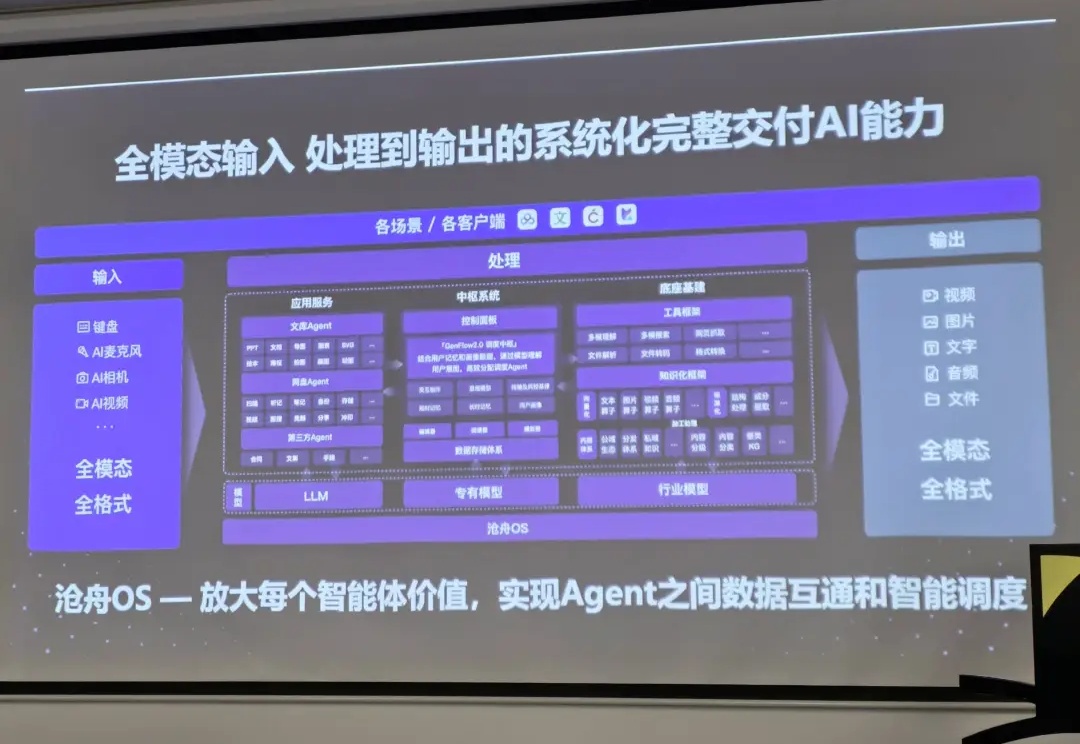

从 OpenAI、字节跳动,到一众创业团队,今年几乎所有 AI 公司都在推进自己的 Agent 战略:有人做工具执行器,有人做工作流代理,有人主打插件调度,有人想做全能副驾……

AI语音成大厂必争之地 打开字节、阿里们的多模态能力地图,每块宝藏都标着"语音”。

据 AI 科技评论报道,前阿里通义实验室视觉负责人薄列峰已正式加盟腾讯混元大模型团队,直接向腾讯副总裁、混元项目负责人蒋杰汇报,主要负责多模态方向的技术攻坚。早在今年4月30日,薄列峰从阿里离职,外界曾一度传出他将赴美加入某大型科技公司,统筹多模态AI研发。如今尘埃落定,他最终选择落脚深圳,加入国内多模态竞争最激烈的战场之一。

一觉醒来发现扣子直接开源了!以后本地部署一个扣子不再是梦!而且采用的是 Apache 2.0 许可证,支持商用!这次开源的是扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)。

兄弟们,是不是也感觉最近被Cursor“背刺”了?这位曾经的AI编程王者,开启 AI 编程大航海时代的白月光,现在是又卡又慢,关键的Claude模型还不给中国区用、改变计费方式,用户的体验简直一言难尽。