延迟下降20×,token减少4.4×!突破多智能体「共识」瓶颈

延迟下降20×,token减少4.4×!突破多智能体「共识」瓶颈过去一年,LLM Agent几乎成为所有 AI 研究团队与工业界的共同方向。OpenAI在持续推进更强的推理与工具使用能力,Google DeepMind将推理显式建模为搜索问题,Anthropic则通过规范与自我批判提升模型可靠性。

过去一年,LLM Agent几乎成为所有 AI 研究团队与工业界的共同方向。OpenAI在持续推进更强的推理与工具使用能力,Google DeepMind将推理显式建模为搜索问题,Anthropic则通过规范与自我批判提升模型可靠性。

最近,一部热血的国风影视大片《霍去病》在影视创作者与海外社区火了。如果不说是AI创作,你一定会觉得完成这样的大制作,是燃烧巨量电影经费的结果。

全球第一届OpenClaw蟹教聚会来了,开发者们众神云集,分享出一大波炸裂的开源项目。更可怕的是,OpenClaw开始控制机器人了,现场的啤酒据说都是机器人续的。「蟹徒」们纷纷高呼:感谢Peter,你让我们重生!

陈丹琦首次转身工业界,第一站就选择Mira初创的理由找到了—— 有个赛友也在这儿,还足足“潜伏”了一年之久。

大模型的革命行将结束,即将开启的会是物理 AI 时代?

2026年2月4日,立春,晚上 7 点,央视频上线了一档叫「中关村对话:AI 迎春夜」的节目。三个小时,四个篇章,六位院士,几十位嘉宾

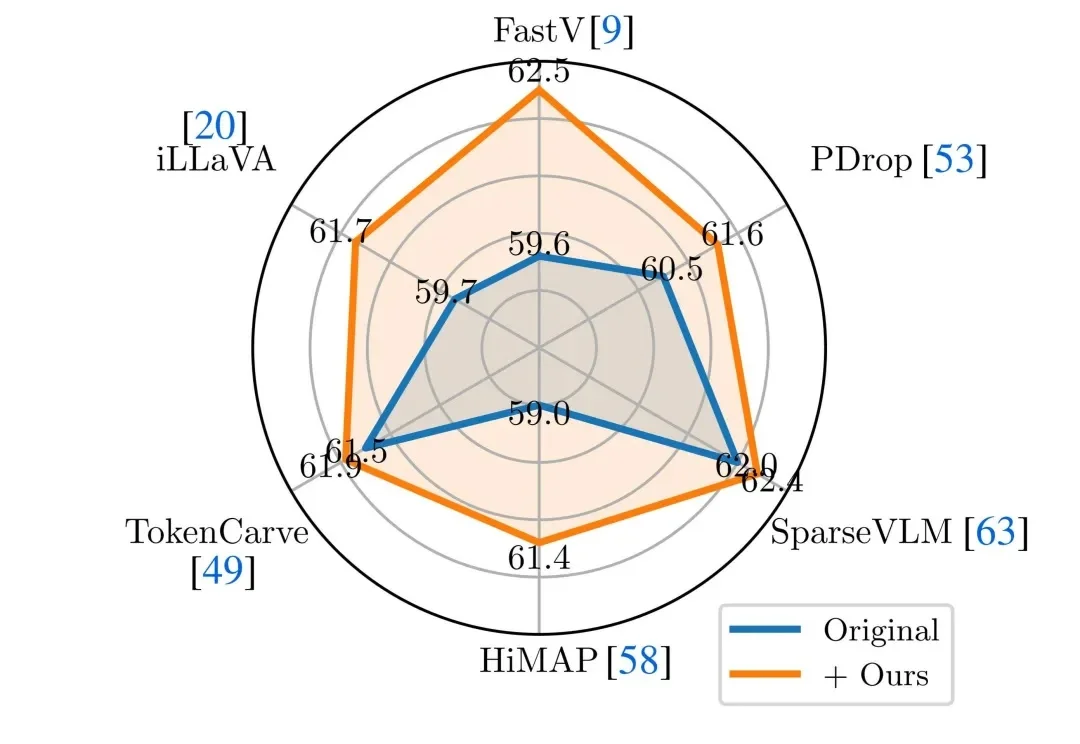

近年来,Vision-Language Models(视觉 — 语言模型)在多模态理解任务中取得了显著进展,并逐渐成为通用人工智能的重要技术路线。然而,这类模型在实际应用中往往面临推理开销大、效率受限的问题,研究者通常依赖 visual token pruning 等策略降低计算成本,其中 attention 机制被广泛视为衡量视觉信息重要性的关键依据。

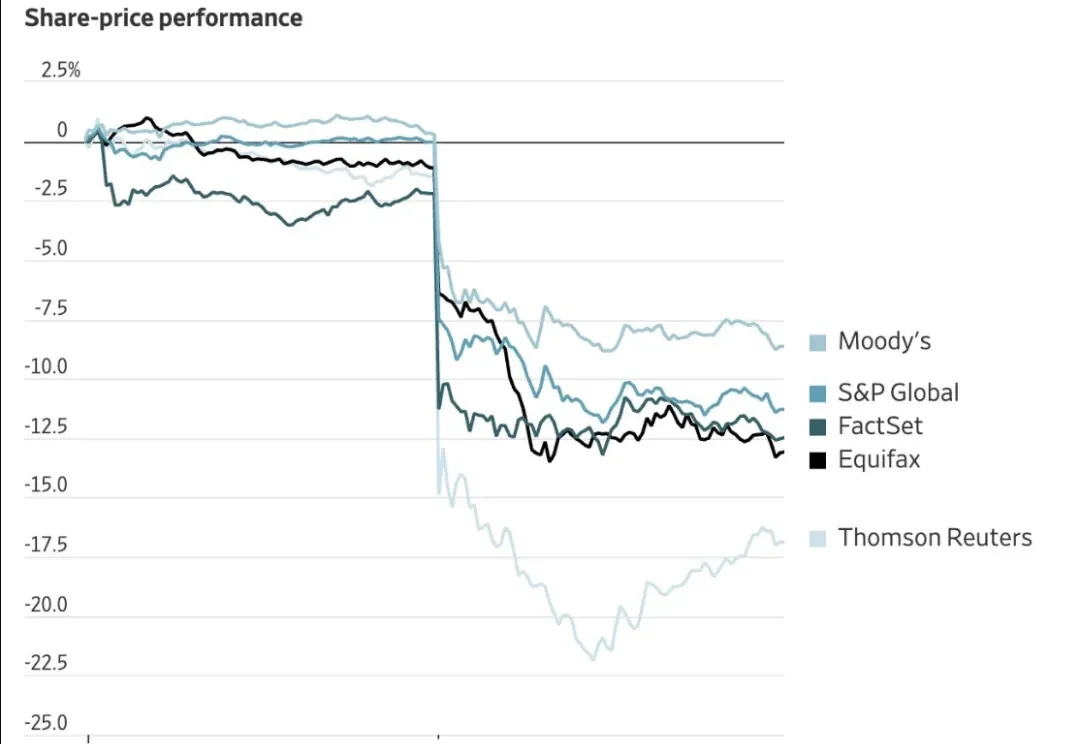

SaaS的末日来了。

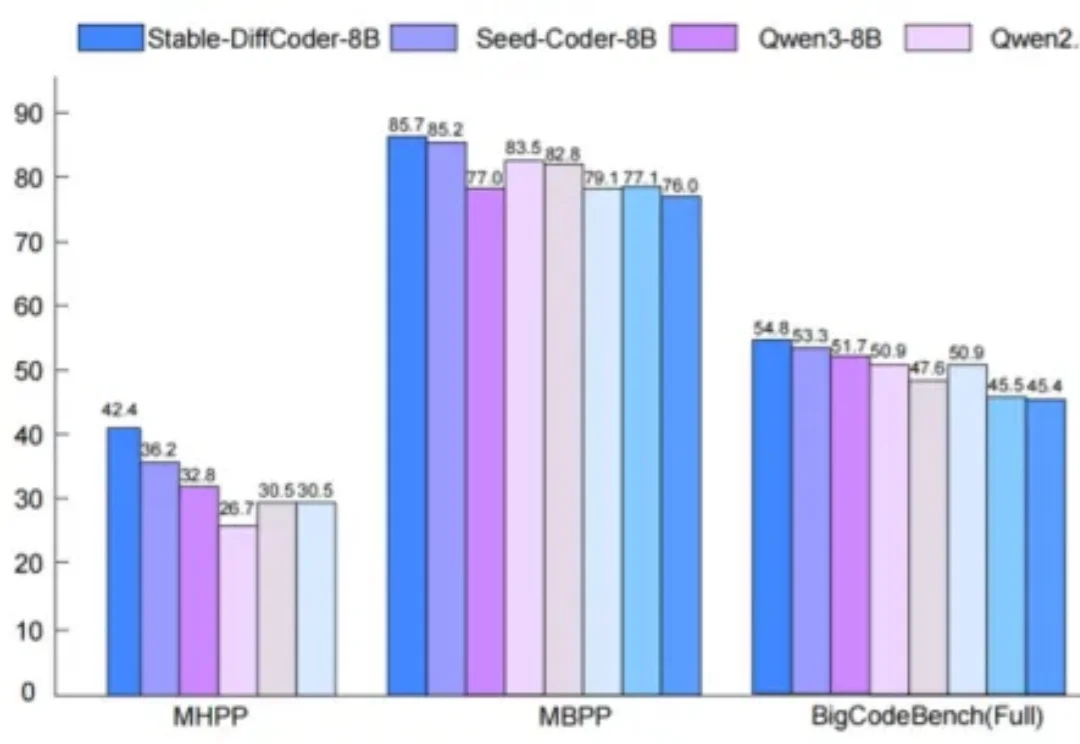

扩散语言模型(Diffusion Language Models, DLLMs)因其多种潜在的特性而备受关注,如能加速的非自回归并行生成特性,能直接起草编辑的特性,能数据增强的特性。然而,其模型能力往往落后于同等规模的强力自回归(AR)模型。

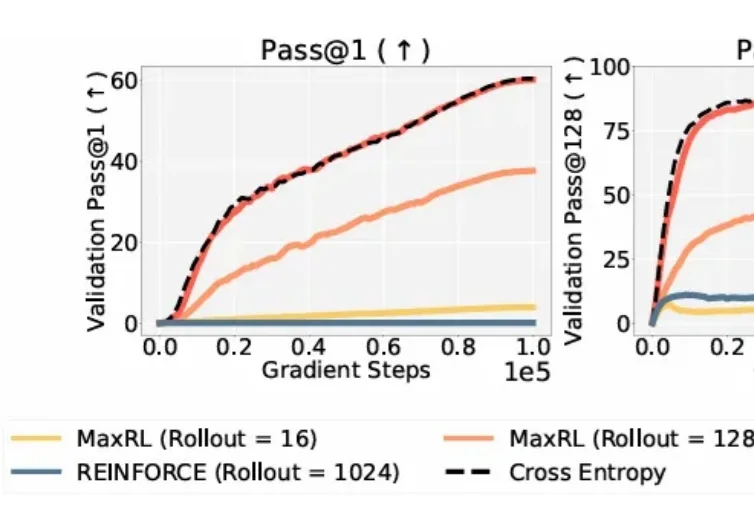

在大模型时代,从代码生成到数学推理,再到自主规划的 Agent 系统,强化学习几乎成了「最后一公里」的标准配置。