大模型“拼好题”,45K数据撬动18%提升,数学问题拒绝死记硬背 | MathFusion

大模型“拼好题”,45K数据撬动18%提升,数学问题拒绝死记硬背 | MathFusion当前数学领域的数据生成方法常常局限于对单个问题进行改写或变换,好比是让学生反复做同一道题的变种,却忽略了数学题目之间内在的关联性。

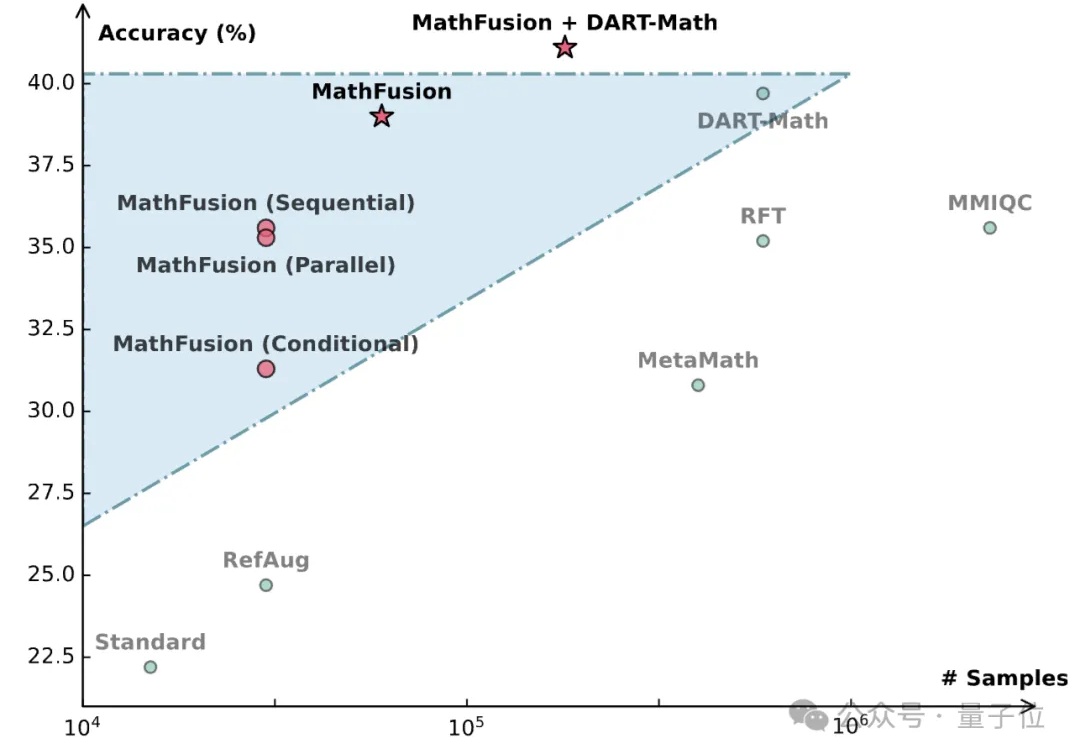

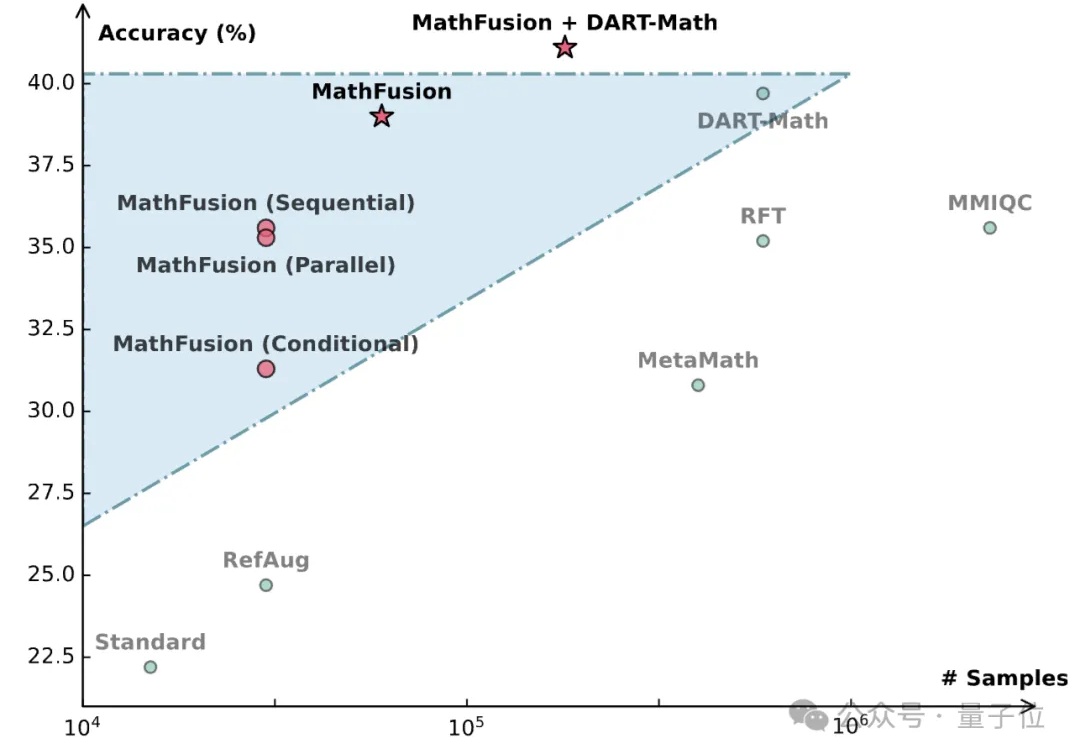

当前数学领域的数据生成方法常常局限于对单个问题进行改写或变换,好比是让学生反复做同一道题的变种,却忽略了数学题目之间内在的关联性。

今年 5 月,一家名为 FutureHouse 的非营利组织宣布推出一款名为 Robin 的新型人工智能(AI)工具,声称其能够极大加速生物学等领域的科学研究进程,该系统不仅能够自主完成从假设提出、实验设计到数据分析等关键科研环节,更在实际应用中,仅历时约 2.5 个月便成功为干性年龄相关性黄斑变性这一复杂眼疾发现了一种新的潜在治疗药物。

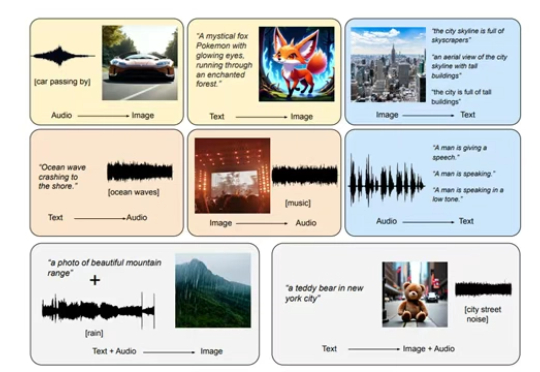

随着大模型的不断发展,多模态数据处理成为了新的热点领域。多模态生成任务主要通过整合多种类型的数据,如文本、图像、音频等,实现不同模态之间的相互转换与生成。

AI 角色扮演、AI 情感陪伴……更多 AI 交互方式的出现正在重新定义“社交”。

“蔚公子,DeepSeek核对两个Excel表格怎么做啊?”小伙伴上周问我。

AI迈入经验时代,2025 年 6 月 6 日,第七届北京智源大会在北京正式开幕,强化学习奠基人、2025年图灵奖得主、加拿大计算机科学家Richard S. Sutton以“欢迎来到经验时代”为题发表主旨演讲

当学术研究沦为「填空游戏」,利用美国NHANES公共数据集,结合AI工具如ChatGPT,研究者通过套用模板、排列变量,批量生产看似精美却质量堪忧的论文。背后不仅是技术的滥用,更是科研评价体系扭曲的缩影。

最近研究 n8n , 发现各种输入、输出都用到 JSON 格式。对 AI 开发来说, 为了生成可控,也会用这种格式。

AI两天爆肝12年研究,精准吊打人类!多大、哈佛MIT等17家机构联手放大招,基于GPT-4.1和o3-mini,筛选文献提取数据,效率飙3000倍重塑AI科研工作流。

生成式AI提升内容效率并重塑营销洞察,但品牌本质(用户价值)不变。企业需聚焦垂直数据沉淀、AI原生工作流改造(非仅工具应用),并应对一把手认知不足及组织转型挑战