速递|B轮融资4400万美元,以色列创企Speedata获英特尔CEO站台,APU芯片让数据分析告别“服务器农场”

速递|B轮融资4400万美元,以色列创企Speedata获英特尔CEO站台,APU芯片让数据分析告别“服务器农场”总部位于特拉维夫的初创公司 Speedata 开发了一款专为加速大数据分析和 AI 工作负载而设计的分析处理单元(APU),该公司已完成 4400 万美元的 B 轮融资, 使其融资总额达到 1.14 亿美元 。

总部位于特拉维夫的初创公司 Speedata 开发了一款专为加速大数据分析和 AI 工作负载而设计的分析处理单元(APU),该公司已完成 4400 万美元的 B 轮融资, 使其融资总额达到 1.14 亿美元 。

AI公司专利往往缺乏体内实验数据。

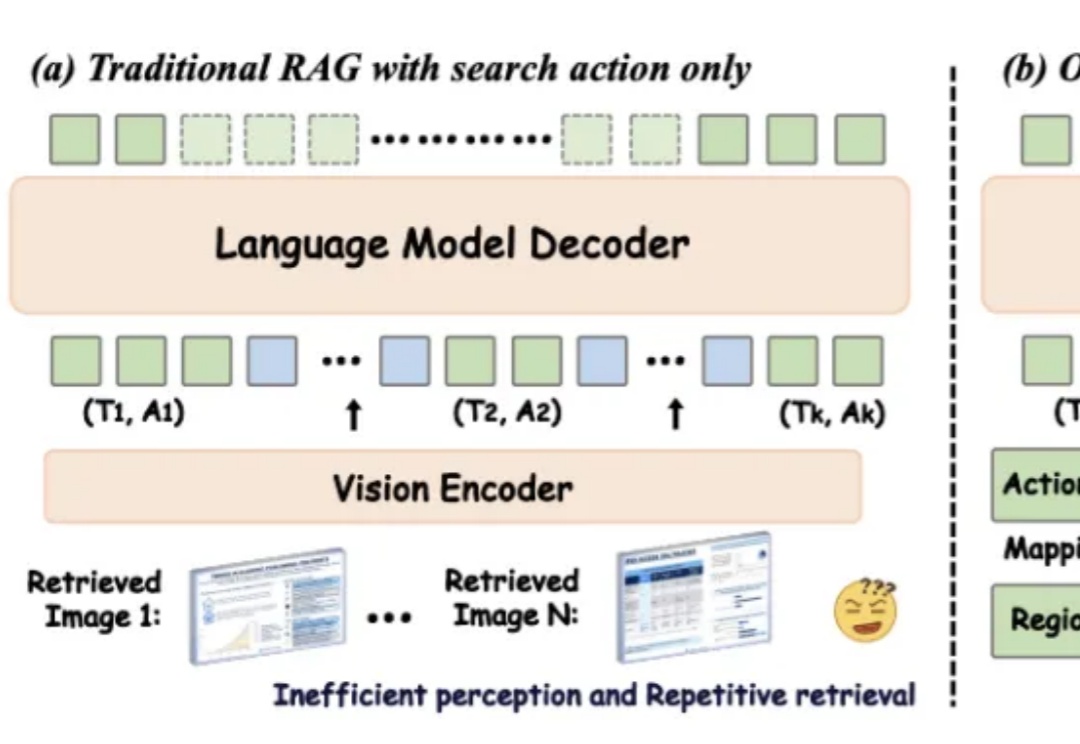

在数字化时代,视觉信息在知识传递和决策支持中的重要性日益凸显。然而,传统的检索增强型生成(RAG)方法在处理视觉丰富信息时面临着诸多挑战。一方面,传统的基于文本的方法无法处理视觉相关数据;另一方面,现有的视觉 RAG 方法受限于定义的固定流程,难以有效激活模型的推理能力。

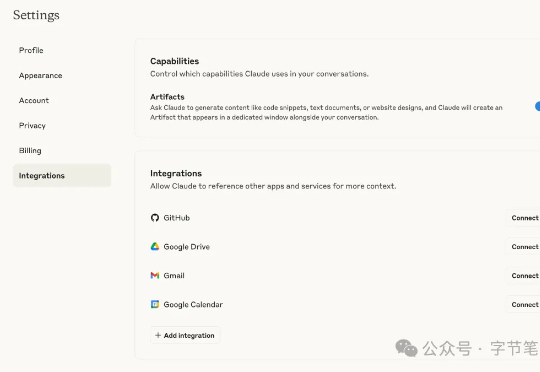

Claude发布MCP网页版本集成和Research,正式开启开挂模式。全面基于远程 MCP 的集成现已面向所有付费 Claude.ai 方案开放(包括 Pro 版用户),提供将 Claude 连接到各种工具和数据源的能力。

发展教育大模型需要新的数据和评估体系!北京理工大学高扬老师团队推出EduBench,是首个专为教育场景打造的综合评估基准,涵盖9大教育场景、12个多视角评估维度、超4000个教育情境。通过多维度评估指标体系和人工标注一致性计算,确保评估可靠性,助力教育大模型发展,推动教育智能化。

IBM 于 6 月 2 日宣布已收购 Seek AI,这是一个允许用户使用自然语言查询企业数据的 AI 平台,具体收购金额未披露。

大语言模型(LLMs)作为由复杂算法和海量数据驱动的产物,会不会“无意中”学会了某些类似人类进化出来的行为模式?这听起来或许有些大胆,但背后的推理其实并不难理解:

新加坡国立大学等机构的研究者们通过元能力对齐的训练框架,模仿人类推理的心理学原理,将演绎、归纳与溯因能力融入模型训练。实验结果显示,这一方法不仅提升了模型在数学与编程任务上的性能,还展现出跨领域的可扩展性。

在多智能体AI系统中,一旦任务失败,开发者常陷入「谁错了、错在哪」的谜团。PSU、杜克大学与谷歌DeepMind等机构首次提出「自动化失败归因」,发布Who&When数据集,探索三种归因方法,揭示该问题的复杂性与挑战性。

生成式AGI已经颠覆了人们的生活,但AI工具并没有随着用户使用场景的融合而整合。各个赛道的头部玩家依靠独家的数据库发展模型,现有算力和数据量难以支撑多模态和跨业务领域拓展,急需形成用户粘性的市场竞争也使得AI的生成稳定性被优先考虑。