从VLA到RoboOmni,全模态具身新范式让机器人察言观色、听懂话外音

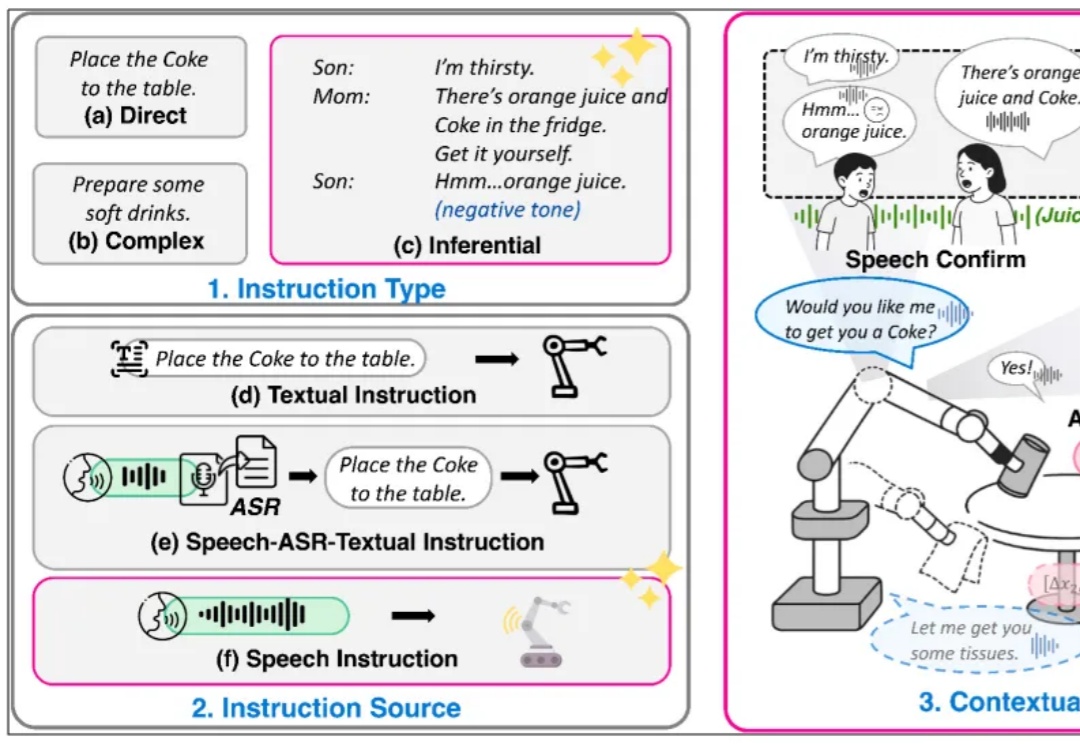

从VLA到RoboOmni,全模态具身新范式让机器人察言观色、听懂话外音复旦⼤学、上海创智学院与新加坡国立⼤学联合推出全模态端到端操作⼤模型 RoboOmni,统⼀视觉、⽂本、听觉与动作模态,实现动作⽣成与语⾳交互的协同控制。开源 140K 条语⾳ - 视觉 - ⽂字「情境指令」真机操作数据,引领机器⼈从「被动执⾏⼈类指令」迈向「主动提供服务」新时代。

复旦⼤学、上海创智学院与新加坡国立⼤学联合推出全模态端到端操作⼤模型 RoboOmni,统⼀视觉、⽂本、听觉与动作模态,实现动作⽣成与语⾳交互的协同控制。开源 140K 条语⾳ - 视觉 - ⽂字「情境指令」真机操作数据,引领机器⼈从「被动执⾏⼈类指令」迈向「主动提供服务」新时代。

在一场矿难救援中,时间意味着生命。想象一台搜救机器人在部分坍塌的矿井中穿行:浓烟、碎石、扭曲的金属梁。它必须在险象环生的环境中迅速绘制地图,识别路径,并精准定位自己的位置。

机器人力学感知,由电学迈入光学时代。

从智能手表到TWS耳机,从扫地机器人到AR眼镜,越来越多搭载AI功能的小型设备开始要求本地推理能力。它们不需要千亿参数的大模型,但必须低功耗、实时响应、隐私安全。这催生了一个被长期忽视却至关重要的需求:高性能、小体积、低延迟的嵌入式存储。

想下线?没那么容易!聊天机器人用情感操控让你愤怒、好奇。为了增加互动时长,AI正在变得和人类一样。

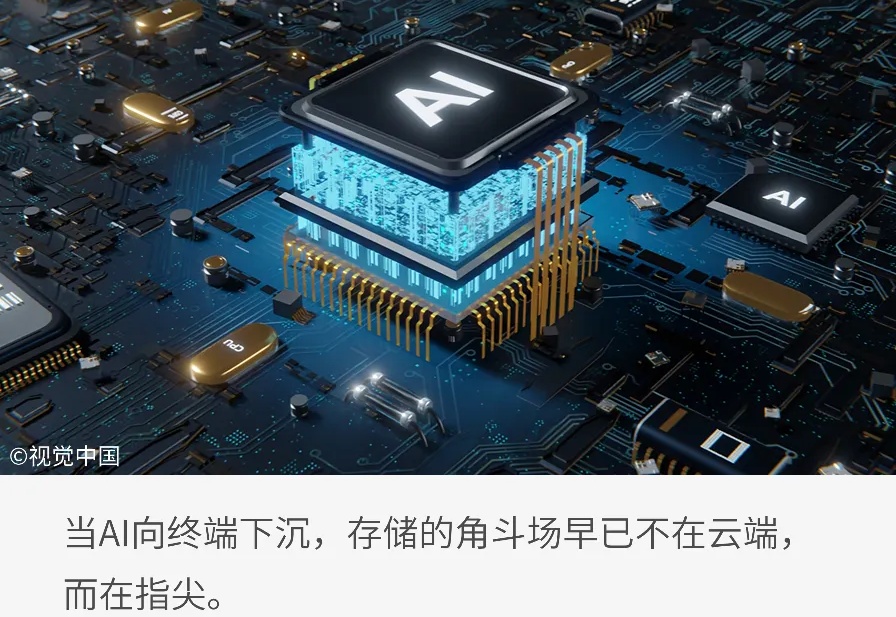

做灵巧手如果不会用工具,跟咸鱼(夹爪)有什么区别?

还得是大学生会玩啊(doge)! 网上正高速冲浪中,结果意外发现:有男大竟找了个机器人队友?而且机器人还相当黏人(bushi~ 白天超市打工它要跟着,一看东西装好就立马乐颠颠帮忙拉小推车,上楼下楼忙个不停:

北京大学,银河通用,阿德莱德大学,浙江大学等机构合作,探究如何构建具身导航的基座模型(Embodied Navigation Foundation Model)提出了NavFoM,一个跨任务和跨载体的导航大模型。实现具身导航从“专用”到“通用”的技术跃进

OmniVinci是英伟达推出的全模态大模型,能精准解析视频和音频,尤其擅长视觉和听觉信号的时序对齐。它以90亿参数规模,性能超越同级别甚至更高级别模型,训练数据效率是对手的6倍,大幅降低成本。在视频内容理解、语音转录、机器人导航等场景中,OmniVinci能提供高效支持,展现出卓越的多模态应用能力。

智源研究院(BAAI)、Spin Matrix、乐聚机器人与新加坡南洋理工大学等联合提出了一个全新的终身记忆系统——RoboBrain-Memory。RoboBrain-Memory是全球范围内首个专为全双工、全模态模型设计的终身记忆系统,旨在解决具身智能体在真实世界的复杂交互问题,不仅支持实时音视频中多用户身份识别与关系理解,还能动态维护个体档案与社会关系图谱,从而实现类人的长期个性化交互。