想让LLM精确输出?试下XML格式Prompt语法约束解码GCD,帮你迭代收敛到稳定解

想让LLM精确输出?试下XML格式Prompt语法约束解码GCD,帮你迭代收敛到稳定解随着Agent的爆发,大型语言模型(LLM)的应用不再局限于生成日常对话,而是越来越多地被要求输出像JSON或XML这样的结构化数据。这种结构化输出对于确保安全性、与其他软件系统互操作以及执行下游自动化任务至关重要。

随着Agent的爆发,大型语言模型(LLM)的应用不再局限于生成日常对话,而是越来越多地被要求输出像JSON或XML这样的结构化数据。这种结构化输出对于确保安全性、与其他软件系统互操作以及执行下游自动化任务至关重要。

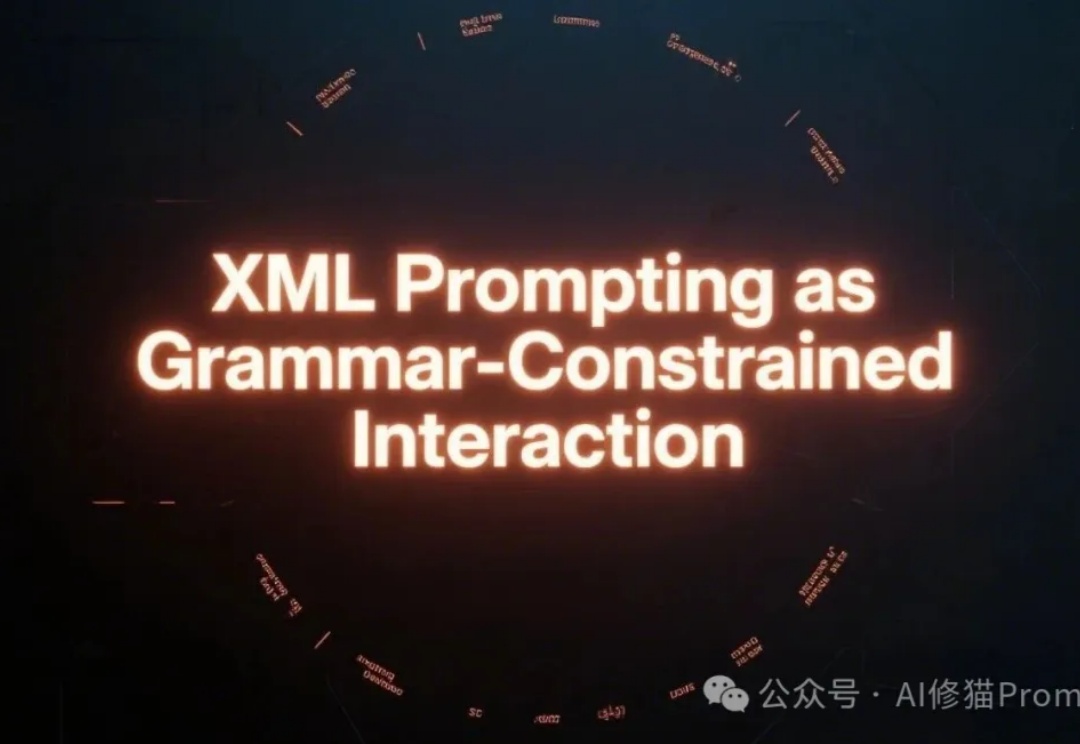

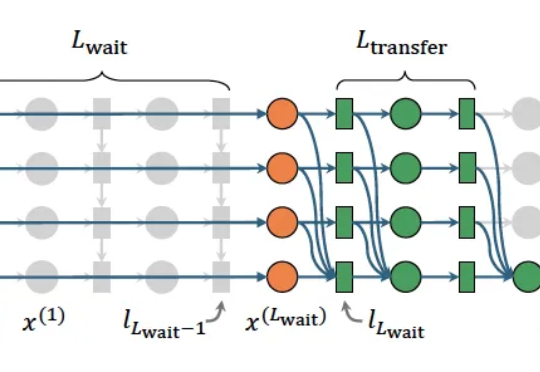

OpenAI o3的多轮视觉推理,有开源平替版了。并且,与先前局限于1-2轮对话的视觉语言模型(VLM)不同,它在训练限制轮数只有6轮的情况下,测试阶段能将思考轮数扩展到数十轮。

自动化修复真实世界的软件缺陷问题是自动化程序修复研究社区的长期目标。然而,如何自动化解决视觉软件缺陷仍然是一个尚未充分探索的领域。最近,随着 SWE-bench 团队发布最新的多模态 Issue 修复

最近,来自加州大学圣克鲁兹分校、乔治·梅森大学和Datadog的研究人员发现:在心算任务中,几乎所有实际的数学计算都集中在序列的最后一个token上完成,而不是分散在所有token中。

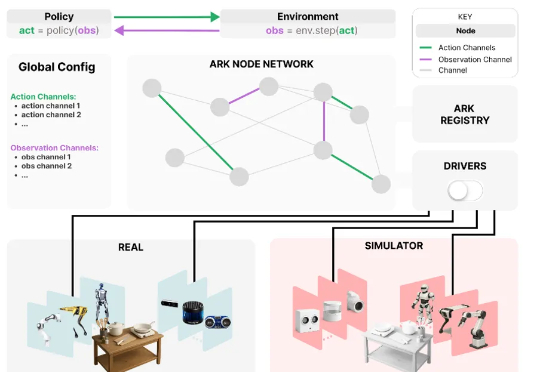

为应对这些挑战,来自华为诺亚方舟实验室,德国达姆施塔特工业大学,英国伦敦大学学院,帝国理工学院和牛津大学的研究者们联合推出了 Ark —— 一个基于 Python 的机器人开发框架,支持快速原型构建,并可便捷地在仿真和真实机器人系统上部署新算法。

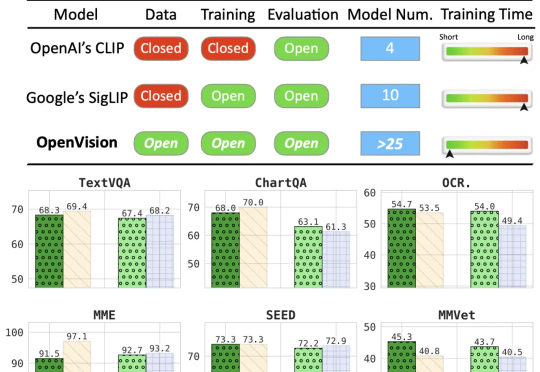

本文来自加州大学圣克鲁兹分校(UCSC)、苹果公司(Apple)与加州大学伯克利分校(UCB)的合作研究。第一作者刘彦青,本科毕业于浙江大学,现为UCSC博士生,研究方向包括多模态理解、视觉-语言预训

OpenAI Codex编程智能体大升级: 推出GPT-5-Codex特化版模型,支持独立连续编程7个小时。还有IDE插件版,在VS Code、Cursor中都可以使用Codex了。新模型最牛的地方在于“真·动态思考”能力。

最强不敢说,但最快实锤了! 刚刚,xAI发布Grok 4 Fast,生成速度高达每秒75个 token,比标准版快10倍! 从下面的动图中,我们可以直观地看出差距——当左边的Grok 4还在说“让我想一下的时候”,Grok 4 Fast已经在说:“下一个问题是什么了。”

GPT-5 的发布,可以看作是一个分水岭。练习时长两年半的 GPT-5,并没有展现出和 GPT-4 本质上的差别,甚至因为模型的预设人格引发了用户的反感情绪。

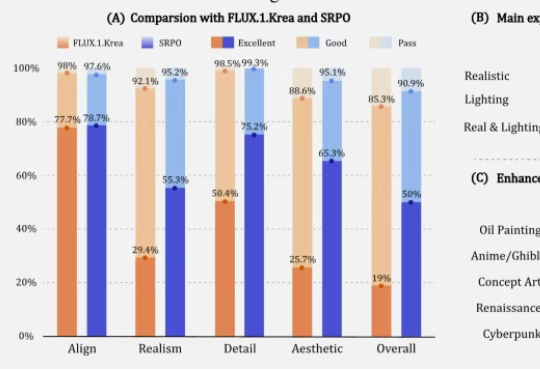

让AI生成的图像更符合人类精细偏好,在32块H20上训练10分钟就能收敛。腾讯混元新方法让微调的FLUX1.dev模型人工评估的真实感和美学评分提高3倍以上。