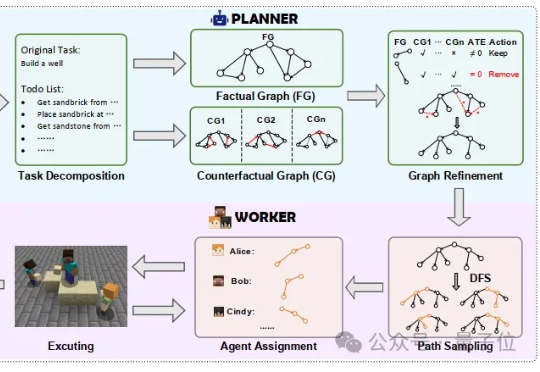

用“因果规划”解决多智能体协作中的任务依赖难题|港科广&腾讯

用“因果规划”解决多智能体协作中的任务依赖难题|港科广&腾讯在长周期、多步骤的协作任务中,传统单智能体往往面临着任务成功率随步骤长度快速衰减,错误级联导致容错率极低等问题。

在长周期、多步骤的协作任务中,传统单智能体往往面临着任务成功率随步骤长度快速衰减,错误级联导致容错率极低等问题。

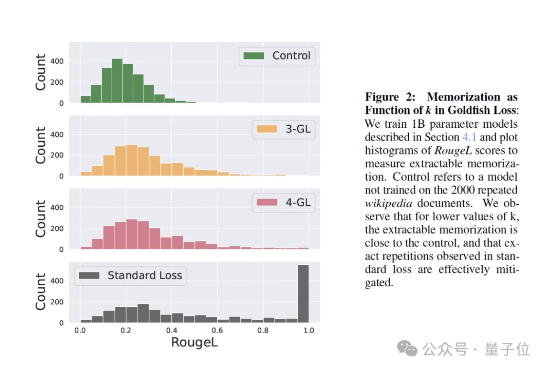

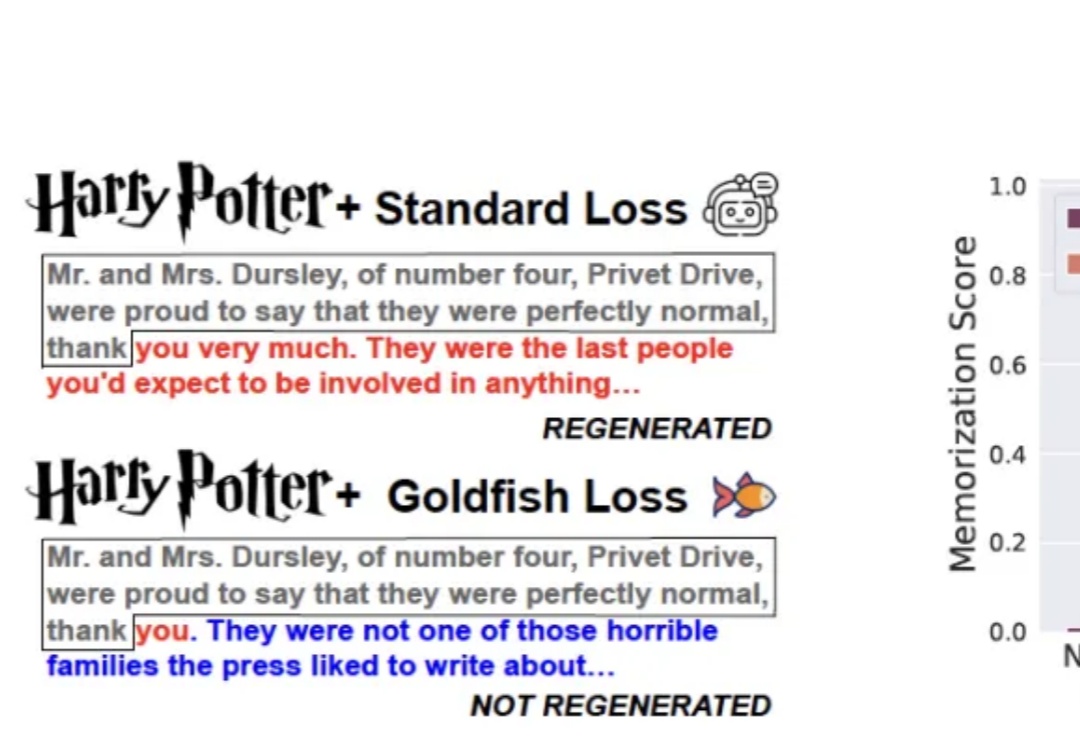

训练大模型时,有时让它“记性差一点”,反而更聪明! 大语言模型如果不加约束,很容易把训练数据原封不动地复刻出来。为解决这个问题,来自马里兰大学、图宾根大学和马普所的研究团队提出了一个新方法——金鱼损失(Goldfish Loss)。

起猛了,美团这下真的开始明牌干AI了。

训练大模型时,有时让它“记性差一点”,反而更聪明!

腾讯混元,刚刚又拿下一个国际冠军—— Hunyuan-MT-7B,以7B总参数量获得国际翻译比赛冠军。该模型支持33个语种、5种民汉语言/方言互译,是一个能力全面的轻量级翻译模型。

天啦噜,搞大模型的实在太疯狂了。

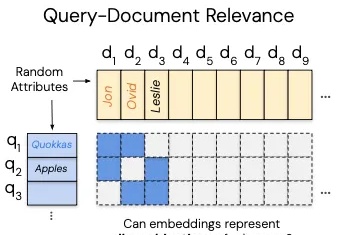

这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

在这场以大型语言模型(LLM)为核心的 AI 浪潮中,苹果似乎一直保持着低调,很少出现在技术报道的前沿。尽管如此,时不时地,该公司也能拿出一些非常亮眼的研究成果,比如能在 iPhone 上直接运行的高效视觉语言模型 FastVLM。

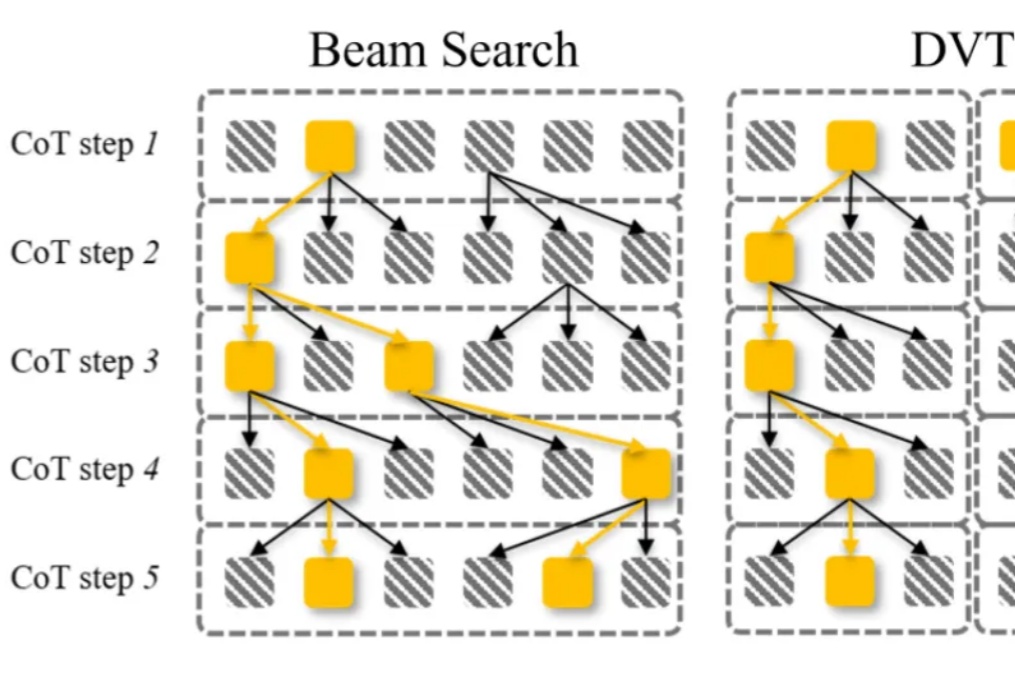

大语言模型通过 CoT 已具备强大的数学推理能力,而 Beam Search、DVTS 等测试时扩展(Test-Time Scaling, TTS)方法可通过分配额外计算资源进一步提升准确性。然而,现有方法存在两大关键缺陷:路径同质化(推理路径趋同)和中间结果利用不足(大量高质量推理分支被丢弃)。

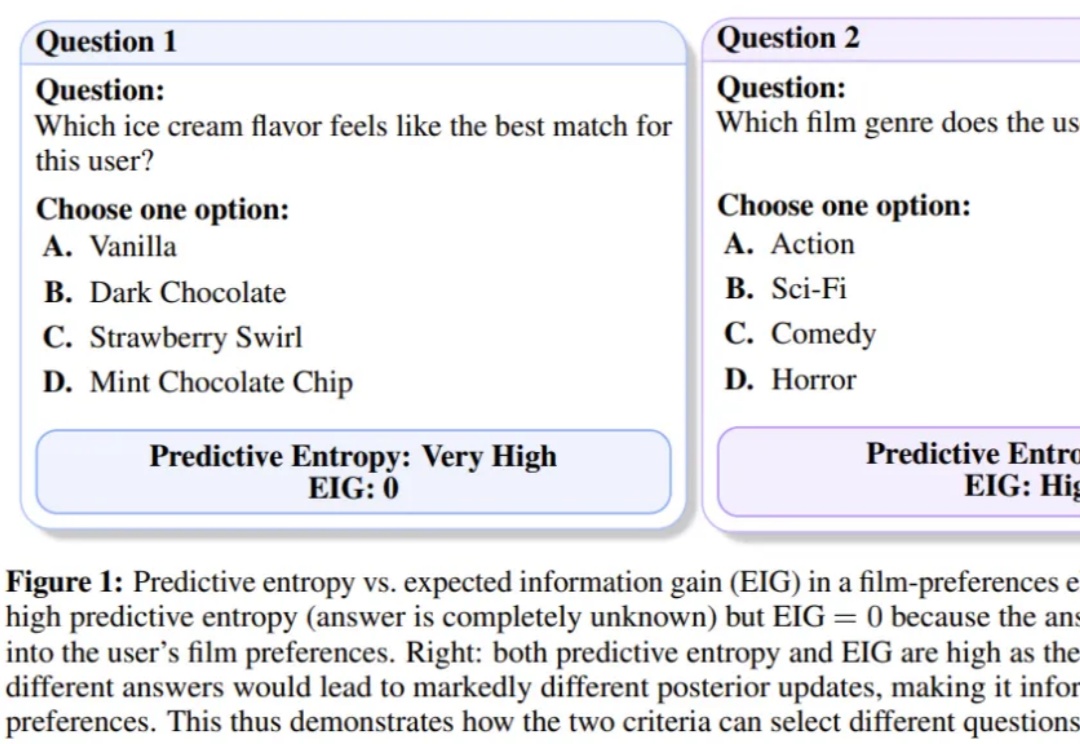

最近,工业界“RAG已死”甚嚣尘上。过去几年,AI领域的主旋律是“规模定律”(Scaling Law),即更大的模型、更多的数据会带来更好的性能。即便偶然有瑕疵,也认为只是工程上的不足,并非数学上的不可能。