让整个X玩疯了的Veo3,到底怎么样?【附测试提示词】

让整个X玩疯了的Veo3,到底怎么样?【附测试提示词】大家好,我是袋鼠帝 还记得前两天Google IO大会上他们发布的最新视频模型Veo3吗 它可以根据提示自动添加环境音效、背景噪声、音乐和对话,并与画面完美同步 而且生成的视频相当炸裂,已经让我有点分不清虚幻与现实了 比如这位推特大神(Hashem Al-Ghaili)用Veo3制作的视频,相当🐂🍺

大家好,我是袋鼠帝 还记得前两天Google IO大会上他们发布的最新视频模型Veo3吗 它可以根据提示自动添加环境音效、背景噪声、音乐和对话,并与画面完美同步 而且生成的视频相当炸裂,已经让我有点分不清虚幻与现实了 比如这位推特大神(Hashem Al-Ghaili)用Veo3制作的视频,相当🐂🍺

AI是否真正在「思考」乃至产生意识,正成为科学和哲学交汇的核心议题。前OpenAI负责人翁荔认为,增加模型的「思考时间」有助突破复杂推理瓶颈;哈佛等机构则指出思维链可能导致「降智」;而生物学家Mallavarapu断言数字计算机永不可能拥有意识。

百度一季度业绩于2025年5月21日港股盘后放出,整体来看小超预期,简单来说,DeepSeek帮了大忙!

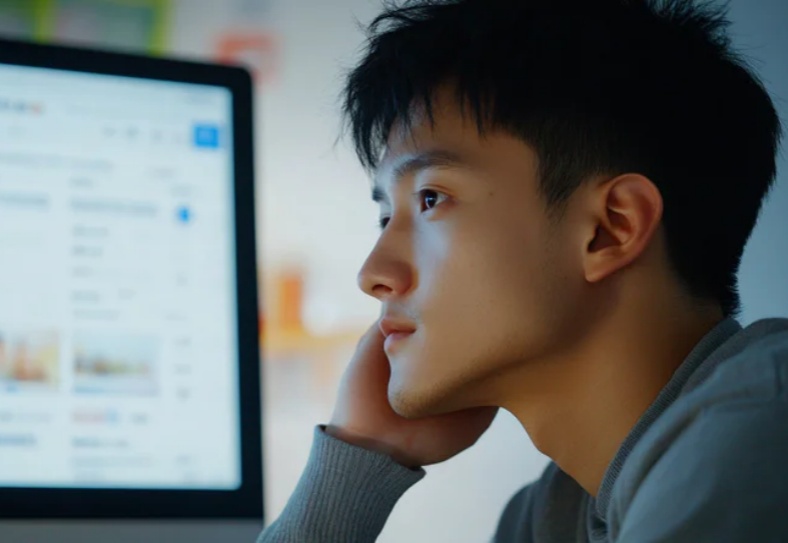

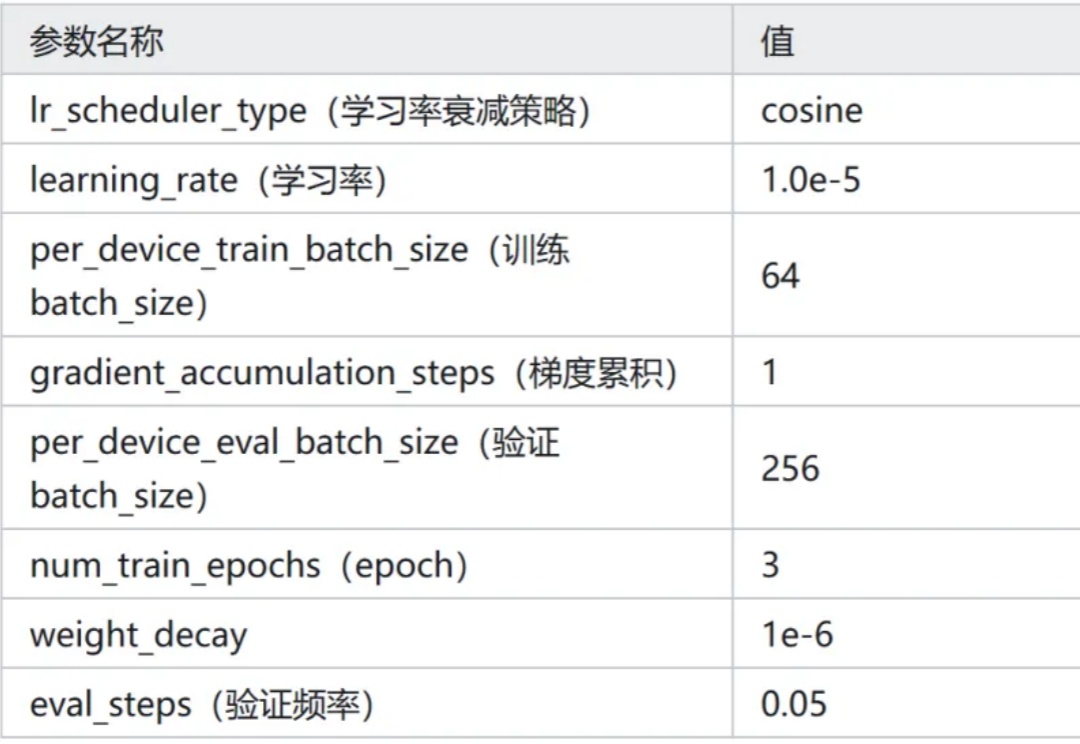

新增 Qwen3-0.6B 在 Ag_news 数据集 Zero-Shot 的效果。新增 Qwen3-0.6B 线性层分类方法的效果。

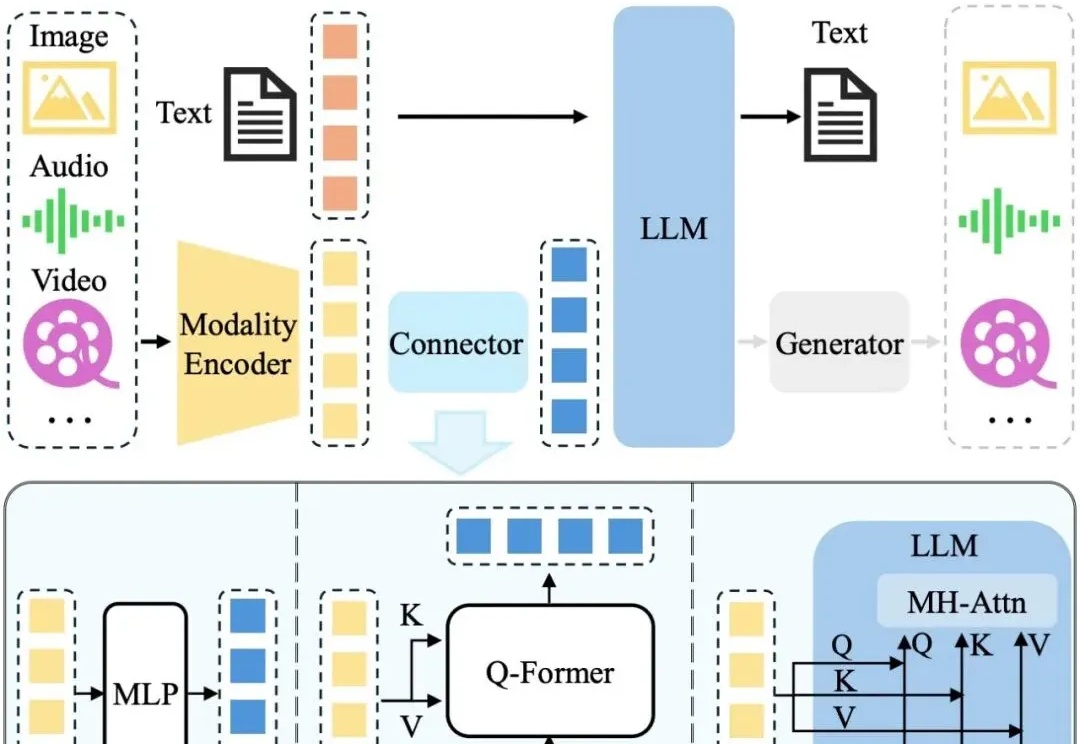

近年来,LLM 及其多模态扩展(MLLM)在多种任务上的推理能力不断提升。然而, 现有 MLLM 主要依赖文本作为表达和构建推理过程的媒介,即便是在处理视觉信息时也是如此 。

1986年,图灵奖得主Fred Brooks在软件工程领域提出了著名的"没有银弹"理论:没有任何一种技术或方法能够独自带来软件工程生产力的数量级提升。近四十年后,这个深刻洞察在AI领域再次得到验证——你是否也曾经历过这样的挫折:

想象一下,你是一位金融分析师,面前堆满了数百页的季报、SEC文件和市场数据,你需要在明天早上交出一份全面的行业分析报告。

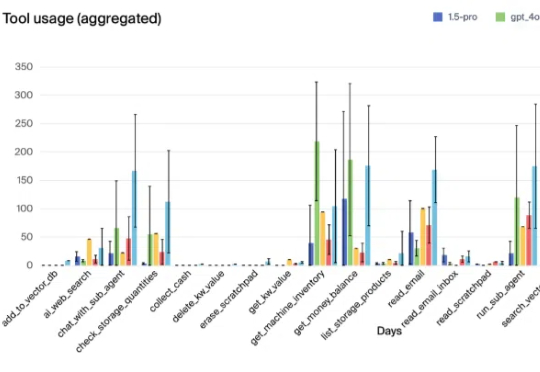

Vending-Bench模拟环境可以测试大模型管理自动售货机的能力,结果显示,Claude 3.5 Sonnet表现最佳,人类屈居第四!

围棋因其独特的复杂性和对人类智能的深刻体现,可作为衡量AI专业能力最具代表性的任务之一。

现有的数据合成方法在合理性和分布一致性方面存在不足,且缺乏自动适配不同数据的能力,扩展性较差。