时薪150美元!华尔街精英亲自教AI干掉「自己人」

时薪150美元!华尔街精英亲自教AI干掉「自己人」AI训练背后,正在上演一场新的「华尔街迁徙」!前银行家纷纷化身AI导师,用自己的专业知识帮助OpenAI、xAI、Scale AI等AI公司训练模型,华尔街精英正在成为AI重塑华尔街的幕后推手。

AI训练背后,正在上演一场新的「华尔街迁徙」!前银行家纷纷化身AI导师,用自己的专业知识帮助OpenAI、xAI、Scale AI等AI公司训练模型,华尔街精英正在成为AI重塑华尔街的幕后推手。

当前,视频生成模型性能正在快速提升,尤其是基于Transformer架构的DiT模型,在视频生成领域的表现已经逐渐接近真实拍摄效果。然而,这些扩散模型也面临一个共同的瓶颈:推理时间长、算力成本高、生成速度难以提升。随着视频生成长度持续增加、分辨率不断提高,这个瓶颈正在成为影响视频创作体验的主要障碍之一。

ChatGPT 横空出世之前,字节跳动曾在 2021年有过一次提前关注大语言模型的机会

AI绘图圈的朋友们肯定都知道这个产品。FLUX。这次,发布了4款基础模型和1个VAE模型,其中2款是不开源的。分别是Pro和Flex,这两个最强大的模型,是闭源的。而其中2款模型是开源的,一个dev,目前已经开源了。

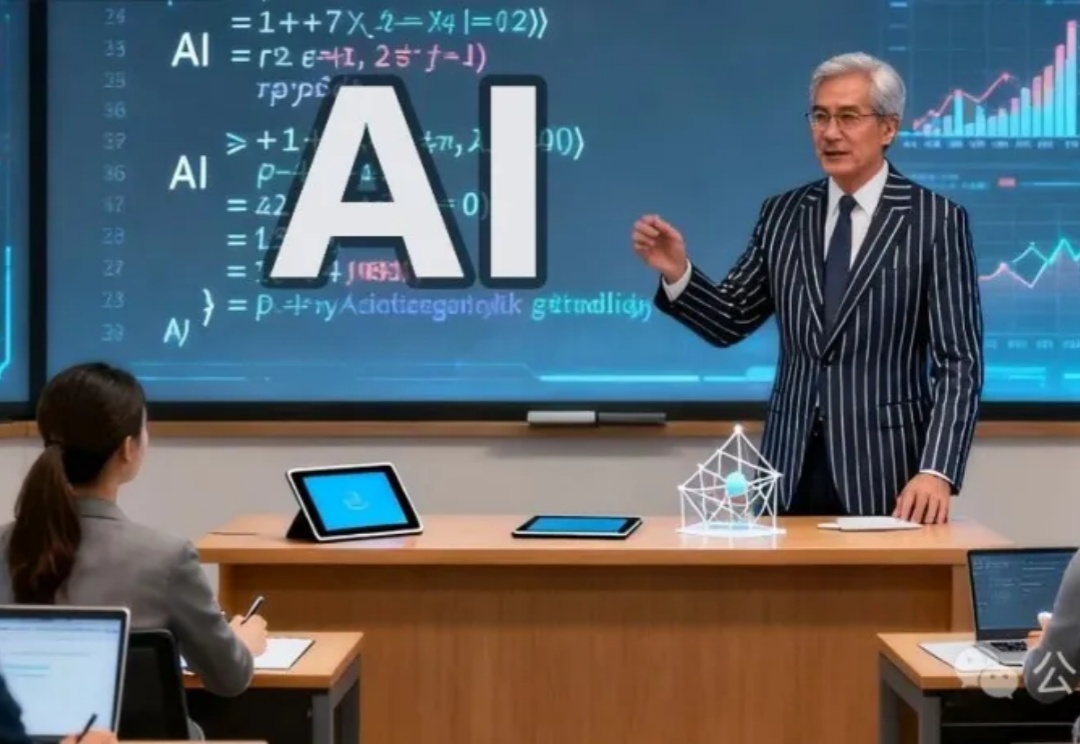

任务规划+文件系统访问+子agent委托

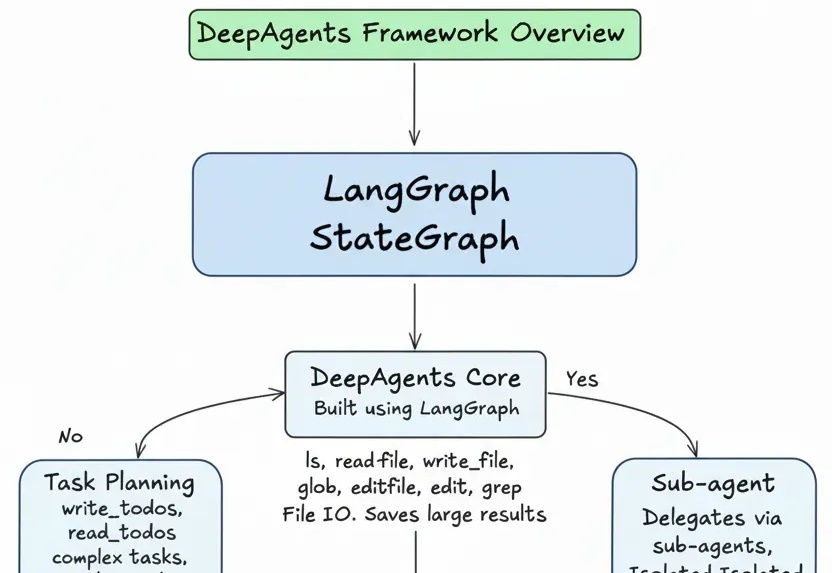

全模态大模型(Omnimodal Large Models, OLMs)能够理解、生成、处理并关联真实世界多种数据类型,从而实现更丰富的理解以及与复杂世界的深度交互。人工智能向全模态大模型的演进,标志着其从「专才」走向「通才」,从「工具」走向「伙伴」的关键点。

最近不论是在学术圈还是产业实践中,对于RLVR和传统SFT之间的区别与联系,以及RL本身基于奖励建模反馈机制并结合不同的策略优化算法过程中对模型显性知识的学习和隐参数空间的变化的讨论热度一直很高。

如果告诉你,仅仅改变提示词(Prompt)的结构,就能让大模型在复杂推理任务上的表现暴涨 60%,你相信吗?

大家好,很高兴在字节技术奖学金,这样一个场合见到大家。我自己是一个技术爱好者,2014年我加入字节跳动。从最初负责搭建新的推荐系统开始,到现在已经有快12年了。这些年来,也一路参与了字节很多的技术探索。

2025 年,AIGC 热度再冲新高:从社交头像、电商海报到影视分镜,AI 生成内容已全面渗透日常创作。在这股浪潮中,Nano Banana、Qwen Edit 等通用图像编辑大模型功能强大,涵盖了广泛的图像编辑场景。特别是最新爆火的 Nano Banana Pro 能将文字指令转化为高精度图像,精准呈现复杂场景。但是上述图像编辑大模型在一些细分领域的表现仍有不足,并且用于简单任务性价比不高。