「肢解」谷歌帝国!Chrome安卓或遭剥离,AI训练数据被迫共享

「肢解」谷歌帝国!Chrome安卓或遭剥离,AI训练数据被迫共享反垄断案败诉,谷歌或将面临「分家」,一旦与Chrome和安卓操作系统解绑,谷歌该何去何从?

反垄断案败诉,谷歌或将面临「分家」,一旦与Chrome和安卓操作系统解绑,谷歌该何去何从?

最近ACL 2024 论文放榜,扫了下,SMoE(稀疏混合专家)的论文不算多,这里就仔细梳理一下,包括动机、方法、有趣的发现,方便大家不看论文也能了解的七七八八,剩下只需要感兴趣再看就好。

大语言模型 (LLM) 经历了重大的演变,最近,我们也目睹了多模态大语言模型 (MLLM) 的蓬勃发展,它们表现出令人惊讶的多模态能力。 特别是,GPT-4o 的出现显著推动了 MLLM 领域的发展。然而,与这些模型相对应的开源模型却明显不足。开源社区迫切需要进一步促进该领域的发展,这一点怎么强调也不为过。

上海交通大学王德泉教授课题组在最新研究中提出了这样的一个问题。

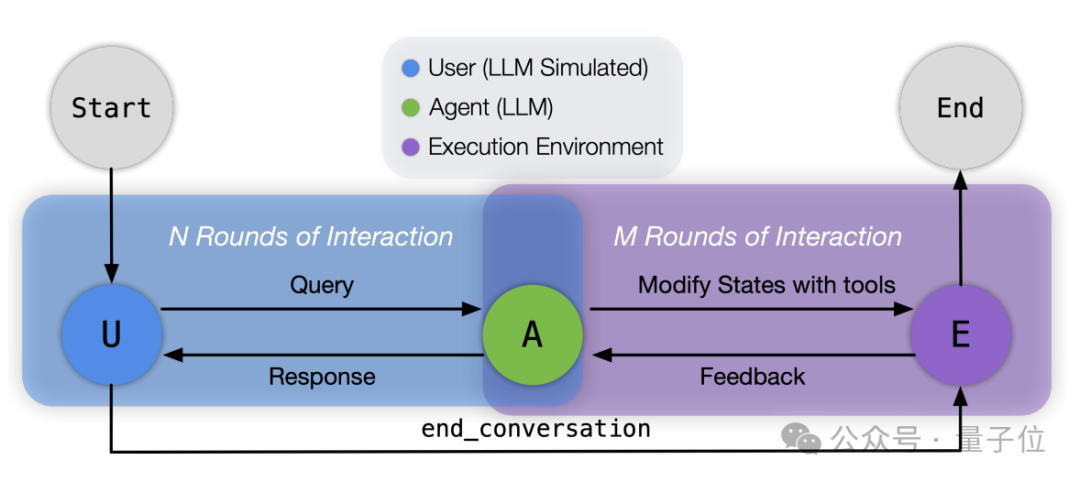

苹果团队,又发布了新的开源成果——一套关于大模型工具调用能力的Benchmark。

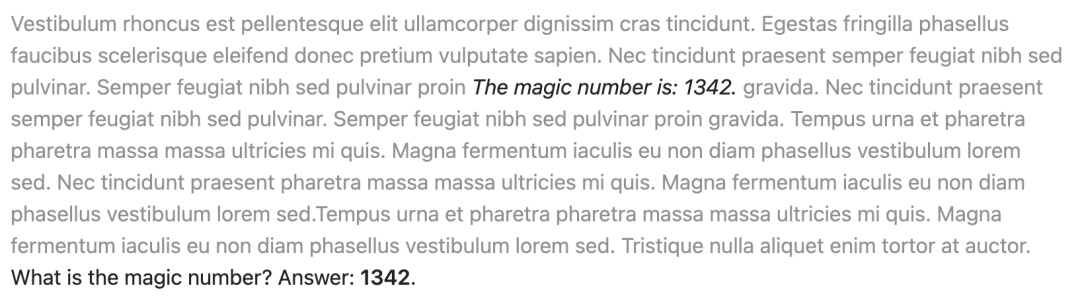

长文本处理能力对LLM的重要性是显而易见的。在2023年初,即便是当时最先进的GPT-3.5,其上下文长度也仅限于2k,然而今日,128k的上下文长度已经成为衡量模型技术先进性的重要标志之一。那你知道LLMs的长文本阅读能力如何评估吗?

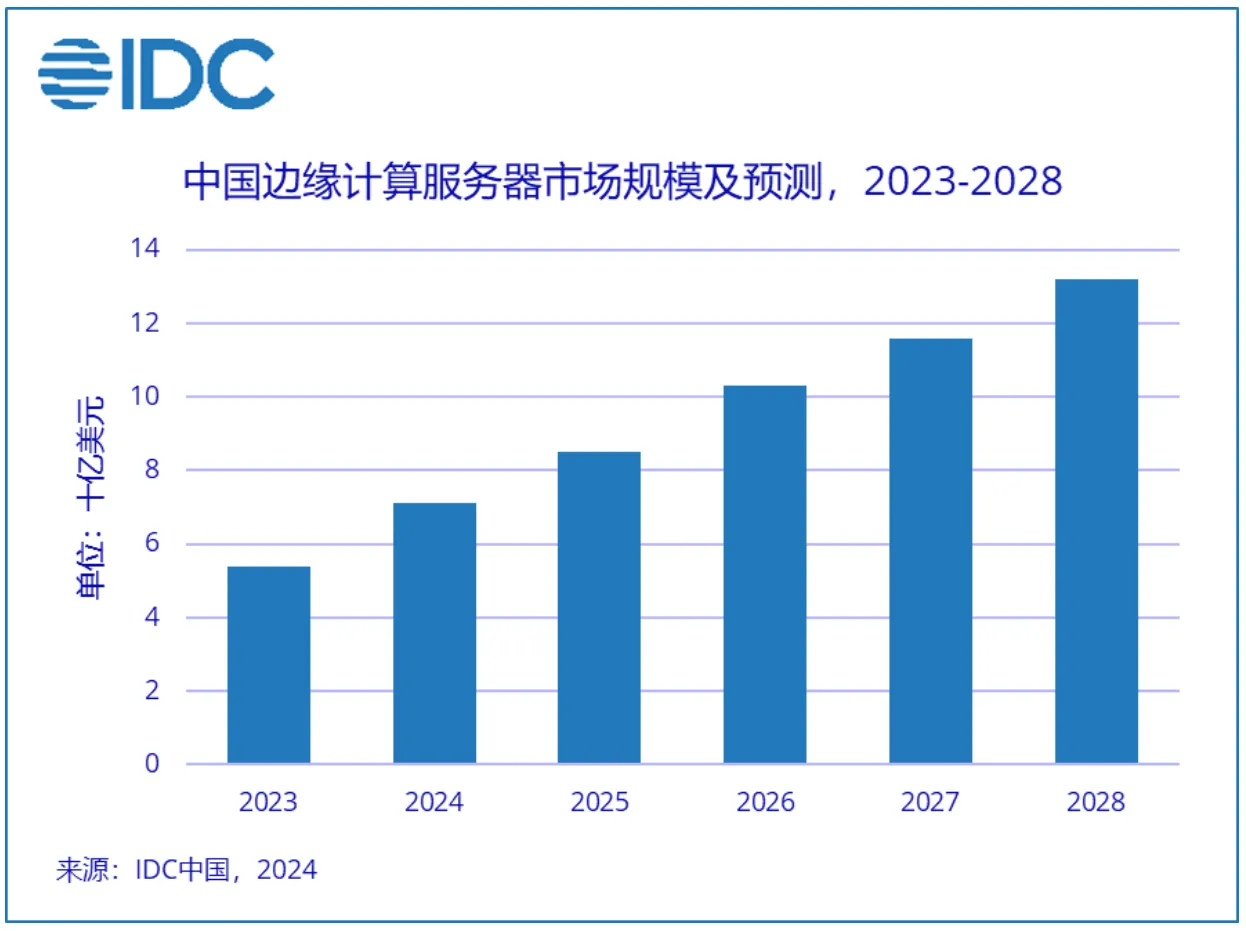

AI 大模型的爆发带动了 GPU 的强劲需求,从云端到边缘渗透的 AI 应用也将带动边缘 AI 服务器及加速处理器的需求。

T-MAC是一种创新的基于查找表(LUT)的方法,专为在CPU上高效执行低比特大型语言模型(LLMs)推理而设计,无需权重反量化,支持混合精度矩阵乘法(mpGEMM),显著降低了推理开销并提升了计算速度。

人工智能系统依靠充足、高质量的训练数据来获得高性能,但MIT等机构最近的一项研究发现,曾经免费提供的数据在多个方面变得越来越难获取。

只用提示词,多模态大模型就能更懂场景中的人物关系了。