只激活3.8B参数,性能比肩同款7B模型!训练微调都能用,来自微软

只激活3.8B参数,性能比肩同款7B模型!训练微调都能用,来自微软只需激活60%的参数,就能实现与全激活稠密模型相当的性能。

来自主题: AI技术研报

9772 点击 2024-07-18 16:44

只需激活60%的参数,就能实现与全激活稠密模型相当的性能。

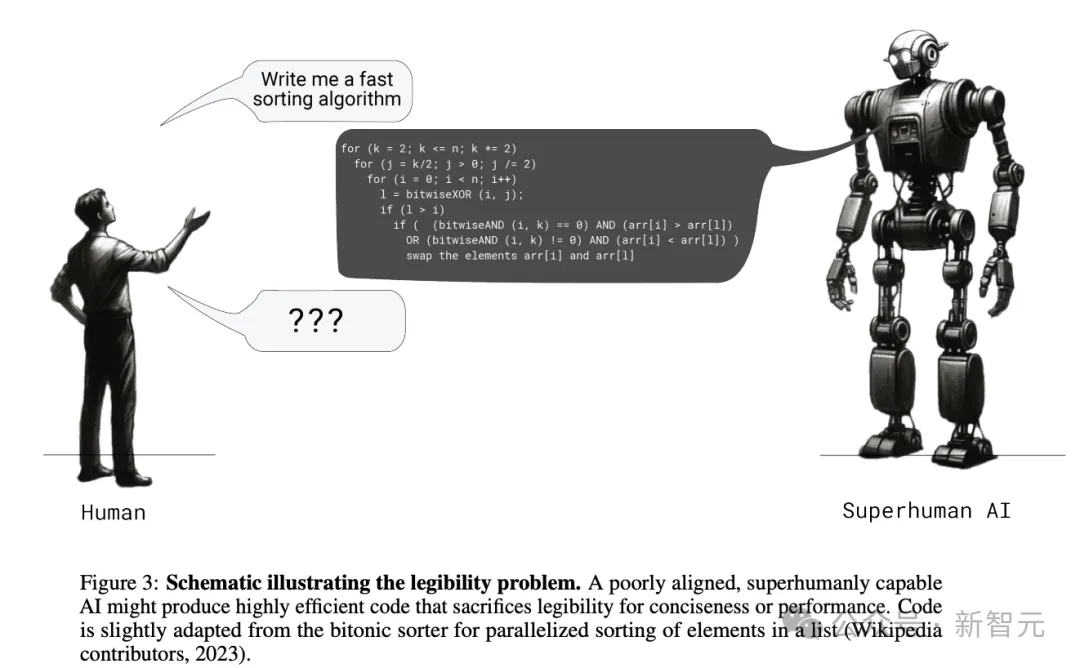

让大小模型相互博弈,就能实现生成内容可读性的提升!

当我们不停在CoT等领域大下苦功、试图提升LLM推理准确性的同时,OpenAI的对齐团队从另一个角度发现了华点——除了准确性,生成答案的清晰度、可读性和可验证性也同样重要。

自回归解码已经成为了大语言模型(LLMs)的事实标准,大语言模型每次前向计算需要访问它全部的参数,但只能得到一个token,导致其生成昂贵且缓慢。

视频生成也能参考“上下文”?!

AI侵权又来了……

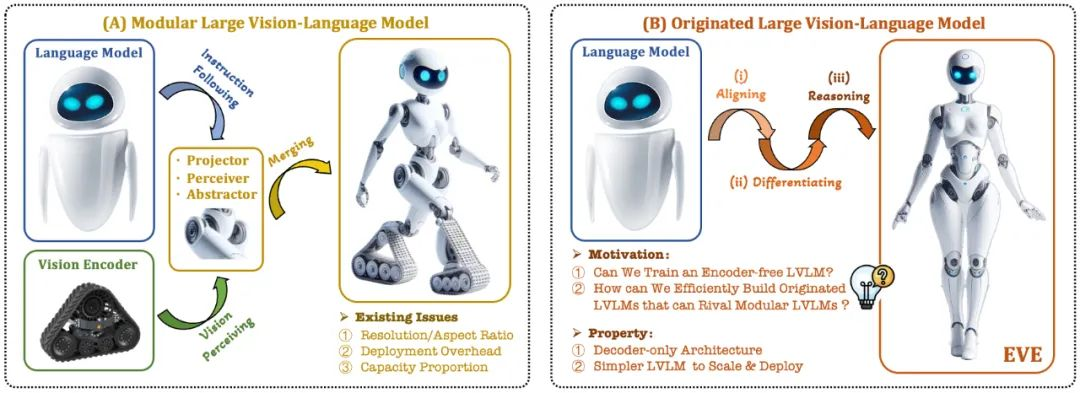

近期,关于多模态大模型的研究如火如荼,工业界对此的投入也越来越多。

假如你有闲置的设备,或许可以试一试。

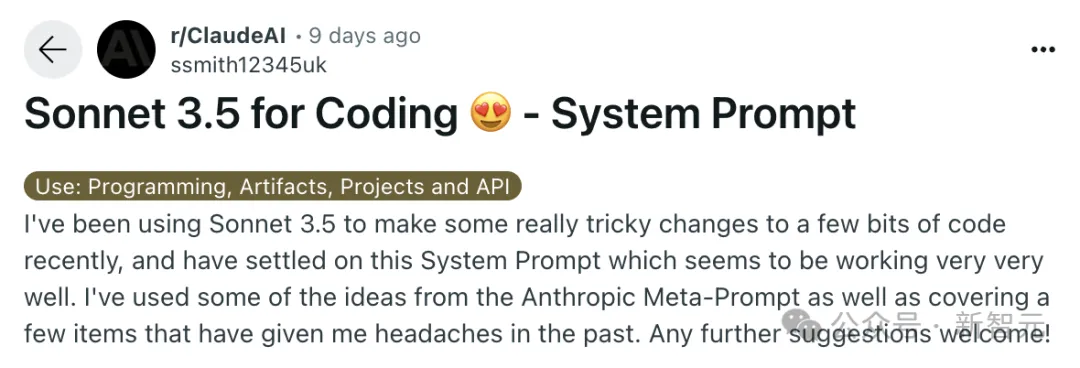

最核心的Claude 3.5编码系统提示,火遍Reddit社区。就在刚刚,原作者发布了进化后的第二版,有的网友已经将其加入工作流。

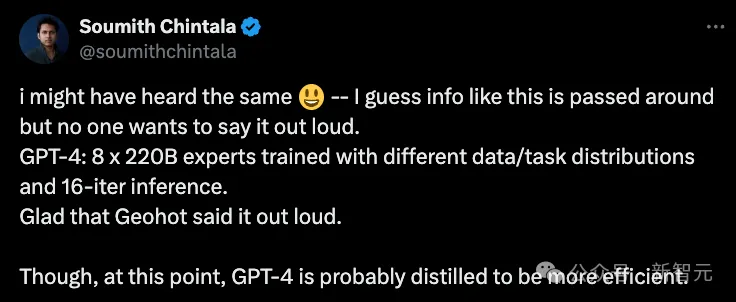

MoE已然成为AI界的主流架构,不论是开源Grok,还是闭源GPT-4,皆是其拥趸。然而,这些模型的专家,最大数量仅有32个。最近,谷歌DeepMind提出了全新的策略PEER,可将MoE扩展到百万个专家,还不会增加计算成本。