腾讯出手了!首款国产AI CLI真有点猛,支持微信登录~

腾讯出手了!首款国产AI CLI真有点猛,支持微信登录~大家好,我是袋鼠帝 先给你们看个好玩的东西:隔空手势控制任意网页 食指☝️指向:控制鼠标移动 比耶✌️:进行点击 手掌✋:上下移动页面 这个高难度的手势控制网页功能,被我用腾讯刚刚发布的国内首款AI CLI:CodeBuddy Code搞定了

大家好,我是袋鼠帝 先给你们看个好玩的东西:隔空手势控制任意网页 食指☝️指向:控制鼠标移动 比耶✌️:进行点击 手掌✋:上下移动页面 这个高难度的手势控制网页功能,被我用腾讯刚刚发布的国内首款AI CLI:CodeBuddy Code搞定了

最近刷视频号时意外发现,评论区多了位「万能 AI 助手」——@腾讯元宝。使用方法很简单,微信搜索「元宝」,添加带 AI 后缀的那个账号为通讯录好友,就可以在视频号评论区 @ 它了。

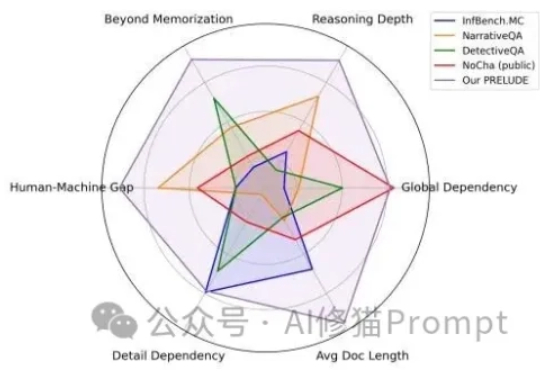

AI领域一度陷入“上下文窗口”的军备竞赛,从几千token扩展到数百万token。这相当于给了AI一个巨大的图书馆。但这些“百万上下文”的顶级模型,它究竟是真的“理解”了,还是只是一个更会“背书”的复读机?

随手拍的一张图,就能秒变3A级游戏大作?! 刚刚,腾讯全新开源游戏视频生成框架Hunyuan-GameCraft,专为游戏环境设计,让任何人都能轻松搞定游戏制作。

今年上半年,围绕 AI 的讨论,正在从「技术能做什么」转向「技术如何赚钱」。 当「模型参数」竞赛和「能力演示」热潮逐渐褪去,资本市场和企业自身都开始更严苛地审视 AI 投入的真实回报。

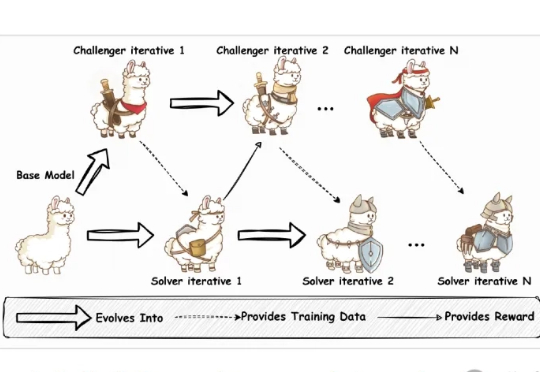

当前训练强大的大语言模型(LLM),就像是培养一个顶尖运动员,需要大量的、由专家(人类标注员)精心设计的训练计划和教材(高质量的标注数据)。

当AI智能体(Agent)开发的浪潮涌来,很多一线工程师却发现自己站在一个尴尬的十字路口:左边是谷歌、OpenAI等巨头深不可测的“技术黑盒”,右边是看似开放却暗藏“付费墙”的开源社区。大家空有场景和想法,却缺少一把能打开未来的钥匙。

深度研究智能体(Deep Research Agents)凭借大语言模型(LLM)和视觉-语言模型(VLM)的强大能力,正在重塑知识发现与问题解决的范式。

据申妈朋友圈报道,原阿里通义千问语音团队负责人、前腾讯AI Lab副主任鄢志杰,已于近期正式加盟京东探索研究院

又是一年WAIC,熟悉的七月,熟悉的上海,腾讯也如约而至。