大家可能看到过很多类似的结论:针对特定任务,对开源模型进行 LoRA 微调可以干翻 GPT-4 这类闭源模型。

听上去很香!但现实的问题是,这条路并没有想象中那么“低成本且高效”。让模型在业务场景里发挥作用的前提是:你得持续微调、优化,还得逐个部署。然而,一旦涉及多个业务场景,事情就开始变复杂了——上百个 LoRA 微调模型要怎么部署?服务器资源会被吃掉多少?算法团队能顶住多大的压力?

更扎心的是,“低成本”和“高效部署”几乎是个伪命题。想象一下,为了部署这些模型,你的团队可能需要熬无数个夜,把预算烧个干净,最后还得面临部署延迟。

这些困难,真的没有解法吗?

然而,某知名招聘行业的互联网公司,在不增加额外 GPU 算力开销的情况下,可以在一天内,上线多个业务线的近 100 个 7B LoRA 微调模型,以进行线上灰度测试和验证,并且全程只需要负责的工程师独立操作,不需要繁琐的跨部门协调。

是不是听起来有些不可思议?了解大模型部署的朋友都知道,部署 100 个 7B LoRA 微调模型需要面临巨大的算力、人力以及时间成本。按照传统部署方案,使用开源推理框架,通常需要:

除了显而易见的算力、人员和时间成本,传统部署方案还存在哪些“隐形成本”?

这些问题导致模型落地成本极高,许多公司甚至难以验证微调模型的实际价值。

如何解决这些挑战?前文提到的某招聘行业互联网公司,通过与无问芯穹合作,在无需自行采购 100 张 GPU 卡的情况下,2 名算法工程师用 1 小时就完成了 100 个 LoRA 微调模型的部署,且后续无需专门维护和管理这 100 个模型服务。

是什么使这种高效部署成为可能?并且成本得到了降低?

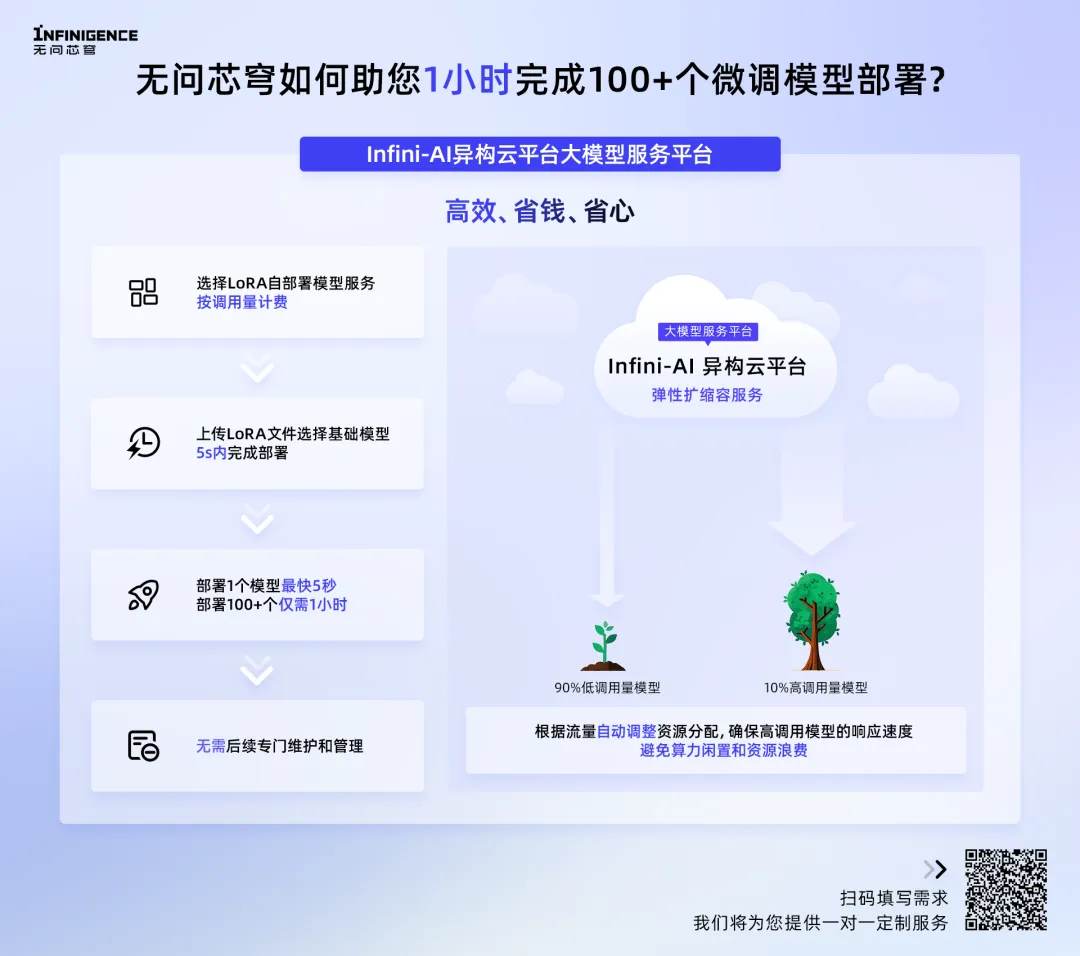

无问芯穹 Infini-AI 异构云平台·大模型服务平台提供了一种操作极简、成本低的部署方式——「Lora 自部署模型服务」。

只需上传 LoRA 文件并选择基础模型,最快 5 秒内即可完成 1 个 7B LoRA 微调模型的部署,让模型部署像调用 API 一样简单。

并且能够让算法工程师在 1 小时内完成 100 个模型的部署, 1 天内完成优化后的效果评估。与此同时,按模型调用的 Token 数量计费模式,免去了企业购置 100 张 GPU 卡的成本压力,显著降低了算力投入。

成本问题解决后,又如何在 100 个 LoRA 微调模型服务中保证 10% 高调用模型的响应速度?「Lora 自部署模型服务」还支持弹性自动扩缩容,可根据流量自动调整资源分配,确保高调用模型的响应速度。

此外,模型部署完成后,无需专人管理和维护这 100 个 LoRA 微调模型服务,无问芯穹 Infini-AI 异构云平台·大模型服务平台将为您提供托管服务。

无问芯穹 Infini-AI 异构云平台·大模型服务平台「Lora 自部署模型服务」为企业提供了一种操作极简、成本低的部署方式,让模型落地将不再受高昂部署成本、低资源利用率以及反复部署的困扰。

为了帮助企业解决模型部署难题,无问芯穹提供了部署试用算力,以及有关业务场景所需的吞吐和并发性能,欢迎复制链接到浏览器打开:

https://infinigence.feishu.cn/share/base/form/shrcn6lARShCYpA93tNjilHIQnh

快来提交需求试试!

文章来微信公众号“夕小瑶科技说”