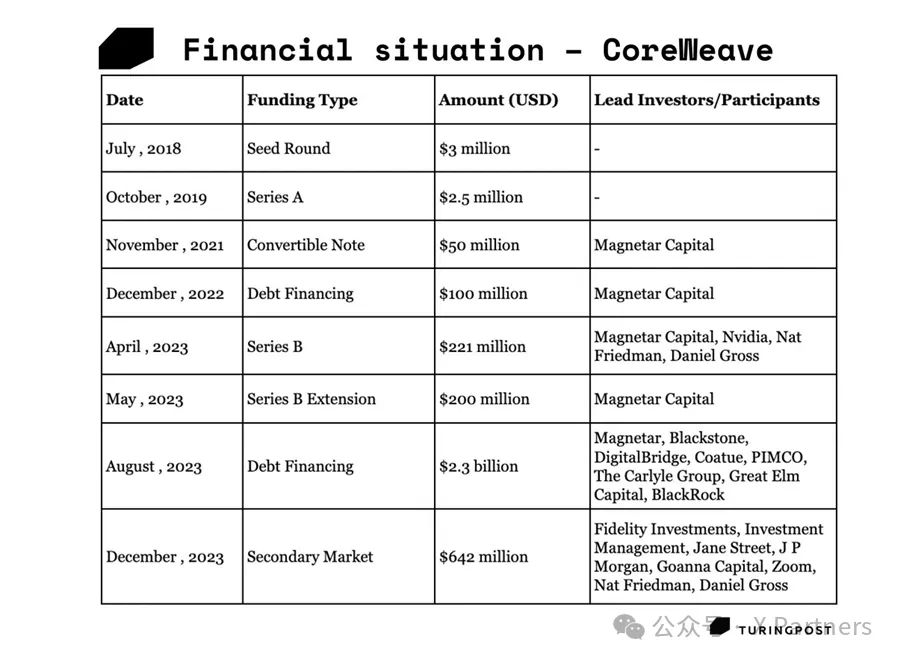

CoreWeave从最初的加密货币挖矿业务起家,现已成为AI云计算领域的领军企业。2024年5月获得了75亿美元的债务融资,这是其历史上最大的一笔交易,主要支持者来自黑石、凯雷集团和贝莱德等机构。此前,在Coatue和富达等机构投资 6.42 亿美元的少数股权投资后,估值从 20 亿美元攀升至 70 亿美元。

他们的战略转移和对英伟达GPU 的早期使用促成了这一目标的实现。CoreWeave 能够提供功能强大且经济高效的GPU资源,为当前的生成式AI革命推波助澜。但他们并没有忘记自己的根和以前的合作伙伴:2024年 3 月 7 日,CoreWeave 与比特币挖矿和数字基础设施提供商 Core Scientific 签订了一份价值高达 1 亿美元的多年期合同,租用其 16MW 的数据中心空间。

Burning that skyscraper: how they started

2016 年,曼哈顿一间办公室里的三位大宗商品交易员-- Michael Intrator、Brian Venturo和Brannin McBee--开始了一项小小的爱好:他们购买了一个简陋的GPU 来挖一些以太坊,希望能"多赚1000 美元"。比特币是挖矿领域的佼佼者,但在 2015 年,一种新的加密货币引起了矿工们的注意:以太坊。据《纽约时报》报道,2016年 3 月,"以太坊价值飙升,在过去三个月里攀升了1000%"。值得一试。许多矿工明白,在这些被称为"矿池"的实体中组队,成功的机会更大。但还有一个新概念:云挖矿。云挖矿是指从提供商处租用计算能力,远程挖掘加密货币,而无需管理物理硬件。在AI的世界里,对于那些渴望获得 GPU 能力的人来说,这听起来很熟悉,对吗?

乘着云挖矿的热潮(交易员对金融业的热潮非常敏感),三位同事不断购买GPU。很快,他们发现自己的办公室里闷热难耐,到处都是呼呼作响的GPU。正如Michael Intrator 所说"突然之间,从一个 GPU 到一堆 GPU,再到台球桌上布满了 GPU......感觉我们要“烧掉“这座摩天大楼!"2017年,他们将“烫手”的GPU 搬到了新泽西州的一个车库里,并创办了CoreWeave 公司(原名大西洋加密公司),开始从事云挖矿业务,并拥有了自己的第一个数据中心。

It's getting cold – a turning point to AI

2018-2019 年,加密货币突然华丽崩盘。这本可能是末日,但对CoreWeave 而言,却是关键时刻。由于市场上出现了廉价的不良GPU,他们做出了战略性举措。Intrator、Venturo 和 Brannin McBee(他们的CSO)开始专注于媒体和娱乐、生命科学、高性能计算、机器学习(ML)和AI--所有这些行业都需要 GPU 提供的巨大能量。

GPU 对 ML、AI 和 HPC 如此重要的原因是:GPU 的并行处理能力可以加速 ML、AI 和 HPC,高效处理大型数据集和复杂计算,从而加快深度学习模型的训练和推理时间。事实上,AI就喜欢在这些GPU 上处理数据。

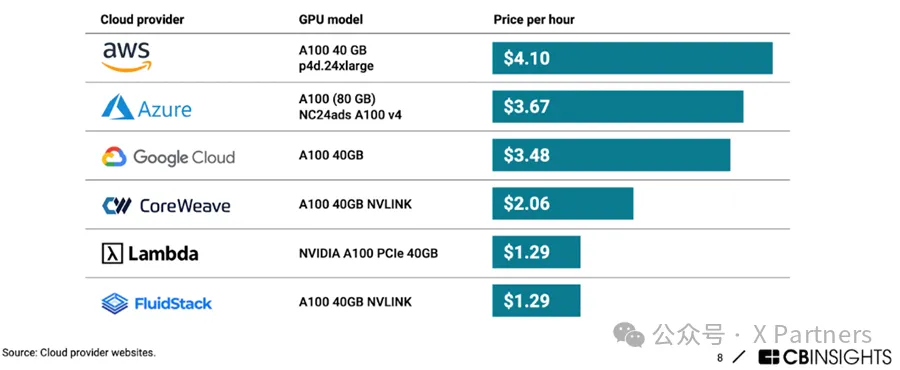

市场对ML 投资越来越多,且随着 ML 公司越来越多,对 GPU 性能的追求也越来越强烈。传统的云计算公司(AWS、微软 Azure、谷歌)仍在摸索中,为使用这种新的AI技术收取高昂的费用。

但是,CoreWeave 也看到了差距--他们拥有 GPU,只是需要围绕 GPU 构建系统。他们还采取了另一个明智的战略举措:当你拥有如此多的GPU 时,就会去找它们的制造商建立合作关系。英伟达与客户、服务提供商、有影响力的人士--所有能让他们的地位变得更广泛、更强大的人--建立关系网络,这真是天才之举。

The Generative AI explosion (and a frantic search for GPUs)

大家都知道2022 年 11月发生了什么:OpenAI推出了ChatGPT,点燃了生成式AI革命。各家公司争先恐后地抢夺让这一切成为可能的芯片。Venturo意识到,'我们从规模角度考虑的一切可能都是完全错误的......这些人不需要 5000 个 GPU。他们需要的是 500 万个。CoreWeave 发现自己已经完美地定位在高需求上。他们从一家名不见经传、只有几条值得关注的新闻的公司,一跃成为独角兽企业,获得了他们所能想象到的所有媒体关注。突然之间,每个人都需要他们所拥有的东西。

AI需要的是坚实的基础设施。"这与电力类似:当你打开电灯开关时,你会想到发电厂吗?"Brannin McBee 说。"我们现在做的就是为AI市场建设电网。如果这些东西建不起来,那么AI将无法扩展。"

Symbiotic partnership: say CoreWeave, hear NVIDIA

CoreWeave 与英伟达紧密相连。英伟达需要其芯片的销售渠道和非竞争对手的合作伙伴。CoreWeave需要芯片、信誉和支持来实现其雄心勃勃的计划。尽管CoreWeave 可以提供其他芯片(详见技术部分),但其大部分产品都是英伟达的产品。英伟达拥有像CoreWeave 这样有实力的合作伙伴,可以展示其GPU 的性能,这对英伟达大有裨益。通过CoreWeave 的平台,企业和研究人员可以轻松利用英伟达的最新技术,通常不需要自己昂贵的内部硬件。这有助于英伟达接触到更广泛的受众。CoreWeave可以提前获得英伟达公司最先进的GPU技术,同时还能获得与行业领导者紧密联系的影响力。这就像成为GPU 领域"圈内人"的一员。根据CBInsights 的报道,英伟达正在向规模较小的专业云提供商CoreWeave 和Lambda Labs 提供GPU 的优先访问权,这两家公司正在以较低的成本向企业提供云GPU 访问权。

Why does CoreWeave get early access to GPUs?

1. Elite Partner Status: 作为英伟达合作伙伴网络中的精英云服务提供商,CoreWeave与英伟达建立了密切且值得信赖的合作关系。这意味着在使用最新GPU 技术时可享受优惠待遇

2. Technical Expertise: CoreWeave 拥有一支精通英伟达架构优化的团队。他们的工程技术使其成为英伟达推出新一代GPU 时的重要合作伙伴,因为他们可以提供反馈并帮助确保与云环境的顺利集成

3. Shared Customer Base:英伟达和 CoreWeave 的目标客户都是创新者、研究人员以及严重依赖 GPU 加速的企业。CoreWeave 实际上成为英伟达影响力的延伸,使其能够在现实世界中快速展示其最新芯片

4. Mutual Benefit: 早期接入为CoreWeave 带来了竞争优势,吸引了希望获得最先进性能的客户。对于英伟达来说,这展示了其GPU 的能力,从而提高产品的采用率

Important Note:虽然CoreWeave 经常可以提前获得英伟达新GPU,但并不总是保证绝对第一。一些与英伟达签订了直接合同的大型企业客户有时可能会根据特定的使用案例和需求获得同等或稍早的使用权

这种专业化使他们能够真正充分利用硬件。他们专门针对图形密集型和计算量大的工作负载对基础设施、软件和网络进行微调。

Competition with‘Big 3’

虽然CoreWeave 并不与英伟达竞争,但它确实要与"三巨头"(AWS、微软 Azure 和谷歌云)一较高下。有人可能会问,既然GPU 资源可以通过现有的云计算平台访问,那么是否真的需要一个GPU 优先的云平台呢?Brian Venturo指出,"三巨头 "存在以下问题:1)计算选项种类有限;2)难以按需扩展;3)成本过高。CoreWeave 的目标是在这些方面超越竞争对手。如果估值是一个指标的话,它似乎正在取得成功

对于Lambda Labs 这样的小型竞争对手,CoreWeave则选择吸引他们的关键人才。2023年 9 月,CoreWeave 迎来了之前担任 Lambda Labs COO的 Mike Mattacola 担任新的COO。2024年3 月 12 日,又宣布了一项重大招聘:曾担任 Google Cloud 财务VP的Nitin Agrawal 将加入公司担任CFO。公司领导层还发生了其他变化:联合创始人Brannin McBee现在将担任CDO;联合创始人Brian Venturo被任命为CSO。现任工程副总裁Peter Salanki 将升任CTO。

Financial situation and partnerships

在短短几个月内,CoreWeave 从默默无闻到 "哇,他们是从哪里冒出来的?"这一切都要归功于生成式AI。他们从最早只是融了几百万美元,到后来获得了数十亿美元的融资,并建立了"GPU 云资源首选"的声誉。

Nvidia 为这家快速成长的初创公司提供了强大的支持,而这些投资也得到了回报。CoreWeave从一个名不见经传的小公司发展到融资数亿美元,并建造了一些世界上最强大的超级计算机。"创始人在谈到他们正在建设的人工智能基础设施时说:"这与电力类似,当你打开电灯开关时,你会想到发电厂吗?我们现在做的就是为AI市场建设电网。"

他们迅速扩张,建立了巨型数据中心,这与在新泽西州车库里的简陋起点大相径庭。规模变得令人震惊。创始人提到,ChatGPT 发布的那一刻,我就想,'我们从规模角度考虑的一切可能都是完全错误的。这些人不需要5000 个GPU。他们需要的是五百万"。

Partnerships (from CoreWeave’s website):

Datadog -用于监控和优化CoreWeave Cloud 使用情况的集成,2023年 8 月 3 日发布

1. Zeet -在2023 年 4 月 27 日举行的关于平台工程入门的网络研讨会上亮相

2. PureWeb - 2023 年 3 月 10 日宣布在 CoreWeave 上发布虚幻引擎和 Unity 的按需流媒体平台

3. EleutherAI & NovelAI - 2022 年 2 月 2 日宣布建立合作伙伴关系,使开源AI更容易获得

4. NVIDIA -成为英伟达首家计算领域的精英云服务提供商,于2020 年 9 月 5 日宣布建立初步合作伙伴关系,并于 2020 年 9 月 4 日加入英伟达CSP 计划

Microsoft alsosigned a multi-billion dollar deal with GPU cloud provider CoreWeave to meet AI needs.微软还与 GPU 云提供商 CoreWeave 签订了价值数十亿美元的协议,以满足人工智能的需求。

Revenue

McBee 对 VentureBeat 说:"CoreWeave 2023年的收入为 3000 万美元,2024年将达到 5 亿美元,25年的合同额已接近 20亿美元。其中哪些来自AI合作伙伴,哪些来自加密货币,目前还不得而知。2024年 3 月 7 日,CoreWeave 与比特币挖矿和数字基础设施提供商 Core Scientific 签订了一份价值高达 1 亿美元的多年期合同,向其租赁 16MW 的数据中心空间。这无疑是一种很好的收入多元化。

Dancing between the feet of elephants

在最近的一封电子邮件中,CoreWeave提出了一些重要的统计数据。仅去年一年:

•在富达和 Jane Street 领投 6.42 亿美元的第二轮融资后,估值和营收飙升至 70亿美元。

•获得由 Magnetar 和 Blackstone 牵头的 23 亿美元债务融资

•员工人数翻了两番

•迅速扩大了数据中心的覆盖范围,从 3 个增至 14 个

•与当今最热门的人工智能实验室合作,包括Mistral、Inflection AI 和一些家喻户晓的公司

他们自称是"所有AI应用背后的镐和铲"。但即使有这些数字作为支撑,他们仍然是一家相对较小的公司,实际上并不生产任何镐或铲,而是购买或借用它们。以下几个挑战可能对CoreWeave 的未来至关重要

•Dependency on Nvidia: CoreWeave 对 Nvidia GPU 的依赖使其面临供应链中断和 Nvidia 战略重点变化的风险。任何供应波动或竞争对手的进步都可能对CoreWeave 的运营产生重大影响

•Market Competition: 所处的领域竞争激烈,微软、谷歌和亚马逊等巨头也在争夺AI和云计算领域的主导地位,并有可能使用其AI芯片。这种竞争压力可能会挑战 CoreWeave 的市场地位

•Financial Risks from Innovative Financing: 使用 GPU 作为大额债务融资的抵押品具有创造性,但会带来财务风险。这种抵押品的价值可能会波动,更新的技术可能会降低现有资产的价值,从而影响CoreWeave 的财务稳定性

•Technological Evolution: AI和云计算领域的技术发展日新月异,需要不断投资于最新的硬件和软件,以保持竞争力。要跟上这些变化,同时又不过度扩张,就必须进行周密的战略规划

创始人McBee对《华尔街日报》说:"感觉就像我们在大象脚下跳舞。

Tech specs: What does the company offer?

与谷歌云平台、亚马逊网络服务或微软Azure等提供广泛服务的主要云提供商不同,CoreWeave针对的是计算密集型工作负载对云计算资源的特定需求,这些工作负载可从GPU中获益。这种专注的方法使 CoreWeave 能够针对 GPU 密集型工作负载优化其基础设施,从而提供优于通用云解决方案的性能和成本效益。

仅以GPU短缺为例,可以理解强大的计算资源对于人工智能应用的关键作用。没有适当的计算资源,就不可能有机器学习应用,更不用说需要大量计算来训练和运行的流行的大型语言模型了。因此,这就是CoreWeave 与企业AI应用之间的契合点,企业AI应用正变得越来越流行,从而提高了对公司服务的需求。CoreWeave还面向视觉效果、动画和像素流等行业。

CoreWeave 提供对其基础设施各组成部分的访问,包括

•GPU Compute:提供可配置实例的 10 多个英伟达GPU。与传统的云计算提供商相比,CoreWeave 可为 GPU 工作负载节省大量成本(高达 80%)

•CPU Compute: 提供 AMD 和英特尔处理器,满足通用计算需求

•Kubernetes: 支持使用 Kubernetes 进行容器化部署

•Virtual Servers: 提供托管在 CoreWeave Cloud 中的虚拟机,是部署可扩展、高可用性应用程序和功能强大的虚拟工作站的理想选择

•Storage: 通过在不同地点的多个服务器上进行数据复制,实现高可用性,从而优先保证数据安全

•Networking:提供无与伦比的公共互联网接入速度(每个节点高达100Gbps)

How CoreWeave achieve efficiency in working with compute-intensive workloads on an enterprise scale?

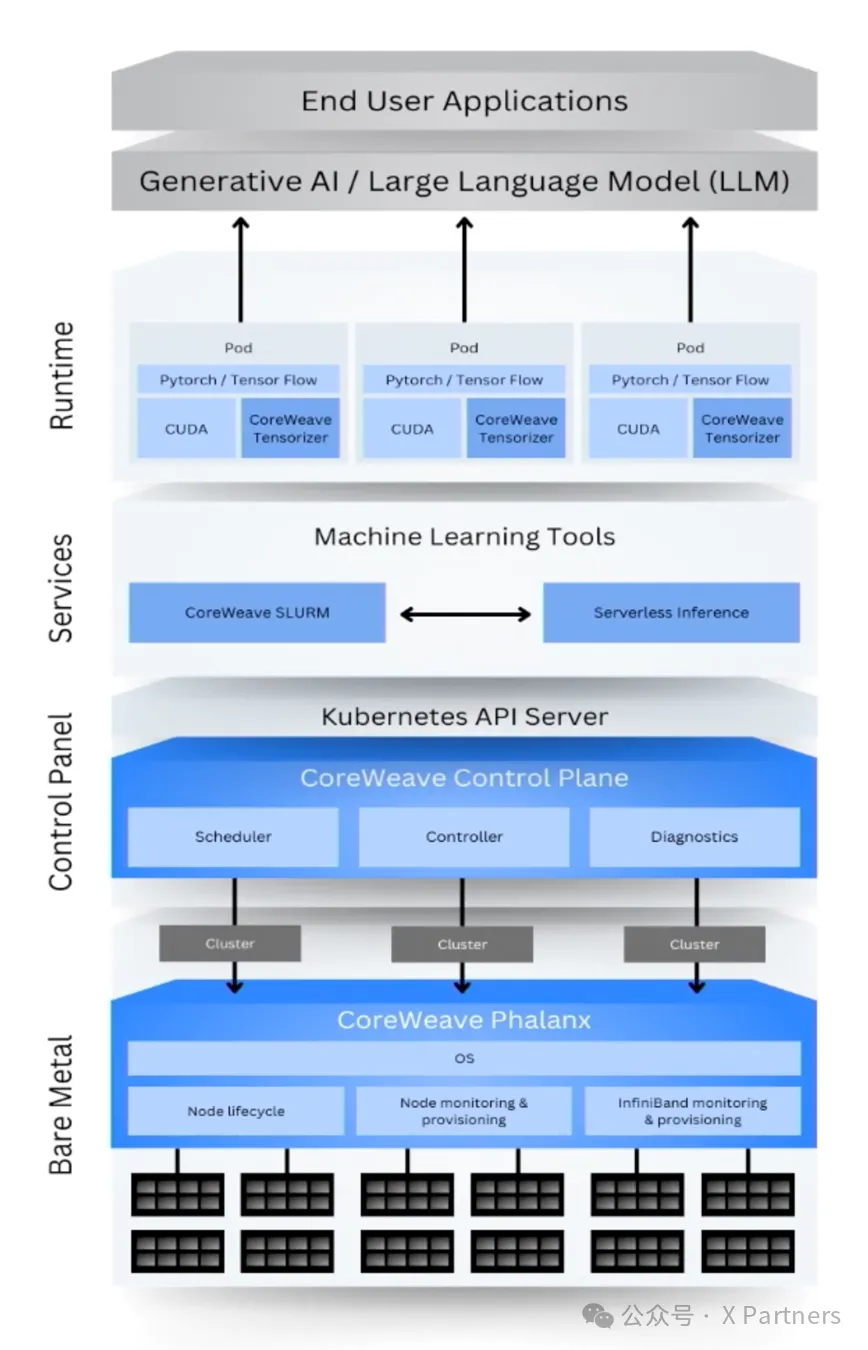

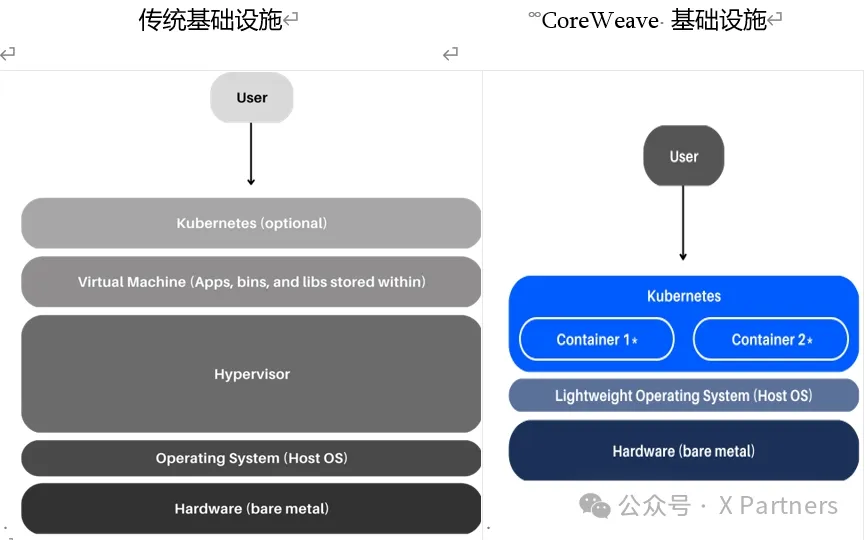

Cloud architecture

云架构是定义云资源和基础设施如何组织、部署和管理的高级设计。它定义了云系统的各个组件如何协同工作。CoreWeave云架构向客户承诺,"计算解决方案的速度比传统云提供商快 35倍,成本比传统云提供商低80%"。它负责资源的可扩展性和弹性,使其能够轻松地扩大或缩小,以满足不断变化的需求。

Bare metal or a direct usage of computing

CoreWeave 利用 "裸机 "技术,这意味着用户工作负载直接运行在服务器的物理硬件(节点)上,而不是由软件(管理程序)创建的虚拟机上。这就消除了通常用于管理单个服务器上多个虚拟机的管理程序层。

因此,客户可以直接访问服务器的全部资源,并从更高效的资源分配中获益。由于物理服务器专用于客户的工作负载,因此客户可以体验到可预测的性能和对硬件规格的细粒度控制,非常适合需要强大处理能力或特定硬件需求的任务。

Broadest range of NVIDIA GPUs

传统的云平台往往迫使企业在经济实惠的低功率 GPU 和昂贵的高性能选项之间做出选择。这会限制AI产品和应用的开发。

CoreWeave 提供超过 10 种英伟达GPUs,打破了这一限制。这种广泛的选择使企业能够将其工作负载的复杂性与适当的处理能力完美匹配。这为企业构建尖端AI应用提供了优化的性能和经济高效的解决方案。

Serverless + Kubernetes

裸机需要由客户承担管理服务器的责任,但CoreWeave 不需要。CoreWeave结合了无服务器方法和Kubernetes 的优势。无服务器计算无需管理基础设施。Kubernetes为容器化应用提供了强大的协调平台。有了无服务器Kubernetes,客户可以专注于应用程序的核心功能,而不必担心服务器或复杂基础设施的管理。它可以根据客户的需求自动增减资源。这包括为计算密集型任务扩展数百个GPU。它还能更有效地利用资源,为客户节省资金。无服务器Kubernetes 使CoreWeave 非常适合工作负载波动或需要按需GPU 资源的情况。

Storage

传统上,加载大型PyTorch 模型会耗费大量时间,影响应用程序性能。CoreWeave通过两种解决方案解决了这一问题:

•Accelerated Object Storage:这是一种高性能存储解决方案,专为频繁访问的静态数据(如模型权重和训练数据)而设计

•CoreWeave Tensorizer: 这是一款 PyTorch 专用工具,可优化模型加载过程本身

Conclusion

CoreWeave 的故事是一个持续的传奇。孕育他们的加密世界可能已成为远去的历史,但它却灌输了一种在当今动荡不安的科技环境中至关重要的拼搏和适应心态。他们证明,创新并不总是诞生在硅谷光鲜亮丽的办公室里;有时,创新始于一间摆满GPU 的闷热房间,始于对未来的赌注。当交易员建立一家 ML基础设施公司时,这也是一个不寻常的故事。

文章来微信公众号“X Partners”,作者“浅浅是Cloris”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner