当我们惊叹于Deepseek的妙语连珠时,是否正目睹硅基系统对人类语言本源的复刻?那在服务器集群中奔流的矩阵运算,与人脑皮层间跳跃的神经电波,究竟共享着怎样的“语言密码”?

借助精密的脑成像技术,人们惊讶地发现,大语言模型的层级结构竟与大脑语言中枢的解剖布局惊人相似。但这种相似性之下,却暗藏着进化史所塑造的本质分野。

翻开这本跨越生物与数字疆界的对话录,本文将带你穿梭于fMRI实验室与云计算中心之间,解码语言处理的双生密码,见证智能本质的百年追问如何在硅基与碳基的共鸣中找到新的答案。

一、AI与人类语言系统的相似性

1. 行为·结构·计算原则的全景比较

1.1 行为的模拟

1.2 解剖学的对应

1.3时序动态的重合

1.4计算原则的共振

2. 语言处理相似性背后的影响因素

二、AI与人类语言系统的差异性

1. 进化之异

2. 发展之别

3. 机制之差

4. 功能之辨

1. AI模型能作为人类的模型生物吗?

2. 大脑如何启发AI的推理能力?

要比较语言模型与大脑行为的相似性,我们可以观察二者在面对相同的问题设置和情景输入下的行为表现是否类似。为了探究语言模型在没有人工干预的情况下,是否能合理地“模拟”出一些多样的、跨领域的人类行为,艾赫(Aher)等人模拟了AI在经济行为、语言处理、社会心理学等多个领域的经典实验中表现[1]。

人类大脑在处理语言时,不仅仅是通过语法来理解句子,还会考虑上下文、情感和社会背景。举个例子,当你看到一句“他走得很快”,你不仅理解到“走得快”是一个动作,还能通过上下文知道可能是在描述一个急于赶路的人。类似地,大语言模型也能通过训练数据中的大量语料来理解句子的意义,并进行语言生成。

在花园路句(Garden Path Sentences)实验中,语言模型能够通过预测语法结构并调整理解路径来处理复杂句子,这类似于人类在遇到语法歧义时如何调整注意力、重新评估句子结构。人类和语言模型都依赖于上下文信息来决定词汇的意义和句子的结构,并能在理解中逐步纠正错误。

比如,"The old man the boats." 初看这个句子,读者可能会将"the old man"理解为“那个老年人”,而将"the boats"理解为“那些船”。然而,正确的结构是:"The old | man the boats" ,其中“the old”是主语,“man”作为动词,表示“操控”或“管理”,整句话的意思是“老人们操作这些船” 。这个句子一开始可能让读者误入歧途,但是根据上下文的提示,我们可以调整对语义的理解。

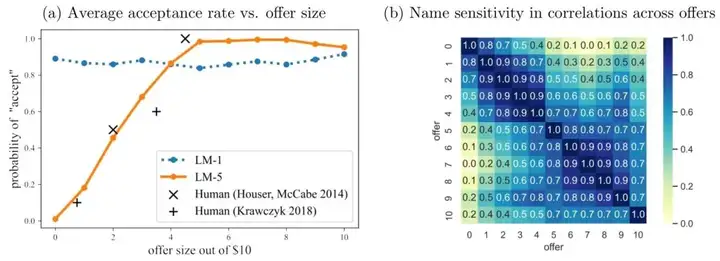

语言模型还能够模拟人类在社会中的某些决策行为。比如终极提议博弈(Ultimatum Game)实验研究了人类在面对不公平提议时会做出怎样的反应。在这个实验中,提议者会给出一个分配方案,接受者则有两个选择:接受提议或者拒绝。如果接受者接受提议,双方按照提议者的方案分配资源;如果拒绝,双方都无法获得任何资源。人类通常会在面对提议时,考虑公平性和社会规范。语言模型通过大量的文本学习,也能够在给定条件下生成类似的决策结果。例如,当一个模拟场景中涉及到不公平的提议时,语言模型会生成“拒绝”这一响应,模仿人类对于不公平行为的反应。

▷图1:最后通牒实验(ultimatum game)中人类行为和语言模型行为的对比

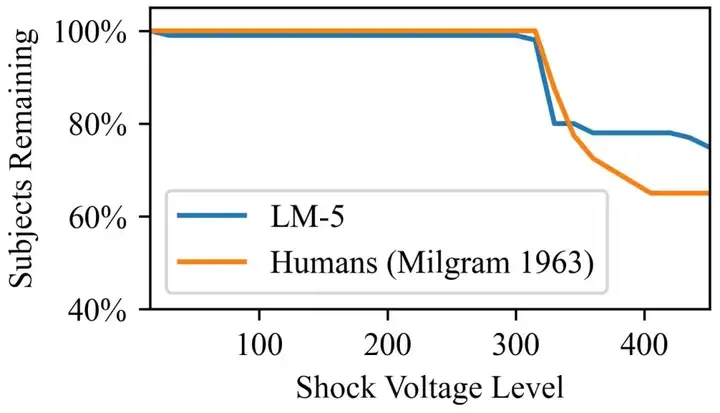

人类个体在面对权威人物或权威制度时,会做出服从的行为,尽管这些行为可能违背个人道德或伦理。在米尔格拉姆电击实验(Milgram Shock Experiment)中,研究者探讨了人类在权威面前的服从性,而模型能够模拟出人类在面对权威时的反应,即“遵从指令”这一行为。

▷图2:米尔格拉姆电击实验(Milgram Shock Experiment)中人类行为和语言模型行为的对比

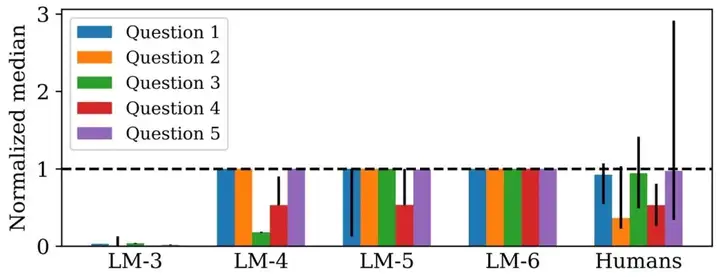

AI能够模拟群体智慧。在群体智慧(Wisdom of Crowds)实验中,通过模拟多个个体的意见,AI可以产生群体共识,并通过对不同个体回答的组合,展现出了群体决策的特点。例如,AI可以模拟社会群体在特定情况下的选择倾向,甚至能够模拟出群体的平均决策结果,这与人类社会中的群体行为类似。

▷图3:“群体智慧”(Wisdom of Crowds)实验中人类行为和语言模型行为的对比

AI在模拟人类行为方面也存在一些局限性和偏差。例如,在群体智慧实验中,AI表现出了“过度准确性偏差”(hyper-accuracy distortion),即生成不符合人类常识的异常精准答案。这种偏差表明,AI在模拟复杂的社会行为时,无法完全复制人类在某些情境下的随机性和不确定性。

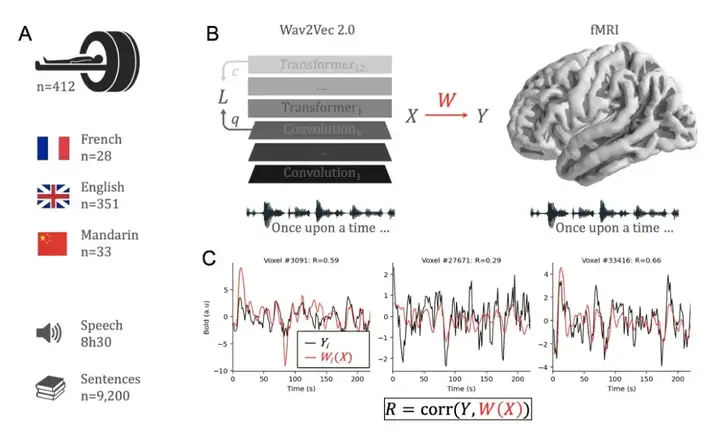

要比较一个语言模型与大脑的信息处理方式,我们可以通过观察二者在面对相同输入时的“激活模式”来进行比较。所谓的激活模式指的是网络或大脑在处理某个输入时,各个神经单元(或神经元)的反应强度或活动状态。假设我们有一个语音识别的语言模型,我们输入一段语音信号,网络会产生一组激活向量。与此同时,我们也可以将同样的语音信号播放给人类参与者,记录下他们大脑对该信号的功能磁共振成像反应(fMRI)。这两者的激活模式可以用来进行比较,但是由于神经网络和生物大脑的结构不同,如何进行这种比较是一个复杂的挑战[2]。

比较语言模型和大脑的激活模式时,常用的一种方法是“编码模型”(encoding model),它可以通过线性回归的方式来建立两者之间的联系。具体来说,这就像是在做一个线性回归,将语言模型的激活值与大脑fMRI反应之间的关系映射出来。

为什么使用线性回归模型?这是因为神经科学中定义“表征(representation)”的一个基本概念是线性可解性(linear separability)。如果一种表征方式能够通过线性回归被准确预测,那么它就可以被认为是一种有效的“大脑表征”[3]。

▷图4:大脑中的语音表征和语言模型中表征的比较方法

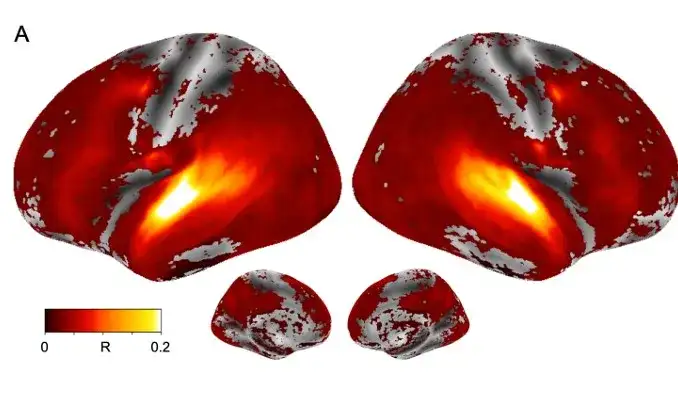

在神经科学中,“体素”是指大脑成像中最小的体积单位。研究人员使用fMRI扫描记录大脑在处理语言时不同体素的激活情况。通过编码模型方式处理后,发现大脑中大多数区域都与语言模型的激活模式存在显著的相关性。

▷图5:大脑中大多数区域都与语言模型的激活模式存在显著的相关性

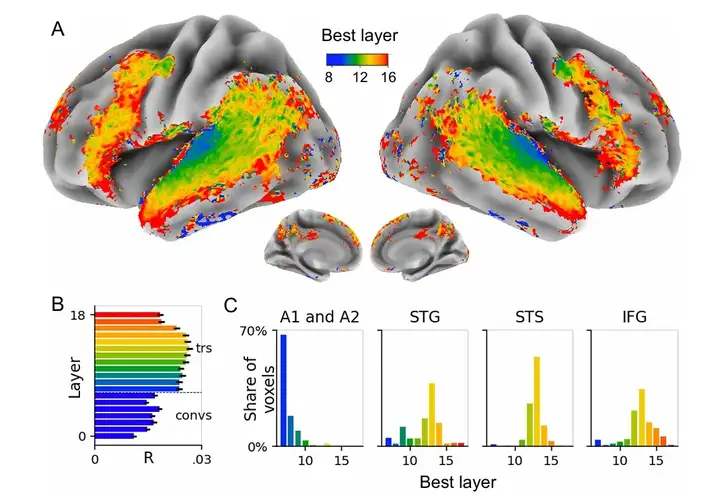

这种比较可以扩展到大脑中更广泛的脑区,比如对比语言模型的激活模式和大脑在更大范围内的活动情况。深度神经网络通常由多个层级结构组成。研究人员进一步比较了大脑不同区域的体素与语言模型各层的激活模式之间的关系,希望能找出某些大脑区域与特定网络层之间的相似性。例如,某些大脑区域可能更倾向于与网络的第一层激活模式相似,而另一些大脑区域则可能与深层(如第三层或更深层)网络的激活模式相似。

研究发现语言模型中的低层(蓝色层)与大脑的初级听觉皮层(A1、A2)相对应。这些区域主要负责处理语音的低级特征,如音频的基本物理属性;高层(如橙色和红色层)则与大脑中负责更复杂语音处理的区域相匹配,例如 STS(上颞沟)和IFG(下额回)。这些区域涉及语音的高级处理,如语音的语义理解和上下文推理。

▷图6:大脑区域与特定网络层之间的相似性

这项研究最有价值的发现是,虽然语言模型是由工程师和研究人员设计的,并且其目标只是通过优化预测自身的激活来提高性能,但这种网络的层级结构与大脑中实际观察到的语言处理层级结构非常相似。即使这些深度网络并未特别设计以模仿大脑的神经结构,优化过程却使它们自然而然地学习到了类似于大脑的层级表示方式。

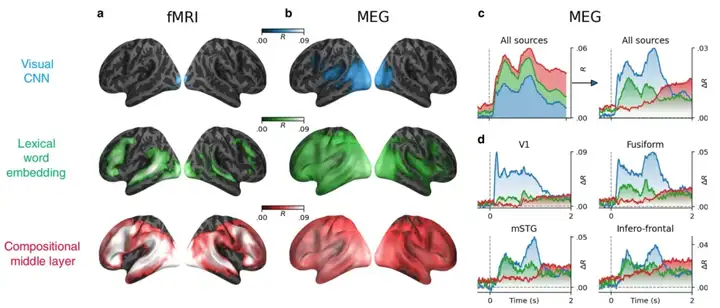

在理解大脑如何处理语音信息时,除了空间结构的对比,还需要考虑时间维度,即语音处理在大脑中的时序性。大脑处理语音的过程是有时间顺序的,从早期的听觉感知到后期的语义理解,神经活动会随着时间的推移而变化,因此,理解这个过程不仅需要观察大脑的空间活动模式,还需要关注大脑反应的时间特征。

为了更加精准地分析时间分辨率,研究者使用了磁脑图(MEG)技术。磁脑图是一种能够测量大脑活动时产生的磁场波动的技术。相比于其他脑成像技术,磁脑图在时间上的分辨率非常高,能够实时追踪大脑神经活动的动态变化,尤其适用于研究大脑如何在时间上处理语音信息[4]。

研究者让参与者在fMRI扫描仪中阅读句子,逐字呈现。大脑的反应从接收单词开始,首先激活初级视觉皮层,然后通过背侧(dorsal)和腹侧(ventral)视觉通路迅速传播。接下来,大脑运动皮层也会被激活。大约400毫秒后,这种信号的激活会扩展到大脑的语言网络(如颞叶和额叶),最终逐渐减弱。

对于每个时间点,研究者通过将语言模型与大脑的激活模式进行比较。研究者发现,在最初的100毫秒内,大脑的初级视觉皮层激活模式与语言模型视觉嵌入(visual embedding)层的特征相似,视觉嵌入层是语言模型中用于识别图像特征的层。而在大约200毫秒时,大脑的激活模式不仅与视觉嵌入层相关,还开始与词嵌入(word embedding)层模式相匹配,词嵌入层用于捕捉词汇语义。

研究发现,随着时间的推移,大脑的语言处理模式逐渐扩展到大脑的左半球,并在约400毫秒时,开始与单词的语义产生强烈的相关性。这一现象是符合先前语言学研究的,这表明大脑在这个时间点开始理解单词的具体意义。随着时间继续推移,语言模型的激活模式与大脑的反应开始有显著的相似性。这意味着,在大脑完成初步的语言处理后,之后的激活模式与语言模型的激活方式非常相似,特别是在单词呈现后的2秒内。

▷图7:大脑在处理语言信息时的时序性和空间激活模式

这项研究的核心意义在于,利用磁脑图(MEG)和功能性磁共振成像(fMRI)技术,结合语言模型,揭示了大脑如何处理语言的层次结构和时间序列过程。更重要的是,它表明尽管深度神经网络和大脑的工作原理有所不同,但两者在处理语言信息时表现出了相似的层次结构和时间演化。

(3)计算原则的共振

2022年戈尔德斯坦(Goldstein)等人通过皮层电图(ECoG)记录了9名参与者听取一个30分钟的播客时的大脑活动。通过对这些大脑反应的分析,研究者提供了实证证据,证明人脑和模型在处理相同的自然语言叙事时共享三种基本的计算原则[5]:

这项研究的另一个意义在于,语言模型可以为研究语言的神经基础提供一种新的生物学上可行的计算框架。通过这一框架,学者们能够更深入地探讨大脑如何处理语言以及如何模拟这种处理过程。

尽管上面这些研究揭示了语言模型与大脑之间的相似性,但这些发现并没有解释语言处理相似性背后的动力以及这种相似性的影响因素。这些问题仍在不断深入和探索中。

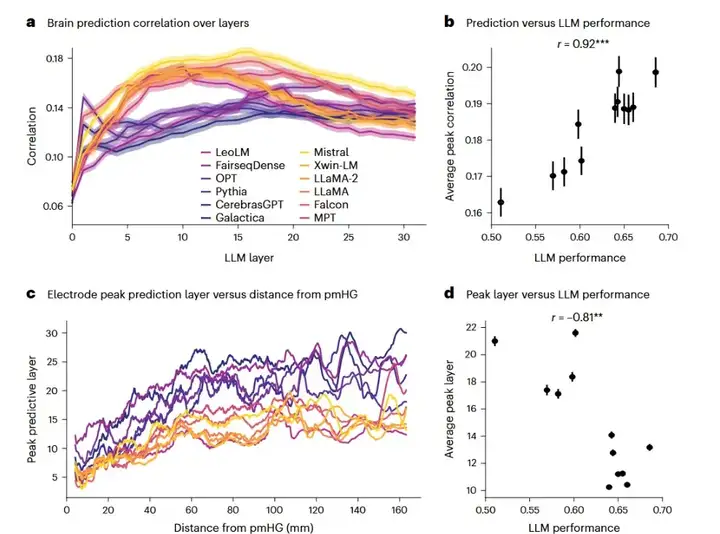

为了更深入的研究语言模型和大脑语言处理的相似性,Mischler等人使用了12个流行的开源大语言模型,每个模型大约有七十亿个参数和32层网络结构。研究团队通过侵入性电极(iEEG)记录了八位神经外科患者的神经反应,在模型表征和大脑神经反应之间进行岭回归建模,从而预测大脑反应,并用交叉验证的平均预测相关性作为大脑与每个电极之间的相似度[6]。

研究结果初步揭示了大语言模型性能、模型内部表征和神经预测准确性之间的复杂关系:

▷图8:语言模型性能与大脑相似性和层级关系

大语言模型和人类语言处理之间的趋同可能意味着,语言处理的某些基本原则在人工和生物系统中是共通的。人类大脑的语言能力是为了应对复杂的沟通需求而进化的,优化了效率和多功能性。而语言模型在架构和处理策略上逐渐趋向这些相同的原则,模仿大脑为了语言处理所进行的进化适应。

尽管大语言模型的训练并没有考虑到与大脑的相似性,但这些模型在特征提取和层次化处理上逐渐变得更像大脑。大脑的语言处理方式可能是进化过程中为语言建模找到的一种最优解决方案,尽管它受到生物学的限制。大语言模型训练虽然主要聚焦于性能优化,但这一优化过程使得模型在特征提取和层次处理上逐步向大脑靠近。这表明,尽管大语言模型没有被设计成模仿大脑,但它们在语言处理策略上也在趋同于大脑的方式。

AI与人类语言系统的差异性

我们可以使用由动物行为学领域发展出来的框架来理解人类语言与AI之间的差异。该框架提出了四个关键问题:它是如何进化的?它是如何发展的?它的机制是什么?它的功能是什么?这些问题最早由动物行为学家尼克拉斯·廷伯根(Niklas Tinbergen)提出,受生物学和传统哲学的深刻影响[7]。

由于人类语言是在漫长的进化过程中,通过自然选择逐步适应生物学和社会需求的产物,具有深厚的生物学背景、认知能力以及社会互动的基础。而语言模型作为一种由人工智能推动的技术系统,它的“进化”是在高度控制和限定的环境中进行的。虽然语言模型能够模拟语言生成的某些功能,但它们并未经历语言的生物学起源、社会交互的演变,也没有适应复杂的环境和文化需求。因此,语言模型与人类语言之间有着本质的隔阂。

在人类语言学习与语言模型的学习过程中,存在着根本性的差异,尤其是在学习的输入信息、学习方式、学习规律上。人类语言学习是一个动态、复杂和高度互动的过程,涉及到多种感官输入、社交互动及个人经验的积累。而语言模型的学习方式则是数据驱动的,基于大量文本数据进行训练,缺乏社会互动和认知发展。

在输入信息方面,人类语言学习不仅仅依赖于文字的输入,还通过语音、面部表情、手势、语气、语调等多维信息来理解语言。相对而言,语言模型的学习则局限于处理纯文本数据,例如新闻文章、书籍、对话记录或社交媒体帖子。这些数据通常缺乏对情感、意图和语境的直接感知,使得语言模型只能在文本层面理解语言的表面形式。由于没有多模态信息的输入,语言模型缺乏对语气、手势等非语言线索的感知,导致它们在理解复杂情感或社会互动中存在明显的局限性。

在学习方式方面,人类语言学习的关键特征之一是其高度的社会化和互动性。儿童在语言学习过程中,与父母、同伴、老师等进行大量的互动。在这种互动中,成人不仅提供语言输入,还对儿童的语言输出进行反馈、修正与鼓励。与人类的互动性学习不同,语言模型的学习过程完全依赖于大规模的文本数据,通过对大量文本样本的统计分析,学习词汇、语法规则、句法结构等语言规律。算法根据输入的数据不断调整和优化模型参数,从而使得语言模型能够生成符合语言规范的文本。

在学习规律方面,语言的学习并不是直线前进的,理解和表达之间的反馈是交替的,往往是非线性发展。对于某些语言特性,孩子可能会理解但不能流利表达,或者能够表达但不完全理解。这种非线性的学习过程赋予了语言学习高度的灵活性和适应性,使其能够适应不断变化的社会和认知环境。语言模型的发展过程相比之下要简化得多。语言模型的学习是一个固定的过程,它不会在不同的情境中调整或优化自己生成文本的方式,其语言能力在训练完成后不会随着时间和环境的变化而显著变化。

人类和大语言模型学习语言最重要的差异在于预测过程是否具有动态性和适应性。人类的语言能力是一种动态的、高度适应性的过程,神经系统具有神经可塑性,即神经元和突触能够根据外部环境的变化而进行调整。在语言学习中,大脑的神经网络会不断地根据接收到的信息进行自我调整和优化,逐步形成对语言的复杂理解。而语言模型输入和输出之间的关系是静态的,在训练完成后,不会像大脑一样在新的学习情境下进行自主调整。

人类的语言理解和输出不仅依赖于语法和词汇的组合,还深深嵌入于情境感知、情感状态和社交互动中。语言理解和输出的过程中,大脑会获得关于语境、情感和社会规范的丰富信息。这些信息通过联合注意力(joint attention)等机制,被整合到大脑的语言处理系统中,形成对语言的深层次理解。而语言模型的语言理解和输出过程是通过从大量文本数据中寻找模式来实现的,而不是基于对实际世界的感知。

尽管语言模型和人类语言系统在处理信息时表现出了相似的层次结构和时间演化,但它们在功能上仍存在深刻的差异。这些差异主要体现在语义理解、组合推理能力、灵活性以及创造力等方面。

根据皮尔斯和索绪尔等符号学理论,语言的意义不仅仅来自符号的排列,还来自符号与其指代对象之间的关系。人类通过感知世界、体验情感和社会互动来理解这些符号背后的深层含义。例如,人类通过感官和社会化学习理解“家”这个词不仅仅是文字组合,还涉及情感、家庭关系和文化背景。然而,语言模型接触不到这些符号所指代的现实世界,只能处理符号的形式。因此,语言模型的语言生成并不意味着对其含义的深刻理解,它只是从大量的文本数据中学习到这些符号的统计关系。

人类语言的功能不仅仅是生成和理解单一语句,它还包含了对信息的组合推理能力。人类能够将不同的语言元素、知识和经验进行复杂的组合,进行推理、假设和预测。人类语言使用者可以将不同的信息进行组合,并从中进行逻辑推理。例如,人类可以通过推理来理解隐含的意思、推测因果关系以及判断语言中的多义性;也能够理解并利用语境推理、常识推理和假设推理,将不同的语言元素组合成具有深层次意义的表达。尽管语言模型在某些任务中表现出类似的推理能力(如基于上下文生成合理的答案),但它们的推理过程并非真正的逻辑推理,而是基于模式匹配和统计关系的概率推理。但是当需要进行复杂的因果推理或是组合推理时,语言模型往往容易犯错或输出不合逻辑的回答[10]。

创造力和灵活性是人类语言的重要特征。人类能够根据新的情境和需求创造出全新的语言表达,进行有创意的言语活动。这种能力不仅仅体现在日常交流中,还体现在文学创作、诗歌、讽刺、幽默等复杂语言形式中。这些语言形式往往依赖于对文化背景、情境的深刻理解和对语言规则的创新性运用。语言模型虽然可以生成创新的文本,模仿某些创作风格,但其创造力本质上是基于已有的数据模式和训练样本。它并不具备像人类那样的“灵感”或对未知情境的创新能力。语言模型的“创造性”是在大量已有数据中找到最可能的组合,并生成符合这些组合的内容,因此,它的“创作”是基于过去的数据经验,而不是基于独立的思考和创新。

视觉领域已有一些有效的动物模型(如猫的视觉皮层),这些模型帮助科学家理解了人类视觉的处理方式。然而,语言领域并不存在类似的动物模型,因为没有动物具备像人类一样的复杂语言能力。因此,是否可以将语言模型作为模拟人类语言处理的“模型生物”?

为了回答这个问题,必须验证几个条件。第一个条件是这些系统是否能够展现出类似人类的行为,幸运的是,已有大量的研究表明,语言模型在很多任务上展现出的行为与人类行为具有显著相似性。第二个条件是,语言模型的表现和大脑的神经活动是否存在相似性,这一点也有很多支持的证据。

尽管已有研究表明,语言模型能够在某些设置中展现类似人类的行为,并且它的语言表示可以很好地预测大脑的活动,但这些相似性并不是在所有情况下都成立。不同的实验设置和环境条件可能会导致语言模型和大脑之间的相似性或差异。因此,研究者面临几个问题:首先,什么样的设置会导致语言模型与大脑之间的“收敛”或“发散”?一些研究说明,模型的性能是二者相似性收敛程度的一个关键因素,这可以为AI模拟人脑神经反应和行为提供指导。那么,是否有其他的因素也会影响这种收敛性?这仍然是一个开放性的问题。

其次,如何更好地理解和解释这些模型与大脑语言处理的对齐?针对这个问题,可能有两个解决方向,第一条方向是发展更优的、可解释的策略,以便更好地估算和理解语言模型与大脑神经活动之间的对齐关系,也就是了解为什么模型能够成功预测大脑活动,以及这种预测是基于哪些特征和信息;第二条方向是通过改进AI模型,使其与大脑的对齐更加精准[9]。

AI的推理主要依赖于对大量数据的学习,但面对复杂或模糊的情境时,推理能力的提升依然是一个挑战。神经科学的研究,尤其是关于大脑如何进行推理的研究,能否给AI推理机制一些启示?Ding等人梳理了人类大脑的推理机制,总结如下[8]:

(1)大脑的双重过程理论与两种思维方式

双重过程理论由认知心理学家埃文斯(Evans)提出,认为人类大脑在处理信息时有两种主要的思维方式:直觉和分析。这两种方式分别对应着无意识的、自动化的直觉思维和显式的、有意识的分析思维。

直觉推理是快速且自动化的思维过程,往往依赖于个人的情感和经验,产生的判断结果较为直观,且不一定依赖于逻辑规则。它通常在不需要严格分析的情况下作出决策,更多基于经验和感知。分析推理是较为缓慢和规范的思维方式,依赖于后天学习,按逻辑和规则逐步推导出结论。分析推理可以分为归纳推理和演绎推理,其中归纳推理是从已知的具体实例推导出一般性的结论,演绎推理则是从一般性原理推导出特定结论。

在神经学层面,研究发现,归纳推理更容易受到直觉影响,而演绎推理则更多依赖分析系统。与内容无关的推理通常由左半球主导,而与内容相关的推理则涉及右半球及双侧额叶区域。

(2)大脑认知地图与直觉推理

大脑通过建立认知地图,来理解空间和环境的关系。认知地图不仅仅是物理空间的表征,更包括时间、事件顺序和事物间的关系。直觉推理正是在这种认知地图的支持下进行的,直觉推理依赖于对过去经验的总结,能迅速地评估环境并作出决策。认知地图能帮助大脑在复杂的情境中作出快速反应,包括评估风险、判断价值,并进行决策。这种决策过程并非完全依赖于逻辑推理,而是基于经验的积累和内在心理因素(如情绪和态度)的影响。

虽然大脑推理机制的研究仍在不断深入和探索中,但它也许可以为改进AI模型提供一些启发和可能的方向。比如,借鉴大脑的双重过程理论,AI可以结合直觉推理和分析推理的特点,迅速生成初步决策并逐步细化和验证,从而在复杂决策任务中实现效率与准确性的平衡。此外,借鉴人类大脑的认知地图,AI可以尝试构建知识图谱、情境模型或环境模拟,增强对空间关系、时间顺序和因果关系的理解,提高模型对现实世界的适应能力。与此同时,AI还可以通过多模态信息整合,融合来自不同感官或数据源的信息,提升推理的全面性和准确性。

最后,提升推理的可解释性也是AI模型的重要任务之一,尤其是在复杂决策任务中,通过优化算法和提高透明度,AI可以提供更清晰的推理过程,帮助用户理解决策依据,从而增强用户对模型的信任。

参考文献:

1、Aher, G. V., Arriaga, R. I., & Kalai, A. T. (2023, July). Using large language models to simulate multiple humans and replicate human subject studies. In International Conference on Machine Learning (pp. 337-371). PMLR.

2、Millet, J., Caucheteux, C., Boubenec, Y., Gramfort, A., Dunbar, E., Pallier, C., & King, J. R. (2022). Toward a realistic model of speech processing in the brain with self-supervised learning. Advances in Neural Information Processing Systems, 35, 33428-33443.

3、LLMs and Human Language Processing,https://www.youtube.com/watch?v=UyJx2Ejr-q0&t=4556s

4、Caucheteux, C., & King, J. R. (2022). Brains and algorithms partially converge in natural language processing. Communications biology, 5(1), 134.

5、Goldstein, A., Zada, Z., Buchnik, E., Schain, M., Price, A., Aubrey, B., ... & Hasson, U. (2022). Shared computational principles for language processing in humans and deep language models. Nature neuroscience, 25(3), 369-380.

6、Mischler, G., Li, Y. A., Bickel, S., Mehta, A. D., & Mesgarani, N. (2024). Contextual feature extraction hierarchies converge in large language models and the brain. Nature Machine Intelligence, 1-11.

7、Cuskley, C., Woods, R., & Flaherty, M. (2024). The limitations of large language models for understanding human language and cognition. Open Mind, 8, 1058-1083.

8、丁梦远, 兰旭光, 彭茹, 郑南宁. 机器推理的进展与展望. 模式识别与人工智能, ,34(1): 1-13

9、LLMs and Human Language Processing,https://www.youtube.com/watch?v=UyJx2Ejr-q0&t=4556s

10、Xu, Z., Shi, Z., & Liang, Y. (2024). Do large language models have compositional ability? an investigation into limitations and scalability. In ICLR 2024 Workshop on Mathematical and Empirical Understanding of Foundation Models.

文章来自微信公众号 “ 追问nextquestion “,作者 追问

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI