推理大语言模型(LLM),如 OpenAI 的 o1 系列、Google 的 Gemini、DeepSeek 和 Qwen-QwQ 等,通过模拟人类推理过程,在多个专业领域已超越人类专家,并通过延长推理时间提高准确性。推理模型的核心技术包括强化学习(Reinforcement Learning)和推理规模(Inference scaling)。

主流的大模型强化学习算法,如 DPO、PPO、GRPO 等,通常需要在完整的思维链上进行微调,需要高质量数据、精确的奖励函数、快速反馈和在线迭代、以及大量的算力。当处理复杂任务,如高级数学和编程问题时,模型需要更细粒度的搜索、更精确的推理步骤和更长的思维链,导致状态空间和策略空间的规模急剧扩大,难度大幅上升。

Inference scaling 策略,不依赖训练,通过延长推理时间进一步提高模型的 Reasoning 能力。常见方法,如 Best-of-N 或者蒙特卡洛树搜索(MCTS),允许 LLM 同时探索多条推理路径,扩大搜索空间,朝着更有希望的方向前进。这些方法计算成本高,特别是步骤多或搜索空间大的时候。采样随机性使得确定最佳路径困难,且依赖手动设计的搜索策略和奖励函数,限制了泛化能力。

在此背景下,普林斯顿大学团队联合北京大学团队合作开发了名为 ReasonFlux 的多层次(Hierarchical)LLM 推理框架。

(该论文作者特别声明:本工作没有蒸馏或用任何方式使用 DeepSeek R1。)

基于层次化强化学习(Hierachical Reinforcement Learning)思想,ReasonFlux 提出了一种更高效且通用的大模型推理范式,它具有以下特点:

ReasonFlux-32B 在多个数学推理基准测试中表现出色,仅仅用了 500 个基于不同数学知识点的思维模版,就展现了其强大的推理能力和跻身第一梯队的实力。

ReasonFlux 的性能提升得益于其三大核心技术:

(a)推理示例对比:

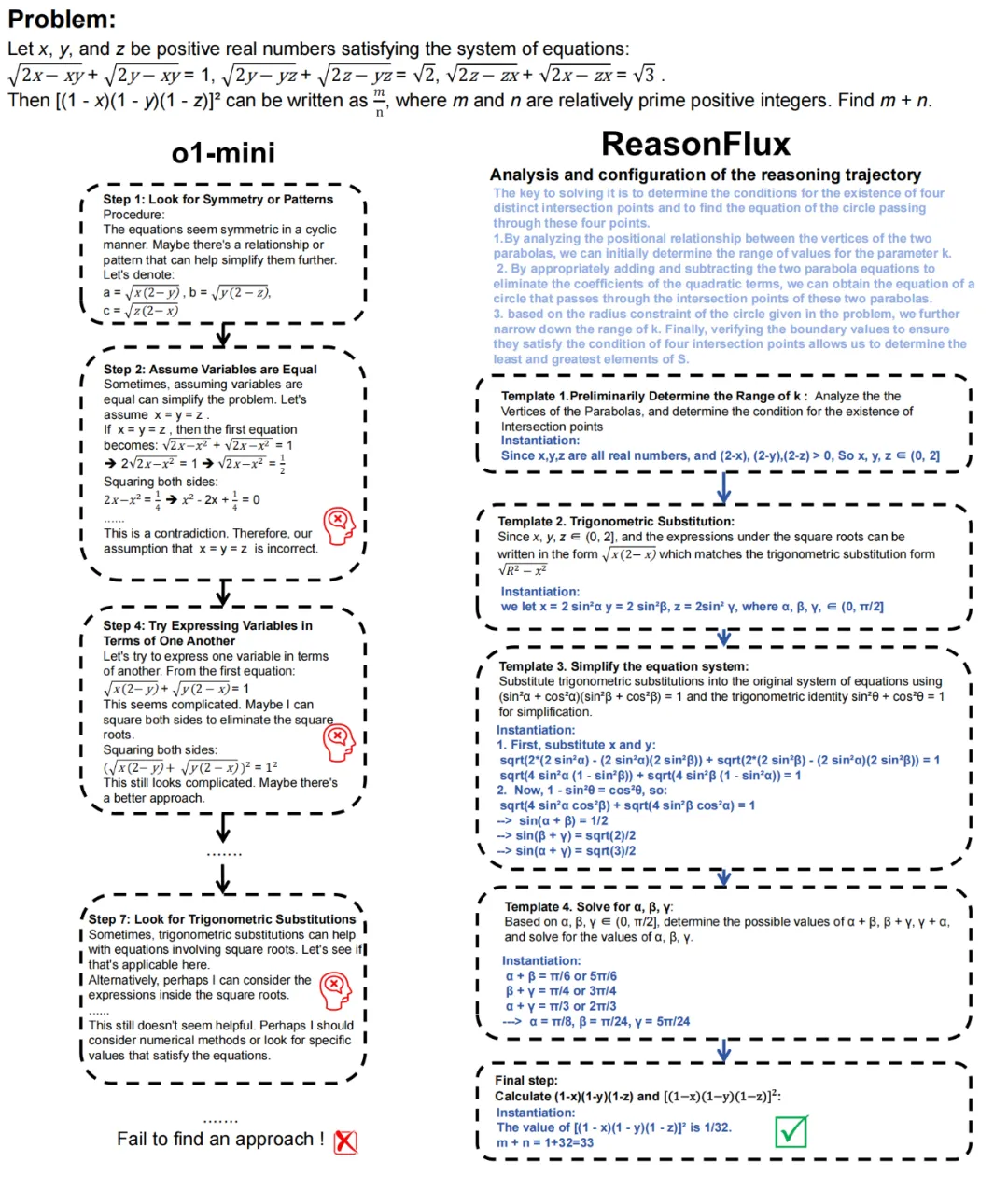

接下来我们来分析 ReasonFlux 在解决实际问题上相较于 o1-mini 的对比。

我们来看和 o1-mini 的对比

如上图可知,o1-mini 在面对这道难题时,尝试了多种策略,但均未能找到有效的突破口。它首先试图通过引入新变量和利用对称性来简化方程组,但收效甚微;接着又尝试假设变量相等来寻找特解,结果却得出了矛盾;随后,它试图用一个变量表示其他变量,并尝试平方去根号,但复杂的表达式使其望而却步;最后,它甚至想到了三角换元,但由于未能正确应用,最终只能无奈地放弃求解。

相比之下,ReasonFlux 的解题过程如下:

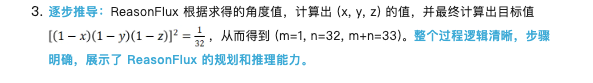

(b) 新的 inference scaling law:

如上图所示,随着问题复杂度的增加,ReasonFlux 正确解答问题时所需的模板数量和交互轮数也相应增加。这表明 ReasonFlux 能够根据问题的难度动态调整推理策略,体现了其优秀的自适应能力。并且可以观察到,交互轮数的增长趋势略高于模板数量,这意味着规划能力的提升对解决复杂问题至关重要。

目前,提升 LLM 推理性能的主流方法通常依赖于增加模型规模和计算资源。例如,增加模型参数量、采用 Best-of-N 或蒙特卡洛树搜索 (MCTS) 等方法来扩大搜索空间以寻找更优解。然而,这些方法往往计算成本较高,且模型的推理过程难以解释。

ReasonFlux 采用了一种不同的方法,通过构建结构化的思维模板库和设计新的层次化强化学习算法,实现了一种更高效和可解释的推理方式。

传统的 Inference Scaling 方法,如 Best-of-N 和 MCTS,主要通过扩大搜索空间来提高准确率。但随着问题复杂度的增加,搜索空间呈指数级增长,导致计算成本显著上升。

ReasonFlux 通过引入结构化的思维模板,将搜索空间从 “原始解空间” 缩小到 “模板空间”,从而降低了搜索的难度和成本。如果说传统的推理范式是 “大海捞针”,那么 ReasonFlux 则是 “按图索骥”。这些模板并非简单的规则堆砌,而是经过提炼和结构化处理的知识模板,它们将复杂的推理过程分解为一系列可复用的步骤,从而提升了推理的效率和准确率。

如上图所示,随着问题难度的提升,Best-of-N 和 MCTS 的探索成本(例如采样轨迹数量和迭代次数)显著增加,而 ReasonFlux 的探索成本(交互轮数)则保持在较低水平且相对稳定。这说明 ReasonFlux 能够更高效地利用已有的知识模板来解决问题,而不需要像 Best-of-N 和 MCTS 那样进行大量的试错和探索。这得益于 ReasonFlux 的结构化模板库和模板轨迹规划机制,使其能够在更小的搜索空间内找到正确的推理路径。

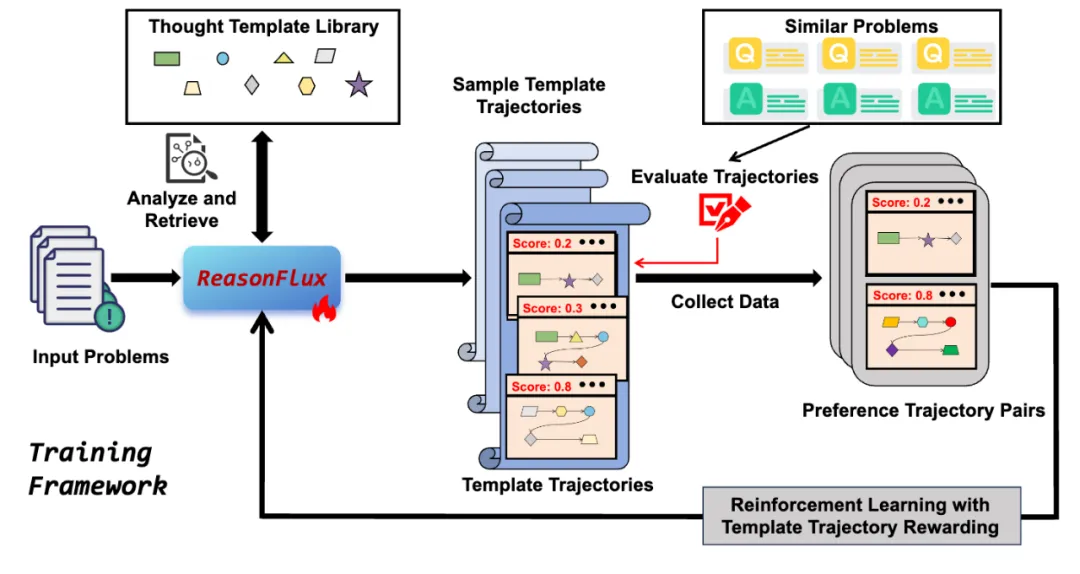

下图展示了 ReasonFlux 的训练框架,其核心在于利用结构化的思维模板库和基于思维模板轨迹奖励的层次化强化学习算法,训练出一个能够进行高效推理的大模型。整个训练过程可以分为两个主要阶段:结构化知识学习和思维模板轨迹优化。

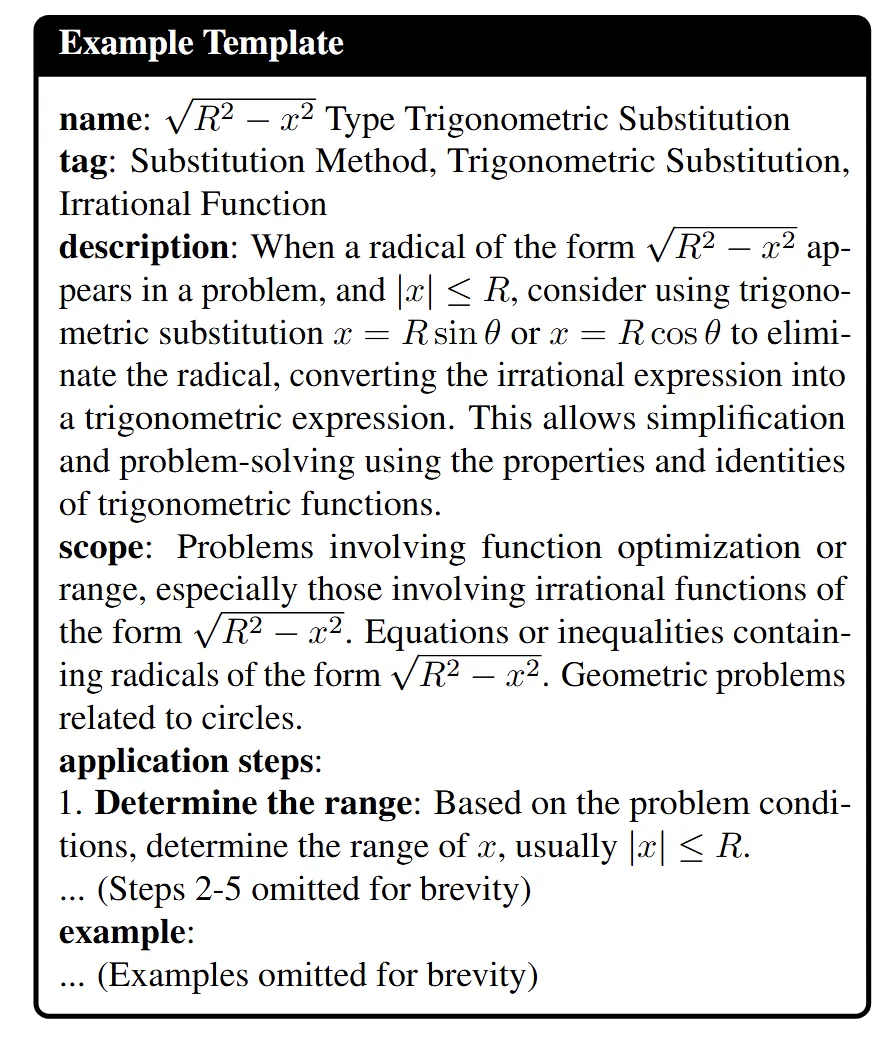

1. 结构化知识学习阶段:这个阶段的目标是让模型学习思维模板库中蕴含的结构化知识。这些结构化的 Thought template 格式如下图所示:

通过这两个阶段的训练,ReasonFlux 模型不仅学习到了结构化的模板知识,还学会了如何针对特定问题选择和组合模板,形成有效的推理路径。这种能力使得 ReasonFlux 能够高效地解决各种复杂的数学推理问题。

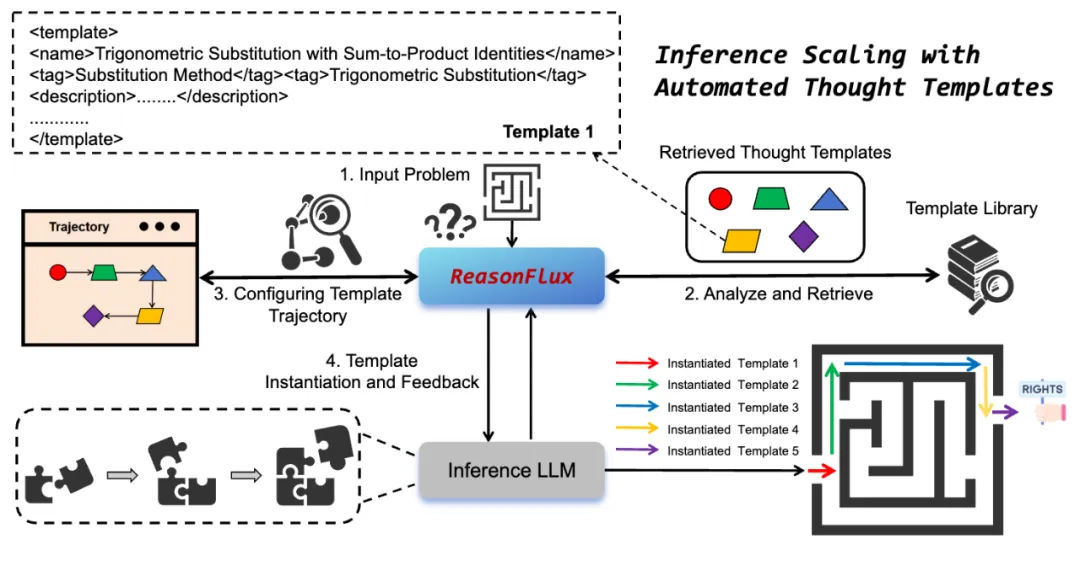

下图是 ReasonFlux 的推理框架。其核心在于 navigator、inference LLM 和结构化模板库之间的多轮交互。这种交互机制使得 ReasonFlux 能够根据问题的具体情况灵活调整推理策略,从而提高推理的准确性和效率。

以下是 ReasonFlux 的推理流程:

通过这种 navigator 引导、inference LLM 执行、模板库支持、动态调整轨迹的多轮交互机制,ReasonFlux 能够高效地解决各种复杂的数学推理问题。这种推理框架不仅提高了推理的准确性和效率,还增强了模型的可解释性,因为我们可以清晰地追踪模型的推理过程和依据。

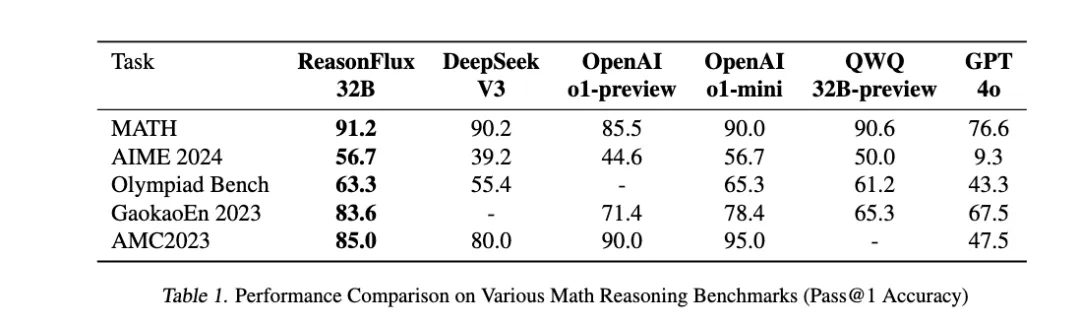

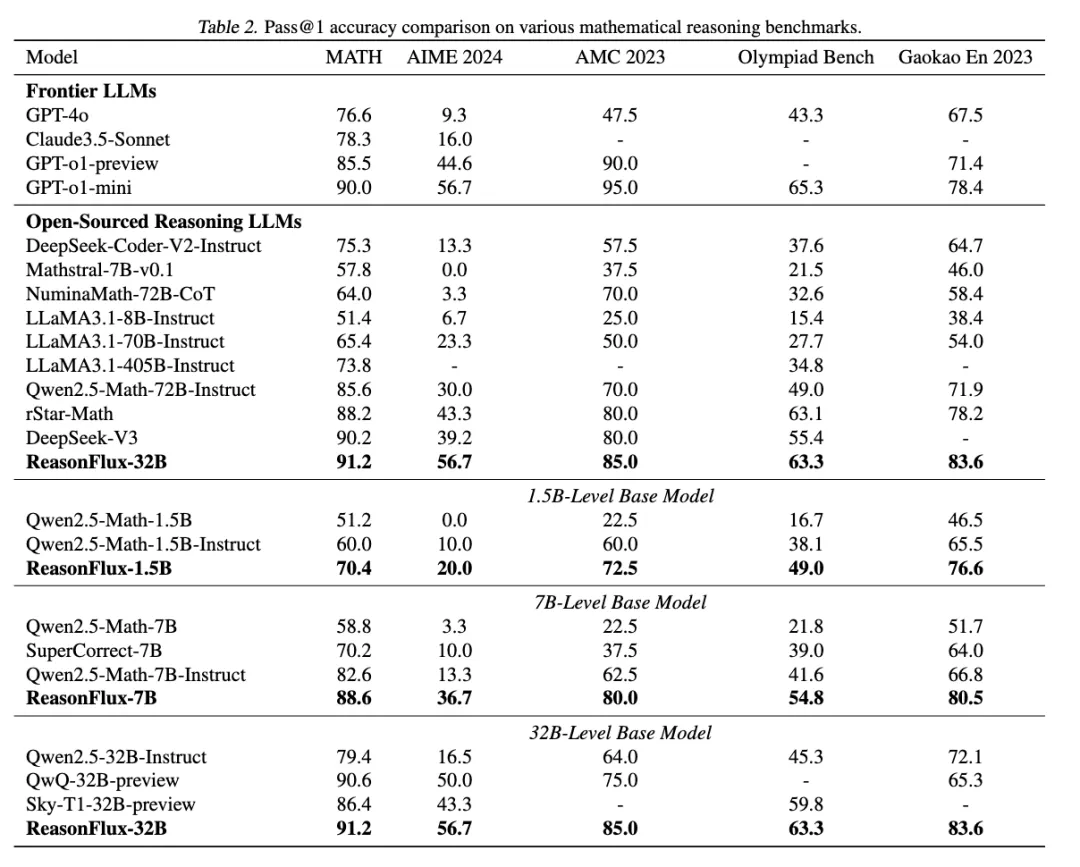

ReasonFlux 在 MATH、AIME 2024、AMC 2023、OlympiadBench 和 Gaokao En 2023 等多个具有挑战性的数学推理数据集上进行了测试,并取得了良好的结果。

ReasonFlux-32B 在这些数据集上的表现处于前列,与其他先进模型相比具有竞争力。如下表所示,在 MATH 数据集上,ReasonFlux-32B 的准确率为 91.2%;在 AIME 2024 数据集上,ReasonFlux-32B 的准确率为 56.7%。这些结果表明 ReasonFlux 框架具有有效性。更重要的是,它表明较小规模的模型通过优化推理框架,可以达到甚至在某些情况下超越较大模型的性能。

ReasonFlux 还可用于不同大小(1.5B, 7B 和 32B)的基础模型,并且都能获得巨幅的推理效果提升,足见其通用性和泛化性。

ReasonFlux 的成功不仅限于数学推理领域,其背后的核心思想 —— 结构化思维模板和模板轨迹 —— 具有广泛的应用潜力。未来,ReasonFlux 有潜力被应用于更多领域,如代码生成,医疗诊断,具身智能等多个领域。

杨灵:北大在读博士,普林斯顿高级研究助理,研究领域为大语言模型和扩散模型。

余昭辰:新加坡国立大学在读硕士,北京大学 PKU-DAIR 实验室科研助理,研究领域为大语言模型和扩散模型。

崔斌教授:崔斌现为北京大学计算机学院博雅特聘教授、博士生导师,担任计算机学院副院长、数据科学与工程研究所所长。他的研究方向包括数据库系统、大数据管理与分析、机器学习 / 深度学习系统等。

王梦迪教授:王梦迪现任普林斯顿大学电子与计算机工程系终身教授,并创立并担任普林斯顿大学 “AI for Accelerated Invention” 中心的首任主任。她的研究领域涵盖强化学习、可控大模型、优化学习理论以及 AI for Science 等多个方向。

文章来自微信公众号 “ 机器之心 ”

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【部分开源免费】FLUX是由Black Forest Labs开发的一个文生图和图生图的AI绘图项目,该团队为前SD成员构成。该项目是目前效果最好的文生图开源项目,效果堪比midjourney。

项目地址:https://github.com/black-forest-labs/flux

在线使用:https://fluximg.com/zh

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner