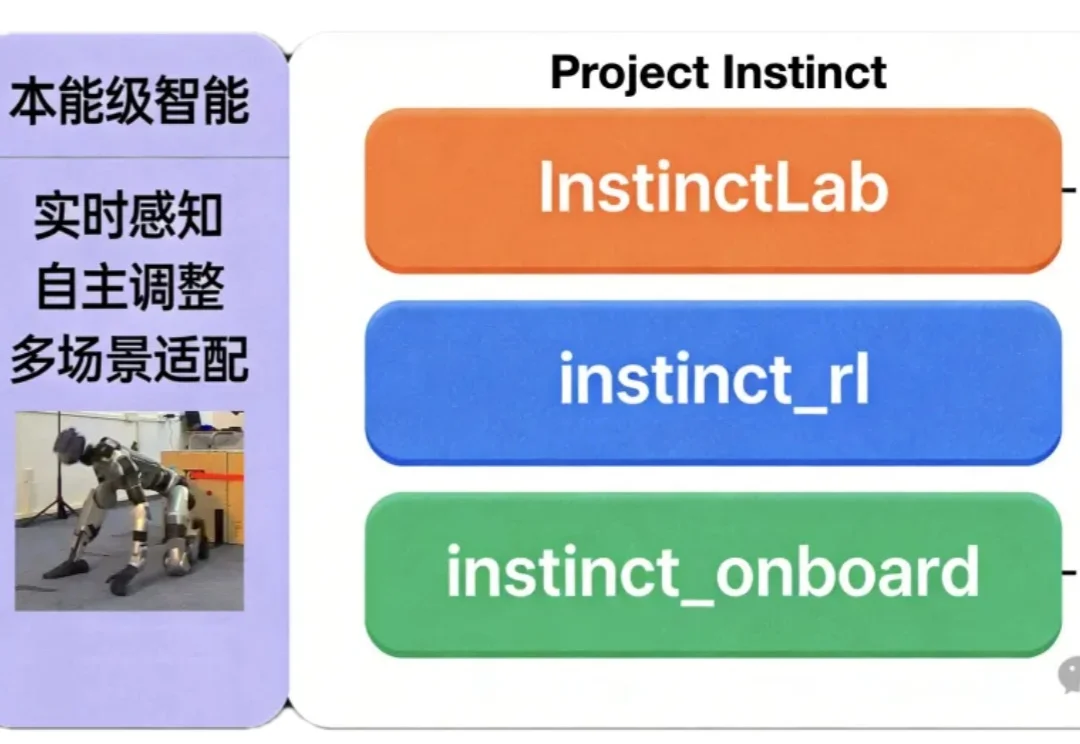

让机器人拥有本能反应!清华开源:一套代码实现跑酷、野外徒步两大能力

让机器人拥有本能反应!清华开源:一套代码实现跑酷、野外徒步两大能力如何让机器人同时具备“本能反应”与复杂运动能力?

如何让机器人同时具备“本能反应”与复杂运动能力?

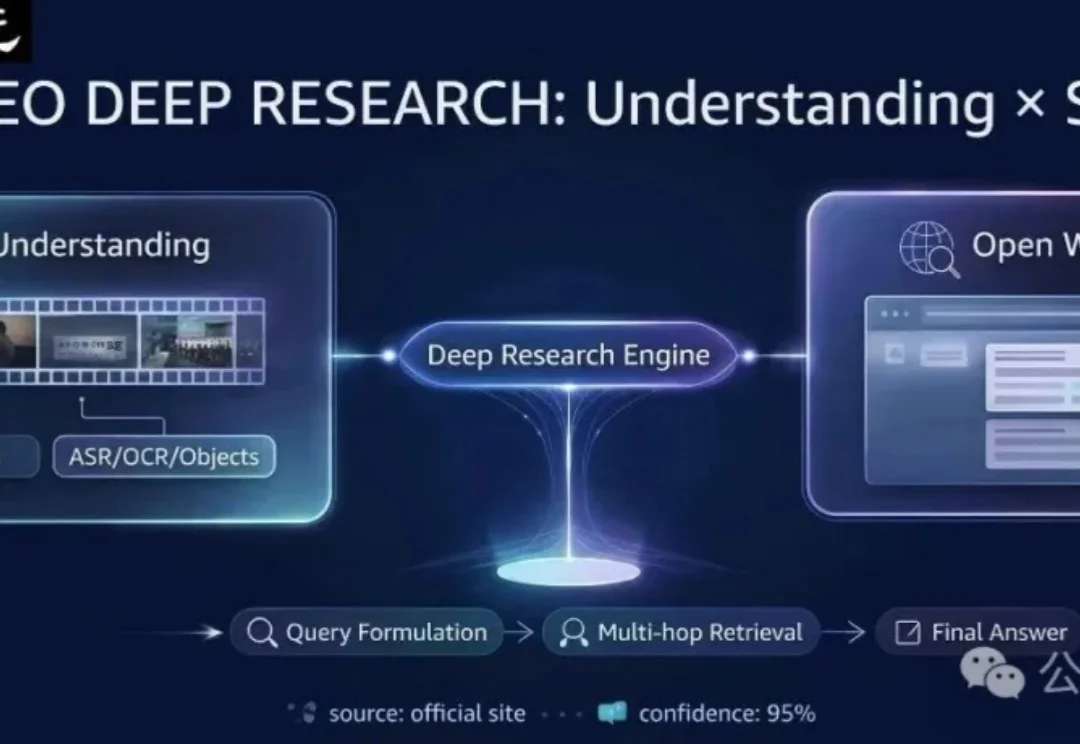

现有的多模态模型往往被困在「视频」的孤岛里——它们只能回答视频内的问题。但在真实世界中,人类解决问题往往是「看视频找线索 -> 上网搜证 -> 综合推理」。

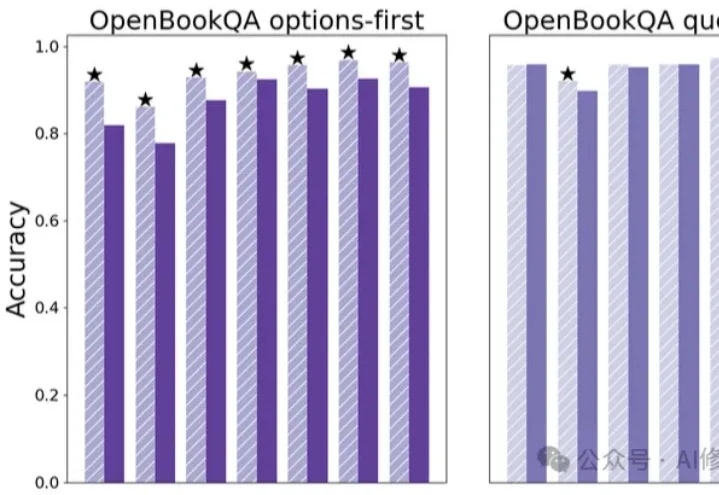

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。

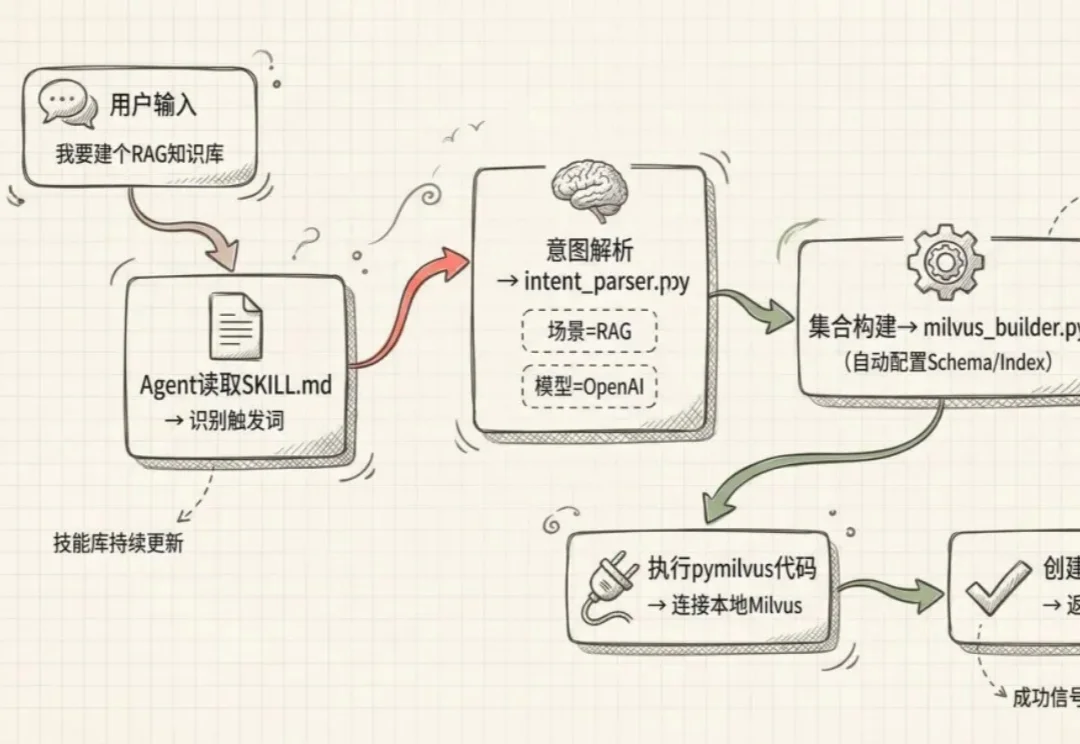

Agent很好,但要做好工具调用能才能跑得通。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

现有AI记忆评测存在局限,如数据源单一、忽视变化本质、注入成本高等。CloneMem通过层次化生成框架构建合成人生,设计贴近真实场景的评测任务,涵盖多种问题类型。

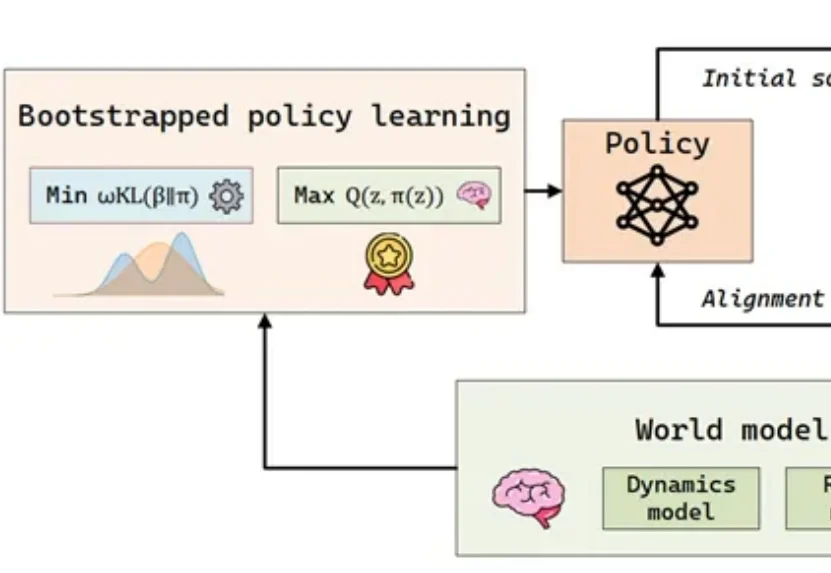

在具身智能(Embodied AI)的快速发展中,样本效率已成为制约智能体从实验室环境走向复杂开放世界的瓶颈问题。

今天的 Agent,在一个独立的、短时间任务上的表现已经很不错了。

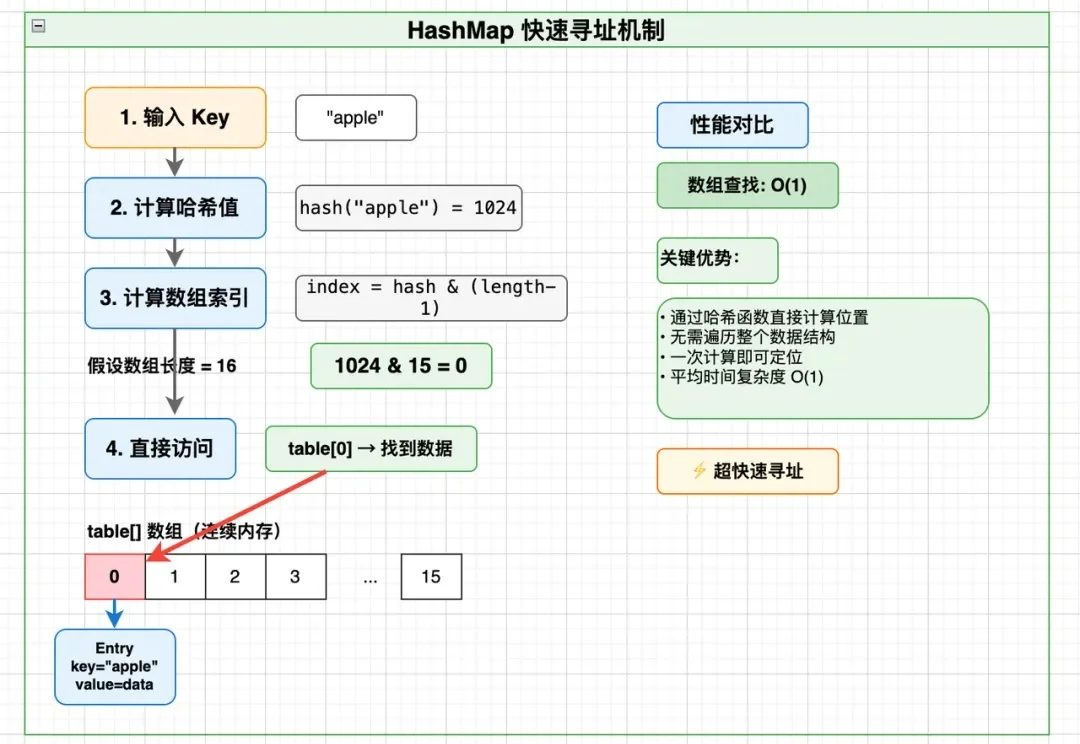

做后端、大数据、分布式存储的同学,大概率都遇到过这样的问题:

这不是一个普通的Skill,而是一把“把经验变成Skill”的工具:Claudeception是一个Meta-Skill,即专门用来“生产技能”的技能。