在AI计算资源日益稀缺的时代,Lambda凭借其独特的云GPU解决方案迅速崛起,成为资本市场的宠儿。最近,这家成立于2012年的AI云计算公司宣布完成4.8亿美元D轮融资,累计融资额达到8.63亿美元,跻身AI创投榜云科技赛道第二位,仅次于Coreweave。此次投资阵容强大,包括英伟达、AI技术大牛Andrej Karpathy,以及和硕、超微、纬创、纬颖等行业巨头的战略入股。

Lambda的愿景十分明确:通过无处不在且经济实惠的计算资源加速人类进步,实现“一人一GPU”的目标。从最初为AI研究人员提供GPU,到推出全球首个按需、自助式的云端GPU集群1-Click Clusters,Lambda始终站在AI开发者的角度思考问题。其最新产品Lambda推理API和Lambda聊天AI助手,也进一步降低了开发者使用高性能计算资源的门槛,让AI产品的构建、测试和部署变得更加高效、安全和经济。

作为AI开发云平台的领先企业,Lambda在全球范围内已吸引数十万用户,包括微软、乐天、直觉外科等知名企业,以及众多AI初创公司。此次融资的落地,使Lambda能够进一步扩展其GPU云计算基础设施,并加速英伟达H200和Blackwell B200芯片的部署。这不仅对AI开发者而言是利好消息,也意味着Lambda正在成为AI基础设施领域无法忽视的重要力量。

那么,Lambda是如何改变AI开发者的工作方式的?它的1-Click Clusters为何被誉为“AI团队期待已久的超级能力”?未来Lambda又将如何塑造AI计算市场的格局?带着这些问题,我们通过深入访谈这家明星公司的管理层,解开其成长路径与技术布局。

Lambda联合创始人兼首席执行官,Stephen Balaban。在创立Lambda之前,是Perceptio的首位雇员,开发了在iPhone GPU上本地运行的人脸识别深度神经网络。Perceptio被苹果公司收购。Stephen拥有密歇根大学计算机科学和经济学学士学位,精通中文和英语。

当然!我们主要提供AI 训练和推理的计算基础设施,包括本地工作站、服务器和云计算服务。我们的目标是让 AI 研究人员和企业能够以更高效、更具成本效益的方式进行训练。

从业务规模来看,我们的硬件销售年营收接近 2 亿美元,而云计算业务的年营收大约是 2.5 亿美元。整体来看,我们的年营收规模约为 4 亿美元,并且增长势头良好。

Lambda Labs 目前主要服务于AI 研究人员、大学实验室、大型科技公司以及初创企业。我们的 GPU 云计算平台,正在迅速成为许多 AI 公司的首选计算解决方案,因为它比 AWS 更具性价比。

我们的本地计算硬件业务始于 2017 年,最初的想法其实是出于成本考虑。当时,我们正在运营一个名叫 DreamScope 的 AI 应用,它利用风格迁移(Style Transfer) 技术来生成艺术风格的图像。

但问题是,我们的应用需要在 AWS 云计算平台上运行,而 AWS 的GPU 云实例极其昂贵,每个月的账单高达 4 万美元!对于一个创业公司来说,这是一个不可持续的支出。

于是,我们决定自己组建GPU 服务器集群。我们发现,仅仅花 6 万美元购买一批 GPU 服务器,就能彻底摆脱 AWS 的昂贵账单。很快,我们意识到,这可能是一个新的商业机会——也许有很多 AI 研究人员和公司,也在寻找更具性价比的计算资源。

所以,2017 年 3 月,我们开始向外部销售 GPU 工作站,第一个月的销售额大约是 3.5 万美元。第二个月翻倍,达到 7 万美元,第三个月又翻倍至 14 万美元。

到 2017 财年结束时,我们的硬件销售收入已经达到 300 万美元。到了 2018 年,这个数字进一步增长到 1000 万美元。可以说,一旦找到了市场需求,我们的增长速度就非常迅猛。

是的,我有一个商业直觉,那就是——如果一个产品一推出就受欢迎,那它成功的可能性就非常高;如果市场反应平淡,那可能方向需要调整。

当 Lambda Labs 开始销售 GPU 工作站时,市场的需求非常旺盛,几乎不需要花费大量精力去教育用户。这表明,我们的产品真正满足了市场的痛点。

Lambda是一家专门为AI工作负载提供GPU云计算的公司,主要聚焦在模型训练、微调和推理。如今,市场上有许多初创公司声称提供类似的GPU云服务,我对此非常欣喜,因为这证明了行业的活力和需求的增长。但Lambda与众不同的地方在于,我们成立于2012年,已经深耕这一领域多年,拥有庞大的用户群、数百名员工,并在全美设有多个办公室。

当机器学习团队评估云服务时,需要考虑到一个核心问题:大规模云计算提供商(Hyperscalers)虽然覆盖了AI计算,但他们并不专注于此。他们的业务横跨Web、移动端、通用GPU计算等各个领域,AI只是他们生态系统中的一部分。此外,还有一些二线GPU云,这些云平台虽然也提供GPU服务,但它们的重心仍然是水平化的,服务对象包括VFX(视觉特效)、渲染、计算科学等多个GPU相关领域。因此,它们的软件栈和支持团队同样是通用的,并没有专门针对AI工作负载进行深度优化。

Lambda的独特之处在于,我们专注且唯一地服务于AI训练和推理领域。我们是一个“细分领域中的细分品牌”,这使得我们能够提供高度专业化的支持,并针对AI计算打造优化的软件栈,确保训练和推理的高效性与稳定性。相比于通用云平台,我们的服务更加垂直,真正为AI团队量身定制。

我们刚开始创立Lambda时,我们的主要关注点还是卷积神经网络(CNNs)、生成对抗网络(GANs)和长短时记忆网络(LSTMs)。当时,大型语言模型(LLMs)这个概念还不存在,自然语言处理(NLP)才刚刚开始成为研究重点。从那时起,我们见证了一个巨大的转变——从处理边界框(bounding boxes)到如今能够处理数百万token上下文长度的模型,整个过程非常令人兴奋。

当时,我们与许多大型企业合作——包括保险、金融、制造业和航空航天等行业的顶尖公司。他们中的许多企业才刚刚开始组建机器学习团队,通常只有一两个研究人员,他们需要Lambda的工作站、服务器和集群来进行AI训练。我们最初主要帮助客户构建本地集群(on-premise clusters),因为当时云端GPU的采购非常昂贵,使用云GPU意味着要租用K80或V100,而相比之下,直接购买一张GPU可能更具成本效益。而且,2017/2018年的云端GPU的性能甚至不如一些消费级游戏显卡,比如1080Ti,所以许多企业更倾向于搭建自己的本地集群。

随着时间推移,AI计算需求发生了巨大变化,尤其是大型语言模型(LLMs)时代的到来。现在,像A100、H100和B200这样的高端GPU,已经成为大规模训练的核心,GPU之间的互联能力变得至关重要。相比早期的独立GPU计算,如今的模型训练更依赖于GPU集群的高效通信,以便能够支持更大规模的数据和更长的上下文窗口。

回顾当年的机器学习团队,他们不仅要学习GPU计算,还需要探索AI如何与企业的最终应用结合。很多公司在早期并不确定AI最终会如何影响他们的业务,但他们知道必须要有一个AI战略。令人惊喜的是,如今这些曾经刚刚起步的企业,已经成长为AI原生企业(AI-native enterprises),建立了庞大的机器学习团队,甚至拥有上百名AI工程师和研究人员,真正将AI深度融入业务核心。

Lambda的成长轨迹,与整个AI行业的发展息息相关。从计算机视觉时代到NLP崛起,再到生成式AI爆发,我们一直紧跟技术潮流,专注于提供最强大的GPU云计算支持。这种技术演进的过程,见证了机器学习如何从一个实验性领域,逐步成为企业战略的核心。

Lambda 一开始就专注于中型市场和企业客户,这也是我们在本地部署业务的起点,并且未来将延伸到云端。最终,我们的服务对象是需要集群 GPU 解决方案的大型企业、机器学习团队以及资金充裕的 AI 初创公司。

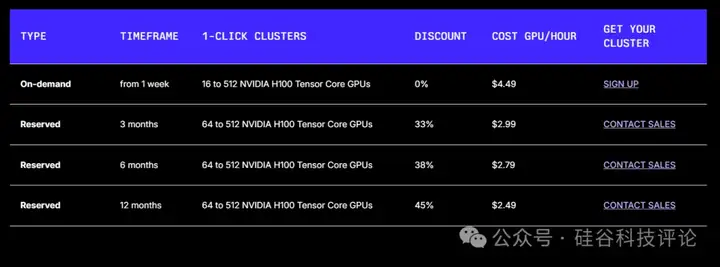

目前我们主要提供两种选择:一种是为期 1 到 3 年的预留合约,另一种是满足短期需求的即时合约,即我们所说的 1-Click Clusters。在过去 18 个月中,我们通过预留 GPU 云产品成功签下了数亿美元的合同。这些产品本质上是采用 H100 GPU 和 InfiniBand 构建的单租户集群,规模从 2000 到 12000 个互联 GPU 不等。主要的工作负载包括从零开始的预训练、对大型开源模型的微调,以及运行时间长达 30 至 90 天的大规模 YOLO 任务。

对于我们的预留 GPU 云来说,推理也是一个重要的工作负载,但仅限于那些资金雄厚、能够承受如此规模推理需求的顶级 AI 实验室。这些集群不是定制的,而是严格按照 InfiniBand 加 H100 进行构建,并整合了来自领先存储提供商的 PB 级存储。通常,从下单到完成构建需要大约 90 天的时间。

我们为机器学习团队解决的核心问题,就是 1-Click Clusters 的概念。我们希望赋予机器学习团队和企业自助接入数据中心级别 AI 计算资源的能力,无需与任何人沟通。这意味着可以按需启动一个包含 H100 和 InfiniBand 的集群,仅需数小时即可完成部署,而且租用周期可以仅为几周。例如,许多已经获得大额 A 轮融资的 AI 初创公司,往往需要等待数月才能验证他们的方案。而 1-Click Clusters 让他们在几小时内就能验证自己的想法,而无需花费 500 万至 1000 万美元去预定一到三年的大规模合约。

最后,我想补充一点:目前,我们大约每隔几个月就在云端部署价值 1 亿美元 的 AI 基础设施。这对我们来说非常令人兴奋,因为它极大地提升了云端 GPU 的流动性。Lambda 的云服务在 Twitter 上因“经常售罄”而闻名——通常,当我们上线价值 1 亿美元 的 GPU 资源时,大约 十个工作日内 就会被全部抢购一空。

现在,我们正开始以 更大规模 的方式部署 GPU——每次投放的价值将达到 数亿美元。我们的目标是让用户访问 Lambda 云时,不再看到“售罄”通知,而是始终有 充足的 GPU 资源 可供使用。1-Click Clusters 就是这个变革的开始。

文章来自微信公众号 “ 硅谷科技评论 ”,作者 svtrai