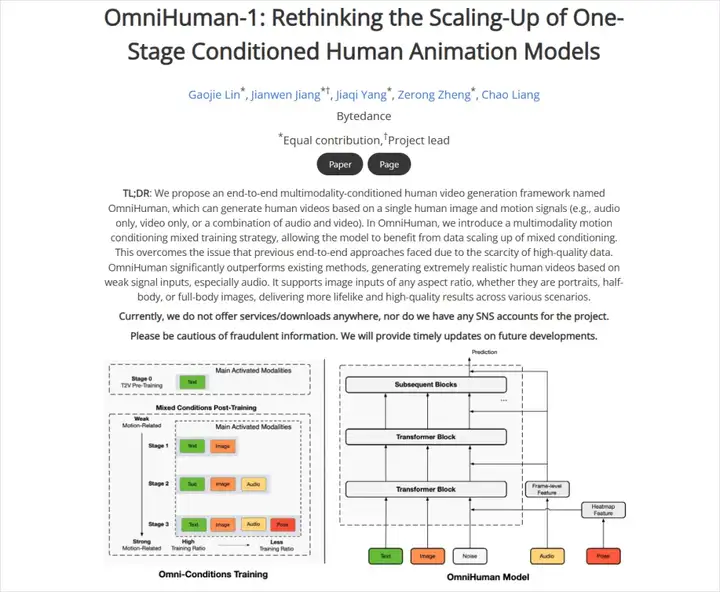

半个月前,字节的OmniHuman-1模型在全球的AI圈,都掀起了巨浪。

可能有些朋友不知道这是个啥,我大概通俗易懂的解释一下:

一张图+一段音频,就能生成超逼真的唇形同步AI视频。

听起来好像是不是之前已经有了?没毛病,这种AI视频我们一般称为对照片说话,我自己之前也写过:3分钟用AI让照片开口说话,去造属于自己的梦吧。

那时候的效果是这样的:

说实话,这个效果已经很不错了,但是有个最大的问题,就是只能生成面部或者头部的动画,背景、肢体全都没法动,非常的尴尬。

而这一次,OmniHuman-1做了巨幅的突破,一张照片+一段音频,就可以生成背景是动态、支持全身动作的视频,甚至还能保证口型同步。

在我心中,这好像才是真正的Sora该有的样子。

而我等啊等啊等啊。

终于,在今天深夜,我等来了OmniHuman-1的内测。

这一次,他们把这个模型也放在了老朋友即梦上。

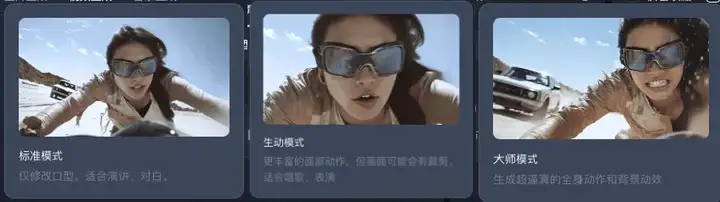

视频生成中的对口型上的大师模式,就是OmniHuman-1。

三种模式的描述对比一下:

在我玩了2个小时后,我只能感叹一句:

AI视频中的人物表演,也终于走进了下一个时代。

视频中的人物,再也不是默剧了,让人物开口说话也终于不用先跑一段动态AI视频再换口型了。

只需要一键,就直接生成一段带表演的、带口型的15秒视频。

这就像当年的语音,从TTS,进化到了端到端的声音一样。

酷到爆炸了好吗。

给大家看下怎么用,真的巨简单。

首先,你需要准备一张人物角色图和一段音频。

图的话没啥需要注意的,不同于之前的生动模式会强制剪裁,现在的OmniHuman-1支持任何比例,同时我自己测试下来,有个问题比较大,就是角色的审核非常严格。

猫猫狗狗之类的动物不能生存我能理解,但是一些拟人角色,或者稍微侧面一点的,都显示未检测到可用角色,比如我传这个哪吒的图:

就会显示这个:

这个我觉得就有一点问题,我就去直接问了下产品经理,是BUG,还是模型特性。产品的回复是:

至于音频的话,除了真人配音之外,如果想用AI生成,我比较建议去海螺AI,目前我觉得最强的AI语音。我曾经也写过一篇文章介绍:30秒就能完美复刻你的声音,这就是当今最强的中文AI语音克隆。

https://hailuoai.com/audio

全部准备就绪上传之后,你只要,点击生成就可以了。

比如我准备了一张哪吒的图片,和一段哪吒2里非常经典的语音。

哪吒台词,数字生命卡兹克,13秒

然后,他两直接合成了一段,AI哪吒念诗。

这效果,虽然有一些瑕疵,而且不能跟哪吒2原片段比,但是已经是我见过的,表演最好的了,毕竟你要是真能跟哪吒2片段打个平手。。。

那...AI对于影视的冲击...

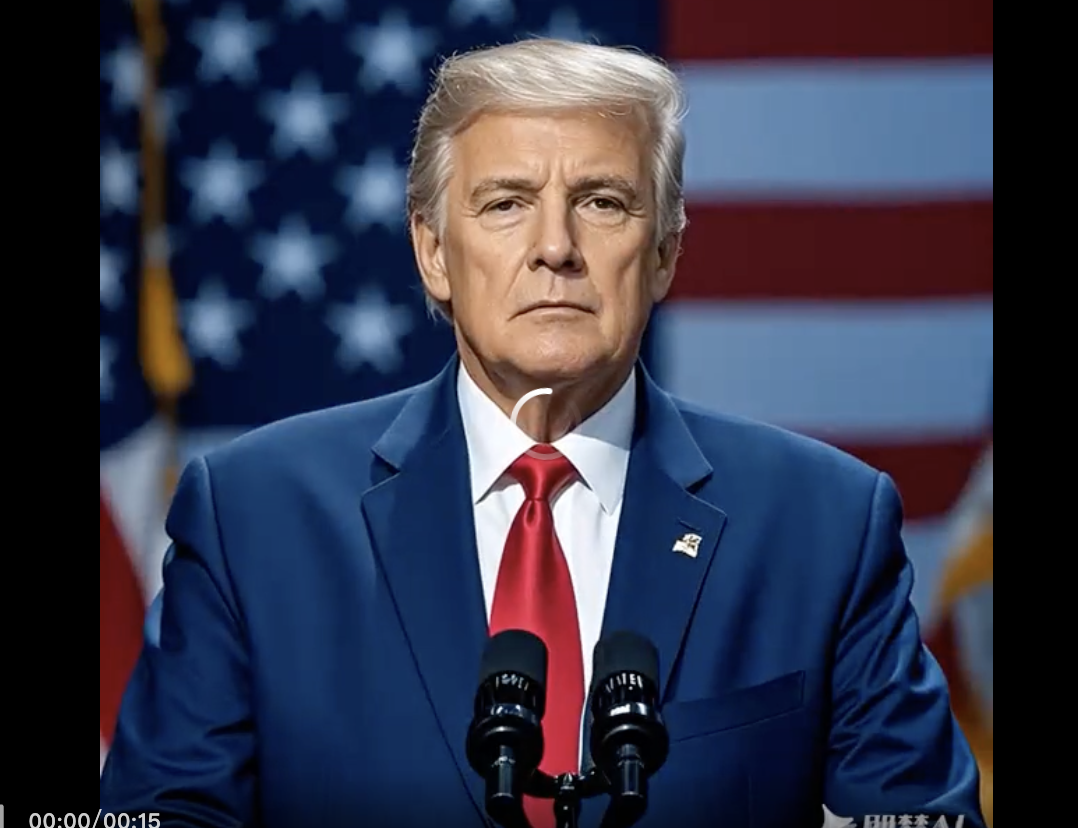

我又整了个活,让奥特曼...来搞个花的。

这个运动非常夸张,不仅奥特曼自己的表演是到位的,背景里面的行人也是匆匆,左右穿越,稳得一笔。

又或者这个miku酱弹吉他。

太牛逼了。

再放几个跑的case。

甚至不止单人,连多人...都可以。

AI女团有望。

从以前要调动画、找配音、做后期合成,至少得个把星期的工作量,如今十几秒钟就能完成,还能批量跑,简直让人不敢相信这是现实。

说实话,这就是我心里那个AI视频2.0时代的标志。

人物不仅动了,还能用自然语音去表达信息,真正把视频当做核心载体,让AI深度参与到表演和叙事中。

这样的想法放在半年前,像极了天方夜谭,可它如今就真实地摆在你面前。

再往后,我们也许要重新思考。

影视、动画、广告、甚至直播,这些传统概念,会不会因为一个AI,而统统被打碎重构?

相信,结论,都在大家的心中。

只是时间上的尺度有不同而已。

科技的长河滚滚向前。

从来不会等待,任何人。

文章来自微信公众号 “ 数字生命卡兹克 “

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales