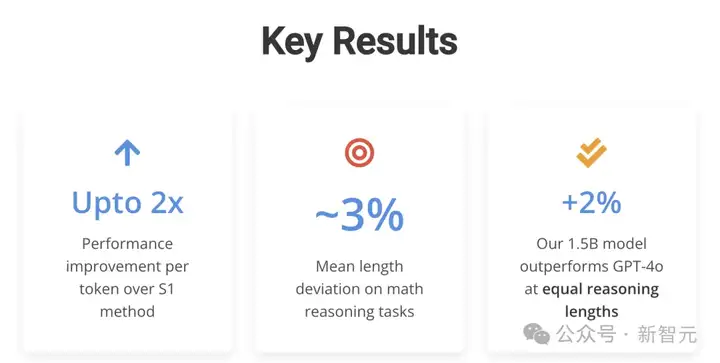

CMU团队用LCPO训练了一个15亿参数的L1模型,结果令人震惊:在数学推理任务中,它比S1相对提升100%以上,在逻辑推理和MMLU等非训练任务上也能稳定发挥。更厉害的是,要求短推理时,甚至击败了GPT-4o——用的还是相同的token预算!

一个只有15亿参数的小模型,竟然能在相同token预算下挑战GPT-4o的性能!

最近,CMU团队推出了「长度控制策略优化」(LCPO),它让AI的推理过程不再是「一刀切」,而是像个聪明管家,能根据任务需求灵活调整「思考」长度。

无论是啃下复杂的数学难题,还是快速解答简单问题,这个名叫L1的模型都游刃有余。

更惊艳的是,它还能把长推理的智慧「浓缩」到短答案中,使模型的效率和准确性双双飙升。

论文链接:https://arxiv.org/abs/2503.04697

推理型语言模型在测试时展现出了一种独特的能力:「思考更久」可以提升表现。

也就是说更长的「思维链」(CoT)序列,通常意味着更高准确性,但也意味着更高的计算成本。

然而,目前的CoT推理长度不可控,导致难以在测试时合理分配计算资源,以达到预期的性能水平。

研究团队首次证明:在相同token预算下,15亿参数的模型能匹敌GPT-4o的性能。

GPT-4o的参数规模为2000亿左右,是新模型的参数规模的133多倍数!

在数学推理任务上,条件完全相同时,L1比S1的相对提升高达100%,绝对提升20%。

除了在标准数学推理场景中更好地控制长度,LCPO训练的模型还能意外地泛化到分布外的任务,包括逻辑推理和像MMLU这样的通用知识基准。而且泛化效果也很好。

更厉害的是在生成短推理时,研究团队发现用LCPO训练的「长思维链」(long-CoT)模型变得特别强:当提示要求短推理时,LCPO训练的模型比原始模型强很多(提升高达10%),即便生成长度相同。

当前的推理模型有一个关键局限性:它们的推理长度无法控制,这使得无法分配测试时计算预算以达到目标性能水平。这导致了三大问题:

1 计算浪费:在某些情况下,生成的序列可能长达数万个标记,而在较短的推理已经足够的情况下,这会导致计算资源的浪费。

2 过早停止:如果没有长度控制,模型可能会在复杂问题上过早停止,未能分配足够的推理步骤。

3 未探索的权衡:目前无法根据目标性能水平校准推理计算预算,导致潜在效率提升未被探索。

在新研究中,在提示中加入一个目标token长度来解决这个问题。

简单来说,给定一个输入提示和一个目标长度,模型需要生成一个回答,让它的长度尽量接近目标长度,同时还得保证答案正确。

这种方式把准确性和输出长度直接挂钩,确保生成的思维链符合用户指定的限制。

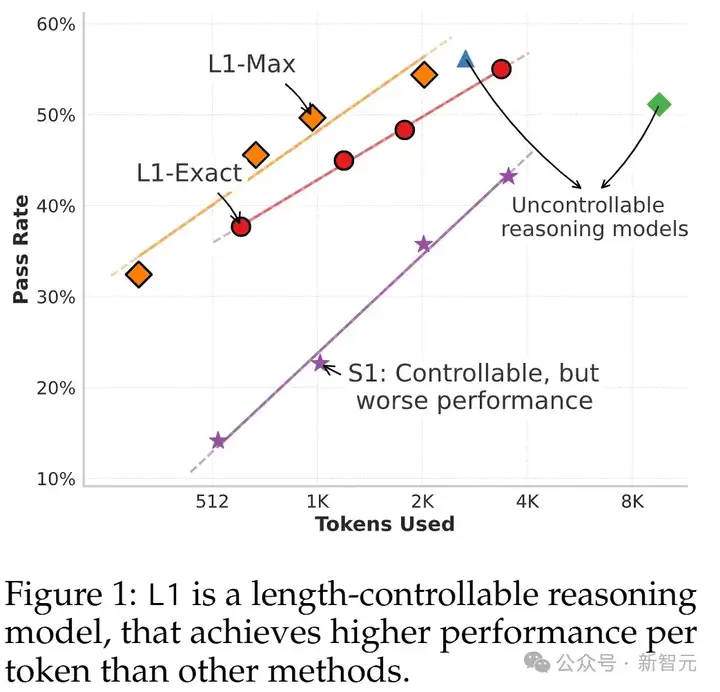

此前的方法,试图通过强制模型在生成过短或过长token时生成特殊token(例如「等待」、「最终答案」),实现长度控制。

然而,这种僵硬的、人为设计的策略与基础模型相比,性能显著下降(下图1)。

其他研究探讨了在指令遵循和一般领域中控制输出长度。

然而,推理模型面临着全新的挑战,例如输出长度要长得多,以及需要在计算成本和性能提升之间进行权衡。

研究人员提出了一个叫做「长度控制策略优化」(LCPO)的简单方法,它基于强化学习(RL),能让推理语言模型精确地、灵活地控制输出长度。

LCPO训练模型时有两个目标:一是最终输出的正确性,二是生成的推理序列要符合提示中指定的长度限制。

这样,LCPO训练出来的模型既能满足长度要求,又能优化推理表现,而不是依赖人为设计的规则。

研究人员试验了两种实用的长度限制方式:一是「LCPO-Exact」,要求生成的推理长度必须精确等于目标长度;二是「LCPO-Max」,要求输出长度不超过目标长度。

他们用LCPO微调了一个15亿参数的推理模型,这个模型基于Qwen-Distilled-R1-1.5B,得到了L1-Max和L1-Exact两个版本。

这些L1模型能很好地在token预算和推理性能之间找到平衡,只要在提示中调整长度要求,就能平滑地在短而高效的推理和长而精准的推理之间切换(见图1)。

重要的是,在这个权衡曲线上有一个点能恢复原始基础模型的性能,同时在所有推理长度范围内都比S1的表现更好(见图1)。

研究团队从一个预训练的推理模型LLM开始,用一个数据集D(包含N个样本),每个样本只有输入提示和最终答案(没有中间的推理过程)。

为了实现长度控制,给每个提示加上一个目标长度的指令。这样就得到了一个新的数据集Dnew,包含了带长度指令的提示和对应的答案。

接下来,用强化学习的目标来更新模型LLM。在实验中,研究人员选择了GRPO方法。

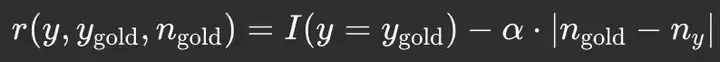

奖励函数包括两部分:正确性奖励rc和长度惩罚rlength。

这个奖励函数有两个作用:一是鼓励模型给出正确答案,同时在要求短输出时倾向于简洁的推理过程;二是即使正确答案可以用更少的token生成,它也会持续推动模型尽量匹配指定的目标长度。

根据目标长度的指令和训练目标不同,有两类方法:

1 LCPO-Exact(或L1-Exact):要求生成的推理过程必须严格等于目标长度;示例提示为:「Think for exactly 512 token」

2 LCPO-Max(或L1-Max):要求生成的输出不得超过目标长度,但可在该范围内灵活调整,以适应不同问题的难度。示例提示为:「Think for maximum 1024 token」

长度控制策略优化(LCPO)是一种简单RL方法,允许推理型语言模型仅使用提示(prompt),自适应地控制生成文本的长度。

在推理阶段,输出长度通过在每个测试提示后统一加上一个固定的目标长度(或者一组长度)来控制。

适用于下列场景:

1 基准测试(Benchmarking):确保不同模型在相同token预算下进行公平对比。

2 精确预算控制(Exact Token Budgeting):在受限资源环境下,严格控制生成内容的长度。

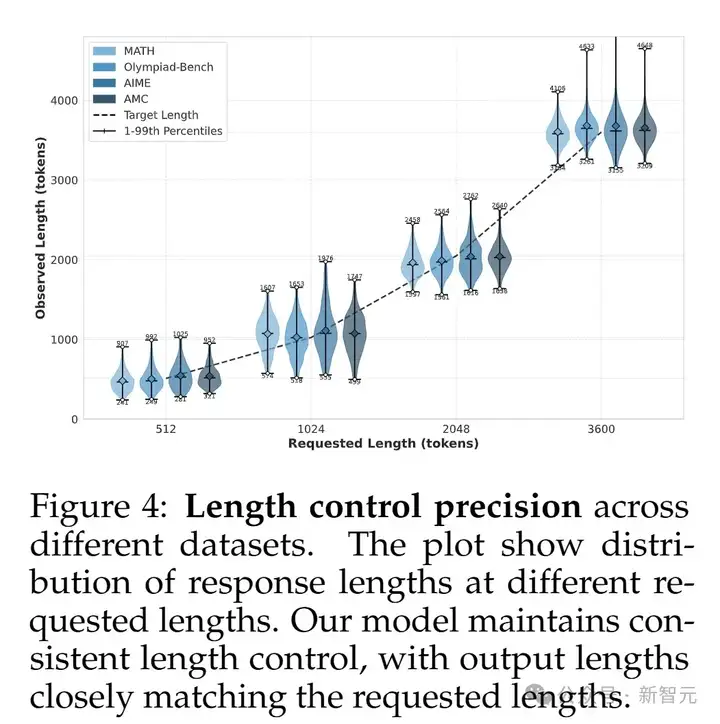

1 问题定义:给定输入提示词x和目标长度n_goal,生成一个长度n_y尽可能接近且答案正确的响应y。目标是最小化 |n_goal-n_y|的同时确保输出正确。

2 提示词增强(Prompt Augmentation):在每个提示词中增加目标长度指令:

3 强化学习(Reinforcement Learning):通过奖励函数进行优化,在准确性和长度匹配之间保持平衡:

其中, α用于平衡答案正确性和长度匹配的权重。

最大长度限制模式,L-Max适用下列场景:

为了训练L1-Max,在L1-Exact的基础上继续微调,用的是同一个强化学习框架,但改进了奖励函数:

(1)逐步惩罚超过目标长度的输出,而不是直接硬性截断(这在GRPO目标中需要保证梯度传播);

(2)鼓励模型在不牺牲正确性的情况下,尽量少用token。

此外,L1-Max用双重目标训练:如果提示要求精确长度,就用长度控制策略优化;否则默认用最大长度限制模式。

具体而言,使用带软约束的奖励函数进行优化,以平衡准确性和token预算:

其中参数α控制减少token使用的激励程度;δ确保轻微超出预算但正确的答案优于错误答案。

L1表现远超其他长度控制模型,同时保持强劲性能。

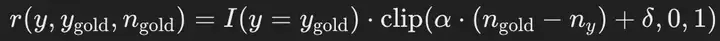

下图2比较了L1-Exact和L1-Max与其它基准模型在不同生成长度下的表现。L1的两个版本在所有token预算下都表现更好,同时还能精确控制长度。

相比专门为长度控制设计的S1方法,L1提升显著,在512和1024 token预算下,相对性能提升100-150%,绝对性能提升20-25%。

这种显著差异可以归因于两个关键原因:一是L1能智能调整思维链,让它适应指定的长度限制还不打断推理过程,而S1经常在中途被截断;二是L1被明确训练来生成不同长度的高质量推理链,能有效把长推理链的推理模式「浓缩」到短链中。

另外,研究团队还发现L1的性能随生成推理链的对数长度呈现线性增长,和OpenAI的o1及S1类似。

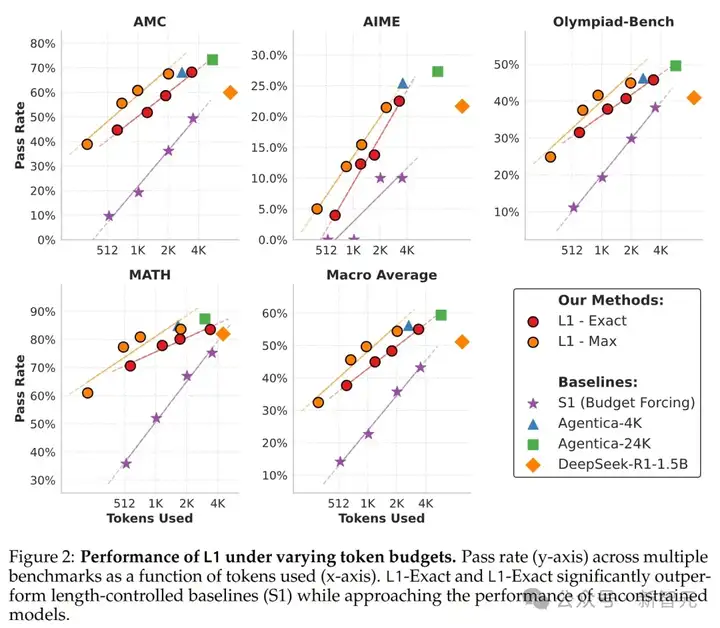

研究团队测试了L1在训练分布外的领域控制长度的能力。

非训练领域数据集分两类:一是通用推理数据集GPQA和LSAT,没明确用于L1训练,但可能在DeepSeek-R1-1.5B的训练范围内;二是MMLU,可能完全不在DeepSeek-R1-1.5B的训练分布内。

下图3显示L1在新领域表现稳健:在非训练通用推理数据集上,性能随token预算正向增长,尽管有长度约束,也接近或匹配Agentica-4K的表现。

在GPQA和LSAT上,他们看到和主数据集一样的线性性能增长趋势,L1在相似token预算下能达到Agentica-4K的表现。

考虑到L1没针对这些任务训练,这种泛化能力很惊人。在MMLU上,线性关系没那么明显(R²=0.66),可能是因为这些知识类问题从长推理中获益较少。

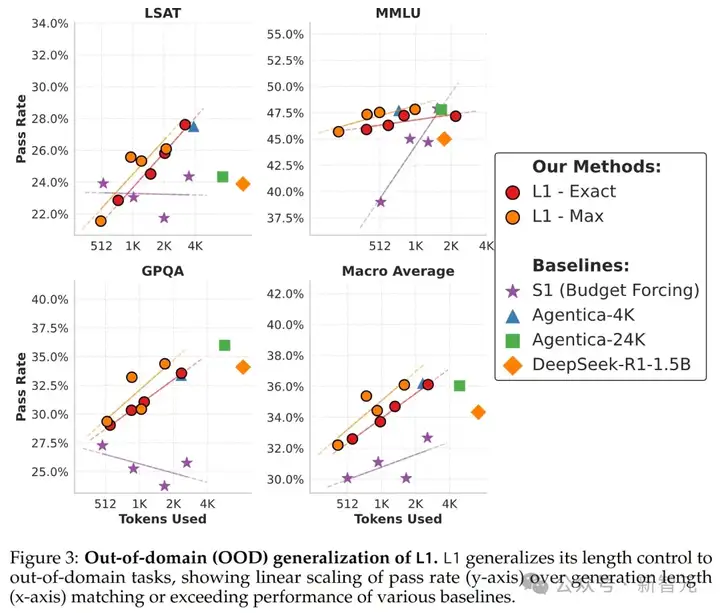

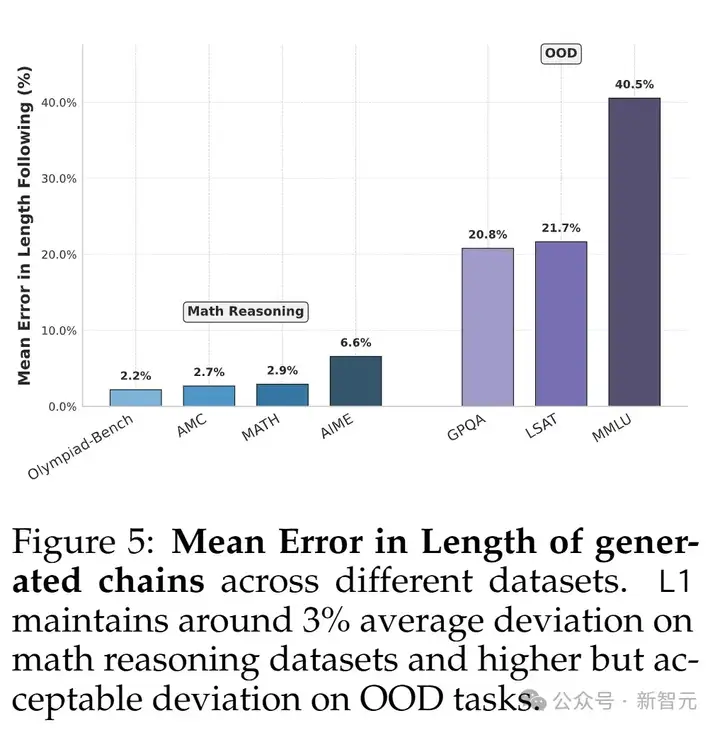

研究团队在多个数学推理数据集上量化评估了L1遵循长度约束的能力。

下图4显示,他们的模型在所有token预算(512、1024、2048、3600)下都能保持一致控制,输出长度通常很接近要求长度。

下图5展示了平均误差,反映了数据集中的平均偏离程度。结果显示误差很低,在数学推理数据集上接近3%。

虽然非训练数据集误差更高(20-40%),但仍比无控制的提示更好。

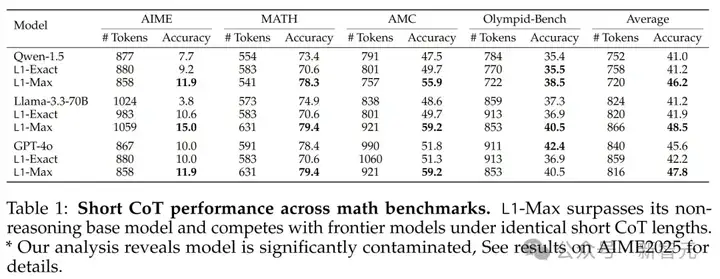

鉴于L1在低token预算下表现强劲,研究团队专门比较了它与基础非推理模型(Qwen-2.5-1.5B-Instruct)和更大的非推理模型(GPT-4o和Llama-3.3-70B)在相同生成长度下的表现。

下表1显示,L1在所有数据集上都持续超越或达到这些模型,尽管token预算相同。

平均来看,L1比非推理模型高5%,甚至比GPT-4o平均高2%。据研究者所知,这是首次证明一个15亿参数模型能在相同生成长度下超过GPT-4o这样的前沿模型。

总体来说,这表明通过适当的强化学习训练,长思维链模型能灵活转为短思维链模型,同时在相同生成长度下显著超越基础模型。

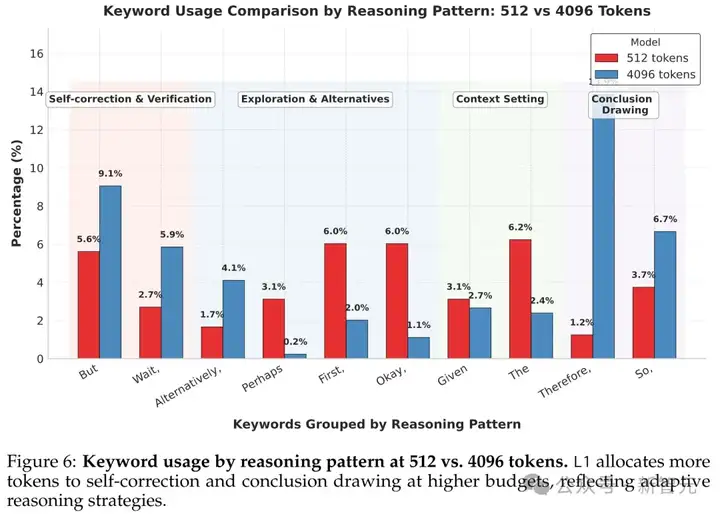

为了了解L1如何根据长度约束调整推理方法,研究团队分析了不同长度输出中推理相关词语的出现频率。

具体来说,他们计算了512 token输出和4096 token输出中最常见推理词的出现率,观察模型在不同长度约束下的策略变化。

下图6把这些关键词分成四种推理模式:「自我纠正与验证」、「探索与替代」、「上下文设定」和「得出结论」。

图6显示,在4096 token输出中,自我纠正和验证相关的词出现频率比512 token输出高约2倍。得出结论的词随token预算增加2-10倍,表明更彻底的验证和完成。

有趣的是,大多数探索相关词在高token数时的相对频率降低,「Alternatively」(或者)是个例外。

总体来看,短思维链的推理模式和长思维链相似,但频率分布不同,长思维链更倾向于自我验证和得出结论。

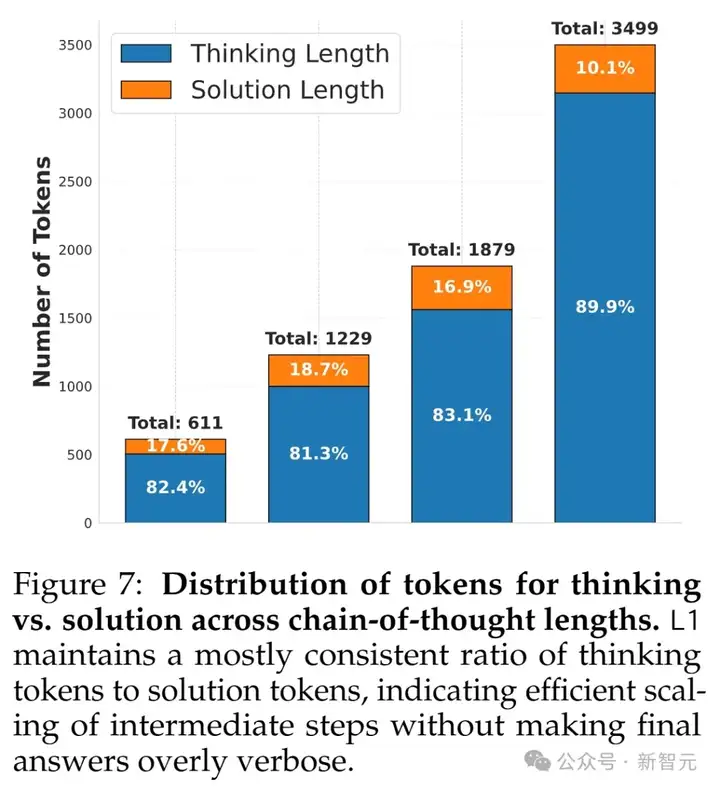

下图7还展示了不同生成长度下思考token(<think>标签内)和答案token的比例。

他们发现这个比例在不同长度下相对稳定。这意味着短思维链时,模型通常给出简短答案(往往直接输出最终答案),节省token。

随着生成长度增加,最后两栏的答案长度趋于稳定,说明模型扩展了思考token,但没让最终答案变得啰嗦。

在这项工作中,研究人员提出了「长度控制策略优化」(LCPO),一个简单但强大的方法,用强化学习让大语言模型能灵活控制推理链的长度。

他们用LCPO训练了L1,一个推理语言模型,优化它生成符合提示中长度限制的输出。LCPO比之前的测试时扩展方法强得多,在数学推理任务上比以前的长度控制方法相对提升超过100%,绝对提升20%。

此外,他们还证明了L1能很好地泛化到训练分布之外的任务,把长度控制能力扩展到非训练领域。

更有趣的是,他们的分析发现了一个意外现象:训练生成更长推理链的模型,竟然在短思维链(short-CoT)推理上变得特别强,在相同生成长度下甚至超过了像GPT-4o这样的大得多的前沿模型。

通过使用简单的提示进行长度控制,LCPO为更高效、灵活和可扩展的推理模型开辟了很有前景的道路。

参考资料:

https://x.com/PranjalAggarw16/status/1898015659369357318

https://arxiv.org/abs/2503.04697

https://cmu-l3.github.io/l1/

文章来自于“新智元”,作者“犀牛 KingHZ”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0