从手机随手拍、汽车行车记录仪到无人机航拍,如何从海量无序二维图像快速生成高精度三维场景?

传统方法依赖精确的相机位姿参数,实际应用成本高昂。港科广团队提出全新框架GraphGS,突破技术瓶颈——无需精准相机位姿,仅凭RGB图像即可实现大规模开放场景的高效重建和高保真新视角合成,相关论文入选ICLR 2025,代码即将开源。

现有三维重建技术通常依赖精确的相机位姿参数和密集视角覆盖,而实际应用中,由于设备限制或环境复杂性,获取高精度位姿和充足视角面临巨大挑战。

例如,COLMAP等传统SfM工具处理千张级图像需要数天时间,且容易因动态物体或重复纹理导致匹配失败。此外,稀疏视角下3D高斯点易过拟合到有限视角区域,导致几何失真和细节丢失。

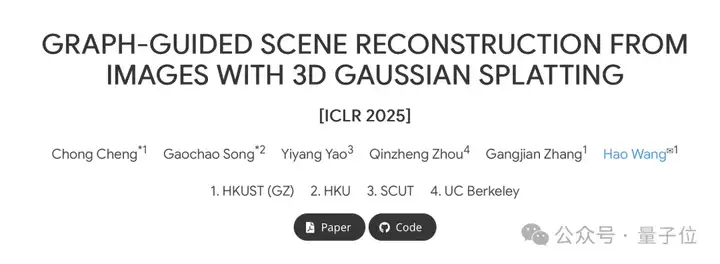

GraphGS通过创新的空间先验感知与图引导优化范式,提出三阶段解决方案:

该方法在保障精度的同时,将千张图像的重建时间从数十小时缩短至数小时。

GraphGS的核心在于将复杂的场景重建问题转化为图结构优化问题。

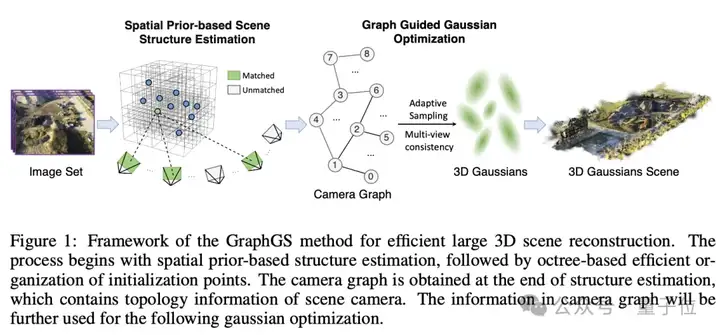

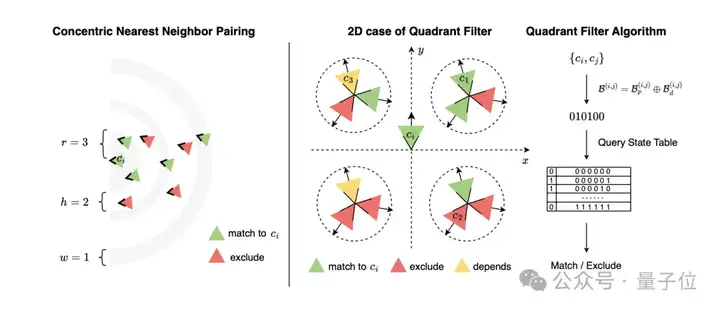

框架首先通过同心圆近邻配对和三维象限过滤策略,从海量图像中智能筛选关键匹配对,仅需平面相机位置即可构建连通相机拓扑图;随后将相机间的空间关系建模为带权无向图,通过多视角光度一致性损失和基于节点重要性的自适应采样策略,引导3D高斯点向全局最优分布演化。这一过程结合了传统几何约束与现代可微分渲染的优势,在保证重建精度的同时显著提升计算效率。

传统方法(如COLMAP)需遍历所有图像对(复杂度O(n²)),GraphGS通过数学策略筛选关键帧:

- 同心圆近邻配对:按距离分层采样,确定局部与全局关键帧,从万级图像对中筛选千级关键帧,解决COLMAP暴力匹配耗时难题。

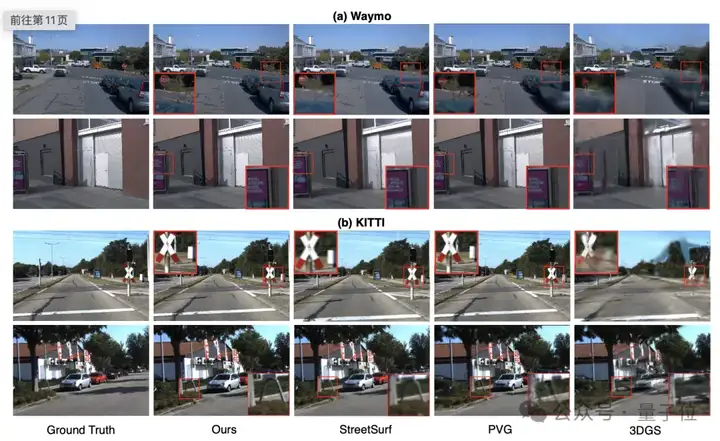

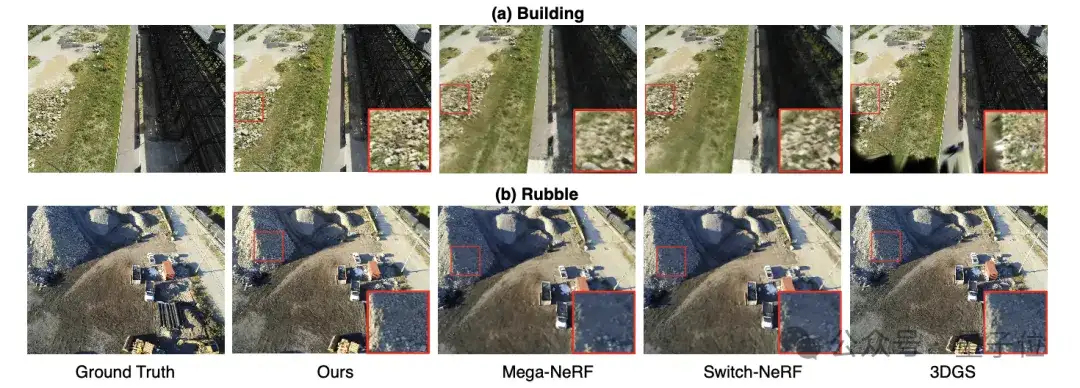

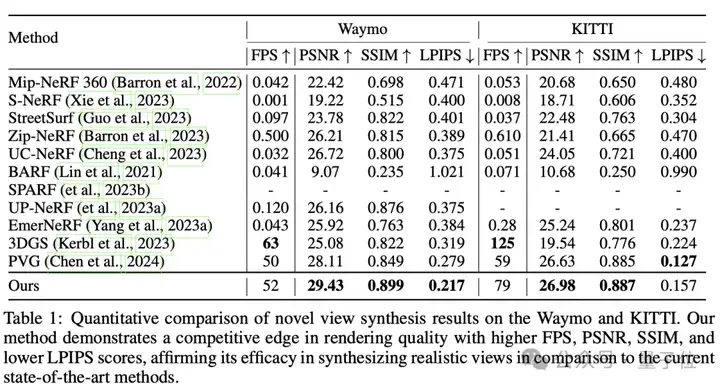

在Waymo、KITTI等自动驾驶数据集上,GraphGS在无真值位姿输入的情况下达到29.43 PSNR和26.98 PSNR,街景重建准确,树枝纹理、车窗倒影清晰可见。面对Mill-19数据集同样不使用真值位姿,该方法在碎石堆积、墙体断裂等极端场景下仍能实现高质量新视角合成,碎石、断墙细节清晰重现。

任意随拍视频,无需真实位姿重建结果展示,左侧为GT,右侧为重建场景。可以看到GraphGS实现了开放场景重建技术的三重突破:首次在无精确位姿输入条件下达成工业级重建精度,将千张图像处理速度提升至小时级,并支持消费级硬件实现平方公里级场景重建。这项技术不仅降低了三维数字化的硬件门槛,更为虚拟现实、智慧城市等领域提供了新的基础设施。

论文标题:Graph-Guided Scene Reconstruction from Images with 3D Gaussian Splatting

项目主页:https://3dagentworld.github.io/graphgs/

文章来自于“量子位”,作者“GraphGS团队”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md