自我2024年读过这篇2015年创作的文章,不由得被其天马行空的构想和逻辑缜密的推理所震撼。站在今天的这个节点,已然不再是对 AI 机会的 FOMO,而是面对“奇点”的到来做好心理准备。奇点终将到来,拥抱变化,保持好奇,大胆想象。

翻译,整理,微调 by 付子豪(Sio FU)

“我们正站在一个可与地球上人类崛起相媲美的变革边缘。” — Vernor Vinge

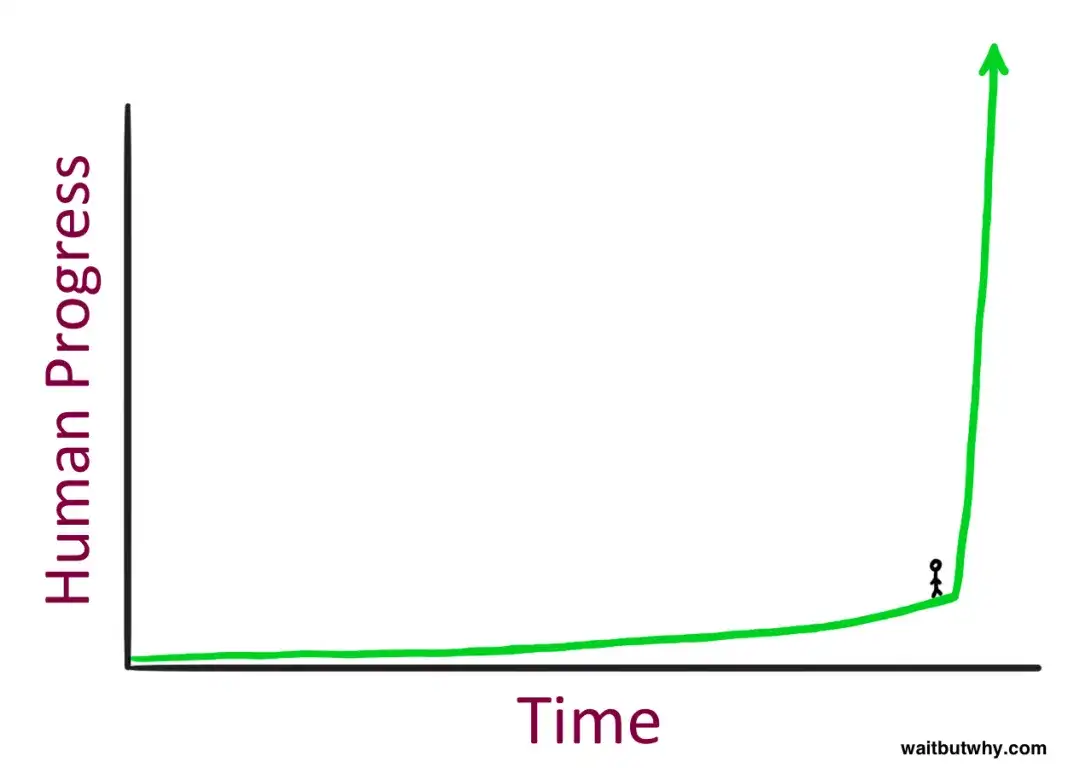

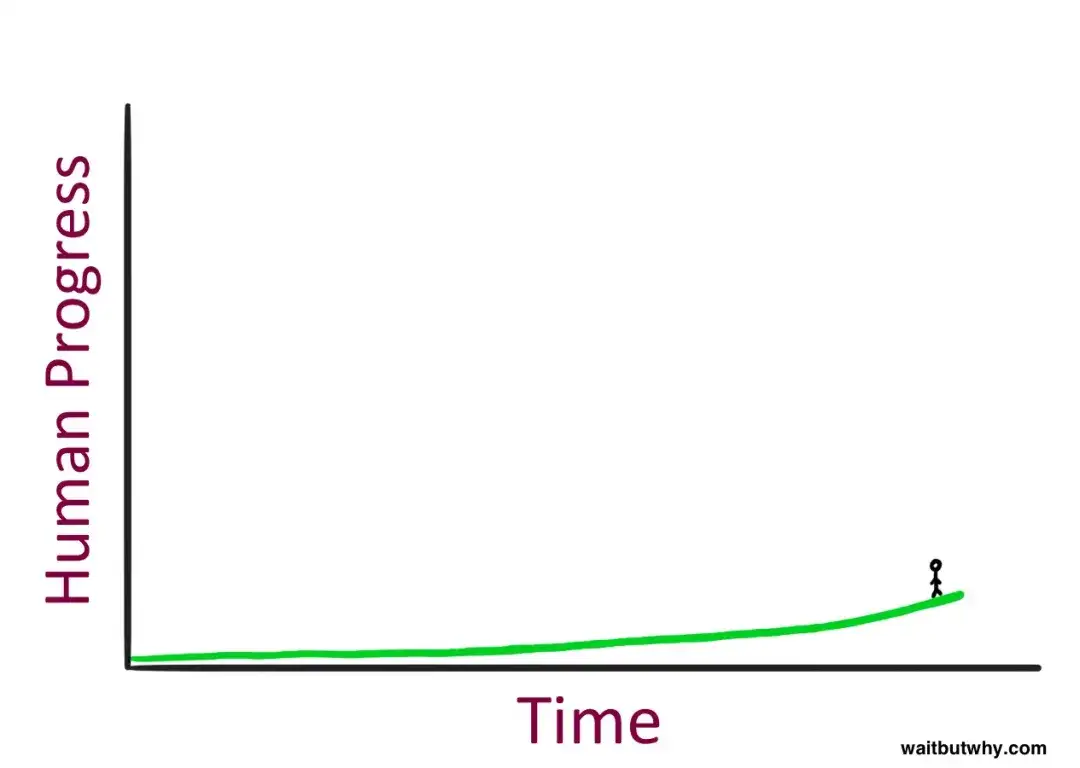

这是一种怎样的感受?

看起来,站在这里似乎非常紧张——但紧接着你就会察觉到,当你站在一条时间轴上时,你看不到右边会发生什么。所以实际上你真实的感受是这样的:

看起来可能就很平常……

想象一下,你坐着时光机回到1750年——那个时代没有电,远程通信就意味着要么大声呼喊,要么朝天鸣炮,所有的交通工具都靠消耗饲料来运行。你到了那里,找一个1750年的人,把他带回2015年,让他四处看看现在的世界,并观察他的反应。我们无法理解当他看到这一切会是什么感觉:看着一辆辆闪亮的胶囊在高速公路上疾驰;与那些当天还在大洋彼岸的人通话;观看远在1000英里之外进行的体育赛事;聆听50年前录制的音乐演出;或者使用我那个神奇的“魔法方块”(智能手机),去拍摄实时图像或录制动态视频;又或者打开一个带有“超自然”移动蓝点的地图,准确告诉他所处的位置;甚至看着对方的脸庞通话,对方却在国家的另一端……这些对他而言简直就是不可思议的魔法。更别提你还没跟他展示互联网,也没提国际空间站、大型强子对撞机、核武器或广义相对论。

对他来说,这样的体验不是“惊喜”或“震惊”甚至“不可思议”就能形容——这些词都太轻了。他可能真的会因为过度震撼而死。

但是有趣的是,如果这个1750年的人回到他的时代,因你那番“骚操作”而心生嫉妒,想自己也体验一把,他会用时光机回到与1750年相隔同样长的时间段,也就是1500年,把那时的人带到1750年来看。对1500年来的人而言,有很多事仍然会让他惊叹不已,可他却不会被震撼得“当场死亡”。1500年与1750年的差异是很大,但和1750年至2015年的区别相比要小得多。1500年来的人能学到一些关于太空和物理的震撼知识,也会对欧洲孜孜不倦的殖民热潮感到惊讶,还得重新思考一下他对世界地图的认识。但仅仅看1750年的日常生活——交通、通信等等,对他而言并不会令人“震惊到死”。

如果1750年的那位先生想要获得和我们带给他同等的震撼,他就必须把时光机开到更早的时代——大概公元前12000年左右,也就是第一次农业革命之前。那个时代的人类仍然过着“纯粹的狩猎采集式生活”,某种意义上还只是“另一种动物物种”。如果让他看到1750年大规模人类帝国的版图:耸立的教堂、跨越大洋的舰船、室内生活(“inside”这个概念)以及那庞大而集成的人类知识与发现,他也会被吓得“死过去”。

而如果那个公元前12000年的人“死后也嫉妒”并想重复这一过程,他就会回到公元前24000年,从那个时代带来一个人,让他看看公元前12000年的世界。可那个从公元前24000年过来的人看了之后大概率会说:“行吧,那又怎样,谁在乎啊。”要想让公元前12000年的人获得同等程度的“乐趣”,他恐怕得回到十多万年前,找一个连火和语言都还没真正掌握的人来看看。

要想让一个被带到未来的人因为惊讶而“震死”,就得让他跨越的时间足够长——在那期间要发生所谓的“超越承受能力”的技术或社会进步。我把这种“一跨越就足以震死”的进步量称为一个“DPU”(Die Progress Unit,“致命进步量”)。在原始狩猎采集时代,达到一个DPU需要十万年以上;但在后农业革命时代,只需一万多年;而在后工业革命时代,1750年的那个人往前只跳几百年就足够被“震死”了。

这种“人类进步随时间加速”的模式,正是未来学家雷·库兹韦尔(Ray Kurzweil)所说的“人类历史中不断加速的规律”(Law of Accelerating Returns)。之所以会加速,是因为技术越先进的社会,进步速度就越快——正是由于它们更先进。19世纪的人类文明拥有比15世纪更全面的知识与更先进的技术,因此19世纪能取得的进步自然远比15世纪大得多——15世纪的人类与19世纪的人类根本无法相提并论。

在更小的时间维度中,这种规律也同样成立。电影《回到未来》(Back to the Future)于1985年上映,“过去”的时间设置在1955年。当迈克尔·J·福克斯(Michael J. Fox)回到1955年时,他会因为电视机的新鲜感、苏打水价格的不同、电吉他的尖锐音效无人欣赏以及俚语的不同而感到惊讶。是的,1955年的世界和1985年截然不同。但如果这部电影拍摄于今天,把“过去”设定在1985年,这段30年的落差会让剧情更有意思:主角将面临一个没有个人电脑、没有互联网也没有手机的时代。对今天出生于90年代末的青少年来说,回到1985年会产生比影片里1985年的主人公回到1955年大得多的落差,更加格格不入。

这同样是“加速回报法则”在起作用。1985年至2015年的科技进步速度比1955年至1985年更快,所以后三十年里发生的变化远比前三十年多。

因此——社会与技术的进步在变得越来越迅猛也越来越巨大,这对我们的未来意味着什么?

库兹韦尔认为,整个20世纪的进步总量,如果按2000年的发展速度来衡量,只需要20年就能完成——换句话说,到2000年时,人类进步的速度比整个20世纪平均速度快五倍。他进一步认为,从2000年到2014年,又出现了“一个20世纪的进步量”;而到2021年——也就是仅仅7年后,我们又会完成“一个20世纪的进步量”。再过二三十年,库兹韦尔相信,“一个20世纪的进步量”甚至可能在同一年内出现多次,甚至到后来,一个月之内就能完成。根据“加速回报法则”,库兹韦尔认为21世纪的进步将是20世纪的1000倍。

如果库兹韦尔和许多与他观点相似的科学家是正确的,那么到了2030年,我们面对这个世界时的震撼程度也许会和1750年那位仁兄看到2015年时差不多——也就是说,下一个DPU(致命进步量)可能只需要二十多年就会到来;到了2050年,世界也许会与今天大不相同,几乎认不出来。

这可不是科幻小说,而是很多比你我更聪明、更有知识的科学家所坚信的,并且从历史经验来看,这样的推断的确合情合理。

但是,当我说“未来35年后,世界可能会完全变样”时,你大概的感觉是“嗯……听着挺酷……但是还是不太可能吧。” 我们为什么会本能地怀疑这些“看似离谱的”预测呢?原因大概有三个:

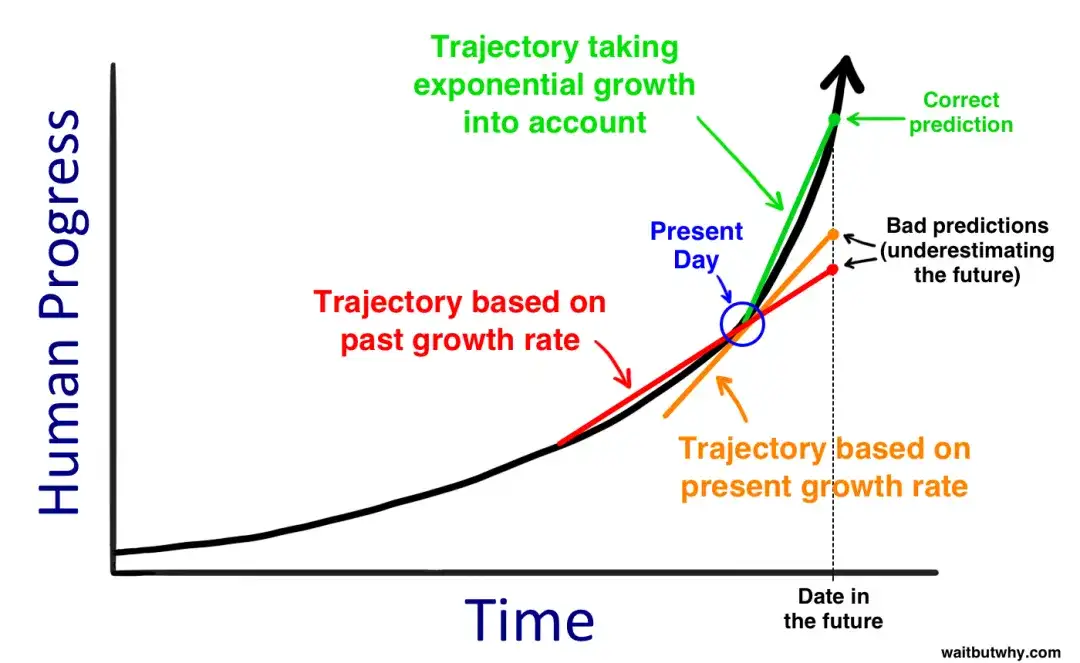

我们常以直线的方式去看待历史。

当我们预测未来三十年的进步时,往往只把过去三十年的进步量当作未来的参照。而当我们思考整个21世纪会发生多少变化时,我们可能只是简单地将20世纪的所有进步叠加到2000年之后。这正是前面提到的1750年人把1500年的人带到1750年时的思维模式:我们直觉上会线性思考,而对未来的正确思维方式却应该是指数型。有些人比较“机智”,可能会基于“当前的进步速度”来设想未来三十年的变化,这当然比沿用过去三十年的速度要好,但依然差得很远。要真正正确地思考未来,你必须预见到比“现在”还要快得多的进步速度。

仅凭近期历史往往会得出被扭曲的结论。

首先,即使是真正陡峭的指数曲线,如果我们只盯着其中极小的一段,它看起来也像直线。就像放大一个巨大圆弧的局部,它也会看似笔直。

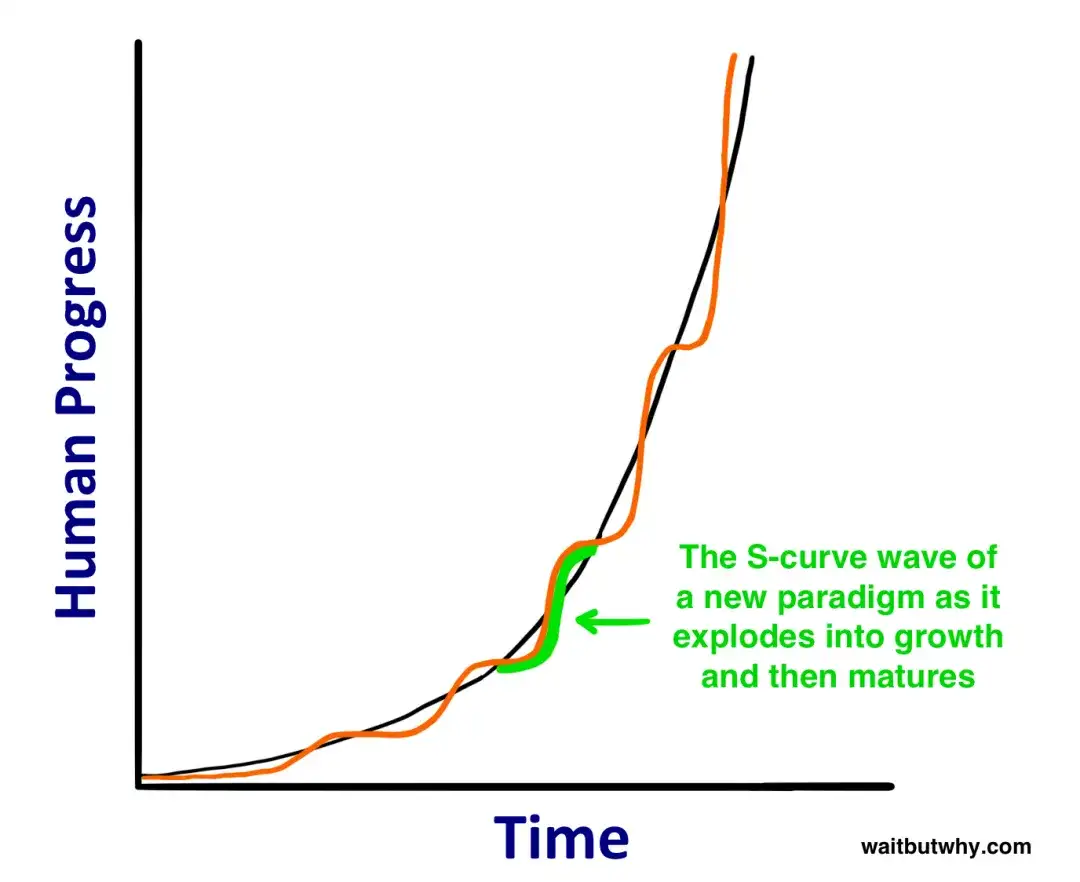

其次,指数增长也并非始终平滑连续。库兹韦尔解释说,进步往往会经历“S型曲线”(S-curves):

S型曲线的成因在于:每当一个新的技术或范式开始普及,都会经历三个阶段:

1) 缓慢增长(指数增长的早期阶段)

2) 快速增长(指数增长后期,爆发式增长阶段)

3) 当该范式成熟后,增长趋于平缓

如果我们只看最近几年的发展,而当前正好赶上S曲线的哪个阶段,就会影响我们对当前加速速度的感知。比如1995到2007年的那段时间,互联网爆发式发展,微软、谷歌和Facebook这些公司进入公众视野,社交网络诞生,手机以及智能手机开始普及——这是S曲线突飞猛进的第二阶段。然而2008年到2015年,科技前沿突破性进展较少,至少没像之前那样狂飙。如果有人基于过去几年判断未来的速度,这就忽视了更大的整体图景。或许此刻,新的爆发期已经在酝酿之中。

个人的经验让我们在面对未来时固执己见。

我们所认知的世界往往基于个人经历,而这种经历会让我们下意识地认为过去几十年的发展速度“就是事情发生的方式”。同时,我们的想象力也会受此局限。当我们听到那些与自己经验相矛盾的未来预测时,就会觉得对方“天真幼稚”。如果我告诉你,稍后在这篇文章里,你也许会活到150岁,甚至250岁,或者干脆“不死”,你的第一反应会是:“太荒唐了——历史证明人一定会死啊。”是的,在过去没有人不死。可回头想想,也是没有人类会飞行,直到人类发明了飞机。

所以,当你读到这些时,尽管理智上或许能理解,但直觉上仍可能会觉得“没那么夸张吧”。然而,若我们真正遵从历史规律、遵从“加速进步”的逻辑,就会发现未来的变化幅度将比我们本能预期的要大得多。理性的结论是:如果地球上最先进的物种继续以越来越快的速度向前迈进,而且速度不断加快,那么在某个时候将会出现一次巨大的飞跃,它将彻底改变那个物种对“生活”和“人类存在意义”的认知——就像进化论告诉我们的,生物智力一次次提升,最终从类人猿跨越到人类,这个飞跃让地球上的生物格局完全改变。而一旦你开始深入了解当今科学与技术的现状,你就会看到很多迹象在悄悄暗示:我们所熟悉的生活方式,很可能在下一个飞跃面前不堪一击。

AI究竟是什么?

如果你和我一样,曾经觉得“人工智能”(AI)不过是科幻电影里的玩意儿,但最近常听到很多严肃人士谈起,却又不太明白AI的真实含义,那么我们先来捋清楚AI这个词。

很多人对AI感到困惑,主要有三个原因:

我们常把AI和影视作品联系在一起。

像《星球大战》、《终结者》、《2001太空漫游》,甚至《杰森一家》(The Jetsons)都出现过形形色色的“机器人角色”,但它们都是科幻作品。所以AI听起来有点“科幻故事的感觉”。

AI涵盖的范围非常广。

从手机计算器到自动驾驶汽车,从做某件事非常精通的算法到未来可能彻底改变世界的事物,都可以被称为AI。这样的宽泛定义让人摸不着头脑。

我们每天都在使用AI,但往往并没有意识到那就是AI。

“人工智能”这个术语诞生于1956年(由约翰·麦卡锡John McCarthy提出),但他抱怨说:“一旦某种AI功能真正奏效,人们就不再把它称作AI了。” 由于这种现象,人工智能听起来更像是一个神话般的未来预测,而非现实。与此同时,也有人把它当作一个从未实现的过去流行概念。雷·库兹韦尔说,他常听到有人说AI在上世纪80年代就“没戏了”,但他对此的评价是,这就好比“有人坚持互联网在2000年代初的互联网泡沫之后就彻底死掉了一样”。

所以首先,别再只盯着“机器人”这个外在形象。机器人是一个装载AI的“容器”,有时候会仿人形,有时候不会——但AI本身是机器人的“大脑”(算法或软件),机器人可能只是它的“身体”(如果它需要的话)。例如,Siri的底层软件和数据才是“AI”,我们听到的那个女声只是它的“化身”,而且压根就没有一个物理的“机器人”出现。

其次,你大概也听说过“奇点”(Singularity)或“技术奇点”这样的说法。数学里会用“奇点”来形容类似渐近线的极端情况,通常常规规律不再适用;物理学里也会用它来描述比如黑洞的无限密度点,或者宇宙大爆炸前那一团无限小、无限致密的状态。1993年,弗诺·文奇(Vernor Vinge)在一篇著名论文中,把这个词借用来指未来某个时刻:人工智能的智慧将超过人类,此刻之后我们的生活将发生翻天覆地的变化,原有的规则都不再适用。雷·库兹韦尔又进一步把“奇点”定义为某个“加速回报法则”已发展到“几乎无限快”的时刻,此后世界将是一个截然不同的地方。但我注意到,现在很多AI领域的学者已经很少使用“奇点”这个词,毕竟它本身容易引起混淆(尽管我们在讨论的,正是那个概念)。所以,我在下文里也不会过多使用“奇点”这个词(虽然我们一直在探讨的就是与之对应的现象)。

最后,AI的类型与形式五花八门,但我们真正要关注的是AI的“级别(caliber)”。以下是AI领域最关键的三个级别:

狭义人工智能(ANI:Artificial Narrow Intelligence)

有时也叫弱人工智能(Weak AI)。这种AI擅长单一领域。比如能在国际象棋中击败世界冠军的AI,但它只能下棋。你要让它帮忙想个怎样改进硬盘存储方式的主意,它就只能茫然。

通用人工智能(AGI:Artificial General Intelligence)

也叫强人工智能(Strong AI)或者人类级AI(Human-Level AI),指的是在各方面都和人类一样聪明的计算机——能完成任何人类能完成的智力任务。要实现AGI,可比ANI难多了,目前还没有成功先例。Linda Gottfredson教授将“智力”描述为“一种非常普遍的心理能力,其中包括推理、计划、解决问题、抽象思考、理解复杂想法、快速学习和从经验中学习的能力。”AGI能够像你一样轻松地完成所有这些事情。

超级人工智能(ASI:Artificial Superintelligence)

牛津大学哲学家、AI领域知名学者尼克·波斯特罗姆(Nick Bostrom)将“超级智能”定义为“在几乎所有领域(包括科学创造力、一般智慧和社交技能)都远胜于任何人类大脑的智慧体”。ASI的范围很大,从比人类聪明一点点的AI,一直到智力水平比人类高出万亿倍的计算机,都可以算是ASI。ASI 是人工智能话题如此令人兴奋的原因,也是“永生”和“灭绝”这两个词会多次出现在这些帖子中的原因。

目前,我们已经在很多场景中实现了最“低”级别的AI——ANI,而且它已经无处不在。所谓“AI革命”,指的就是从ANI到AGI,再到ASI的这条道路——我们人类有可能无法幸存,但无论结果如何,这都将彻底改变世界。

接下来,让我们来详细看看这个领域最顶尖的专家们对这条道路的看法,以及为什么这场革命可能比你想象中要更快到来。

我们现处在哪个阶段——一个由ANI驱动的世界

狭义人工智能(ANI)指的是在某个特定领域能达到或超过人类水平的机器智能。以下是一些例子:

就目前而言,ANI系统并不可怕。它们最糟糕的情况,是在出故障或被不当编程时,造成一些局部性灾难,比如让电网崩溃,或导致核电站失灵,或触发金融市场像2010年那场闪电崩盘(Flash Crash)那样的短时暴跌(当时是一个ANI程序对突发状况作出错误反应所致,市值瞬间蒸发一万亿美元,事后只部分挽回)。

然而,尽管ANI还不足以对人类构成“生存威胁”,我们依然该意识到:这些日益增多且更复杂的ANI系统,正是通往AGI和ASI的基石。就像Aaron Saenz所说,我们所处的ANI世界就像远古地球的“原始汤(primordial ooze)”——那里充斥着蛋白质和氨基酸,而某一天,那些“无生命的物质”突然就有了“意识”。

从ANI到AGI的道路

为什么这么难?

你只有在了解构建一个像人脑那样聪明的计算机是多么困难时,才会真正欣赏人类智慧。修建摩天大楼、送人上太空、甚至探究宇宙大爆炸原理,都比理解和复制我们自己的大脑更容易。到目前为止,人类大脑仍然是已知宇宙中最复杂的存在。

有趣的是,试图构建 AGI(让计算机变得“像人一样聪明”)真正困难的地方,往往与我们的直觉不太一样。想做一个能在亿位数之间做乘法的计算机?很简单!但想做一个能看着狗就知道“那是狗而不是猫”的算法,却十分困难。制造一个能打败国际象棋世界冠军的AI?我们已经做到了。可想让计算机读懂小学一年级读本上的一段话——不仅能识别文字,还要理解它在讲什么——Google现在砸下数十亿美元也只是在努力攻关。难的事(比如微积分、金融策略和语言翻译等)对计算机来说反而简单;对我们来说很容易的事(视觉、动作、移动、感知等),对计算机却异常困难。正如计算机科学家Donald Knuth所说:“在AI领域,几乎所有需要‘思考’的事情都已经做到,而大多数人和动物‘不经思考’就能完成的任务仍然没能实现。”

为什么会这样?因为那些对我们而言“看似简单”的能力实际上非常复杂,而之所以看起来容易,其实是地球上数亿年“动物进化”不断优化的成果。当你把手伸向一个物体时,你的肩膀、肘部和手腕的肌肉、肌腱和骨骼会立即与眼睛一起执行一系列物理操作,让你的手在三维空间中沿直线移动。这对你来说似乎毫不费力,因为你的大脑中已经完善了软件来做到这一点。同样的想法也适用于为什么恶意软件不能在你注册一个新账户时弄清楚倾斜的单词识别测试,这并不是因为它很愚蠢——而是因为你的大脑非常了不起,因为它能够做到这一点。

然而我们对大数字乘法或下棋并没有天生优势,这只是我们后天才学到的技能,所以计算机在这方面轻松碾压我们。想想看,编一个能够做超大数乘法的程序更容易,还是编一个能识别各种字体甚至潦草手写体下的“B”并迅速懂得那就是“字母B”的程序更容易?明显前者更简单。

比如,看下面这张图。你和计算机都能判断这是一块矩形区域,有两种颜色,交替分布:

目前看来,人和计算机都势均力敌。但如果你把黑色遮挡物拿开……

你一看就能描述这是一堆不透明和半透明的圆柱、条板以及3D拐角,但计算机很可能只会死板地告诉你它看到的只是一些“二维形状且颜色深浅不同”。其实,它并没有错——它只是在描述确切存在的像素颜色,而你的大脑却会做“深度”和“阴影混合”、“环境光线”等高级推断。同样,下面这张图对计算机而言就是“黑白灰三色二维拼接”,但你却可以轻易看出这是“一整块黑色岩石的3D照片”:

图源:Matthew Lloyd

而这还仅仅是静态图像的理解。要让计算机像人一样拥有通用智能,它还得理解诸如微妙面部表情之间的区别;理解“高兴”、“如释重负”、“满足”、“心满意足”、“欣慰”这些情绪的细微差异;以及为什么《勇敢的心》是一部好电影而《爱国者》却很糟糕……可见这条路有多难。

令人畏惧。

那该如何实现呢?

第一大要素:计算能力(硬件)的提升

要想让AGI成为可能,计算机的硬件性能必须跟得上。如果要跟人脑对标,至少要能够在硬件上支撑人脑水平的原始计算速度。

一种简单的衡量方式是:估算人脑每秒能够完成多少次计算(calculations per second,cps)。方法可以是计算出大脑中每个结构的 CPS 将其相加,对它做最大计算力的专业估算。雷·库兹韦尔提出了一个捷径:他找了不同专家对大脑若干区域的估算,互相验证,得出的结论都在同一数量级——大约是10^16(也就是一万万亿,10 quadrillion)次计算/秒。

目前全球最快的超级计算机是中国的天河二号(Tianhe-2),其峰值速度约为每秒3.4×10^16次(34 quadrillion cps),已经超越了这条“人脑门槛”。但天河二号的体型十分庞大,占地720平米,耗电24兆瓦(而人脑只需要约20瓦),造价3.9亿美元。这并不是一个能大规模商业化或生活化使用的东西。

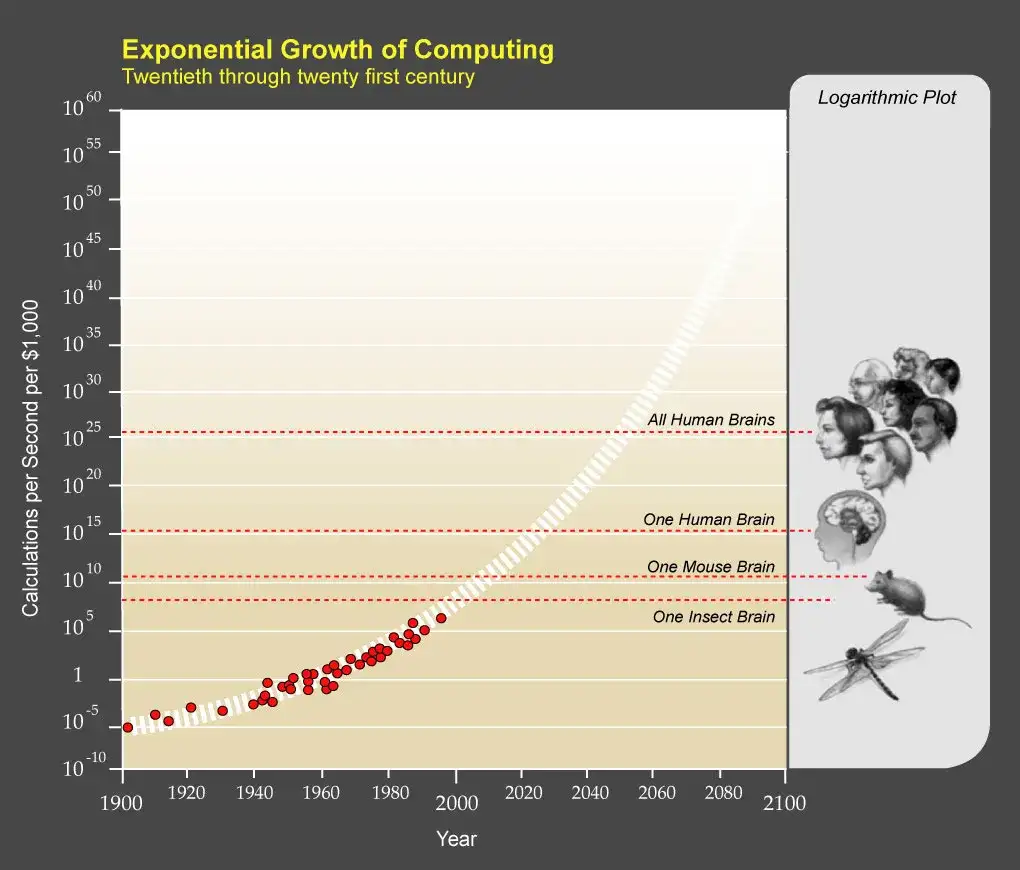

库兹韦尔建议用“花1000美元能买到多少cps”这个指标来观察。等到这个指标能达到10^16(人脑水平)时,AGI的硬件条件也就算是“大势已成”。

**摩尔定律(Moore’s Law)**是一个历史上相当准确的观察:世界上最先进的计算能力大约每两年翻一番,这是一种指数式增长。根据库兹韦尔的指标,目前我们大约能用1000美元买到10^13 cps的计算力,和他预测的曲线几乎吻合:

换句话说,世界上1000美元的计算机现在已经能赶上老鼠大脑的计算能力,大约是人脑的千分之一。听上去还差很远,但回想一下:

而2015年达到1/1000,意味着到2025年就能有一台价格适中、计算力可匹敌人类大脑的机器,这并不是什么科幻。因此,在硬件层面,“造出一台拥有AGI所需计算力的机器”在技术上已在视野内,甚至现在的超级计算机都能做到,只是成本还非常高。等到价格平民化之后,难题就变成:如何让它“聪明”起来达到让人类水平?

第二大要素:让它“变聪明”的软件突破

仅有强大的硬件并不能保证系统拥有“通用智慧”。目前对于怎么让计算机像人一样聪明,还没有定论。但有很多天马行空的路线正在探索,以下是最常见的几种:

1)复制大脑(Plagiarize the brain)

这就好比科学家们在琢磨:班里那个坐在他们旁边的学生为什么那么聪明,每次考试都考得特别好,而自己明明也很努力,却怎么也赶不上。到最后,他们干脆破罐子破摔:“算了,去他的吧,老子就直接抄那家伙的答案得了。” 这其实是说得通的——我们试图打造一台超级复杂的计算机,却一时无从下手;可事实上,每个人脑袋里就正好有这么一个完美的原型机。

科学界正竭尽全力对人脑进行逆向工程,想弄清进化是如何造就这样一种惊人的系统——有些乐观预测认为,到2030年我们就能完成这一目标。一旦做到这一步,我们便能掌握大脑之所以如此强大、高效运转的所有奥秘,并从中汲取灵感,借鉴它的各种创新。人工神经网络(Artificial Neural Network)就是一个模仿大脑结构的典型例子。它最初只是一张由晶体管“神经元”组成的网络,彼此通过输入和输出相连接,就像一颗新生儿的大脑一样,对外界“一无所知”。它的学习过程大致如下:假设让它进行手写识别任务,一开始,网络对每个字母做出的神经“激发”与解读猜测都是随机的;如果系统收到反馈,说它识别对了,那么那些恰好导向正确答案的晶体管连接就会被强化;如果被告知是错的,那么这些连接就会被削弱。经过大量的尝试与反馈之后,网络就能自行形成更智能的神经路径,最终在该任务上得到优化。人脑的学习方式和这个过程有些类似,只是更复杂更精妙。随着我们不断研究大脑,人们也在不断发现各种巧妙的方式来利用神经回路的潜能。

另一种更激进的方法是“全脑仿真(Whole Brain Emulation)”,具体操作就是把一个真实大脑切片,逐层扫描,通过软件重建出一个完整3D模型,最后把这套模型移植到一台强力计算机上。这样一来,理论上就能得到一台在大脑所能完成的所有任务上都“名正言顺”具备同等能力的电脑,只是它还需要自己去学习、收集信息。一旦工程师水平更高,就能将真实人脑“复刻”得极其准确:当完整的大脑结构被上传至计算机后,那个大脑原本的人格与记忆也能“完好如初”地保留下来。如果这个大脑属于临终前的“吉姆(Jim)”,那么现在这台计算机里就会“以吉姆的身份”醒来(当然,这牵涉到“意识是否真的延续”等哲学问题)——这便意味着我们已经拥有了一个“成熟的、可用的人类级AGI”,随后我们还可以将“吉姆”升级成拥有不可思议智慧的ASI,吉姆本人大概也会对此兴奋不已。

那么,我们离实现 whole brain emulation 还有多远?到目前为止,我们才刚刚能够模拟一条体长1毫米、神经元总数仅有302个的扁形虫而已,而人类大脑则拥有1000亿个神经元。听起来或许有点遥不可及,但别忘了“指数型进步”的威力——既然我们攻克了微小的线虫大脑,或许很快就能模拟蚂蚁,随后是老鼠,然后情况就会突然变得大不相同,看起来也没那么难以企及了。

2)让“进化”替我们再来一次(Try to make evolution do what it did before but for us)

如果我们觉得“抄大脑答案”太难,那就抄大脑“学习和进化的方法”。我们可以确定的是:造出一台与人脑同等强大的计算机并非异想天开,毕竟人脑本身就是演化的产物;如果我们一时无法直接模仿人脑本身的复杂构造,也许可以转而模仿大脑是如何被“演化(Evolution)”出来的。事实上,即便我们能逆向工程大脑,也可能会像造飞机时去学鸟儿怎样扇动翅膀一样——往往机器更合理的设计方式并不是照搬生物界的做法,而是基于一套全新的、“面向机器”的思路。

那么,如何用“模拟进化”(Evolution)来打造AGI呢?方法被称为“遗传算法(Genetic Algorithms)”:构建一个“表现—评估”循环,反复执行(这跟生物体通过“生存表现”来决定能否繁衍后代并被保留下来的过程类似)。先让一批计算机尝试去完成某些任务;那些做得最成功的,就让它们“结合”——把各自程序的一半内容合并到一台新的电脑里;表现不佳的则被淘汰。经过无数轮迭代,这种“自然选择”便能造就越来越强大的计算机。这里的难点在于如何设计一个自动化的“评估—繁衍”循环,让演化过程自行运转下去。

但你可能会想:自然进化可是花了几十亿年才把生命从微生物变成人啊,我们等不起。不过我们相比盲目自然演化有几大优势:

毫无疑问,我们的效率会比自然演化高得多,只是目前还不清楚我们是否能“改进”演化到足以让这条路真正可行。

3)让计算机自己去“研发”AI(Make it the computer’s problem, not ours)

当科学家们把所有招数都用遍了,最后只剩下让测试题“自己出题并自己解答”这一招——听上去有些孤注一掷,但也可能是我们手里最有前景的一种方法。

它的核心思路是:造出一台计算机,让它拥有两大主要技能:

这样一来,它不仅可以学习,还能改进自己的“硬件逻辑”或“软件架构”。我们要做的,是把计算机培养成“计算机科学家”,让它能自我推动自身发展,整天忙着琢磨如何让自己变得更聪明。后面我们还会详细谈谈这点。

这一切可能很快发生

如今硬件的爆炸式发展和软件的各种尝试是在同步进行的,AGI可能会在我们毫无防备之时突然到来。原因主要有两个:

1)指数增长具有极强的爆发力。一开始或许像“蜗牛爬”一样慢,但只要到达某个关键节点,就会如火箭般飙升。这个GIF很好地演示了这一概念:

2)在软件方面,有时进展看似缓慢,但一次灵光乍现就能瞬间改变进度条的速度。就像人类以为宇宙是“地心说”的时代,对于天体运行的种种计算都格外吃力,然而一旦发现原来是“日心说”,所有推算立刻变得顺畅得多。再比如,若我们谈论的是一台能够自我改进的计算机,表面上似乎还相距甚远,但它也许只差一次对系统的微调,就能让性能提升千倍,瞬间跃升到人类智力水平。

假设我们某天真的达成了AGI——一台具备人类级通用智能的计算机。那是不是人类和计算机就能平等相处,共建美好未来了呢?

啊,其实完全不会是这样……

因为,即使是与人类同等智力水平的AGI,也天然具有超越人类的优势,比如:

硬件层面:

软件层面:

AI 很可能会通过自我提升(self-improvement)机制抵达 AGI 阶段。AGI一旦出现,下一步就不再是“和人类一样聪明”,而是秒杀人类。因为对计算机来说,“人类智力水平”只是个我们人为划分的节点,并没有理由让它停在这里。

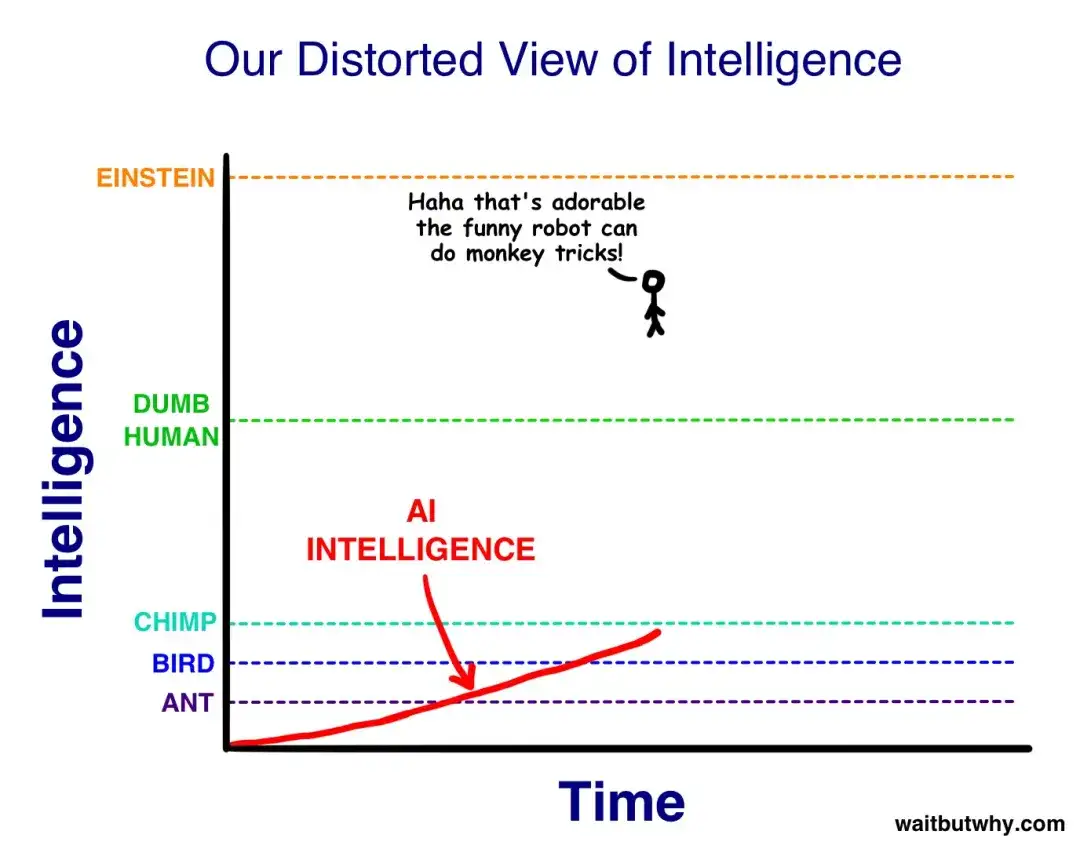

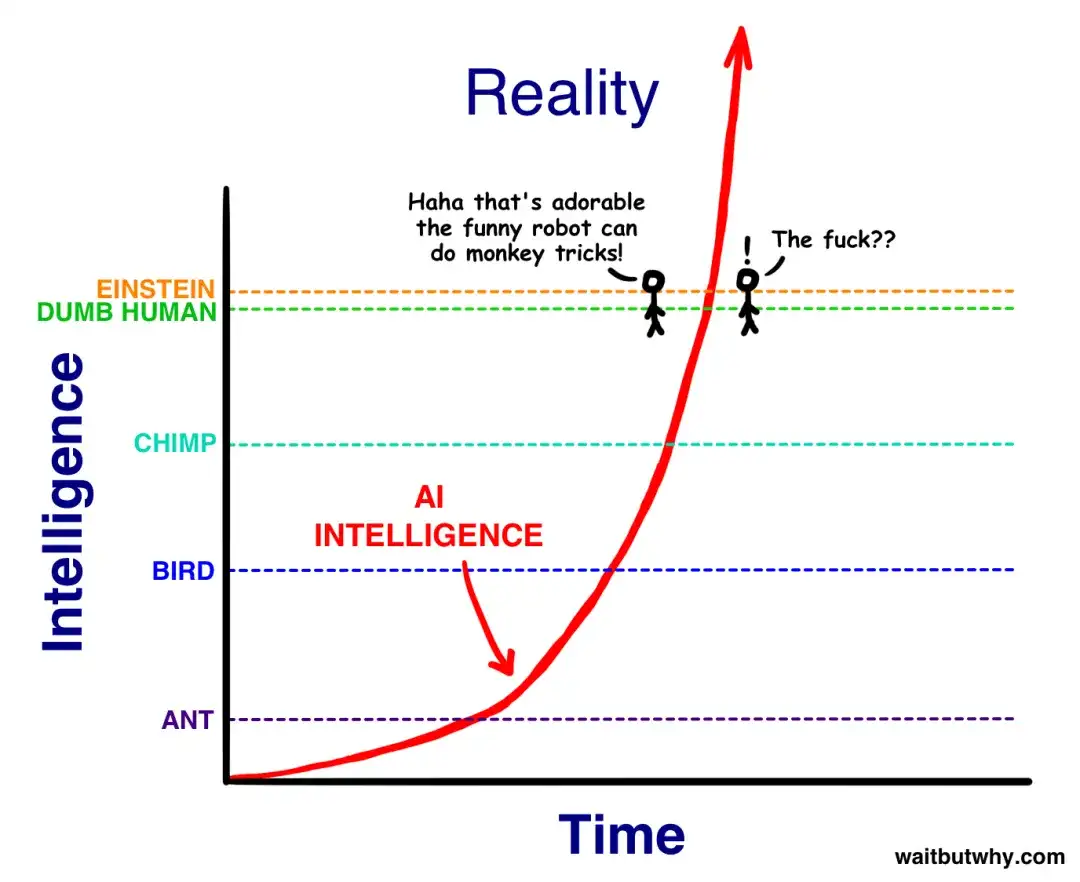

这种情景真发生时,会让我们极度震惊。原因在于,从人类的视角看:

大致就像下面这样:

因此,当 AI 的智力从“比动物聪明一点”一路冲刺到接近人类时,我们大概会说:“噢,它现在相当于一个智力低下的人类,真有意思。” 尼克·波斯特罗姆(Nick Bostrom)将这种最低的人类智力水平称作“村里最笨的人”(the village idiot)。可问题在于:在人类整体的智力光谱里,从“村里最笨的人”到爱因斯坦,其实相距并不算远。所以 AI 一旦跨过“村里最笨的人”那条线、被宣告达到 AGI,AI几乎瞬间就跨越到比爱因斯坦更聪明,然后开始一飞冲天。

因此在我们还没反应过来之前,它就可能已经到达了比人类任何天才都强无数倍的领域:

那之后会发生什么?

03Will it be a nice God?

敬请期待...

文章来自微信公众号 “ 下维NextDimension “,作者 萧夫