什么开源算法自称为DeepSeek-R1(-Zero) 框架的第一个复现?

新强化学习框架RAGEN,作者包括DeepSeek前员工Zihan Wang、斯坦福李飞飞团队等,可训练Agent在行动中深度思考。

论文一作Zihan Wang在DeepSeek期间参与了Deepseek-v2和Expert Specialized Fine-Tuning等工作,目前在美国西北大学读博。

他在介绍这项工作时上来就是一个灵魂提问:为什么你的强化学习训练总是崩溃?

而RAGEN正是探讨了使用多轮强化学习训练Agent时会出现哪些问题 ,以及如何解决这些问题。

通过大量实验,研究团队发现了训练深度推理型Agent的三大难点:

比如在单个任务上多试几次,每轮限制5-6个动作,并保持rollout的频繁更新。

甚至会出现表面看起来能完成任务,实际上只是匹配了固定模式的假象。下一步的关键在于建立更细粒度、面向解释的奖励机制。

RAGEN是一个模块化的Agent训练和评估系统,基于StarPO(State-Thinking-Actions-Reward Policy Optimization)框架,

通过多轮强化学习来优化轨迹级别的交互过程,由两个关键部分组成:

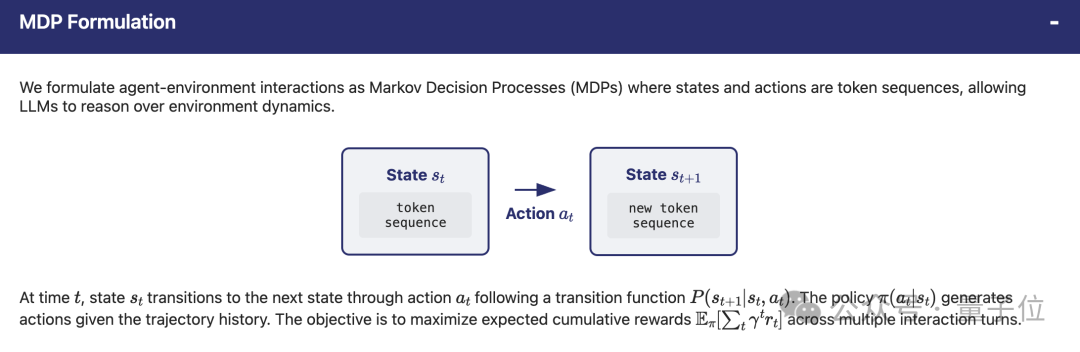

将Agent与环境的交互表述为马尔可夫决策过程 (MDP),其中状态和动作是token序列,从而允许在环境动态上推理。

StarPO是一个通用的强化学习框架,用于优化Agent的整个多轮交互轨迹,在两个阶段之间交替进行,支持在线和离线学习。

Rollout阶段:

给定初始状态,该模型会生成多条轨迹。在每一步中,模型都会接收轨迹历史记录并生成推理引导的动作。

<think>...reasoning process...</think><ans> action </ans>

环境接收动作并返回反馈(奖励和下一个状态)。

Update阶段:多回合轨迹优化

生成轨迹后,训练优化预期奖励。StarPO并非采用逐步优化的方式,而是使用重要性采样来优化整个轨迹。

这种方法能够在保持计算效率的同时实现长远推理。

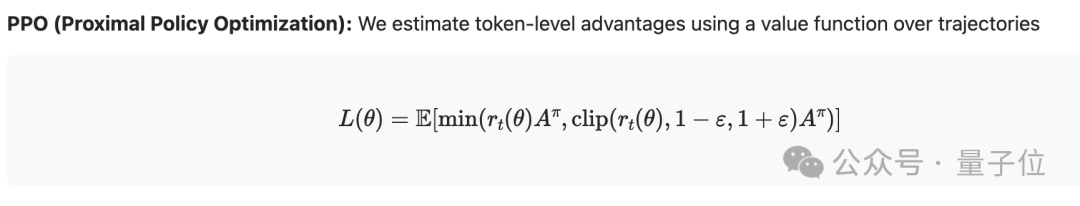

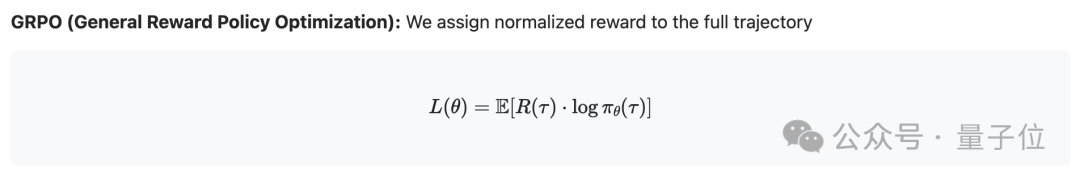

StarPO支持PPO、GRPO等多种优化策略。

除提出算法外,RAGEN论文中还重点介绍了通过研究推理稳定性和强化学习动态得出的6点主要发现。

发现1:多轮训练引入了新的不稳定模式

像PPO和GRPO这样的单轮强化学习方法的adaptations在Agent任务中有效,但经常会崩溃。

PPO中的“批评者”或许可以**延缓不稳定性,但无法阻止推理能力的下降,这凸显了在Agent任务中对专门的稳定性进行改进的必要性。

发现2:Agent强化学习中的模型崩溃体现为训练过程中的“回声陷阱”

早期智能体会以多样化的符号推理做出反应,但训练后会陷入确定性、重复性的模板。

模型会收敛到固定的措辞,这表明强化学习可能会强化表面模式而非一般推理,并形成阻碍长期泛化的“回声陷阱”。

发现3:崩溃遵循类似的动态,可以通过指标预测

奖励的标准差和熵通常会在性能下降之前发生波动,而梯度范数的峰值通常标志着不可逆崩溃的临界点。这些指标提供了早期指标,并激发了对稳定策略的需求。

发现4:基于不确定性的过滤提高了训练的稳定性和效率

基于奖励方差过滤训练数据可以有效对抗“回声陷阱”。仅保留高度不确定的训练实例可以延迟或防止跨任务崩溃,并提高数据效率。

发现5:任务多样性、行动预算和推出频率影响数据质量

多样化的任务实例能够实现更好的策略对比和跨环境泛化。合适的行动预算能够提供充足的规划空间,并避免过长序列引入的噪声。

Up-to-date rollouts能够确保优化目标与当前策略行为保持一致。

发现6:如果没有精心的奖励设计,推理行为就无法产生

虽然符号推理在弱监督下的单轮任务中自然出现,但在多轮环境中,如果没有明确鼓励可解释的中间推理步骤的奖励设计,它就无法持续存在。

团队观察到,即使有结构化的提示,如果奖励信号仅关注最终结果,推理能力也会在训练过程中逐渐衰退。

这表明如果没有细致的奖励塑造,智能体可能会倾向于走捷径,完全绕过推理。

同团队还有另一个项目VAGEN,使用多轮强化学习训练多模态Agent。

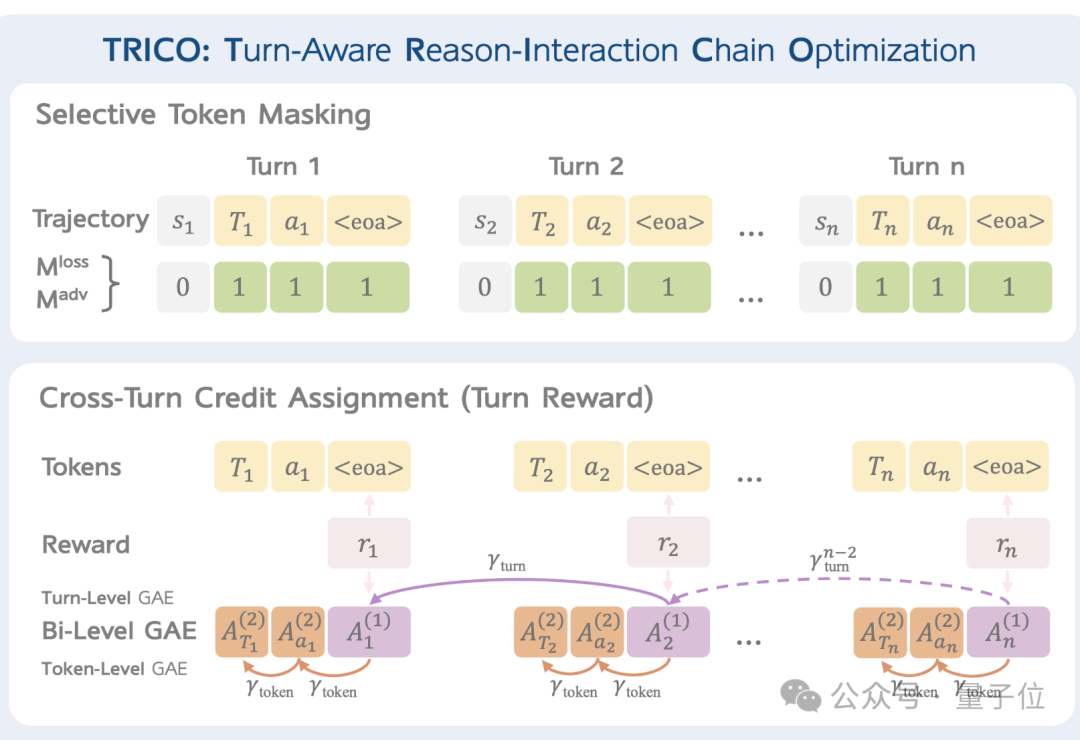

VAGEN 引入了回合感知推理交互链优化 (TRICO) 算法,通过两项关键创新扩展了传统的RICO方法:选择性token屏蔽,跨轮credit分配。

与传统的Agent强化学习相比,VAGEN不会平等对待轨迹中的所有token,

而是重点优化最关键的决策token并在交互过程中创建更细致的奖励结构,更适合多模态Agent

RAGEN、VAGEN代码均已开源,感兴趣的团队可以跑起来了。

论文:

https://github.com/RAGEN-AI/RAGEN/blob/main/RAGEN.pdf

代码

https://github.com/RAGEN-AI/RAGEN

https://github.com/RAGEN-AI/VAGEN

参考链接:

[1]https://ragen-ai.github.io

[2]https://x.com/wzihanw/status/1915052871474712858

文章来自于微信公众号 “量子位”,作者 :梦晨

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI