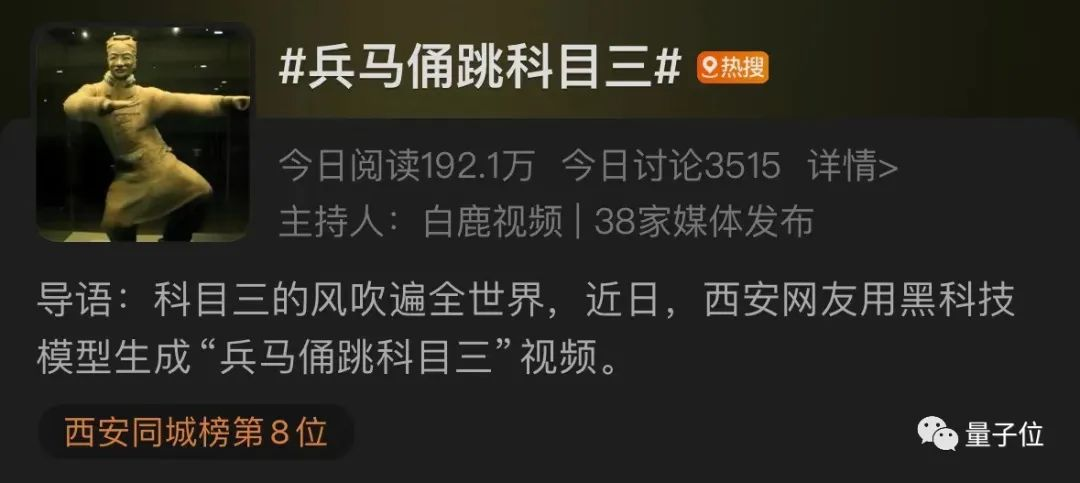

家人们,火爆全球的魔性舞蹈《科目三》,谁能料到,就连兵马俑也开始跳上了!

热度还居高不下,瞬间被轰上了热搜,小伙伴们纷纷惊掉了下巴表示“闻所未闻,见所未见”。

这到底是怎么一回事?

原来,是有人借助了阿里之前走红的AI技术——AnimateAnyone,生成出来了这个舞蹈片段。

技术圈的盆友对这个技术都不陌生,“出道”至今仅仅1个月时间,这个项目便已经在GitHub上斩获了超1.1万个star。

呼唤它能让更多人轻松上手体验的声音,也越来越多。

好消息是,现在AnimateAnyone已经可以免费体验了!

而且“入口”还直接被嵌进了阿里通义千问APP——名曰:通义舞王。

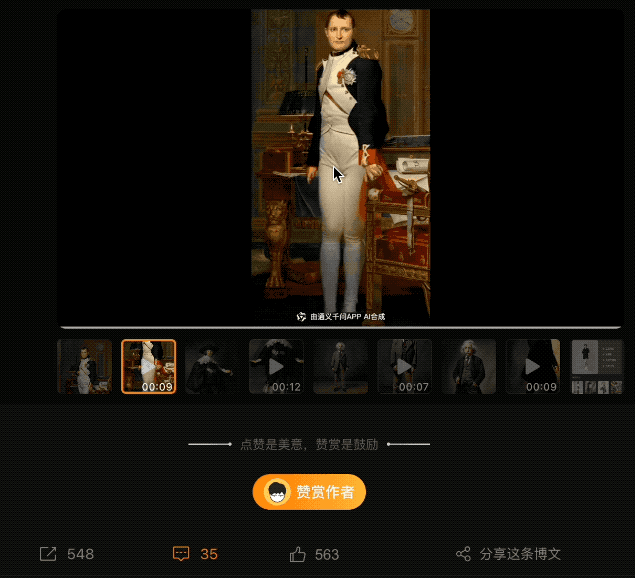

很快,各种效果、各种玩法、各种人物,都动了起来……例如微博网友“Simon_阿文”,让拿破仑表演了一把……

这标致的舞姿,这反差的形象,着实算是把脑洞给打开了。

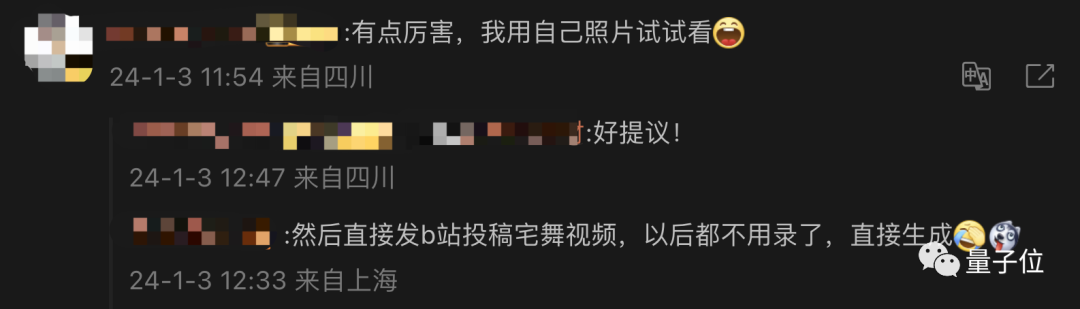

也有不少网友换了个思路:

想用自己照片试试;以后投宅舞视频可以直接生成了。

所以效果究竟行不行,我们也忍不住实测了一波~

打开通义千问APP,我们只需要点击对话框中的“一张照片来跳舞”:

或者在输入框内敲“通义舞王”或“全民舞王”等关键词,就可以跳转到相应界面了:

接下来的操作,也正如我们刚才所说:极、其、简、单。

首先,在众多已经提供的模板中,pick一个。

目前通义千问APP提供了12个模板,这次我们就选择二次元最爱、宅舞《极乐净土》测试一下~

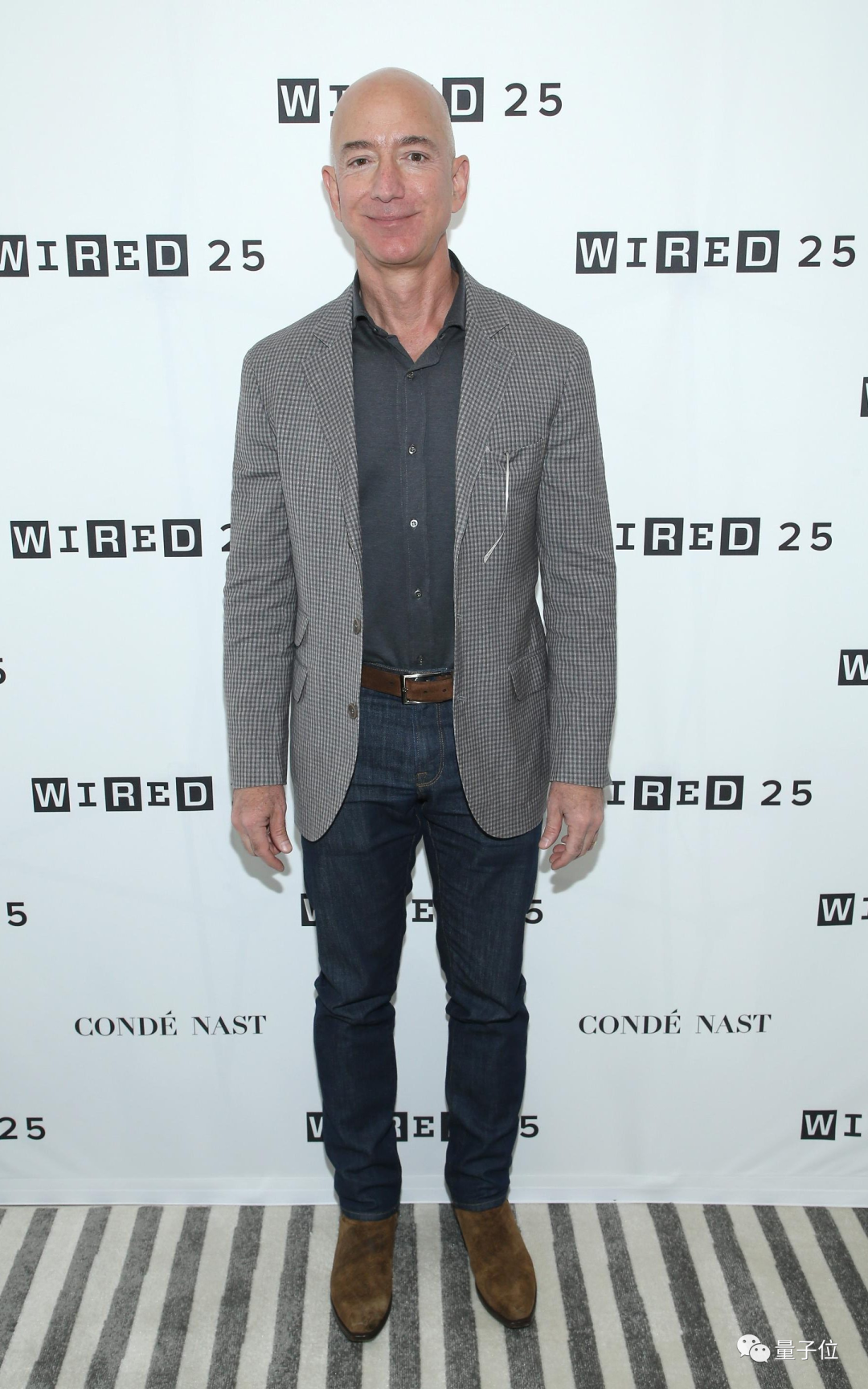

然后,选一位测试对象。比如我们找了(前)全球首富贝佐斯:

需要说明的是,在选择照片的时候,还是需要一点“技巧”的,“通义舞王”也有相应提示:

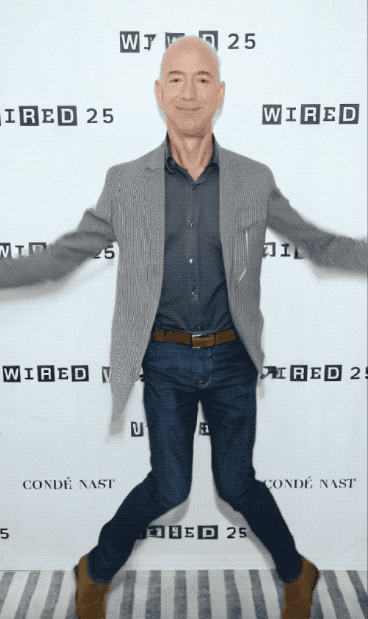

在此之后,直接点击“立即生成”,静候几分钟,贝佐斯大跳《极乐净土》的视频,就诞生了:

是不是效果还行?虽然还不能讲“真假难辨”,但首富都能这样为你跳一曲了,还要什么自行车。

不仅如此,“通义舞王”除了能够生成真人风格之外,还有其他风格可玩。

例如动漫风格的小姐姐跳DJ慢摇:

还有卡通风格的人物热舞:

总而言之,现在你想让任何人跳舞——一张全身照就够了。

不过有一说一,虽然“通义舞王”已经成功吸引了众多网友前来玩耍,反响火爆,但它也还没到完美无瑕的境界。

例如等待时长,现在平均时间大约在10分钟左右(有点久,但毕竟是免费的,还要啥自行车啊)。

还有就是从视频效果来看,如果照片角度不好或者清晰度不够也会影响AI对于人物手部的处理。

这些问题,实际都与背后的技术原理和技术挑战,密不可分。

在视觉生成任务中,目前较为主流的方法便是扩散模型。

但在仅靠一张照片就生成视频这件事上,它还面临着诸多的挑战,例如人物形象一致性(consistency)的问题。

简单来说,就是如何保证照片人物在动起来的过程中,各种细节能够和原照片保持一致。

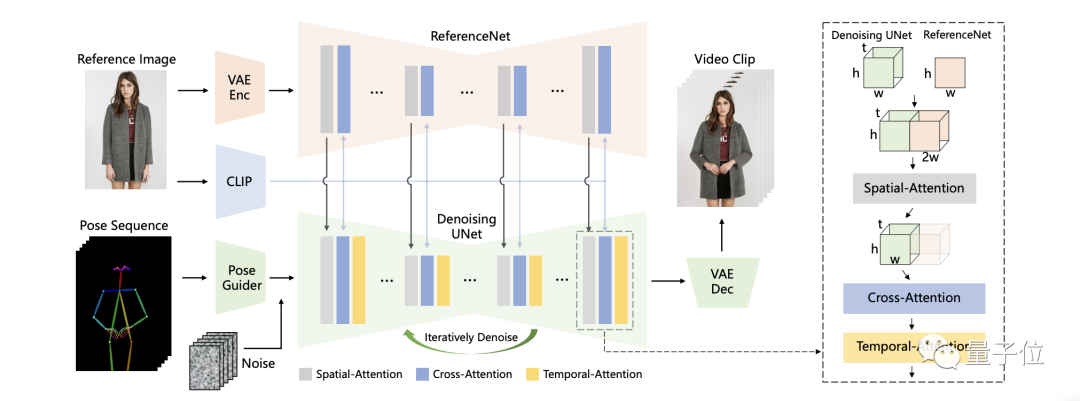

为此,阿里团队在扩散模型的基础之上,提出了一个新的算法,也就是我们刚才提到的AnimateAnyone。

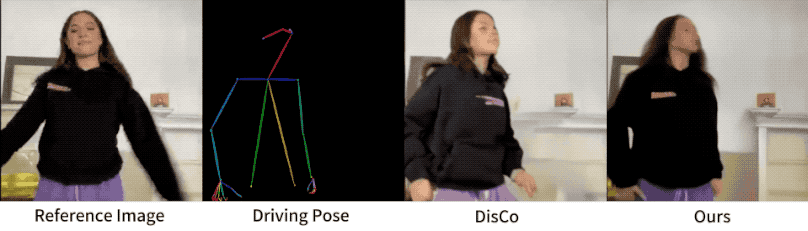

从一致性、可控性和稳定性三个方面,保证了视频输出的效果和质量。

例如在一致性方面,阿里团队引入的是ReferenceNet,用于捕捉和保留原图像信息,可高度还原人物、表情及服装细节。

具体而言,在参考图特征提取上,ReferenceNet采用的是与去噪UNet类似的框架,但没有包含时间层;它继承了原始扩散模型的权重,并独立进行权重更新。

在将ReferenceNet的特征融合到去噪UNet时,首先将来自ReferenceNet的特征图x2复制t次,并与去噪UNet的特征图x1沿w维度连接;然后进行自注意力处理,并提取特征图的前半部分作为输出。

虽然ReferenceNet引入了与去噪UNet相当数量的参数,但在基于扩散的视频生成中,所有视频帧都需要多次去噪,而ReferenceNet只需在整个过程中提取一次特征,因此在推理过程中不会导致显著增加计算开销。

在可控性方面,阿里团队使用的是Pose Guider姿态引导器。

Pose Guider姿势引导器采用的是一个轻量级设计,而不是引入一个额外的控制网络。

具体来说,使用了四个卷积层(卷积核大小为4×4,步幅为2×2,通道数分别为16、32、64、128),这些卷积层用于将姿势图像对齐到与噪声潜变量相同的分辨率。

处理后的姿势图像会被加到噪声潜变量上,然后一起输入到去噪UNet中,从而在不显著增加计算复杂性的情况下,为去噪UNet提供姿势控制。

最后是在稳定性方面,阿里团队引入的是一个时序生成模块。

时序层的设计灵感来源于AnimateDiff,通过在特征图上执行时间维度的自注意力,以及通过残差连接,其特征被整合到原始特征中。

同样的,这个模块的作用之下,满足了在保持时间连续性和细节平滑性的同时,减少了对复杂运动建模的需求。

最终,在AnimateAnyone的加持之下,从效果上来看,保证了图像与视频中人物的一致性。

这也是AnimateAnyone背后的技术原理。

然而,阿里之所以不断在AnimateAnyone上攻坚优化,并非完全出于技术很酷很有潜力,还藏着一颗引领视频生成技术的野心。

因为大家都在问“What is the Next?”的时候,LVM(Large Vision Model),已经潮水声轰鸣了。

实际上,在AnimateAnyone火了之后,阿里还有另一项视频生成技术在同时出圈。

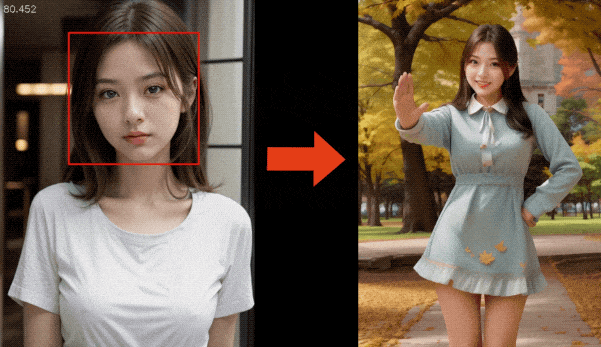

它叫DreaMoving,只需一张脸部照片、一句话描述,就能让你在任何地方跳舞!

例如下面这段《擦玻璃》的舞蹈视频:

你所需要做的就是“投喂”一张人像,以及一段prompt:

一个女孩,微笑着,在秋天的金色树叶中跳舞,穿着浅蓝色的连衣裙。

而且随着prompt的变化,人物背景和身上的衣服也会随之发生改变。例如我们再换两句:

一个女孩,微笑着,在木屋里跳舞,穿着毛衣和长裤。

一个女孩,微笑着,在时代广场跳舞,穿着连衣裙般的白衬衫,长袖,长裤。

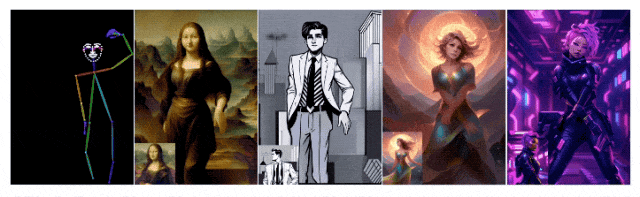

和AnimateAnyone一样的,它也是真人、卡通、动漫人物统统都能hold住。

当时也引来了不少网友们的热玩和惊呼。

这些都是阿里在视频生成上的“沿途下蛋”,都是“勇攀珠峰”——死磕AI视频生成技术的证明和结果。

为什么?

因为纵观去年一整年的AIGC发展的脉络,AI视频生成的爆发趋势似乎越来越明确了。

2022年底以来,从最初ChatGPT引爆大语言模型,全球科技巨头乃至初创企业纷纷入局,到后来各家不仅限于自然语言技术,更是将文生图、文生音频、文生视频、图生视频等多模态技术“玩”出了新高度。

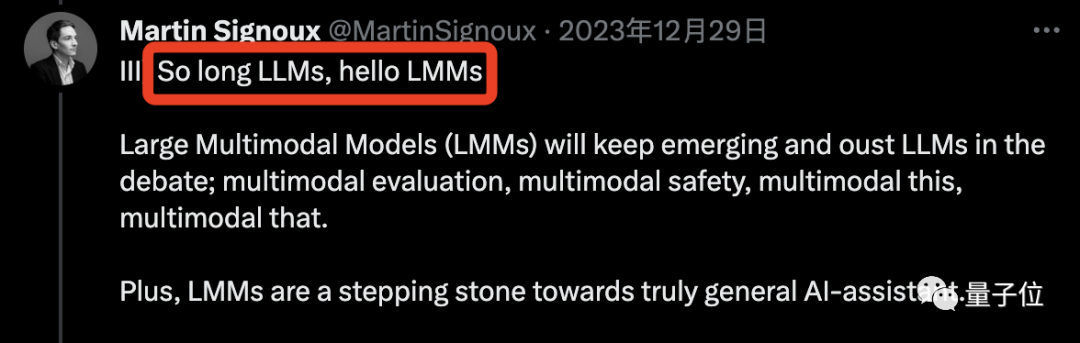

产业是什么?LLM(大语言模型)正在逐步向LMM(多模态大模型)发展。

并且从这期间学术界、产业界所交出的一份份“作业”中,也能印证这一点:

因此,多模态大模型、AI视频生成领域,正是现如今AIGC这波顶流中的顶流,阿里频频在此发力,也就不难理解了。

不仅如此,在岁末年初之际,更是有众多AI大佬将2024年的预测押注于此。

例如Meta研究院Martin Signoux非常直接地表态“再见LLM,你好LMM”,这个预测也得到了LeCun的转发和点赞。

因此,如果要问谁是下一个ChatGPT,可能没有人可以给出准确预判。

但如果问下一个ChatGPT会从哪个赛道来?AI视频生成,就是自带鼓风机的那一个,而在这个赛道里,阿里已经抢占了先机。

参考链接:

[1]https://weibo.com/1757693565/NA6OhoCo2#comment

[2]https://weibo.com/2099591797/NA8fX0eOE?refer_flag=1001030103_

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0