刚刚,三星版“豆包AI手机”,来了【附现场体验】

刚刚,三星版“豆包AI手机”,来了【附现场体验】北京时间今天凌晨,三星正式发布了年度旗舰新机Galaxy S26系列,这也是三星第三代AI手机,其重点提升了AI、影像、性能等方面的能力。发布会后,智东西第一时间上手体验了最新的三星旗舰机,其在视频防抖、AI视频问答、AI智能执行方面都给我留下了深刻印象。

北京时间今天凌晨,三星正式发布了年度旗舰新机Galaxy S26系列,这也是三星第三代AI手机,其重点提升了AI、影像、性能等方面的能力。发布会后,智东西第一时间上手体验了最新的三星旗舰机,其在视频防抖、AI视频问答、AI智能执行方面都给我留下了深刻印象。

xAI的Grok图像转视频模型(grok-image-video-720p)登顶「Image-to-Video Arena」排行榜,以1404分的超高ELO评分力压群雄,位居第一。马斯克亲自发帖为自家Grok Image模型站台,称它每周都在迭代优化。

从电商团队到视觉设计师,如今任何人都能在几分钟内生成数百张可投入生产的图片。几年前,这样的产量需要数千名摄影师、工作室和制作人员。长期以来支配电商及其他数字领域的成本结构已经发生了转变。传统的内容生产

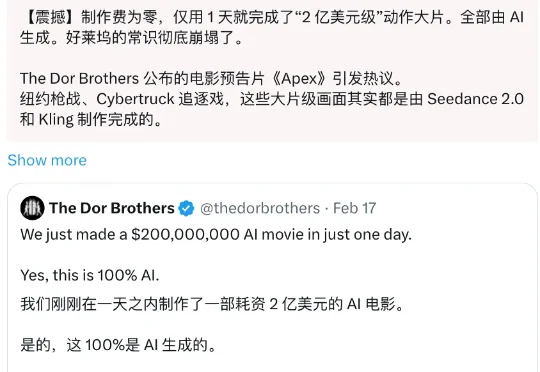

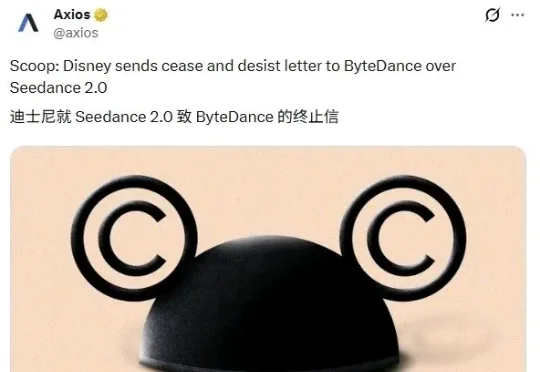

「我们刚刚在一天之内制作了一部耗资 2 亿美元的 AI 电影。 100% 是 AI 生成的」。在我们走进电影院观看春节档时,一条三分钟的电影预告片在海外刷屏了,这个看起来堪称好莱坞 A 级制作的大片,居然是完全是 AI 制作的。

进入 AI 时代之后,这件事开始被反复拿出来讨论。如果内容不只是被看,而是可以被「操作」、被「玩」,那它还算不算我们熟悉的内容平台?最近一两天,这个问题突然被推到了舆论场的正中央。

昨天春晚张杰献唱的《驭风歌》大家都听了吧?气势是相当磅礴了。但你知道吗?其实这首歌的表演,背后还有一个AI彩蛋:没错,就是背景视频里那幅流动的巨型水墨画卷中,那一群气势磅礴、奔腾而来的骏马——

2026年2月12日,字节跳动正式发布新一代AI视频生成模型Seedance 2.0,同步接入豆包App、即梦App等平台,凭借广播级画质、丝滑运镜、多镜头叙事控制的工业级生成能力,迅速引发全球行业关注。

爆红社交平台、登顶全球评测,中国AI视频模型集体破圈。

解析Vidu Q3:AI视频生成下半场,拼的是“可交付”。

这家AI独角兽累计拿下56亿融资。