中国也有了世界第一的模型,他的名字,叫Seedance 2.0。

中国也有了世界第一的模型,他的名字,叫Seedance 2.0。Seedance2.0的火,已经烧了好几天了。

Seedance2.0的火,已经烧了好几天了。

Seedance 2.0用了两天,个人感想是,以下几类人群或即将失业:一、把「学好提示词」奉为圭臬,并开班传授佶屈聱牙反逻辑长难句prompt的AI导师。二、成本只有一个自拍杆的所谓短视频博主。三、刚开始做AI社交的小创业者。

晚上躺床上在刷资讯的时候,发现马斯克转帖并表态了一个搞怪视频。大致意思就是,让你选世界上最好的模型是什么?Grok 还是 Others,然后一直点不到 Grok,按钮越来越小。点到之后,马斯克开始跳舞。

这两天,AI 视频圈被偷摸摸上线的 Seedance 2.0 刷屏了。在 AI 视频领域颇有影响力的博主海辛,在即刻分享了自己对它的观点:「Seedance 2.0 是我 26 年来最大的震撼」、「我觉得它碾压 Sora2」。

2月7日,字节跳动AI视频生成模型Seedance2.0开启灰度测试,该模型支持文本、图片、视频、音频素材输入,可以完成自分镜和自运镜,镜头移动后人物特征能够保持一致。

梦瑶 发自 凹非寺 量子位 | 公众号 QbitAI 不是,谁也没跟我说今年的AI春节大战搞得这么猛猛猛啊!?! 年还没到呢,可灵就超绝不经意甩出一个「过大年计划」:推出可灵3.0多模态全家桶。 让每

就在刚刚,可灵更新了,更了个大的。

今天,北京多模态生成技术创企生数科技宣布完成超过6亿元人民币A+轮融资。生数科技还披露,2025年该公司实现用户和收入超10倍增长,用户和业务覆盖全球200多个国家和地区。

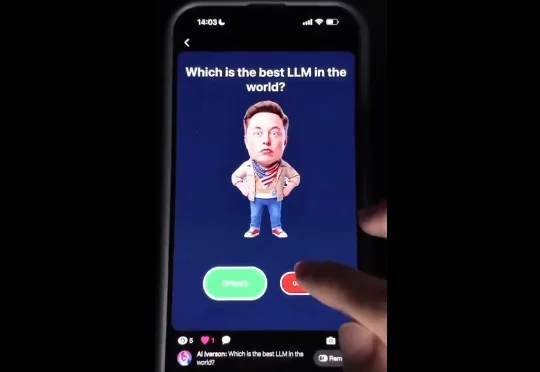

xAI“迄今为止最强大的视频音频生成模型”Grok Imagine 1.0版本,正式全面上线。

找准PMF,比创意更重要