超越OpenAI!

国产大模型突袭,AI语音生成天花板被重新定义了。

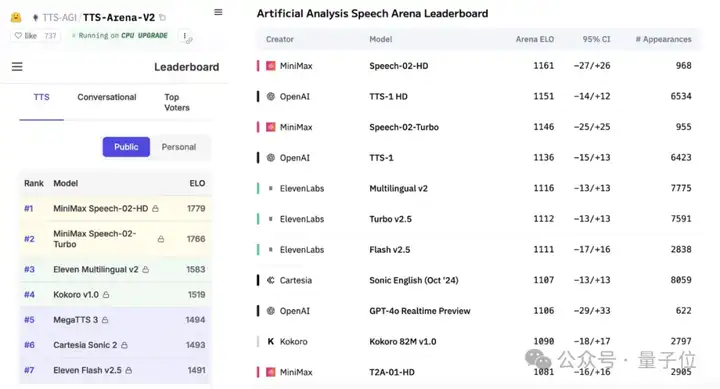

MiniMax最新发布Speech-02,同时拿下Artificial Analysis Speech Arena和Hugging Face TTS Arena两项全球权威语音基准测评第一!

而且还是榜单前十名中唯一的国产玩家。

要知道,这俩榜首长期被OpenAI、ElevenLabs占据,前者不用多介绍,公认的AI领域全球NO.1梯队成员,后者也是专精AI语音合成赛道的领军玩家。

具体效果如何?一手实测在此:

用专业播音腔读一读量子位的文章?So easy~

直接根据文章内容配上相应的语气和情绪,中英混杂轻松搞定,各种停顿和重音,完全就是顶级新闻播报员的感觉。

还能让霉霉为我们读论文。不仅是熟悉的美音,而且非常还原她个人特点。

如上效果,只需几秒语音参考,即可让大模型当场完成超逼真复刻。

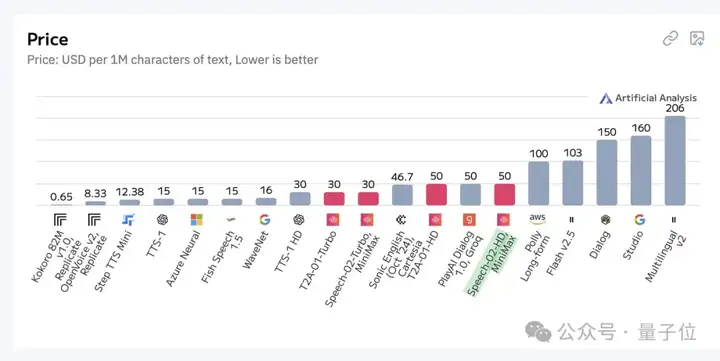

并且在提供SOTA级性能同时,定价仅为ElevenLabs的一半甚至四分之一,性价比也称得上“全球SOTA”了。

如此能力,不少人其实不知不觉体验到了。

比如前段时间大火的吴彦祖陪你学英语中的“AI阿祖”,底层能力正是来自MiniMax。

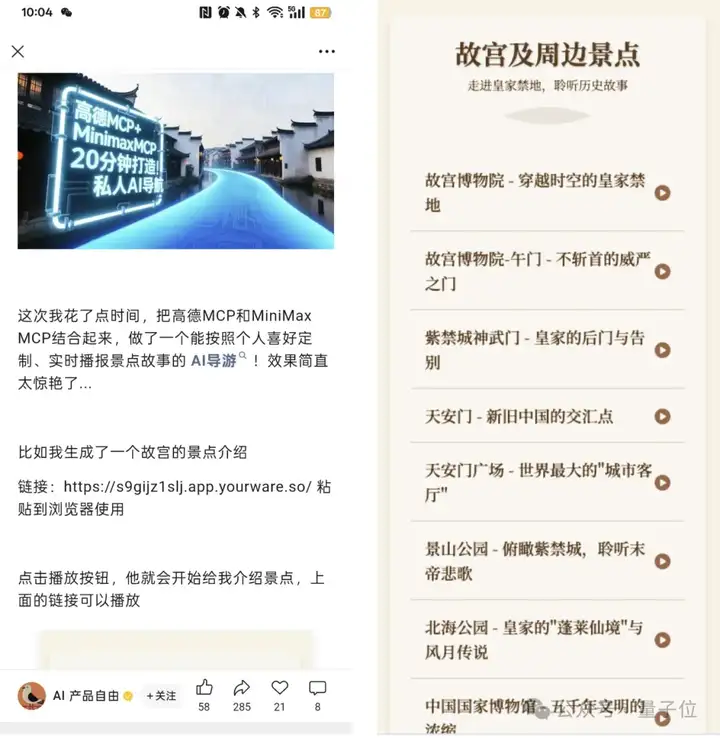

还有个人开发者打造的出圈案例——故宫AI向导,正是基于MiniMax MCP Server,支持通过简单文本输入,完成图像、语音、视频生成以及声音克隆等多项能力。其中语音生成与克隆的能力,就是靠MiniMax Speech模型完成。

果然,MiniMax还是一如既往闷声搞大事啊。

那么借着这次语音模型重磅更新,来扒一扒MiniMax是如何发起突袭的。

总结来看,Speech-02兼顾了三方面亮点:

首先,在最关键的“超拟人”方面,Speech-02的还原度不说是100%,也几乎是天衣无缝了。

比如这段脱口秀,无论是中文咬字还是英文发音,都非常完美。同时还带有自然的情绪起伏、停顿和重音,给人以更丰富的听觉感受。

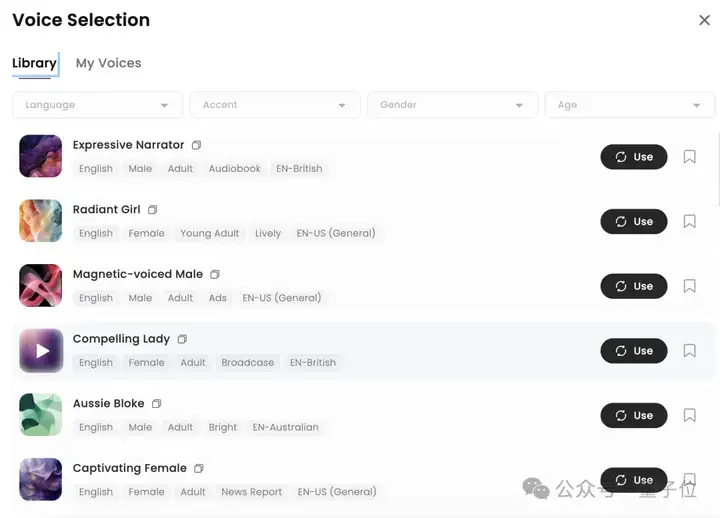

其次在个性化方面,Speech-02现在已经提供了丰富音色可供选择。

细分维度包括语言、口音、性别和年龄。目前已经支持32种语言。中英文这样常用的选项里,还包含不同的口音。

同时,它也支持对任意音色进行复刻。

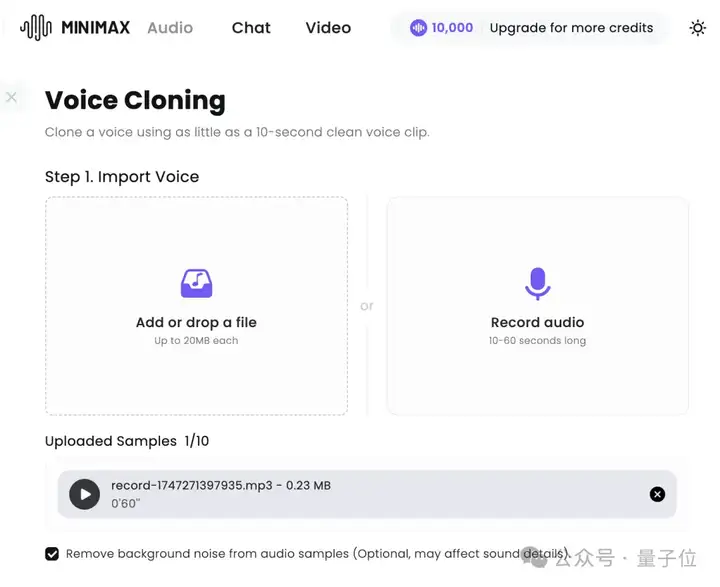

由于不局限于只学习精品音色,它具备极强泛化能力,最少只需听10秒参考样本,即可完成对一种说话人声音的模仿。而且还支持对音色进行进一步细节调整。

以声音参考这一功能为例(这一功能在国内仅对B端用户开放),只需提供10-300秒声音参考样本,Speech-02就可以开始完成复刻。上传文件or直接录音都可以。也就是说,对着模型说几句话,它就已经能学会你的音色了。

它支持自动剔除背景噪音,对上传音频的质量要求不高。

比如生成霉霉音色时,我们使用了她在纽约大学演讲的片段,其中包含了掌声、欢呼声等噪音影响,但是对生成结果的影响很小。

此外还支持情绪等更细微的调整,能满足专业领域人士的需求。

最后,在多样性方面,Speech-02可以支持32种语言。

不仅支持不同语言之间无缝切换,而且在音色生成时就可以完成语种跨越。比如喂给它霉霉英文语音素材,让它生成中文版音色。

生成的语音也支持多语言之间无缝切换,如下是英语、西班牙语之间切换。

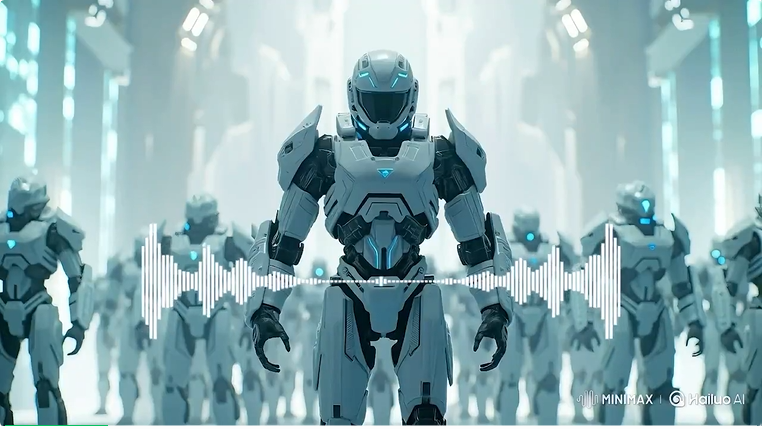

由此几方面优势结合,用Speech-02完成电影级配音,也不是问题了。

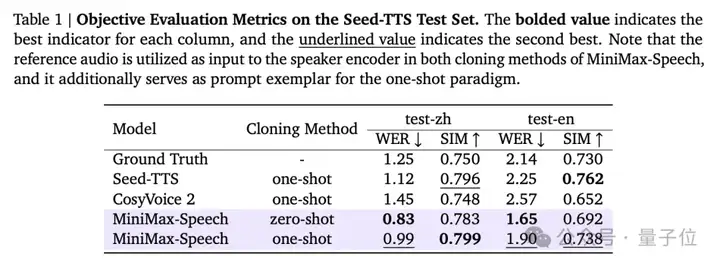

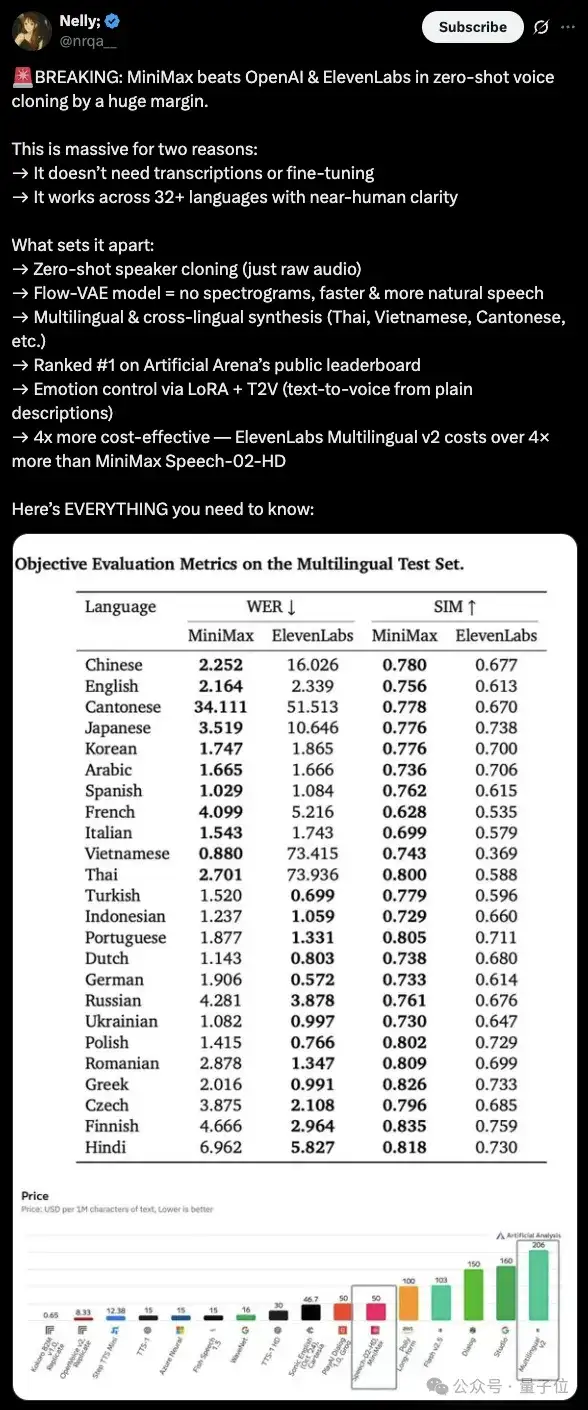

从数据维度看,Speech-02的表现也是全方位碾压。

通过词错误率(WER)和说话者相似度(SIM)两个维度,在Seed-TTS Test数据集上,Speech-02在零样本克隆中实现了更低词错误率,one-shot下SIM得分与真实音频(Ground Truth)相当,表明模型能够有效提取和保留说话者音色特色。

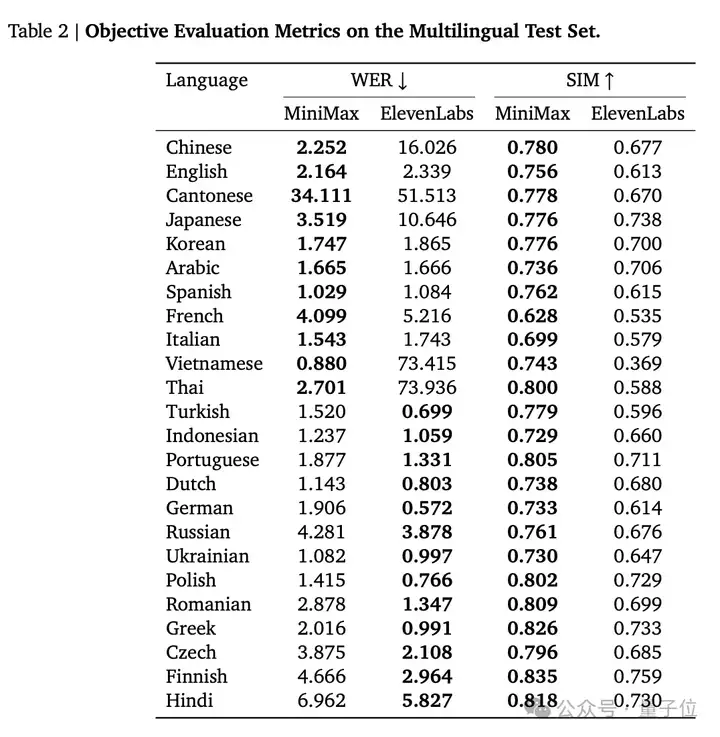

在多语言评估上,Speech-02在包含24种语言的测试集上,它的WER表现与ElevenLabs Multilingual v2相当,在中文、粤语、泰语、越南语和日语等复杂语言中表现更好,甚至在英语上也完成了对ElevenLabs的全线超越。

在SIM方面,MiniMax-Speech在所有测试语言中均优于ElevenLabs Multilingual v2,表明其说话者编码器和合成流程在保留说话者身份方面更为有效。

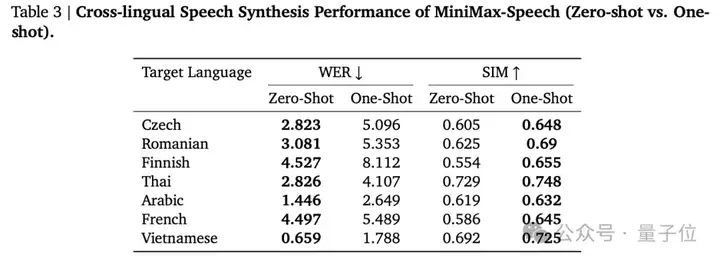

A语音音频直接克隆至B语言语音,MiniMax-Speech的zero-shot在所有测试语言中都实现了更低WER,发音准确度最高。

所以,Speech-02为啥这么强?

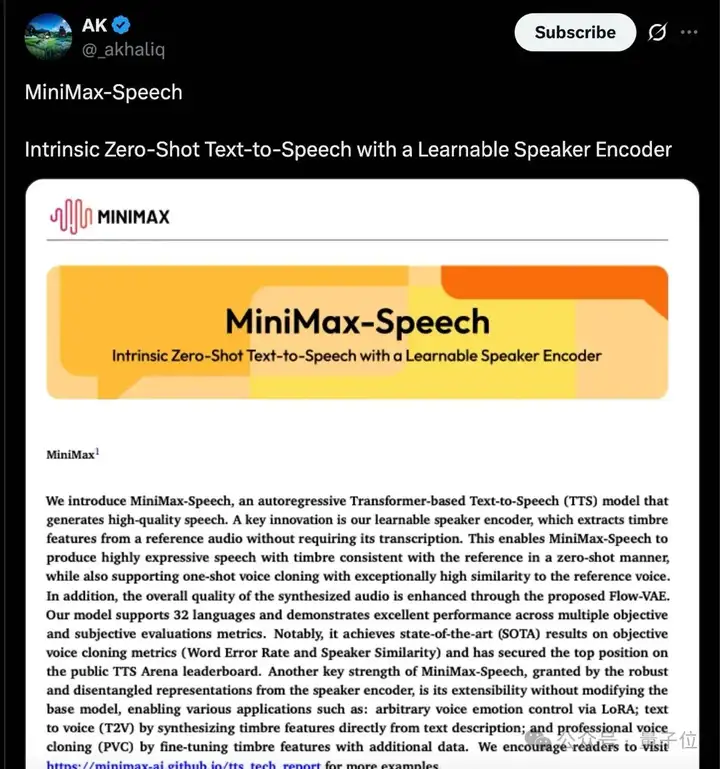

还得看技术细节。目前Speech-02论文已全面公开,还被很多海外AI博主关注到了。

从技术维度,Speech-02实现了只需极少样本、甚至在没有训练数据的情况下,仅通过参考音频,就能生成与目标说话人极为相似的音色,并且可以转换成多种语种。

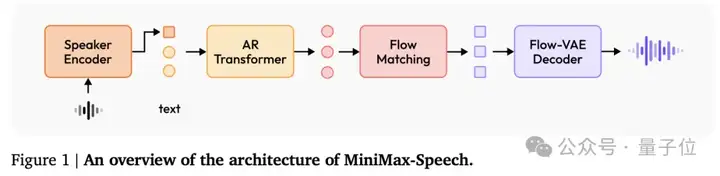

具体而言,它使用了基于自回归Transformer的架构。

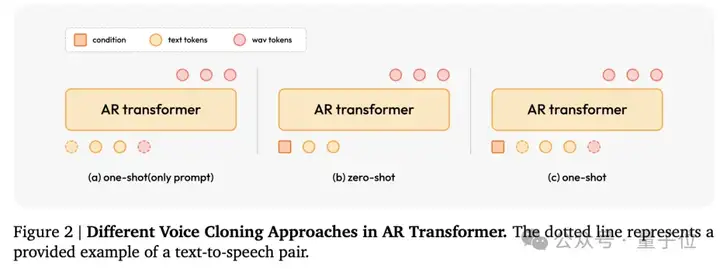

大多数自回归TTS在语音克隆中需要语音和对应文字转录作为提示。提示语音和目标语音在语义或语言上存在不匹配、解码长度限制等问题,往往会造成生成质量欠佳。

为此,Speech-02引入了独特的可学习说话者编码器(Learnable Speaker Encoder),直接与TTS模型一起训练。输入仅为一段参考音频,输出为一个固定大小的“声音特征向量”。

核心解决了三方面问题:

1、无需参考文本即可通过语音提示实现零样本语音克隆;

2、跨语言语音生成,它只关注声音的特征而不关心语音内容,因此即使参考音频是英文,但是也可以使用该音色直接生成其他语言的语音;

3、根据生成任务实际需求,提取出对音质和相似度更有用的特征。

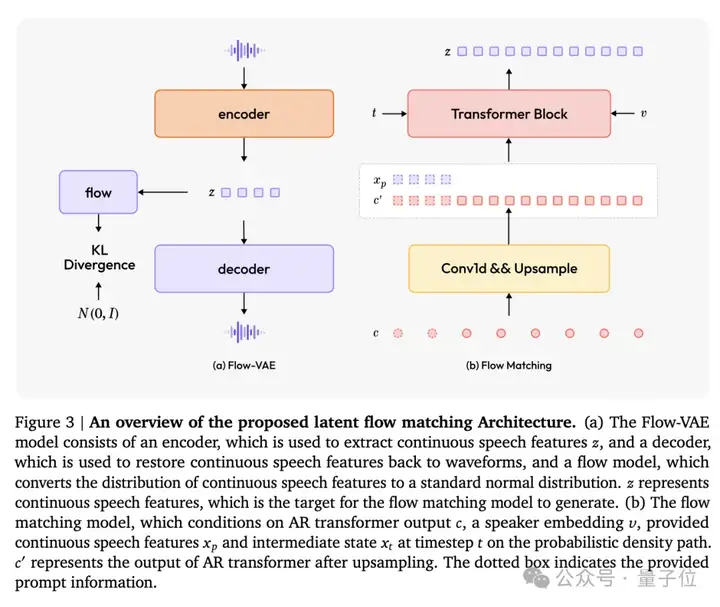

模型另一个重要创新在于引入了基于Flow-VAE的流匹配模型,进一步提升了生成语音的音质和说话人相似性。

VAE(Variational Autoencoder)用来学习语音的潜在特征表示(比如音色、韵律、情感等),它通常假设潜在空间服从标准正态分布,这可能会限制模型对复杂数据分布的建模能力。

由此引入Flow模型,通过一系列可逆转换,将潜在空间映射到更复杂的分布,从而更准确地捕捉数据中的复杂结构和分布特性。

此外,研究团队还探索了模型的多种下游应用。比如通过LoRA实现对合成语音情感更精细控制、文本驱动音色生成以及专业语音克隆(通过微调参数为特定说话人生成更高保真度语音)。

不过,技术上领先还只是其一,在AI语音行业落地上,MiniMax也已悄悄领先。

落地案例多元、跨行业、全球化。与不同行业玩家共同开拓AI语音的应用前景。具体包括:

比如在教育领域,MiniMax与高途共同探索出了24小时可定制化的AI语言陪练系统。

最近全网爆火的“吴彦祖教你学口语”中的“AI阿祖”,就是基于此实现,通过对吴彦祖音色精品复刻,在高途推出的吴彦祖英语课中,AI阿祖可以24小时随时在线陪练。

在智能座舱方面,MiniMax多个大模型已入驻极狐汽车,为用户提供即时问答服务。

值得一提的是,作为大模型技术厂商,MiniMax还一直与不同行业玩家共创,开拓AI应用边界、激发场景创新。

在一些前沿落地场景里,总能看到MiniMax。

比如大模型趋势下爆火的AI玩具领域,MiniMax为热度top1的跃然创新haivivi提供底层语音合成和文本模型能力。支持BubblePal能够随时灵活回答小朋友们的“十万个为什么”。

基于MiniMax语音能力的「AI语音挂件」(售价399-449元),上线2个月销量突破2万台。

AI教育硬件方面,MiniMax为听力熊团队提供底层模型支持,专为青少年解决学习、生活中的各种问题,不局限于问题回答,还可以进行适当的反馈和情感表达,兼顾教育与陪伴场景。听力熊AI听说学习机T6已接入。

更为新鲜的,MiniMax与香港电视台尝试了使用语音模型的粤语能力做天气预报,进一步开拓落地场景。

在海外也与Hedra合作,打造了可以定制化的数字角色分身。

可以明显感知到,MiniMax不仅在商业价值已得到初步验证的领域积极落地,也重点关注了AI语音在更多新场景的应用,推动技术创新同时更为行业带来新价值。

可以感知到,与MiniMax达成合作的行业玩家中,不乏领域内领军者,更有很多来自新兴赛道。前者的落地价值已经初步被验证,后者则蕴藏着巨大潜力。

所以,为啥它们不约而同选择MiniMax?

技术领先性是最首要的。MiniMax是AI领域头部玩家,在大模型技术浪潮之前,已经抢先布局自研多个模态的基础模型,覆盖文本、语音、视觉三大领域。

显然在AI语音领域,MiniMax长线布局,而且一直走在行业前沿。

而且,MiniMax还有天然的技术试炼场——星野、Talkie等。这意味着,MiniMax更懂实际落地、更懂如何将实验室中的前沿技术输送到用户面前。所以,MiniMax也是国内最早用大模型架构提供语音服务的公司。

这或许也是为何MiniMax始终低调,但又一直被行业青睐。

而透过这次动作,MiniMax的布局战略,也呈现出更清晰的全貌——

布局全模态,且纷纷拿下SOTA。

以最初的三大基础模型为起点,MiniMax在短短2年时间内已经完成了对全模态能力的完整布局。

文本方面,MiniMax打破了传统Transformer架构限制,首次大规模实现了线性注意力机制,这种架构创新极大地提升了模型的计算效率,降低了成本,尤其在处理超长文本场景中,展现出显著的可扩展性。这也是对Agent时代进行抢先押注,从中也足见MiniMax领先于行业的技术。

就在年初,MiniMax还完成了MiniMax-01系列开源,包含两个模型,基础语言大模型 MiniMax-Text-01 和视觉多模态大模型 MiniMax-VL-01,为开源社区提供优质选择。

语音方面,随着Speech-02发布,MiniMax在AI语音领域的领先地位更加不可动摇。

视频方面,海螺AI已经是全球最大的生成式AI视频平台,它为用户提供了高度自由的创作控制能力,用户可以通过简单的输入(如一张图片或一段文字)生成视频,并且能够像专业导演一样自由掌控镜头语言。

如今,大模型趋势来到应用落地侧,MiniMax依旧坚持原始性创新,不断刷新领域内新纪录。

底层技术是AI厂商的源头优势,是长期估值的压舱石,也是唯一不可被快速复制的壁垒。

而在落地方面,MiniMax低调推进,与不同行业合作。一些AI落地爆款背后,总能看到MiniMax的身影。这既是技术领先的进一步验证,也是其落地能力的直接证明。

可以看到,随着大模型发展驶入“深水区”,更关键在于,谁能构建起“模型即产品”机制,不断将AI技术从一线实验室向千行百业输送。

在这之中,布局全、壁垒深、落地广的玩家,更值得被关注。

MiniMax已经为行业打了个样,不是吗?

文章来自于“量子位”,作者“明敏”。

【开源免费】MockingBird是一个5秒钟即可克隆你的声音的AI项目。

项目地址:https://github.com/babysor/MockingBird

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales