一句话总结:用户需求逼着AI“下沉”。

试想一下,我们在用扫地机器人、可穿戴设备、安防摄像头的时候,都希望设备能“自己做决定”,而不是每次都把数据传到云端再等结果。

这不仅慢,还容易涉及隐私和网络稳定性问题。

根据Gartner的数据,AI芯片市场从2019年的120亿美元预计将在2024年增长到430亿美元。而其中一个重要驱动力,就是边缘AI。

然而,要想把AI部署在小巧的嵌入式设备中,最大的挑战是两个字:限制。功耗限制、算力限制、内存限制……传统MCU根本带不动复杂的神经网络模型。

而如果硬塞一个GPU上去,又会把整个系统的成本和功耗推到不可接受的水平。

因此,“能跑AI的低功耗MCU”成了边缘智能的关键解法。无论如何,只有当边缘人工智能在所有嵌入式系统上都能更轻松地访问时,它才会变得无处不在。

在此背景下,MCU市场的领导者们已经不满足于仅在软件工具包中增加机器学习功能,而是开始在硬件上集成NPU。这一转变标志着一个全新时代的来临。

六大MCU巨头的AI战术

包括ST、NXP、英飞凌、瑞萨、芯科科技在内的MCU巨头都已经有了实打实的AI MCU。

厂商的技术选择,与其擅长的细分市场高度契合——从消费级到工业级、从车载到低功耗IoT,都能找到对应的“拳头产品”。

1. STMicroelectronics:从软件突围到硬核自主

ST很早就看到了MCU上跑AI的潜力。

早在2016年就开发了自家的神经网络加速器Neural-ART,并在2019年推出了知名的STM32Cube.AI工具,

让开发者可以将训练好的AI模型转换成可运行在STM32 MCU上的代码。

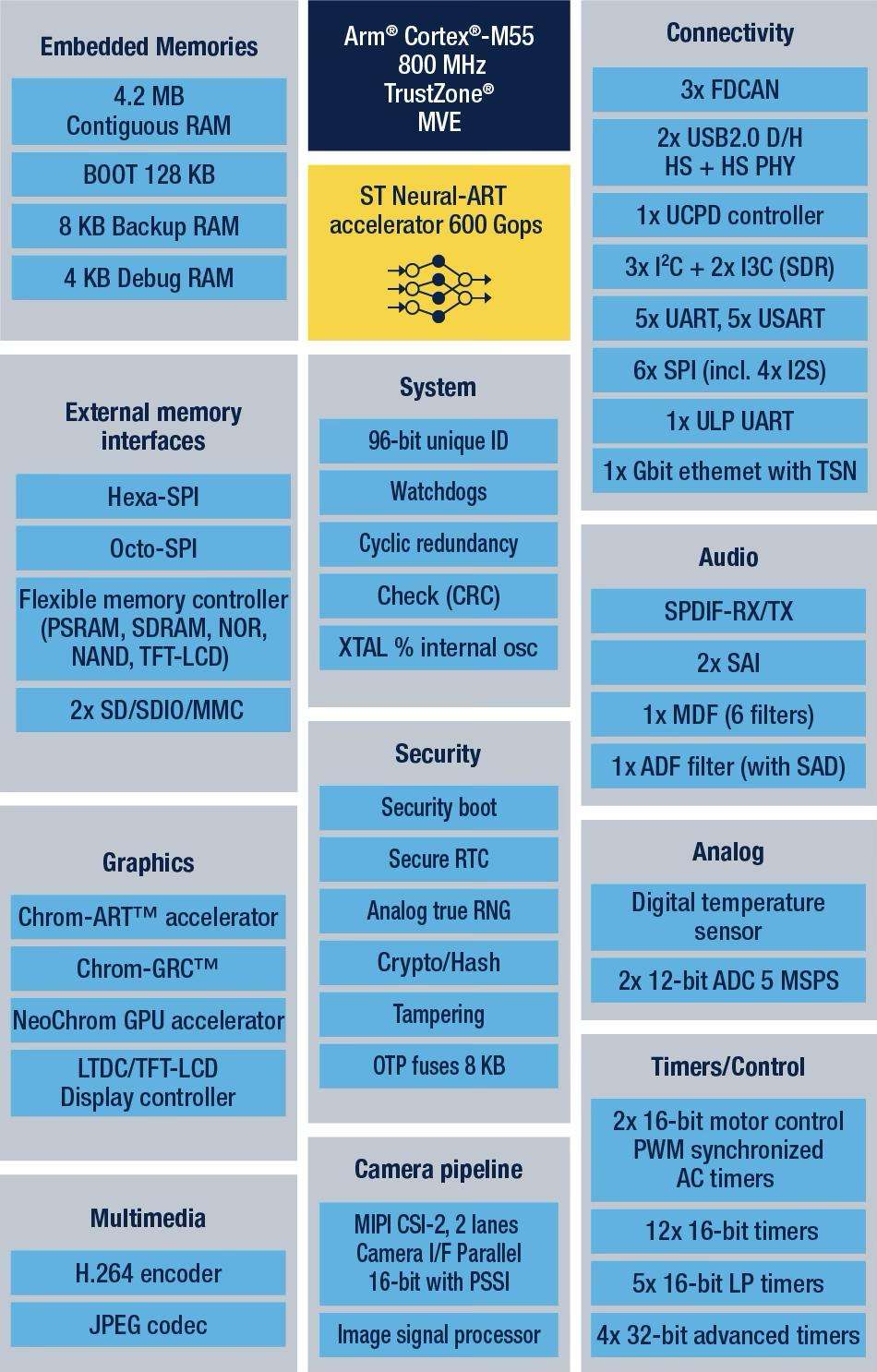

STM32N6是ST最新推出、功能最强大的STM32产品,也是首款搭载Neural-ART加速器的STM32产品。

它也是ST的首款 Cortex-M55 MCU,也是业内少数几款运行频率高达 800 MHz 的 MCU 之一。

此外,STM32N6 拥有 4.2 MB 的内置 RAM,是 STM32 中最大的内置 RAM。它也是ST首款搭载NeoChrom GPU和 H.264 硬件编码器的产品。

STM32N6搭载自研的Neural-ART加速器是一款定制的神经处理单元 (NPU),

拥有近 300 个可配置乘法累加单元和两条64位 AXI 内存总线,吞吐量高达600 GOPS,让原本需要加速微处理器的机器学习应用现在可以在 MCU上运行。

这一突破性的架构不仅允许每个时钟周期执行更多操作,并优化数据流以避免瓶颈,而且还针对功耗进行了优化,实现了3 TOPS/W。

Neural-ART加速器在发布时就支持比业界普遍水平更多的AI算子。

全新 STM32N6已兼容TensorFlow Lite、Keras和ONNX等众多AI算子,未来还能再继续增加算子数量,

不过仅目前支持的ONNX格式就意味着数据科学家可以将STM32N6用于最广泛的AI应用。

STM32N6框图

ST凭借自研NPU和成熟生态体系,把“AI跑在MCU上”变成了一件真正可行、可商用的事情。

意法半导体微控制器、数字IC和射频产品部总裁Remi El-Ouazzane表示,STM32N6有望成为STM32产品线中营收最快突破1亿美元的产品之一。

2. NXP:双线并进,汽车与消费共振

与ST类似,恩智浦早在2018年也推出了机器学习软件eIQ软件,该软件能够在恩智浦EdgeVerse微控制器和微处理器

(包括i.MX RT跨界MCU和i.MX系列应用处理器)上使用。

此前,NXP主要依赖第三方IP(如Arm的Ethos系列)来实现AI加速功能。

然而,随着AI推理需求的多样化和快速发展,为了更好地满足市场需求并增强产品竞争力。

据NXP的AI战略负责人Ali Ors指出,AI工作负载的快速演进和模型的多样性使得依赖第三方IP变得不再灵活,

为了更好地支持客户,特别是在产品部署后仍能提供长期支持,NXP决定开发自有的NPU架构。

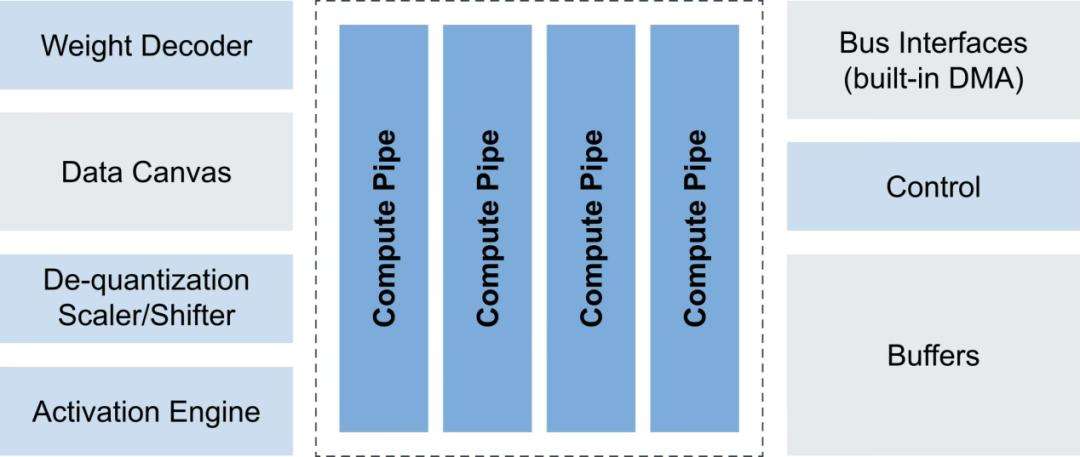

2023年1月,NXP正式推出了eIQ Neutron NPU,eIQ Neutron NPU支持多种神经网络类型,例如CNN、RNN、TCN和Transformer网络等。

NXP eIQ Neutron NPU系统框图

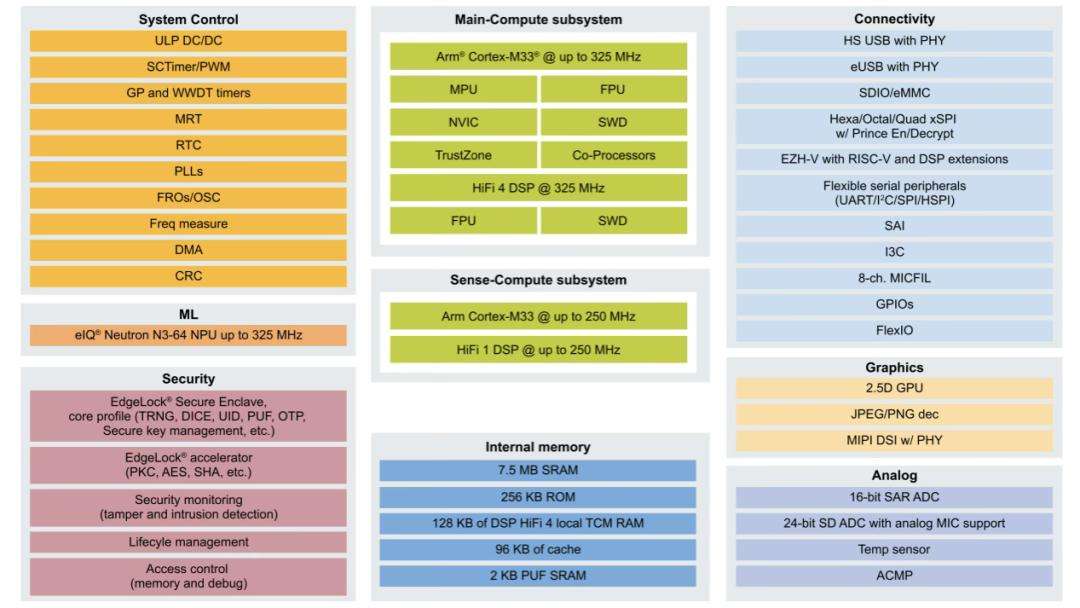

目前NXP已在两款MCU中都集成上了NPU:

1)在i.MX RT700跨界MCU中集成eIQ Neutron NPU,供高达172倍的AI推理加速,

并将每次推理的能耗降低至原来的1/119,支持语音识别、HMI交互、智能家居等场景;

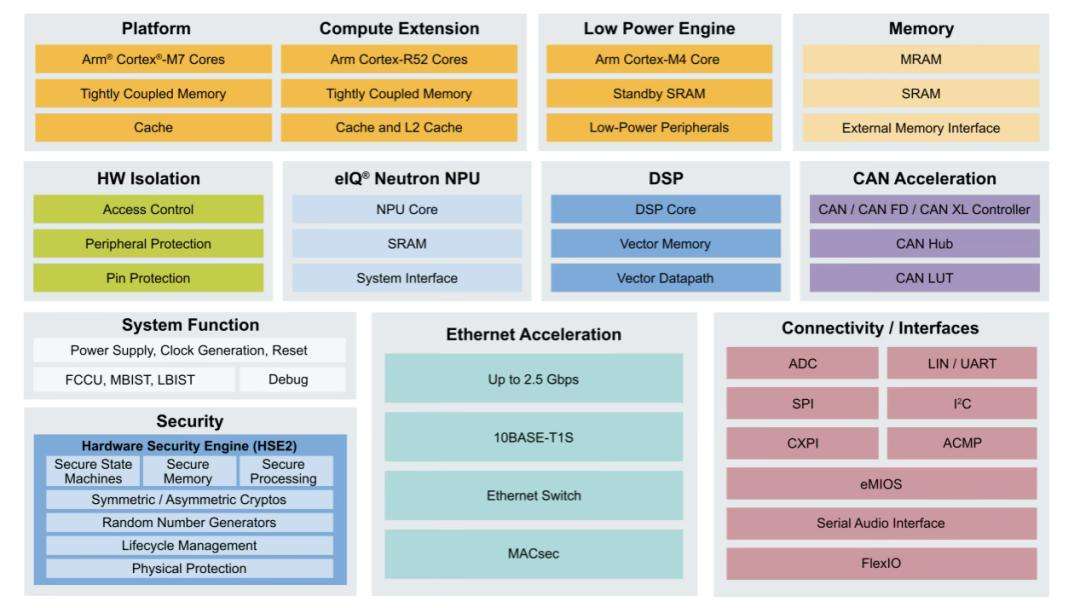

2)在最新的S32K5汽车MCU中也引入了NPU,这是业界首款集成嵌入式MRAM和NPU的汽车级16nm MCU。

i.MX RT700 跨界 MCU

S32K5汽车微控制器

为了配合eIQ Neutron NPU的使用,NXP在eIQ软件中新增了对eIQ Neutron NPU的支持,支持开发各种类型的神经网络,

包括CNN、RNN、Transformer等,非常灵活。

3. 英飞凌:借力Arm生态,快步切入AI赛道

英飞凌并未押注自研NPU,而是选择与Arm Ethos-U55绑定。

其PSOC Edge系列借助Arm Cortex-M55 + Ethos-U55的组合,加之与NVIDIA TAO工具链的集成,在高精度视觉AI和低功耗设计之间取得了不错的平衡。

英飞凌重在降低AI开发门槛,走“通用平台 + 快速集成”路线,节省研发时间,是入门边缘AI的务实选择。但缺点是差异化有限,长期竞争力依赖生态深度。

4. TI:实时控制+AI并举

TI打出的牌更偏工业和汽车实时控制方向,其TMS320F28P55x C2000 MCU系列是首个内建NPU的实时控制MCU。

NPU不仅提升故障检测准确率至99%以上,还能降低延迟5~10倍。

TI的C2000一直在嵌入式市场数十年经久不衰,与电源、工业驱动紧密耦合,将AI作为系统智能提升的“内生力”。

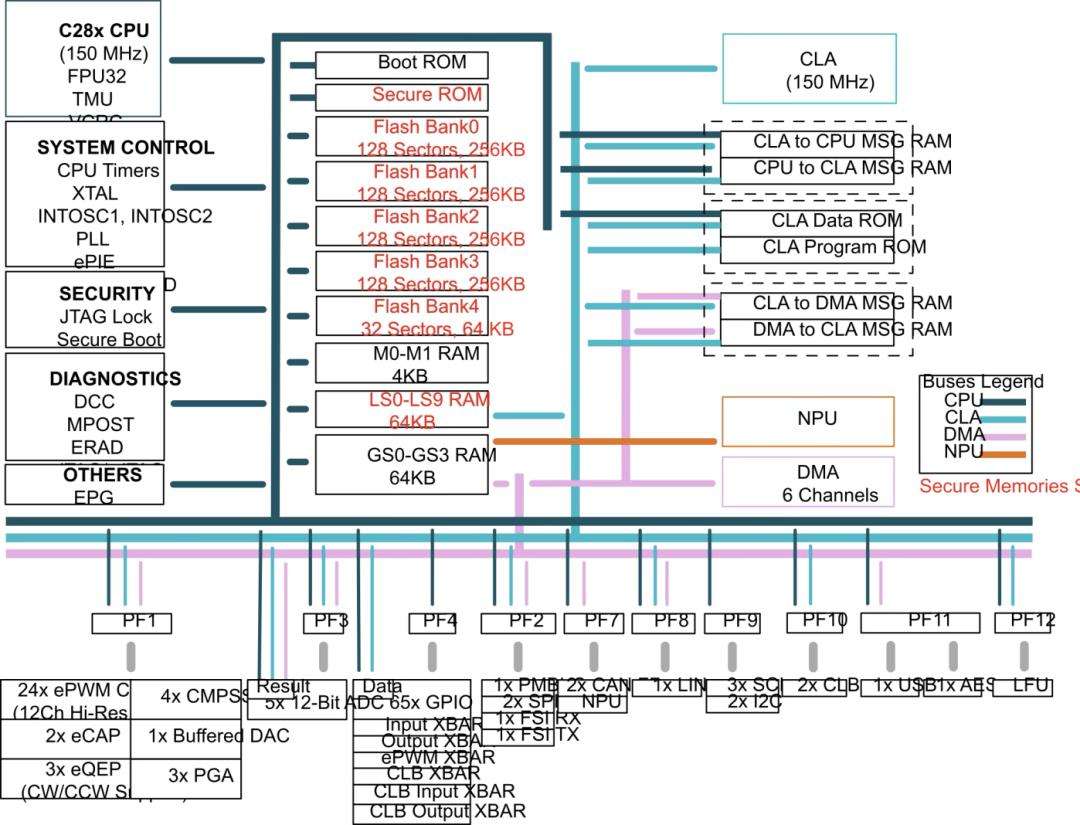

TMS320F28P550SJ系统框图

5. 瑞萨电子:走无NPU的极致优化路线

瑞萨目前尚未推出集成NPU的MCU,但其RA8系列MCU使用了Cortex-M85 + Helium技术,在不依赖NPU的前提下,也能跑基础的AI模型。

这种“用架构挖潜力”的策略降低了系统复杂度与成本,适用于无需大规模神经网络的场景,如语音识别、预测性维护等。

瑞萨用软硬协同优化替代NPU,“无NPU胜有NPU”,打出的是“高性价比”的技术路线。

6. 芯科科技:专注物联网的AI能效王者

芯科科技(Silicon Labs)的xG26系列SoC/MCU定位明确:为无线物联网打造极致AI能效。

其矩阵矢量AI加速器可实现8倍速提升、1/6功耗,特别适合电池供电设备(如传感器、智能门锁)中以AI唤醒替代长时间运行的场景。

Silicon Labs主打小而美的“低功耗AI”,在IoT中找到专属打法,是垂直领域差异化的典范。

国内MCU厂商也不甘示弱

在MCU这个赛道,国内玩家颇多,也很卷,MCU+AI这股风自然也在国内刮起。

国芯科技推出了首颗端侧AI芯片CCR4001S,并与美电科技联合推出AI传感器模组,实现了图像识别、语音识别等功能的本地处理。

该芯片采用了自研的NPU架构,支持高效的AI推理,适用于智能家居、安防监控等场景。

CCR4001S端侧AI MCU是国芯科技首款基于自主RISC-V CRV4H内核的边缘AI芯片,内置0.3 TOPS@INT8的NPU加速子系统,

支持TensorFlow、PyTorch、TensorFlow Lite、Caffe、ONNX等主流框架。

该芯片已通过工业级内部测试,具备高可靠性,可广泛应用于工业电机控制、能耗优化、AI传感器、产品缺陷检测与预测性维护等场景。

国芯科技与美电科技联合推出的AI传感器模组,利用CCR4001S在本地完成图像和语音识别,实现无需云端即可部署的端侧智能化解决方案。

兆易创新GD32G5系列MCU也已具备一定的AI算法处理能力,它以Arm Cortex-M33高性能内核为基础,

高达216 MHz的主频配合内置DSP硬件加速器、单精度浮点单元(FPU)和硬件三角函数加速器(TMU),可支持10类数学函数运算;

同时集成滤波器(FAC)与快速傅里叶变换(FFT)加速单元,使得该系列在最高主频下可达316 DMIPS,CoreMark分数694。

兆易创新表示,未来将进一步强化硬件AI加速能力,全面布局端侧智能市场。

澎湃微推出了集成 TinyML能力的32位MCU,凭借片上神经网络加速和标准电机控制外设,

可在单芯片上实现离线语音识别与电机驱动控制,适用于智能家电、工业设备和物联网传感节点等场景。

通过本地小模型推理,可大幅降低对云端的依赖,提升响应速度并节省成本

借助自研架构、完整生态和灵活采购优势,国内MCU厂商正以“快、真、稳”的姿态迎头赶上。

他们不仅在产品性能指标上与国际巨头同场竞技,更通过更贴近应用的本地化解决方案,为下游客户提供了更具成本效益和开发效率的AI边缘计算选择。

未来,随着更多创新迭代的落地,国内MCU+AI赛道的竞争必将更加激烈,也将带来更多意想不到的惊喜。

MCU x AI,未来的趋势

MCUxAI,趋势已经不可避免。过去,AI功能常被视为MCU的增值插件;

未来,AI将成为MCU的内置能力。从安全监测到状态识别,再到节能智能调度,各类嵌入式应用都将默认搭载AI加速单元,MCU若无AI引擎便难以在市场中立足。

一块NPU芯片的算力固然重要,但真正决定其生命周期的,是完整的生态体系——从模型转换工具、推理框架,到量化精度与算子支持。

拥有成熟软硬件配套的ST、NXP等厂商,将在行业标准与客户粘性上持续领先。

从市场层面来看,不同细分市场对AI MCU有着截然不同的优先诉求。消费电子追求廉价、易部署、快速迭代;汽车与工业则强调功能安全、稳定可靠、超低时延;

物联网要求超低功耗、高度集成。MCU大厂围绕这些需求,正沿着自研NPU、授权IP、软件加速等多条技术路线并行布局。

随着AI加速单元日臻成熟,多种嵌入式设计将以“混合CPU + NPU”架构取代掉一些传统CPU + MPU方案。

此举不仅重塑产品定义,还将对半导体供应链、IP授权模式和产业分工带来深远影响——真正掀起新一轮的技术与商业革命。

结语

MCU上的AI之战,既是技术创新的前沿,也是产业模式重塑的风口。集成NPU的MCU,正从技术探索迈入商业化加速阶段。

短期看,各家在架构与性能上各擅胜场;长期看,真正能让AI“无感”融入千千万万设备的,是软硬一体的生态体验与垂直场景的精准落地。

随着时间的推移,所有用于终端ML应用的MCU都将变成混合CPU/NPU设备。

这与过去几十年MCU领域的其他基本趋势一样不可避免,例如转向基于闪存的MCU,以及几乎所有MCU都集成USB连接。

文章来自于微信公众号 “半导体行业观察”,作者 :杜芹