爆火的斯坦福全能家务机器人Mobile ALOHA,大!翻!!车!!!

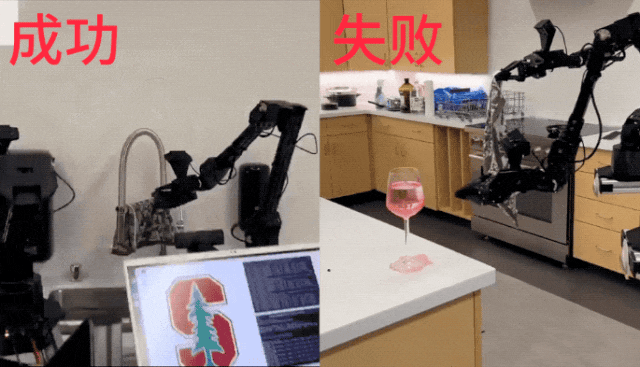

你以为它擦个红酒轻而易举,但实际上却是这样的:

全给你弄撒喽,顺带碎个杯子……

你以为它能化身大厨娴熟烹炒,结果给你上演一个炒锅底:

Mobile ALOHA的翻车大合集还不止这些。

例如刚才炒完虾的锅,哎呦喂,一不小心没拿住:

即使小哥一个箭步冲上去也没阻止“悲剧”的发生(好像还烫到手了)。

这画面,真是像极了庄嫂摔碗……

昨天还在“神坛”上的Mobile ALOHA,一夜之间便被曝出了这么多“笨手笨脚”的样子,也是引来不少网友的围观。

然而,这次即使面对翻车铁证,网友们的画风却是一反常态:

它并不完美,不过很可爱。

总会有犯错的余地。

最重要的是:

放心了。(手动狗头)

这到底是怎么回事?

原来,这段机器人大翻车的视频,就是由斯坦福Mobile ALOHA的作者Tony Z. Zhao发布的。

并且他还直言不讳地说道:

机器人还没有做好准备接管这个世界。

而这段翻车视频,正是机器人完全在自主模式下所犯的。

用作者的话来形容,就是“最愚蠢的错误”。

毕竟除了刚才我们展示的几个例子之外,Mobile ALOHA甚至连锅都放不进橱柜里:

炒完的虾粘锅倒不出来不说,连碗的位置也找不到:

拿支笔也没法找对位置下手:

面对失败合集,作者却是打趣道:

这是我目前为止最喜欢的视频了,(不过)当机器人在你面前犯错的时候,你就不会觉得那么有趣了。

确实,毕竟手都被烫了……

不过作者今天自曝这段视频其实应该还有另外一个原因。

因为前两天Mobile ALOHA神级现场的视频确实引来了不小的关注度,不过很多人误以为这是它在自主模式下完成的。

但其实,Mobile ALOHA采用的是混合模式,并非完全自主,作者也呼吁网友们在吃瓜的同时认真看下论文和代码。

值得一提的是,作者还引用了2015年波士顿动力Atlas人形机器人“翻车合集”并向它致敬。

或许这也正如英伟达科学家Jim Fan说的那样:

一步一个脚印。

就在这两天,Mobile ALOHA团队连续放出三个爆火视频,展示了该机器人敏捷灵巧的家务能力,看呆网友。

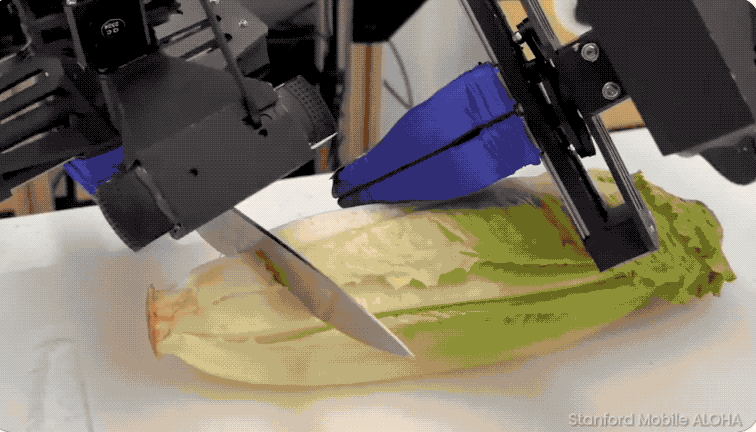

包括做满汉全席(磕鸡蛋、给鸡肉翻面这种细活都信手拈来):

套枕套铺床单:

浇花、拖地板、开瓶盖,甚至逗猫猫:

那叫一个人模人样,上得厅堂下得厨房。

不过,大部分都是真人操控的,比如上面这些。

更直观的可以看下面这个抽纸擦玻璃的动图,背后直接站了个人类1:1示范:

不过,对于一些相对简单的任务,例如这个单炒虾仁:

还有刷锅、将餐椅归位、呼叫并乘坐电梯、擦桌子等等,只需真人少量示教,它就可以学会,然后脱离人类进行自主操作。

具体而言,作者介绍,上面这些简单动作目前只需要学习50次就可以做到90%的成功率——

经测试,Mobile ALOHA可以连续9次擦干倒洒了的酒、连续呼叫5次电梯都不会出错,能够保持一定的稳定性。

除此之外,它还能抗干扰,在完成归置锅具到柜子之中时,实验人员不停向它面前投掷杂物,都完全没有影响它发挥:

在训练期间根本看不见的椅子?它也能准确识别并完成归位任务。

那么,作者是如何仅通过50个演示就让Mobile ALOHA实现自主任务的呢?

最关键的是通过ACT或扩散策略进行模仿学习,然后和静态操作数据一起对机器人系统进行联合训练。

有了这一联合训练方式,机器人的性能可以显著提高,尤其是那种需要精确操作的任务。

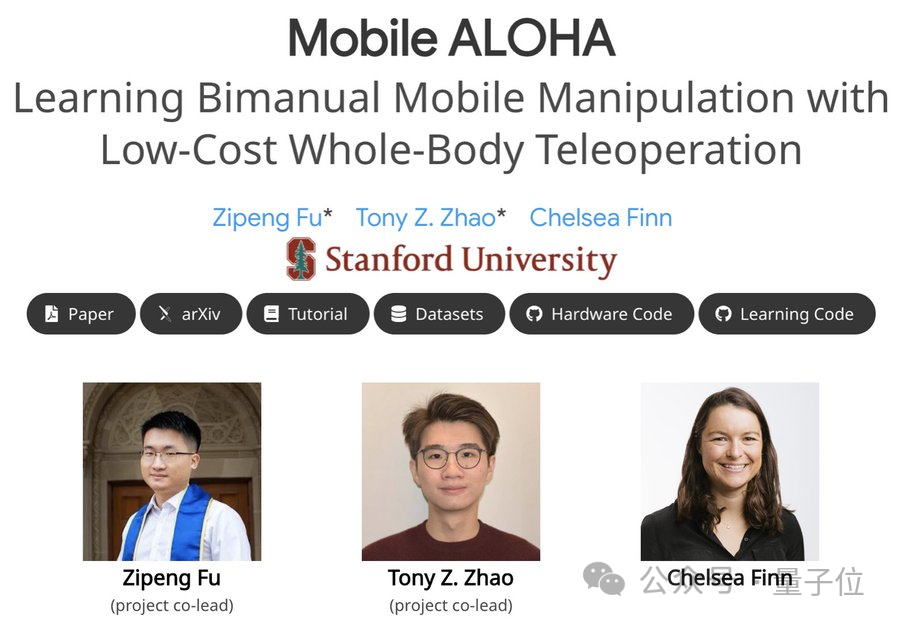

最后,也再次为介绍一遍斯坦福大学的这个机器人成果:

它于今年3月底正式发布,历经了8个月的迭代和2个月的测试。

一共三位作者,其中两位为斯坦福计算机科学专业的华人博士生(最后一位是导师):

当时的这位机器人,就已经能够利用工具完成各种精密细活了,只不过只能在固定的位置:

当然,背后也是真人遥控的。

而正如其名ALOHA全称是“???? ????ow-cost ????pen-source ????????rdware System”,这款机器人主打的就是开源和低成本:

全部软硬件设计包括代码和数据都一并发布,而搭建这一个系统“只”需3.2万美元(约合22.7万人民币),具体需要哪些硬件,作者还列了个清单,感兴趣的朋友可以照着DIY。

几乎和斯坦福的爆火机器人同一时间,谷歌也发布了自家最新的研究成果,并且是一气发了仨:

一个是将机器人决策速度提高14%,同时保持操作准确率不变并增加了10.6%的改进模型;

一个是专攻泛化能力的新框架,用了一种全新方法让机器人完成从未见过任务的成功率从29%提升至63%;

以及一个可以同时容纳20个机器人的收据收集系统,将用于加快机器人理解人类指令的能力的训练。

这些新成果全部用于升级谷歌的机器人大模型RT-2。

和斯坦福的Mobile ALOHA对比起来,谷歌的RT-2表现还是高冷一些,但它所有效果都是全自主的。

除了这两家,李飞飞团队也一直在跟进,其名为VoxPoser的机器人系统也已经可以听懂人话完成各种指令,并且无需额外训练。

这不由地让人想到,不少人那句“2024会是机器人元年”的预言:

你觉得会成真吗?

参考链接:

https://twitter.com/tonyzzhao/status/1743378437174366715