为提升大模型“推理+搜索”能力,阿里通义实验室出手了。

最新研究开源全新通用预训练框架——MaskSearch,在域内及跨域开放域问答任务上均较基线方法取得显著性能提升。

小模型甚至能媲美大模型表现。

在推理+搜索方向,通义实验室搜索团队已提出ZeroSearch、OmniSearch等工作,通过在特定的下游任务进行强化学习训练,

让大模型在与环境交互的过程中学习使用搜索引擎。

该团队认为,仅在特定任务上训练会导致模型的泛化能力受限,难以适应更多场景下的检索推理任务。

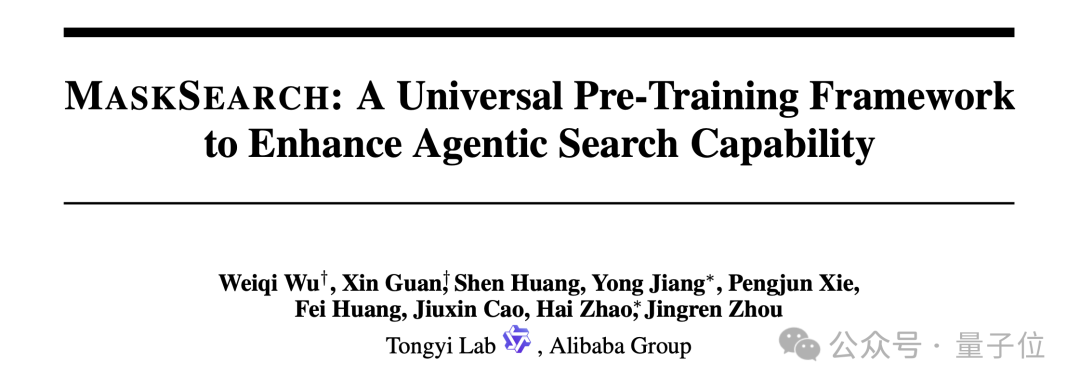

受BERT模型在预训练过程中使用的掩码(Mask)预测任务启发,MaskSearch引入了检索增强型掩码预测任务。

也就是让模型使用搜索工具,预测文本中被遮蔽的部分,在预训练过程中有效学习通用的任务分解、推理等智能体策略,

同时熟练掌握搜索引擎的使用方法,为其后续适配多领域任务奠定基础。

不仅如此,MaskSearch可以兼容监督微调(SFT)和强化学习(RL)两种训练方法。

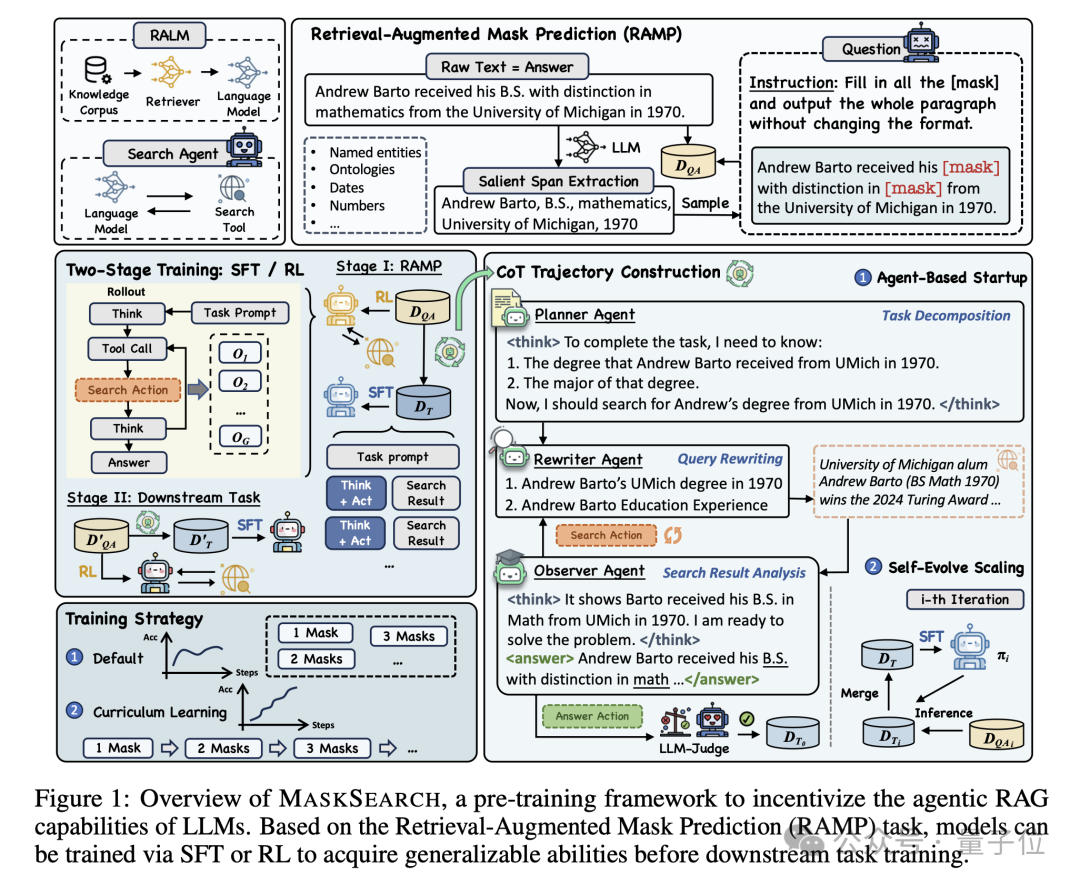

通过加入预训练的二阶段训练,MaskSearch相比只在下游任务进行训练的基线方法,在多个开放域问答数据集上有明显效果提升。

接下来,一起来深入探究MaskSearch的核心架构与运作机制。

检索增强型掩码预测(RAMP) 作为 MaskSearch 的预训练任务,其核心要义在于:

在输入的文本序列中,对关键信息进行掩码处理,模型需主动借助外部知识库 ,调用搜索工具来预测这些被掩盖的文本片段。

为了提升被掩码部分的难度,除了在过去掩码预测任务中常被遮蔽的命名实体(如人名、地名、组织名等)、日期和数字,MaskSearch还考虑了以下几类关键信息:

这不仅增加了任务的难度,还促使模型在检索和推理过程中更加精细化地处理信息,从而提升其在多领域任务中的适应能力和泛化能力。

为了生成用于监督微调(Supervised Finetuning, SFT)的思维链(CoT)数据,作者提出一种结合Agent合成与蒸馏(Distillation)的数据生成方法,具体包括:

最终由一个LLM负责答案判断,仅保留正确答案的思维链。

强化学习

强化学习部分,作者采用了动态采样策略优化(DAPO)算法,构建混合奖励(Hybrid Reward)系统

——格式奖励检查模型输出是否符合指定格式,回答奖励则评估生成答案与标准答案的一致性。

作者探索了多种回答奖励函数,最终选择基于模型的奖励函数,使用Qwen2.5-72B-Instruct模型作为评判,为生成答案和标准答案的一致性进行打分。

课程学习

为了帮助从易到难依次学习,作者提出依据掩码数量对训练样本进行难度分级,让模型首先通过简单样本学习基础推理技能,

然后逐步提升能力以应对更具挑战性的场景。

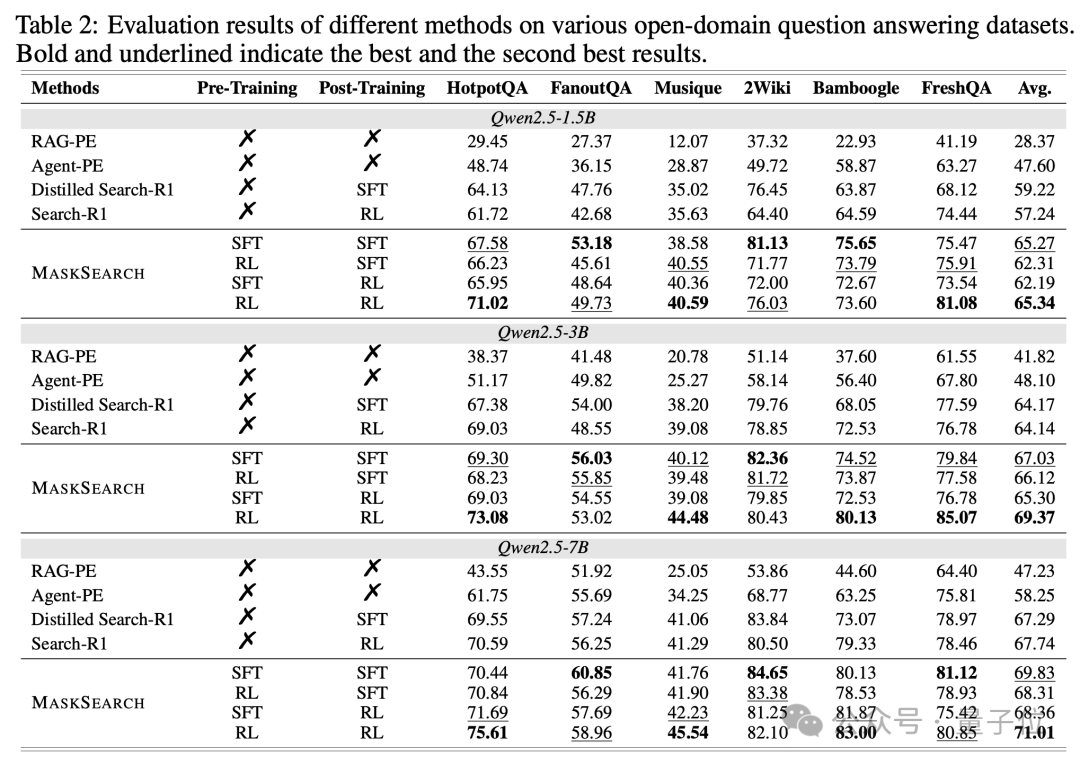

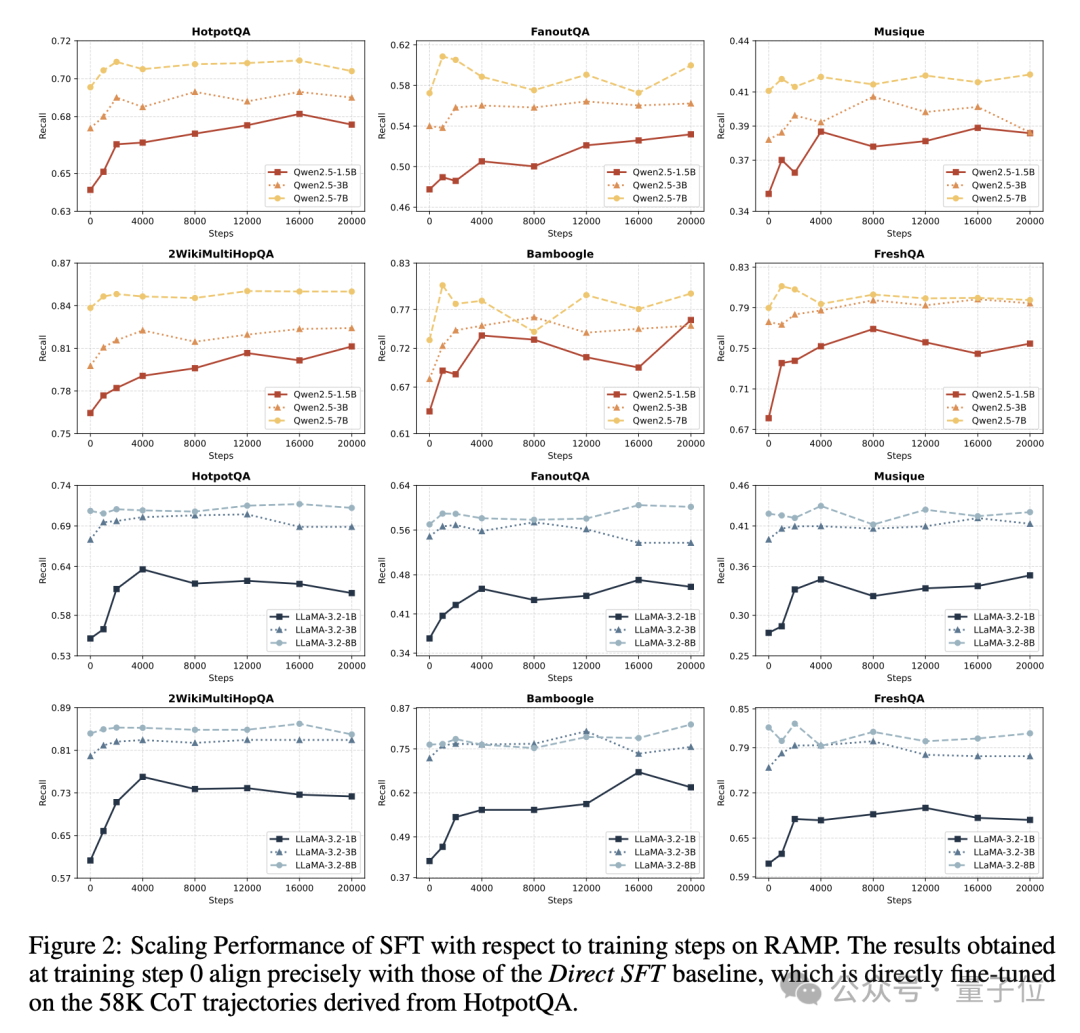

作者通过基于不同大小的Qwen和LLaMA模型的实验证明,两阶段MaskSearch训练框架显著提升了大模型的搜索和推理能力。

遵循以RAMP作为预训练任务,HotpotQA数据集作为下游任务的训练流程,MaskSearch在领域内(in-domain)数据集上稳定提升模型召回率;

在Bamboogle等领域外数据集上,性能提升更为显著,小模型甚至能媲美大模型表现,验证了RAMP作为可扩展学习信号的有效性。

实验进一步验证了监督学习(SFT)与强化学习(RL)两种训练方式与MaskSearch框架的兼容性。

其中,RL在RAMP任务上展现出更高性能上限,尤其在HotpotQA等领域内任务中,在所有大小的Qwen模型都取得了最优效果。

这表明RL通过动态采样策略和混合奖励机制,能更精准优化模型的多步搜索与推理流程,为提升检索增强模型的适应性提供了更强的训练范式。

在监督学习的场景下,作者通过不同训练步数实验验证 MASKSEARCH 的可扩展性:

小模型(如1B)经预训练后性能提升显著,而大模型(如 7B)受限于自进化数据的多样性,性能增益相对平缓,但召回率分数仍相对仅微调模型有所增长。

这证明 RAMP 对不同规模模型均有持续提升的潜力,也表明数据质量和多样性是决定 SFT 方法模型性能上限的关键因素。

此外,实验验证了基于掩码数量设计的课程学习训练策略。

具体方法是训练时按掩码数量分层采样数据,每个数量对应10K训练样本,配合6K HotpotQA数据维持任务平衡。

当掩码数量从1逐步增至4时,Qwen2.5-7B模型在验证集上的得分明显增加,且显著高于将不同数量掩码的数据混合训练时的表现。

此外,在下游任务上课程学习也有进一步提升模型训练后表现的效果,验证了难度梯度设计对推理能力构建的促进作用。

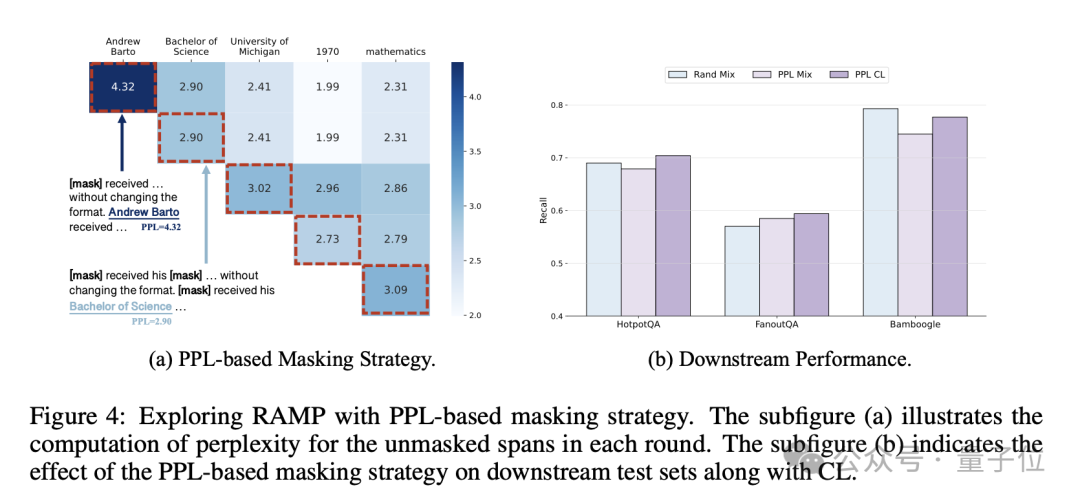

掩码策略是影响RAMP预训练任务难度的另一重要因素。

作者对比了随机掩码与基于困惑度(PPL)的难度导向掩码策略,也就是通过计算模型恢复掩码时的损失值(即困惑度),优先选择恢复难度高的部分进行遮蔽。

实验显示,PPL策略在FanoutQA数据集上提升模型召回率,但在其它数据集中也会因过度追求难度导致性能下降,

表明任务难度仍需要与模型当前搜索和推理能力相匹配。

因此,结合课程学习的训练策略平衡难度,能够在整体上获得更优效果。

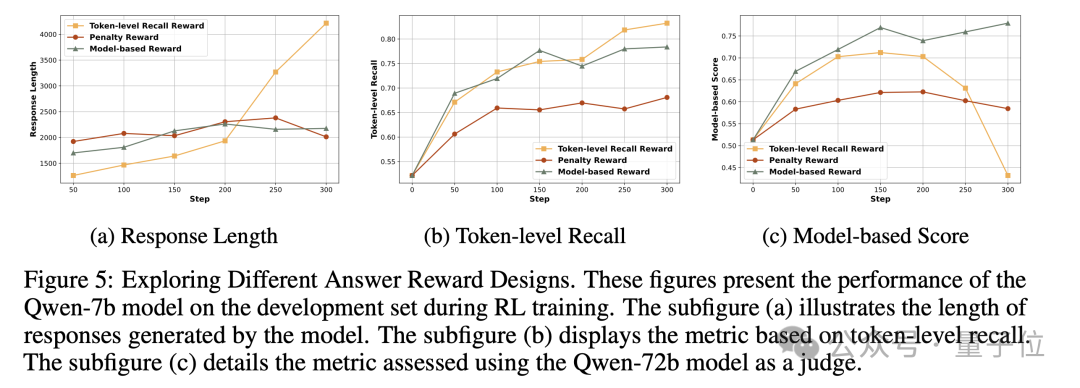

2、RL奖励函数影响

在强化学习训练过程中,不同奖励函数对模型性能影响各异。

以Qwen2.5-7b模型为例,基于token级召回率的奖励函数促使模型为提升召回率,向答案中堆砌大量无关信息,致使回答长度大幅增加,

相较于其它RL奖励函数实际性能显著下滑。

尽管引入惩罚项以抑制回答长度,能在一定程度上减少信息冗余,但模型仍可在有限长度内通过枚举方式钻规则漏洞。

相较而言,基于模型的奖励函数表现出最佳性能,在模型生成的回答长度、token级召回率以及经Qwen72b模型评判的分数上,均优于其它两种奖励方法,

有效规避奖励欺骗问题,且RL训练全程表现出卓越的稳定性和高效性。

总之,MaskSearch致力于提升大型语言模型(LLM)的智能体推理+搜索能力。

该框架依托检索增强型掩码预测(RAMP)预训练任务,赋能模型自主执行多步搜索与推理,填补文本中的掩码空白,实现外部知识的深度整合。

经监督微调(SFT)与强化学习(RL)双重训练路径锤炼,并引入课程学习策略,MaskSearch在域内及跨域开放域问答任务上均较基线方法取得显著性能提升。

Paper: https://arxiv.org/abs/2505.20285

GitHub: https://github.com/Alibaba-NLP/MaskSearch

文章来自于微信公众号 “量子位”,作者 :通义实验室

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner