将一幅图像转换为3D的方法通常采用Score Distillation Sampling(SDS)的方法,尽管结果令人印象深刻,但仍然存在多个不足之处,包括多视角不一致、过度饱和、过度平滑的纹理,以及生成速度缓慢等问题。

为了解决这些问题,北京大学、新加坡国立大学、武汉大学等机构的研究人员提出了Repaint123,以减轻多视角偏差、纹理退化,并加速生成过程。

论文地址:https://arxiv.org/pdf/2312.13271.pdf

GitHub:https://github.com/PKU-YuanGroup/repaint123

项目地址:https://pku-yuangroup.github.io/repaint123/

核心思想是将2D扩散模型的强大图像生成能力与再绘策略的纹理对齐能力结合起来,以生成具有一致性的高质量多视角图像。

作者进一步提出了针对重叠区域的可见性感知自适应再绘强度,以提高再绘过程中生成图像的质量。

生成的高质量、多视角一致的图像使得可以使用简单的均方误差(MSE)损失进行快速的3D内容生成。

作者进行了大量实验证明,Repaint123能够在2分钟内从零开始生成具有多视角一致性和精细纹理的高质量3D内容。

文章的主要贡献点如下:

1. Repaint123全面考虑了图像到3D生成的可控重绘过程,能够生成多视角一致的高质量图片序列。

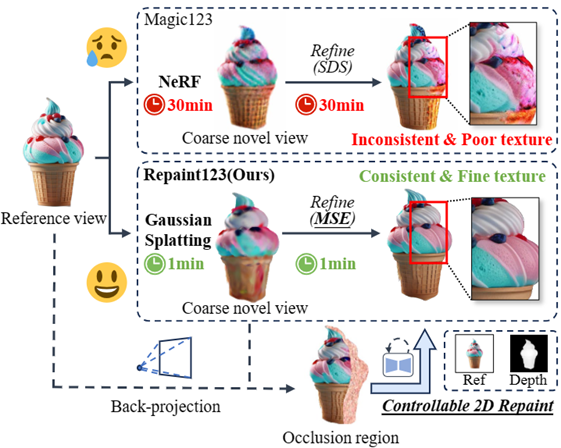

2. Repaint123提出了一个简单的单视图3D生成的baseline,粗模阶段采用Zero123作为3D prior与SDS损失快速优化Gaussian Splatting几何(1分钟),细模阶段采用Stable Diffusion作为2D prior与MSE损失快速细化Mesh纹理(1分钟)。

3. 大量的实验验证了Repaint123方法的有效性,可以在短短2分钟内从单一图像中生成匹配2D生成的质量的3D内容。

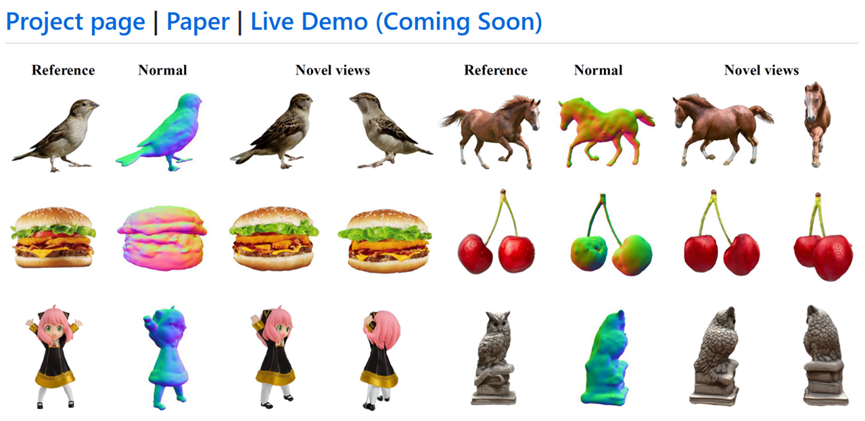

图1:论文动机:快速、一致、高质量的单视角3D生成

具体方法:

Repaint123主要改进集中于mesh细化阶段,包含两个部分:多视角一致的高质量图像序列生成,快速高质量的3D重建。

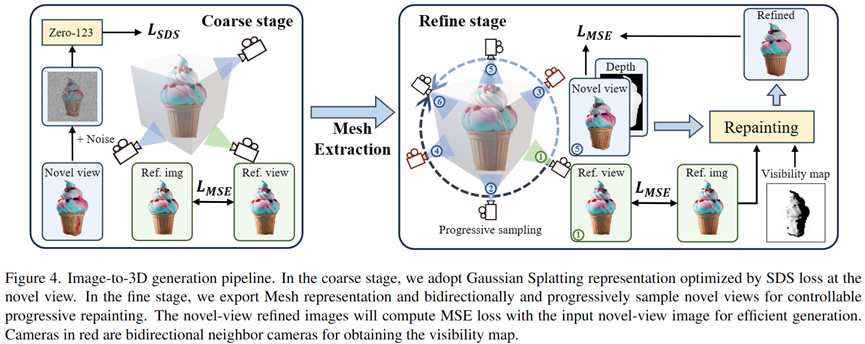

在粗模阶段,作者采用3D Gaussian Splatting作为3D表征,通过SDS损失优化的粗模几何和纹理。

在细化阶段,作者将粗模模型转换为网格表示,并提出一种渐进的、可控的纹理细化重绘方案。

首先,作者通过几何控制和参考图像的指导逐步重新绘制相对于先前优化视图的不可见区域,从而获得新颖视图的视图一致性图像。

然后,作者采用图像提示进行无分类器指导,并设计自适应重绘策略,以进一步提高重叠区域的生成质量。

最后,通过生成视图一致的高质量图像,作者利用简单的MSE损失来快速生成3D内容。

多视角一致的高质量图像序列生成:

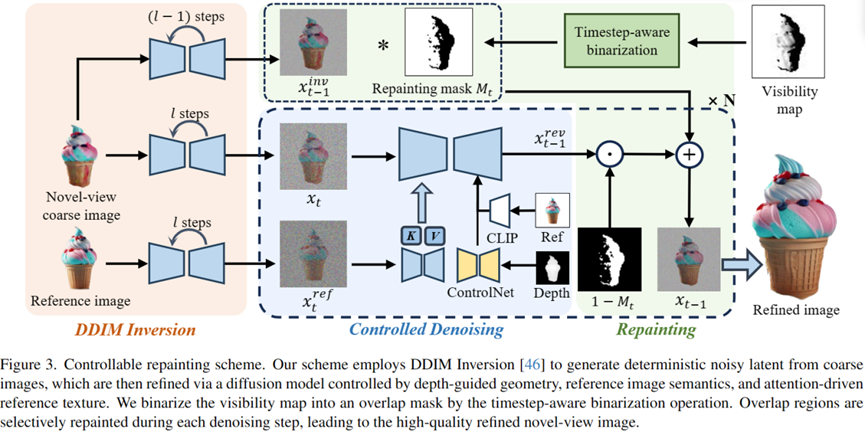

如图2所示,多视角一致的高质量图像序列生成分为以下四个部分:

图2:多视角一致的图像生成流程

DDIM Inversion

为了保存粗模阶段生成的3D一致的低频纹理信息,作者使用DDIM Inversion将图像反演到确定的latent, 为后续去噪生成忠实一致的图片做基础。

Controllable Denoising

为了控制几何一致与长程纹理一致,在去噪阶段作者使用ControlNet引入粗模渲染的深度图作为几何先验, 注入参考图的Attention特征进行纹理迁移。

同时,为了执行Classifier-free guidance提升图像质量,论文使用CLIP将参考图编码为image prompt提示去噪网络。

Obtain Occlusion Mask

为了从渲染出来的图像In和深度图Dn的新颖视图中获得遮挡掩码Mn,在给定Ir和Dr的重绘参考视图Vr条件下,作者首先通过使用深度Dr缩放来自Vr的2D像素点至3D点云,然后从新视角Vn渲染3D点云Pr,得到深度图Dn'。

作者认为两个新颖视图深度图(Dn和Dn')之间具有不同深度值的区域是遮挡掩码中的遮挡区域。

Progressively Repainting both Occlusions and Overlaps

为了保证图像序列重相邻图像的重叠区域像素级别对齐,作者使用了渐进式局部重绘的策略,在保持重叠区域不变的情况下生成和谐一致的临近区域,从参考视角依次类推到360°。

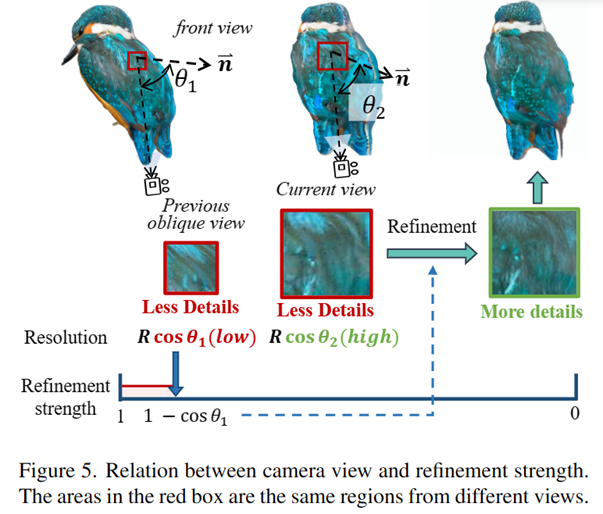

但是如图3所示,作者发现重叠区域同样需要进行细化,因为一个之前斜视的区域在正视时其可视分辨率变大,需要补充更多的高频信息。

为了选择合适的细化强度使得在提升质量的同时保证忠实度,作者借鉴投影定理与图像超分的思想,提出了一种简单直接的能见度可感知的重绘策略来细化重叠区域,另细化强度等于1-cosθ*(其中θ*为之前所有相机视角与所视表面法向量夹角的最大值),从而自适应地重绘重叠区域。

图3:相机视角与细化强度的关系

快速高质量的3D重建:

如图4所示,作者采用了两阶段方法,先使用Gaussian Splatting表示来快速生成合理的几何和粗糙的纹理,同时借助上述生成的多视角一致的高质量图像序列, 作者得以使用简单的MSE loss进行快速的3D纹理重建。

图4:Repaint123两阶段单视角3D生成框架

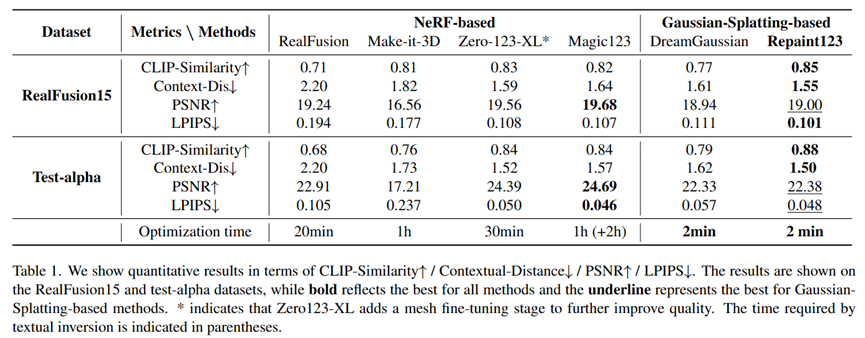

作者比较了多个单视图生成任务方法,在RealFusion15和Test-alpha数据集上取得了一致性、质量、速度三方面最先进的效果。

单视图3D生成可视化比较

单视图3D生成定量比较

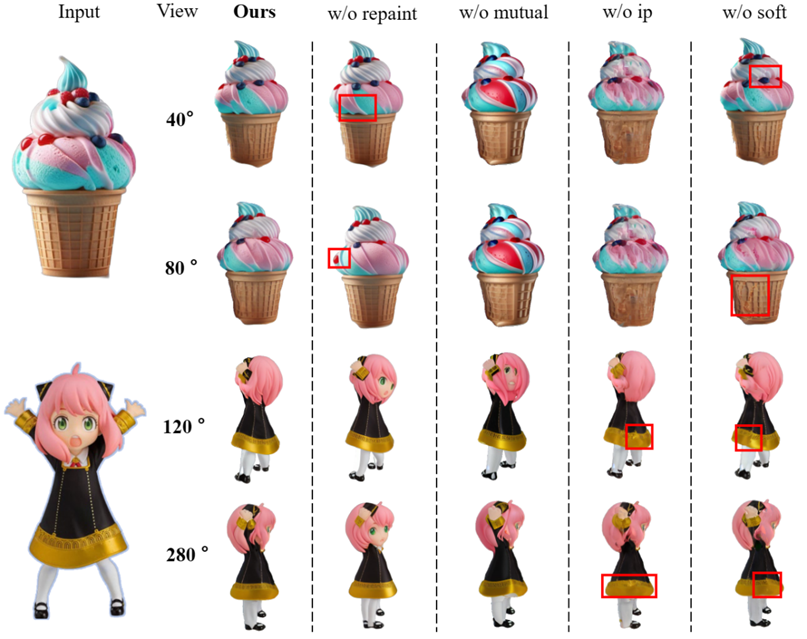

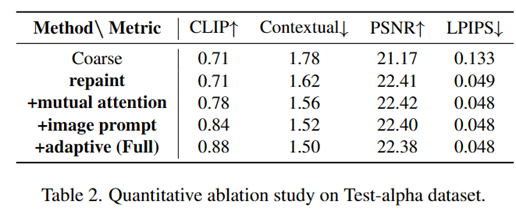

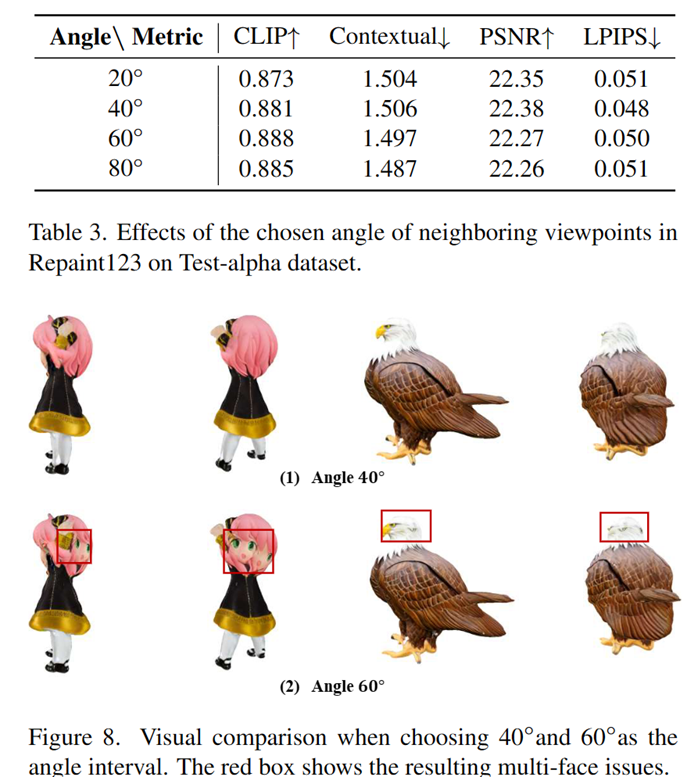

消融实验

同时,作者也对论文使用的每个模块的有效性以及视角转动增量进行了消融实验:

参考资料:

https://github.com/PKU-YuanGroup/repaint123

文章来自于微信公众号 “新智元”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0