在金融科技智能化转型进程中,大语言模型以及多模态大模型(LVLM)正成为核心技术驱动力。尽管 LVLM 展现出卓越的跨模态认知能力,其部署却长期受限于显著的算力瓶颈 —— 大小中等的模型一次多图推理可能需要 100 G 的显存空间,严重制约产业落地。

针对这一技术痛点,哈工大团队联合度小满金融科技正式发布 EFFIVLM-BENCH,业界首个支持跨场景统一评估的多模态大模型高效化基准框架,为学术界提供可复现的压缩方案对比基准,同时赋能工业界实现最优部署策略遴选。该项目框架已在 GitHub 全面开源, 对应论文《EFFIVLM-BENCH: A Comprehensive Benchmark for Evaluating Training-Free Acceleration in Large Visual-Language Models》被 ACL(CCF-A)录用为主会论文。

EFFIVLM-BENCH:

为LVLM高效化方案提供全面、系统的“体检报告”

在 LVLM 的研究和应用中,不同的方法常常应用于不同的模型上,另一方面,即使最新的研究为能够公平比较仍应用于较为古早的模型上。如何在最先进的模型上公平有效地评估和比较各种加速方法的性能,一直是一个亟待解决的问题。EFFIVLM-BENCH 的出现,正是为了填补这一空白。该平台的核心价值在于其先进性、全面性和系统性。

EFFIVLM-BENCH 提供了一个统一的评估框架,对主流的加速技术进行细致的性能剖析,包括 kv cache 压缩、token 压缩和参数压缩(如剪枝、量化),共计近 20 种模型高效化方法。在评测上,它不仅关注模型在特定任务上的绝对性能,更创新性地引入了泛化能力、忠诚度(即压缩后模型与原始模型行为的一致性)以及实际推理效率(如真实推理时间)等多维度评估指标。这意味着,EFFIVLM-BENCH 能够为不同的加速方法出具一份详尽的 “体检报告”,揭示其在不同场景下的优势与不足。

EFFIVLM-BENCH 的评估范围广泛,涵盖了多种前沿的 LVLM 架构(如 LLaVA-OneVision, Qwen2-VL, InternVL2.5)、模型高效化方法以及近 20 个不同类型的多模态基准任务,从文档图像理解、图表问答到长文本视频理解等,力求模拟真实应用场景的复杂性。通过对这些场景的深入分析,EFFIVLM-BENCH 旨在帮助研究者和开发者找到性能与效率之间的最佳平衡点,即所谓的 “帕累托最优” 解。

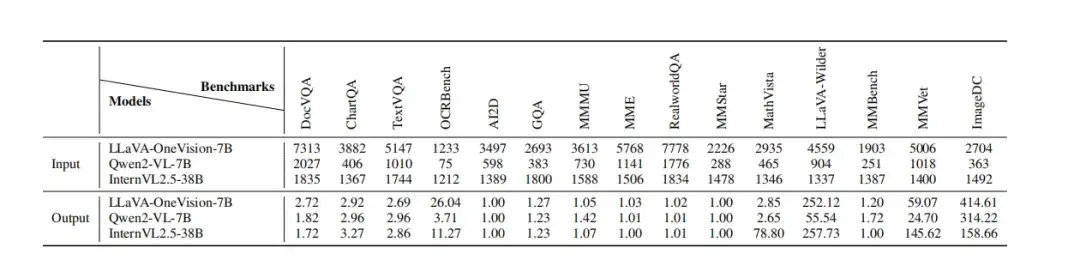

图 2 不同模型在多个 Benchmarks 上的输入输出长度

EFFIVLM-BENCH 的深度洞察:

加速 LVLM 并非 “一刀切”

通过 EFFIVLM-BENCH 的广泛实验与深度分析,哈工大团队联合度小满获得了一系列关于 LVLM 加速的重要发现。研究表明,LVLM 的加速并非简单的 “一刀切” 方案,其效果与具体应用场景和所采用的技术策略紧密相关。例如,任务依赖性显著,token 压缩方法在处理不同类型的任务时表现各异,尤其对于需要精细视觉信息或生成长序列输出的任务,其性能可能会受到较大影响。在保持模型泛化能力和忠诚度方面,KV 缓存压缩技术通常展现出更佳的优势。

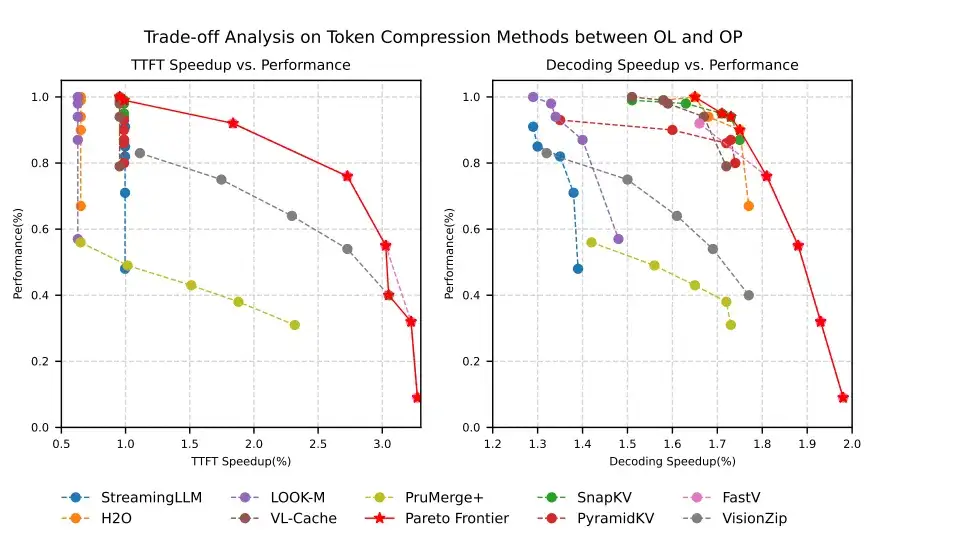

同时,效率权衡也是一门艺术,不同的加速策略在 “首 token 生成时间”(TTFT)和后续解码速度上各有侧重,开发者需要根据实际应用需求进行选择,例如 token 压缩可能更适合需要快速响应的短文本任务。此外,参数压缩的稳健性也值得关注,像量化这样的技术在保持模型原始性能方面往往更为可靠。更进一步,该研究还深入探讨了层自适应稀疏性、注意力汇聚点(Attention Sink)在 LVLM 中的关键作用,以及模态特定的信息合并策略等前沿机制,这些探索为未来的 LVLM 优化指明了新的方向。这些发现共同揭示了 LVLM 加速的复杂性和多面性,强调了针对性优化和综合评估的重要性。

图 3 针对 Token 压缩方法在效率与性能之间的权衡关系

开源共建,推动 LVLM 技术发展

EFFIVLM-BENCH 的推出,标志着 LVLM 效率评估领域的一个重要进展。哈工大团队与度小满表示,EFFIVLM-BENCH 将秉承开放共享的原则,其完整的代码和评估方案已在 GitHub 上开源,希望能为研究者和开发者提供一个强大而易用的评估工具。

通过 EFFIVLM-BENCH,团队期望能够激发更多关于 LVLM 加速技术的创新研究,推动相关技术的快速迭代和优化,最终使得强大的大型视觉语言模型能够以更低的成本、更高的效率服务于更广泛的应用场景。

随着人工智能技术的不断深化,LVLM 等先进技术必将在各行各业发挥越来越重要的作用。此次哈工大团队联合度小满推出 EFFIVLM-BENCH,是双方在大模型领域合作的又一重要成果。未来,双方将继续深化合作,探索更多前沿技术,为推动人工智能技术的发展和应用贡献力量。

文章来自公众号“机器之心”