相比于友商,在“对齐”这一环节Antropic的表现尤为激进。

ChatGPT、OpenAI这两个名字无疑是2023年科技圈最为炙手可热的存在,但投入AI大模型赛道的显然远远不止OpenAI一家,例如谷歌有Gemini、Meta有开源的Llama 2、亚马逊也有Titan。并且这个赛道目前来看也并非巨头们的狂欢,比如创业公司Antropic旗下的Claude,就被认为是一款比肩GPT-4的大语言模型。

只不过作为AI赛道的独角兽,Antropic最近陷入了麻烦,该公司刚刚发布不久的Claude 2.1受到了用户的广泛批评。

诸如“我对Claude 2.1感到非常失望”、“Claude已经死了”,这是Reddit上用户们的吐槽。

而大家之所以会对Claude不满,在于Claude 2.1现在经常会拒绝为用户服务,并以版权为由不给为用户提供的文档进行总结,面对用户可能涉及的不道德或违法行为会给予直截了当的拒绝,最让用户不爽的则是输入的Propmt往往会被Claude 2.1认为是违规。

如此种种,让相当多用户认为Antropic为了让Claude 2.1合规、而主动降低了后者的性能,甚至限制使用。其实这背后就涉及到了一个如今在AI赛道有着巨大影响力的概念“对齐”(Alignment),即要求AI能够在各种环境下自发推导出符合人类价值观的行动方针,并不会产生意外的有害后果。

然而强行让AI遵守人类价值观是有代价的,此前由微软研究院发布的一篇论文证实了对AI大模型所进行的任何AI对齐行为,都会损失大模型的准确性和性能。

因此目前AI领域围绕商业化激进发展与安全保守之间的博弈,就产生了“有效加速主义”和“超级对齐”这两个对立的阵营,双方对抗的高潮就是去年秋季发生在OpenAI内部的“政变”,OpenAI首席科学家Ilya Sutskever驱逐了该公司CEO Sam Altman。

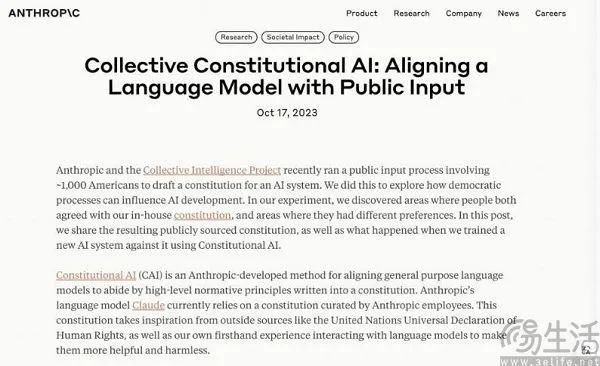

尽管最终Sam Altman回归OpenAI,但业界的主流思潮已经变成了AI需要被监管、需要有风险控制措施。故而对齐成为了目前一众AI大模型必备的环节,但相比于友商,在“对齐”这一环节Antropic的表现尤为激进。在发布Claude 2.1之前,该公司起草了一份AI宪法(Collective Constitutional AI),强调AI回答时要保持客观、平衡、易于理解,且AI必须是无害的。

其实Antropic的保守也是有原因的,虽然Claude确实有类似ChatGPT Plus这样面向个人用户的Pro版本,但其主要是面向企业级市场,而对于后者来说,相比于Claude在性能上表现更加出色,合规反而是更加重要的一件事情。所以为了让AI更符合监管的要求而限制性能,这是一个让个人用户不满,却符合企业用户需求的决策。

值得一提的是,Claude 2.1表现出性能下降的趋势,其实并不完全是因为Antropic在“AI对齐”上更加激进,Claude 2.1本身的迭代也有问题。作为去年11月中旬推出的新模型,Claude 2.1最大的卖点是200k的上下文窗口,这一卖点契合了当时一众AI大模型互相比拼上下文窗口容量的风潮。

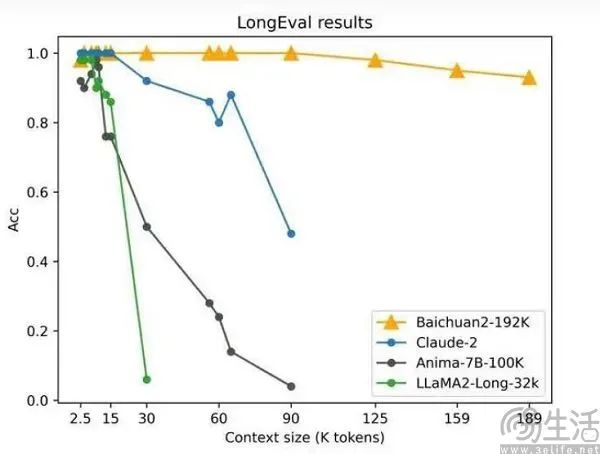

例如在去年10月末,百川智能推出的Baichuan2-192K把上下文窗口增大到192k,就一度成为当时全球上下文窗口最大的模型。

紧接着李开复带领的零一万物团队发布开源大模型Yi系列,其将上下文窗口的规模增加到了200k,旋即无问芯穹的大模型计算引擎“Infini-ACC”,更是将这一数字扩展到256k。

但问题在于,当用户输入的内容变多了之后,“算力需求”和“显存压力”的增加会直接导致大模型性能的下降。即便开发者通过优化算法来实现窗口长度和性能之间的平衡,但在上下文窗口超过100k之后,大模型的性能也会直线下降。

其实这一点在百川智能的Baichuan2-192和Antropic的Claude 2.1上都有明显的体现,有海外YouTuber在测试中发现,Claude2.1的表现甚至还不如2.0版本。

这一方面是AI对齐不可避免地带来了性能下降,毕竟一个束手束脚的AI难以发挥潜力;另一方面则是Antropic盲目扩大Claude 2.1的上下文能力,使得在双重负面因素的影响之下,如果用户没有感受到Claude变得越来越不好用反而是有问题的。

只能说如今用户的群情汹汹是Antropic激进决策的“代价”,但这个代价究竟有没有必要,可能就只有Antropic自己清楚了。

文章来自于微信公众号 “三易生活”(ID:IT-3eLife),作者 “三易菌”