在我们探索宇宙和深海的同时,人类最复杂的前沿仍然隐藏在我们自己的头颅之中。神秘而复杂的大脑,这个自然界中最复杂的已知结构,不仅是思想和感觉的源泉,还是我们对世界感知的根本。正如物理学家理查德·费曼所说,“我所不能创造的,我便不能理解(What I cannot create, I do not understand)”,要想解锁这个谜团,我们便需要从头构建一个类似的人造大脑。当人造大脑已能复现人脑特征,那我们对自然之脑的理解无疑更为深入。

从视觉、听觉,再到嗅觉,我们的大脑处理感官信息的方式超乎想象。它能从混乱的视觉图像中辨识出熟悉的面孔,从嘈杂的环境中捕捉微弱的旋律,甚至在气味的复杂混合中识别出特定的气味。但这一切不仅仅是生物学的奇迹,也是人工智能未来发展的蓝图。通过学习和模仿大脑处理信息的方式,科学家们试图在人工神经网络中复现这些现象。本文将穿越人类大脑与人工智能之间的复杂迷宫,从视觉、听觉、嗅觉概述相关研究,探索人脑与人工神经网络的相似与差异,为下一代智能系统的设计提供方向。

视觉

感知基础:从简单到抽象特征的提取

当我们观察事物时,存在一个明显现象,相比倾斜方向的图像,我们更容易觉察到垂直或水平方向的图像。这被称为倾斜效应(oblique effect)。

就像下图所展现的那样,我们倾向于更清晰地记住直立的树和山脉,而非它们倾斜的根茎。这种偏好可能反映了我们祖先在进化过程中发展出的能力。垂直和水平方向的特征在环境中更为常见,因此视觉系统在构建高效表征时,需要对这些方向的变化更敏感,这将有助于我们更快地识别和响应环境变化。

▷图1:倾斜效应示意图。在任意随机选取的自然场景照片中,水平和垂直方向也比倾斜方向更常见。这种情况也出现在人造建筑物中。| 来源:Cognitive Psychology: Connecting Mind, Research and Everyday Experience 3rd Edition

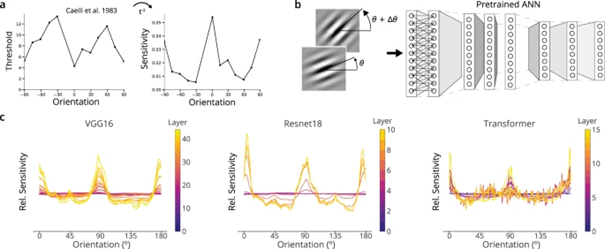

为了搞清楚这一现象究竟从何而来,研究者[1]基于卷积神经网络的模型VGG16及 Resnet18,以及非卷积网络架构的transformer,分别构建人工神经网络,来模拟这一现象。他们发现,经过训练的网络在对不同方向的刺激进行处理时,显示出与人脑类似的倾斜效应。具体来说,这些网络在0度、90度和180度的方向刺激上的反应更为敏感。这是我们首次观察到人工神经网络和大脑涌现出相同的特征,而这一主题将在之后反复出现。

▷图2:被训练分类自然出现物品的人工神经网络,会呈现类似人类的编码敏感性。来源:参考文献1

当我们进入森林,会发现一排排几乎相同的树木。人脑为了高效地对其进行表征,会利用数据不变性对重复的元素进行压缩,以提高信息处理的效率。这被称为平移不变性。这种机制在人工神经网络(卷积神经网络)中也找到了对应。

更有趣的是,即使是基于全连接神经网络,只要训练它们识别自然界中的图像,它们也能涌现出类似的具有局部、空间平铺的感受野[2]。这意味着即使在没有预设网络结构的初始状态下,人工神经网络也能自发学会先聚焦图像中的一小块,之后看到类似的结构,就直接从记忆中调用已有的存储,高效地处理相似结构。

在处理视觉信息时,大脑常常需要应对输入数据的缺失和噪声。但面对这些问题,人脑会在必要时将注意力集中于更大的图像,而不是陷入多个细节部分。例如,在遇到部分遮挡的图形时,我们的大脑倾向于视觉上“填补”缺失的部分,将其视为一个完整的形状,这就是闭合法则。训练用来分类自然图像的神经网络也会呈现出类似补全的倾向[3]。

除开遮挡造成的信息缺失之外,观察时间过短也将带来输入的缺失。就如“看不见的黑猩猩”一样,当我们过于关注某事时,可能会忽略显而易见的视觉信息。这表明即使是短暂出现的、未进入我们的意识图像,也能在我们的视觉皮层中留下印象。

例如,在实验中,即使被试者只是瞥了一眼或根本没有意识到某个图像,他们仍然能够在一定程度上识别图像内容,如判断图像中是否存在生物[4]。使用卷积神经网络架构,研究者发现当数据存在缺失/噪音时,模型仍能在一定范围内进行判别。这一现象与人脑的处理方式相似。

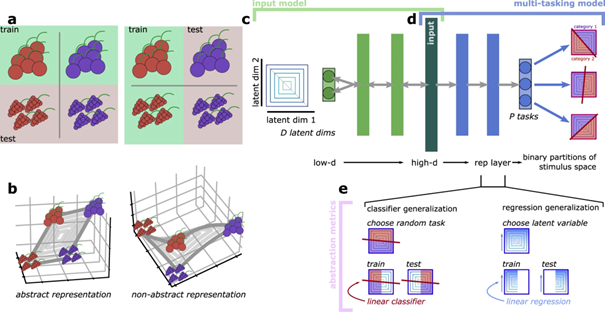

进一步地,从处理简单的线条到局部的平移不变,再到复杂图像的缺失补全,人脑对外物的感知逐渐从具象走向抽象,从而得以在面对不同的环境和对象时经由归纳形成知识。在机器学习领域,这样的能力被称为解耦(disentangle)。研究表明,人工神经网络通过监督和强化学习,在需要解决多个任务时,能够自发地涌现出抽象表征[5]。这些抽象表征有助于大脑在新的任务上实现少数样本的学习和有效的泛化。

▷图3:a)两个分类任务的例子。(左)在一种形状的红色和蓝色浆果之间学习的分类可以泛化到其他形状。(右)两个不同形状的红色浆果之间的分类可以推广到不同形状的蓝色浆果。(b)四个浆果例子的线性、抽象(左)和非线性、非抽象(右)表示的例子。(c)输入模型的示意图。(d)多任务模型的示意图。(e)两个抽象指标,分类器泛化指标(左)和回归泛化指标(右)。来源:参考文献5

在视觉系统成功识别出抽象特征之后,其下一步任务是理解这些特征之间的复杂关系。这一阶段是对信息的深入处理,涉及到模式识别和逻辑推理,是人类视觉处理中极为高级的功能。相比之下,虽然人工智能在许多领域已显示出卓越的能力,但在处理这类抽象任务时,它们通常需要更多的资源和能量。

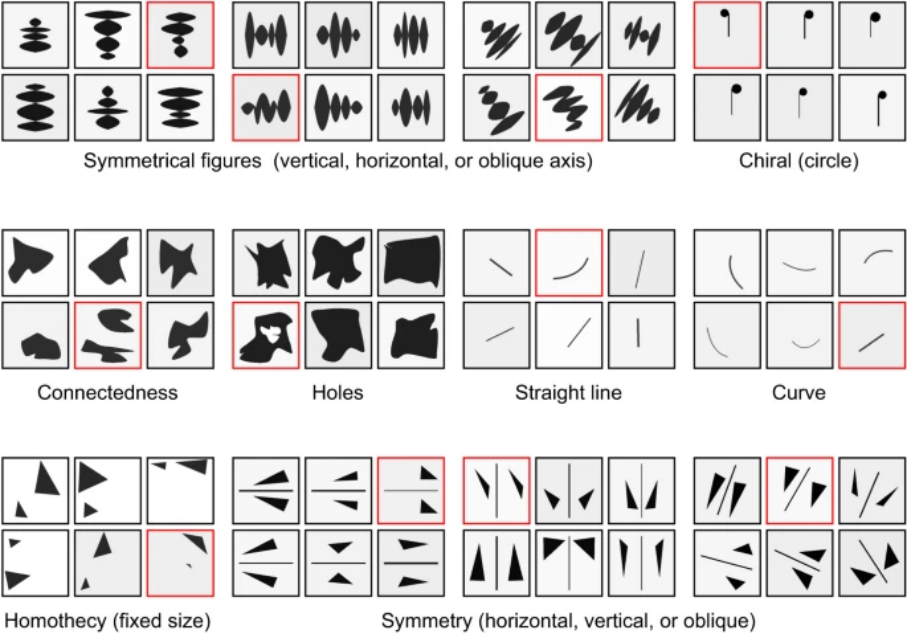

以找不同的Oddity Test为例,人类通常能够轻松地完成这种测试。然而,对于人工神经网络来说却很难。为了解决这一难题,科学家们给AI提供了小抄[6],即利用人类志愿者在完成Oddity Test时的眼动数据来训练神经网络。这些眼动数据包含了人脑在观察图像时自然而然地关注的局部间关系,从而为网络提供了一种模拟人类观察行为的方式和抽象推断的线索。这种新型的生物启发网络展现了更高的准确性、更快的学习速度,以及更少的所需参数。*

*作者注:我们是否可以通过类似的方式训练其他动物,如黑猩猩或某些鸟类,来完成Oddity Test?若是发现基于人的眼动数据训练的AI模型,当输入换成黑猩猩或鸟类的眼动数据后,也是可以适用的,那就意味着人脑的抽象思维能力不仅并不特殊,还可能是从动物的类似机制中继承而来的。不过以上是笔者个人的异想天开,供读者讨论。

▷图4:Oddity test的例子。来源:参考文献6

抽象处理:从社交到分类

我们大脑中有一些特殊的神经元,它们非常擅长于识别和辨认人脸。这些神经元能在我们还是婴儿的时候就开始对脸部特征做出反应。但这种能力是否是我们天生就有的,还是随着视觉经验而发展出来的,一直是科学家争论的热点话题。

有趣的是,利用捕捉视觉皮层腹侧区特征的人工神经网络模型发现[7],即使是没有接受过特别训练的深度神经网络,也能展示出类似的能力,它们能够“自然地”识别人脸(从随机前馈线路中自发产生),这表明我们的大脑可能有着与这些系统相似的处理机制。

此外,我们大脑识别人脸的能力并不完美。比如,面对不熟悉的种族的人脸,或者人脸的图像被上下颠倒时,我们的识别准确率就会下降。这种现象曾被认为是人脑对人脸识别特有的特点。

但是,通过研究基于卷积神经网络的人工智能模型,科学家们发现,这些“缺陷”其实是大脑为了更高效地识别人脸而进行的优化[7]。类似的人脸图像正反颠倒识别准确率下降的现象,只出现在以人脸识别为训练任务的卷积神经网络中,没有出现在接受过物体识别训练的卷积神经网络中。如专门用于识别汽车的人工智能模型中,当汽车的图像倒置时,相比正向图片,这些模型的识别能力也会下降。这说明,我们大脑的这些特点其实是对特定任务的优化,而不是什么独特的计算本质。

人脑可以从少数例子中学习概念,这对于传统的深度神经网络来说,这种从少量例子中学习的能力被称为少样本学习(few-shot learning)。那么,大脑是如何从少数例子中学习的?答案在于大脑将视觉特征映射到一个高维空间中[9],在这个空间构建一个能够跨越相距甚远空间的”虫洞”,并通过一种称为“流形学习(Manifold Learning)”的技术进行学习。理论上只用200个神经元就可区分不同类的输入。

模仿这种机制,人工神经网络也在采用类似的方法。通过配置一个灵活可塑的下游神经元,基于少数样本和简单的规则,人工神经网络就能学会如何区分不同的概念。这种方法的优势在于,它不仅能够处理视觉数据,甚至能根据语言描述符来学习和识别新的视觉概念。

▷图5:人脑和DNN基于4个实例进行训练的示意图。来源:参考文献9

在学习过程中,人脑大部分时间是没有明确指导的。这就像孩子在识别家里的猫和狗时,不需要有人一直在旁边告诉他们这是猫那是狗。这种学习的方式被称为半监督学习。人脑在半监督学习的模式下表现优良。

相似地,人工神经网络也能使用深度无监督对比嵌入方法进行学习。这种方法使神经网络在处理视觉信息时,特别是在大脑的腹侧视觉皮层相关区域,达到甚至超过了当前最先进的监督学习模型的神经预测准确率[10]。即便是仅使用头戴式摄像机收集的、嘈杂且有限的真实人类儿童发育数据,这些神经网络仍能有效地学习并产生类似大脑的表征。研究还发现,半监督深度对比嵌入可以利用少量标注示例生成表征,从而大幅提高错误模式与人类行为的一致性。

听觉

就像我们的眼睛对某些视觉特征特别敏感一样,我们的耳朵也对特定的声音特别敏感。比如,在嘈杂的环境中,我们依然能分辨出音乐的旋律或人的声音。

当科学家用深度神经网络训练完成复杂听觉任务来模拟这种听觉处理时,训练完成的模型能够很好地完成这些任务,达到人类的水平[11]。但有趣的是,只有在用真实的音乐和自然声音训练时,这些模型对音高的感知才能表现得像人类一样。如果用人工合成的声音或在没有任何背景噪音环境下训练,这些模型就会展现出完全不同的音高策略。这表明,我们的听觉系统也许真的是为了应对复杂、有时会被噪声遮蔽的环境而优化。

人脑不仅能识别特定的声音,还能判断声音来自哪个方向。通过比较声波到达左右耳的时间和强度差异,我们可以估计出声音的来源,这被称为定位。在现实世界中,环境会产生回声,而且我们会同时听到很多声音,因此定位尤其困难。

然而,当科学家在虚拟世界中训练深度学习模型[12],并使用与人耳相同的信息采样精度时,这些模型能够在定位任务上与人类达到同样水平,且表现出与人类相似的缺陷,例如当面对多个声音来源时,定位的准确性下降。与人类一样,模型同样在面对多于3个声源时无法定位。模型还扩展了对定位使用机制的解释,例如发现定位时模型不仅基于声音的强度和时间差异,还会对两耳间的频率敏感。

除环境的声音感知外,感知音乐则更为复杂,它包含识别旋律,感知固定的音高和节奏等不同部分。然而这些特征究竟是从何而来的?2019年的一项研究发现[13],一种用于音乐风格分类的深度神经网络,能够达到与人类相当的水平,而且它的错误模式也类似于人类。这表明无论是人造的还是自然的听觉系统,在处理音乐时都受到相似的限制。该研究进一步展示了这个模型如何模仿人类听觉皮层的反应,其复杂的网络层次结构能够精确地预测对不同音乐元素的反应,这反映了我们听觉系统中固有的层次化处理方式。

音乐感知是我们天生就有的能力,还是随着时间和经验而发展的?2024年初[14]的研究表明,使用模拟大脑听觉信息处理机制的人工深度神经网络,即使训练数据中不包含音乐,也可以通过经由自然声音训练,使人工神经网络自发地涌现出适应检测音乐的专用单元。这些音乐检测单元在多个时间尺度上编码音乐的结构,对音乐的细微变化极为敏感,类似于我们大脑中处理音乐的方式。

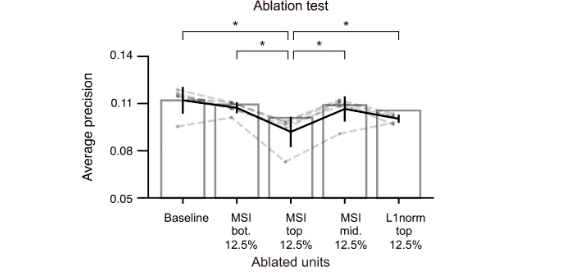

而当在人工神经网络中抹去这些音乐选择节点时,网络在音乐分类任务上的表现明显下降,这证明了我们对自然声音的处理能力可能为我们对音乐的感知提供了基础。换句话说,音乐感知可能是我们听觉系统进化适应的一部分,是对声音处理的一个通用且高效的模板。

▷图6:音乐选择性MSI最高的12.5%人工神经网络单元抹去后,对该网络分类准确性的影响最大。来源:参考文献14

嗅觉

与我们熟知的视觉和听觉不同,嗅觉没有一个直接的物理到知觉的映射。换句话说,我们不能像将光的频率直接对应到颜色,或声波的波长对应到音调那样,将特定的化学分子直接对应到特定的气味。嗅觉要解决的问题是将众多对分子浓度的感知进行压缩并追踪来源,而任务的难点在于这些分子的排列没有固定的边界或结构气味没有边缘,不是可以在空间中分组的对象,以及气味信号很是稀疏(有的气味不需要特别多的分子脑也要能识别)。

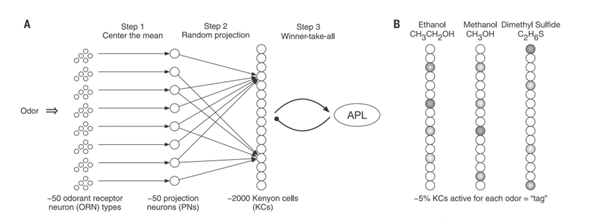

针对上述的两个问题,索尔克研究所的神经生物学家的做法是构造浅层的三层网络来模拟果蝇的嗅觉[15]。这个网络设想作为一只果蝇,它需要识别50种不同的气体。但其脑中的负责嗅觉的神经元不可能时刻处在待机状态,去判断是否有对应分子的到来。

在实验中,图7A中的50个气味分子对应了果蝇的50个投射神经元,图7B中的每个分子,可被看成对应一个长度50的向量。来自投射神经元的信息多对一地到达名为Kenyon细胞处理中心。这个系统采用了一种“赢者通吃”的机制,即在众多神经元中,只有对特定气味反应最强的那个会被激活。

上述机制构成了维度的40倍扩展,这使神经反应模式更鲁棒地区分气味(一个气味被多个下游神经元表征),能耗也更少(只有大约5%的神经元对给定的气味反应高度活跃,就可为每个细胞提供一个独特的标签)。将类似的技术用在搭建手写数字识别网络上,可让系统在部分硬件失灵的场景下运行。

▷图7:(A)苍蝇嗅觉回路示意图。(B)气味反应的示意图。相似的气味对(如甲醇和乙醇)被分配了更相似的标签。来源:参考文献15

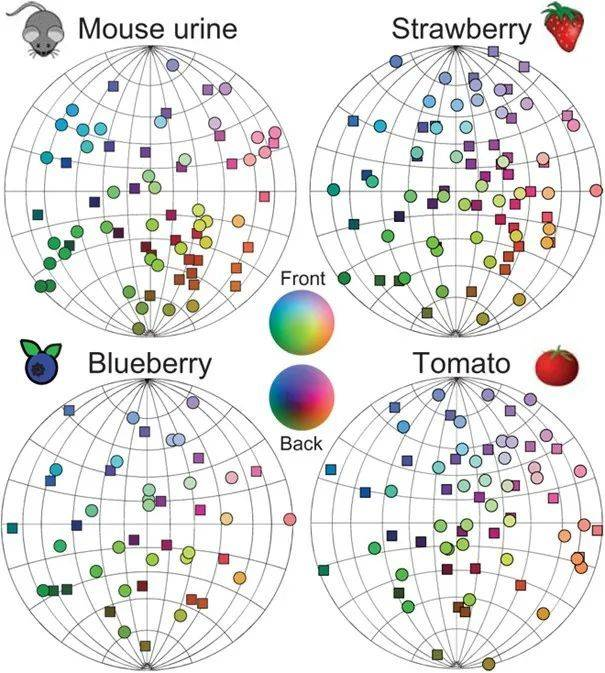

当面对来自同一生化反应的多种化合物时,生物的嗅觉系统会通过激活相同的神经元来节省存储空间。如果两种化合物很少同时出现,那么它们就会被映射到大脑中相距较远的区域。这就像在三维空间中创建了一个类似马鞍的三维双曲空间“嗅觉地图”[16],其中相似的气味会被归为一类,而不同的气味则被清晰地区分开来。这种空间上的排列方式,帮助我们大脑有效地处理和识别复杂的气味组合。这与根据像素相似度在双曲空间创建的地图类似。

▷图8:不同物体对应的嗅觉地图,圆形/矩形表示近/远侧。来源:参考文献16

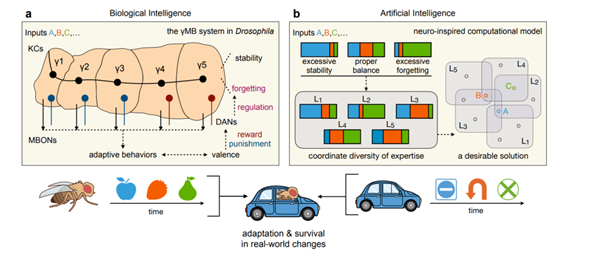

另一方面,科学界也在借鉴嗅觉机制来改进AI[17]。例如,通过设计一种能够“主动遗忘”的多层学习系统,这些系统能够处理不断增加的数据,并在学习过程中整合新旧信息。这种方法类似于生物嗅觉系统中多个并行处理模块的工作方式,最终由大脑中的一个集成模块“蘑菇体”(mushroom body),来决定哪些信息最可靠。这种架构(无论是生物界,还是模仿产生的AI模型)将主动遗忘与稳定性保护结合起来,可更好地权衡新旧信息,并相应地协调多个持续学习者,确保解决方案具有持续学习的能力。

▷图9:基于生物体的持续学习架构示意图。来源:参考文献17

总结

无论是从大脑获得启发以改进神经网络,还是基于神经网络的特征去探讨大脑的运行机制,我们可以梳理出几条反复出现的线索。首先,不论是在杂乱的环境中识别细微的音高变化,还是用少量待机神经元在大量信息中精确地检测气味,我们的神经系统都在努力在有限的资源下,以刚刚好的程度将任务完成。这说明了感官处理的方式是受到我们进化历程中的种种约束的。

其次,大脑并没有打算一招鲜吃遍天,而是针对不同的环境输入给出了特异性的解决之法。这值得一直在追求“一种技术解决所有问题”的AI界学习。

再者,大脑对感官的处理也并非完美,大脑如同总在摸鱼边缘疯狂试探的打工人,会产生种种认知缺陷,例如难以识别不熟悉种族的面孔。但这种不完美也反映了大脑对信息处理的一种经济学平衡,如视觉系统对不完整图像的自动补全。

回顾了众多相关领域的有趣研究后,我们可以发现当前的研究关注最多的是感官是视觉,最多的是生物是人。然而,我们的感官并非所有生物中最佳的那个。我们的视觉并非如鸟类那样,具有四周色感细胞,能看到更多彩的世界,听觉更也不如能够超声定位的蝙蝠。基于脑(尤其是感官)启发的AI算法,未来可以不必只聚焦于人身上,而应该更多地探索其他生物的感官系统。

当前的AI架构,无论是在反向传播还是神经网络设计方面,都和大脑真实的运行机制有相当大的差距。大脑中的单个神经元并非简单的对输入加权求和,而是具有亚细胞层面的可塑能力。这使得AI借鉴大脑时,要切记勿要刻舟求剑,而是要搞清楚生物体在具体任务上面临的进化约束,如此方能避免邯郸学步。

站在百年的门槛回望,我们仍然不清楚人造大脑能否实现,但毫无疑问,我们已在人工智能中复现大脑的某些关键特征,包括其优势和缺陷。而这也指引着AI领域的迅猛发展,还更进一步帮助我们理解大脑。尽管模拟大脑的终极目标可能仍然遥不可及,我们对大脑的模仿和理解,正逐步引领人工智能超越现有的人类智能边界,为我们带来前所未有的创新和突破。

参考文献:

[1]Benjamin, Ari S., et al. “Efficient Neural Codes Naturally Emerge Through Gradient Descent Learning.” Nature Communications, vol. 13, no. 1, Dec. 2022, https://doi.org/10.1038/s41467-022-35659-7.

[2]Ingrosso, Alessandro, and Sebastian Goldt. “Data-driven Emergence of Convolutional Structure in Neural Networks.” Proceedings of the National Academy of Sciences of the United States of America, vol. 119, no. 40, Sept. 2022, https://doi.org/10.1073/pnas.2201854119.

[3]Kim, Been, et al. “Neural Networks Trained on Natural Scenes Exhibit Gestalt Closure.” Computational Brain & Behavior, vol. 4, no. 3, Apr. 2021, pp. 251–63. https://doi.org/10.1007/s42113-021-00100-7.

[4]Mei, Ning, et al. “Informative Neural Representations of Unseen Contents During Higher-order Processing in Human Brains and Deep Artificial Networks.” Nature Human Behaviour, vol. 6, no. 5, Feb. 2022, pp. 720–31. https://doi.org/10.1038/s41562-021-01274-7.

[5]Johnston, W. Jeffrey, and Stefano Fusi. “Abstract Representations Emerge Naturally in Neural Networks Trained to Perform Multiple Tasks.” Nature Communications, vol. 14, no. 1, Feb. 2023, https://doi.org/10.1038/s41467-023-36583-0.

[6]Woźniak, Stanisław, et al. “On the Visual Analytic Intelligence of Neural Networks.” Nature Communications, vol. 14, no. 1, Sept. 2023,

https://doi.org/10.1038/s41467-023-41566-2.

[7]Baek, Seungjun, et al. “Face Detection in Untrained Deep Neural Networks.” Nature Communications, vol. 12, no. 1, Dec. 2021, https://doi.org/10.1038/s41467-021-27606-9.

[8]Dobs, Katharina, et al. “Behavioral Signatures of Face Perception Emerge in Deep Neural Networks Optimized for Face Recognition.” Proceedings of the National Academy of Sciences of the United States of America, vol. 120, no. 32, July 2023, https://doi.org/10.1073/pnas.2220642120.

[9]Sorscher, Ben, et al. “Neural Representational Geometry Underlies Few-shot Concept Learning.” Proceedings of the National Academy of Sciences of the United States of America, vol. 119, no. 43, Oct. 2022, https://doi.org/10.1073/pnas.2200800119.

[10]Zhuang, Chengxu, et al. “Unsupervised Neural Network Models of the Ventral Visual Stream.” Proceedings of the National Academy of Sciences of the United States of America, vol. 118, no. 3, Jan. 2021, https://doi.org/10.1073/pnas.2014196118.

[11]Saddler, Mark R., et al. “Deep Neural Network Models Reveal Interplay of Peripheral Coding and Stimulus Statistics in Pitch Perception.” Nature Communications, vol. 12, no. 1, Dec. 2021, https://doi.org/10.1038/s41467-021-27366-6.

[12]Francl, Andrew, and Josh H. McDermott. “Deep Neural Network Models of Sound Localization Reveal How Perception Is Adapted to Real-world Environments.” Nature Human Behaviour, vol. 6, no. 1, Jan. 2022, pp. 111–33. https://doi.org/10.1038/s41562-021-01244-z.

[13]Kell, Alexander J. E., et al. “A Task-Optimized Neural Network Replicates Human Auditory Behavior, Predicts Brain Responses, and Reveals a Cortical Processing Hierarchy.” Neuron, vol. 98, no. 3, May 2018, pp. 630-644.e16. https://doi.org/10.1016/j.neuron.2018.03.044.

[14]Kim, GwangSu, et al. “Spontaneous Emergence of Rudimentary Music Detectors in Deep Neural Networks.” Nature Communications, vol. 15, no. 1, Jan. 2024, https://doi.org/10.1038/s41467-023-44516-0.

[15]Dasgupta, Sanjoy, et al. “A Neural Data Structure for Novelty Detection.” Proceedings of the National Academy of Sciences of the United States of America, vol. 115, no. 51, Dec. 2018, pp. 13093–98. https://doi.org/10.1073/pnas.1814448115.

[16]Zhou, Yuansheng, et al. “Hyperbolic Geometry of the Olfactory Space.” Science Advances, vol. 4, no. 8, Aug. 2018, https://doi.org/10.1126/sciadv.aaq1458.

[17]Wang, Liyuan, et al. “Incorporating Neuro-inspired Adaptability for Continual Learning in Artificial Intelligence.” Nature Machine Intelligence, vol. 5, no. 12, Nov. 2023, pp. 1356–68. https://doi.org/10.1038/s42256-023-00747-w.

文章来自于微信公众号 “追问nextquestion”(ID:gh_2414d982daee),作者 “郭瑞东”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI